Die Softwareentwicklung hat sich über die Jahre kontinuierlich weiterentwickelt, und stets steht die Performance im Fokus. Ein zentraler Bestandteil, der maßgeblich beeinflusst, wie effizient ein Programm läuft, ist der Compiler. Compiler übersetzen Quellcode in maschinenlesbare Programme und optimieren dabei die Codeausführung. Dabei werden vielfältige Optimierungen angewendet, um Geschwindigkeit zu steigern und den Ressourcenbedarf zu senken. Eine bahnbrechende Methode, die in der Welt der Compileroptimierung zunehmend an Bedeutung gewinnt, sind die Link Time Optimizations (LTO).

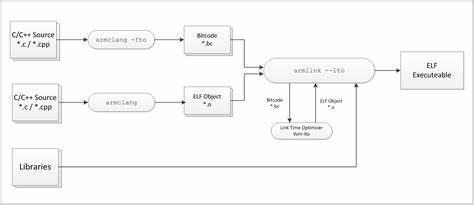

Diese Technik erweitert den Optimierungsprozess auf die Link-Phase, was bisherige Grenzen konventioneller Kompilierung überschreitet und völlig neue Möglichkeiten eröffnet. Traditionell erfolgt die Kompilierung von Programmen dateibasiert. Einzelne Quellcodedateien werden separat übersetzt, in Objektdateien (.o) umgewandelt und später vom Linker zu einem ausführbaren Programm zusammengefügt. Der Compiler arbeitet also immer isoliert auf Einzeldateien.

Optimierungen wie Inlining von Funktionen oder Verschmelzung von Schleifen können innerhalb dieser Dateien stattfinden. Doch sobald Funktionen oder Codeabschnitte in unterschiedlichen Dateien liegen, hat der Compiler keinen Einblick mehr in deren Implementierung. Er kennt lediglich deren Signaturen und erzeugt an den Aufrufstellen sogenannte Platzhalter, deren Auflösung erst der Linker übernimmt. Dadurch entgehen dem Programm wichtige Potenziale für Optimierung, weil diese über Dateigrenzen hinweg nicht sichtbar sind. Genau hier setzt Link Time Optimization an.

LTO verlagert einen Teil der Optimierungsarbeit vom Compiler in die Linker-Phase. Das bedeutet, der Linker wird nicht nur zum einfachen Zusammensetzen von Objektdateien gebraucht, sondern übernimmt selbst komplexe Code-Analysen und Optimierungen. Er betrachtet das Programm ganzheitlich und kann so Funktionen aus verschiedenen Kompilations-Einheiten zusammenführen, Funktionen inline setzen, Schleifen verschmelzen und den generierten Code neu anordnen, um die Speicherlokalität zu verbessern. Dies führt zu geringerer Ausführungszeit, besserer Cache-Ausnutzung und kleineren Binärdateien. Für Entwickler kann dies bedeuten, dass Programme mit identischem Quellcode und identischen Optimierungsflags deutlich schneller laufen oder weniger Speicherplatz benötigen.

Ein anschauliches Beispiel ist die Kombination von Min- und Max-Findefunktionen in einer Anwendung. Wenn diese Funktionen in getrennten Dateien liegen, kann der Compiler sie nicht zusammen optimieren. Bei aktivierter LTO hingegen kann der Linker diese Informationen zusammenführen, die beiden Funktionen inline setzen und die Schleifen über die Daten verschmelzen. Dies reduziert die Anzahl der Iterationen über das Datenarray und verbessert damit die Laufzeiteffizienz erheblich. Der technische Hintergrund von LTO basiert darauf, dass der Compiler während der Kompilierung eine Zwischendarstellung (Intermediate Representation, IR) erzeugt, anstatt nur reinen Maschinencode zu produzieren.

Diese IR enthält detaillierte Informationen über den Programmcode und dessen Struktur und ermöglicht umfassende Analysen. Bei aktivierter LTO wird diese IR in den Objektdateien in speziellen Segmenten gespeichert. Der Linker liest diese Zwischendarstellungen aus allen Objektdateien ein, führt sie zusammen und wendet Optimierungen auf dieser höheren Abstraktionsebene an. Dadurch entstehen Einblicke und Möglichkeiten, die einem gewöhnlichen Linker auf rein binärer Ebene nicht zugänglich sind. LTO bringt nicht nur Vorteile mit sich, sondern hat auch gewisse Nachteile, die im praktischen Einsatz beachtet werden müssen.

So steigt die Kompilierzeit hinsichtlich Dauer und benötigtem Arbeitsspeicher erheblich an. Das Zusammenführen und Optimieren aller Zwischendarstellungen gleichzeitig erfordert mehr Ressourcen. Besonders bei großen Projekten mit tausenden von Quellcodedateien kann dies zu deutlich längeren Build-Zeiten und höherem Speicherverbrauch führen. Gerade deswegen zögern manche Entwickler, LTO in ihre Toolchains zu integrieren, weil es den Entwicklungsprozess verlangsamen kann. Hier ist also abzuwägen, ob die Laufzeitvorteile die Mehrkosten beim Kompilieren rechtfertigen.

Ein weiterer Aspekt betrifft die Komplexität des Build-Systems. Um LTO korrekt zu nutzen, müssen sowohl beim Kompilier- als auch beim Linkvorgang spezielle Flags gesetzt werden – typischerweise „-flto“ bei GCC und Clang. Zudem ist es wichtig, dass die Compiler- und Linker-Versionen kompatibel sind und die verwendeten Bibliotheken ebenfalls mit LTO erstellt wurden. Bei gemischten Build-Umgebungen können deshalb Probleme auftreten. Dennoch haben moderne Compiler und Build-Systeme diese Herausforderungen deutlich reduziert, und immer mehr Entwickler setzen LTO erfolgreich in ihren Projekten ein.

Performance-Experimente zeigen die Potenziale und Grenzen von LTO. In mittelgroßen C++-Projekten ließ sich durch LTO die Ausführungszeit um über 9 Prozent verbessern, während die Binärgröße um knapp 20 Prozent schrumpfte. Diese Verbesserungen sind bemerkenswert, gerade weil sie ohne Codeänderungen erreicht werden konnten. Allerdings stiegen die Kompilierzeiten und der Speicherbedarf beim Linking um ein Vielfaches an. Größere Softwareprojekte wie Browser profitieren daher von dedizierten Build-Servern, um die Mehrlast handzuhaben.

Andererseits offenbaren Tests mit bestens optimierten Projekten wie der bekannten Multimedia-Bibliothek ffmpeg, dass der Nutzen von LTO nicht immer so offensichtlich ist. ffmpeg, sowohl in C als auch mit handoptimiertem Assembler-Code, zeigte beim Einsatz von LTO nur minimale bis gar keine signifikanten Geschwindigkeitsvorteile. Der Grund liegt darin, dass die Entwickler bereits viele Funktionen in Header-Dateien definiert und kleine Funktionen häufig inline setzen, wodurch die Optimierungsmöglichkeiten, die LTO bietet, reduziert sind. Zudem kann LTO in manchen Fällen sogar zu größeren Binärdateien führen, da der Linker zusätzliche Codeinformationen berücksichtigt. Die Entscheidung, LTO einzusetzen, sollte also projektspezifisch getroffen werden.

Für Projekte, die noch ungenutzte Optimierungsspielräume bieten, kann LTO ein einfacher Weg sein, die Performance zu verbessern. Für hochgradig optimierten Code oder sehr große Projekte gilt es abzuwägen, ob der erhöhte Ressourcenbedarf die Vorteile überwiegt. Eine umfassende Benchmarking-Phase ist daher unerlässlich, um die tatsächlichen Auswirkungen auf die eigene Software zu verstehen. Neben dem traditionellen LTO bietet der Compiler Clang mit ThinLTO eine optimierte Variante, die die Kompilier- und Linkzeiten reduziert, indem die Zwischendarstellung in kleinere, inkrementelle Teile zerlegt wird. ThinLTO verspricht eine ähnliche Leistungssteigerung mit deutlich kürzeren Build-Zeiten und geringeren Speicheranforderungen.

Diese Technik gewinnt zunehmend an Popularität und zeigt, dass sich LTO immer weiter entwickelt, um praktikabler und schneller im Entwicklungsalltag eingesetzt werden zu können. Zusammenfassend lässt sich sagen, dass Link Time Optimizations einen wichtigen Schritt in der Evolution von Compileroptimierungen darstellen. LTO erweitert den Optimierungshorizont auf die gesamte Applikation statt nur auf einzelne Dateien. Durch intelligentere Inlining-Strategien, verbesserte Code-Anordnung und effizientere Nutzung von CPU- und Speichersystemen erzielen Entwickler spürbare Performancegewinne. Trotz höherer Kompilierkosten lohnt es sich für viele Projekte, LTO zumindest zu testen und in den Build-Prozess zu integrieren.