Im digitalen Zeitalter gewinnt die automatisierte Datenerfassung aus dem Web zunehmend an Bedeutung. Unternehmen, Entwickler und Forscher benötigen zuverlässige, leistungsstarke Tools, um relevante Informationen aus verschiedenen Online-Quellen zu extrahieren. Hier tritt AnyCrawl v0.0.1-alpha.

5 auf den Plan – ein innovatives, in Node.js und TypeScript entwickeltes Web-Scraping- und Crawling-Toolkit, das sich durch seine Anpassungsfähigkeit, Geschwindigkeit und Funktionsvielfalt auszeichnet. AnyCrawl hat sich mit seiner neuesten Version v0.0.1-alpha.

5 weiterentwickelt und bringt entscheidende Verbesserungen mit sich. Besonders hervorzuheben sind der Support für einen individuellen User-Agent und eine erweiterte API, die das Scraping und Crawling deutlich flexibler und zielgerichteter gestalten. Durch diese Funktionen ermöglicht AnyCrawl nicht nur das Sammeln von Daten in großem Umfang, sondern auch die präzise Steuerung der Anfragen und eine bessere Umgehung von Anti-Scraping-Mechanismen. Die Möglichkeit, den User-Agent individuell zu definieren, gehört zu den bedeutendsten Neuerungen. User-Agent-Strings werden von Webservern genutzt, um den Typ des anfragenden Clients zu identifizieren, beispielsweise Browsername und Version.

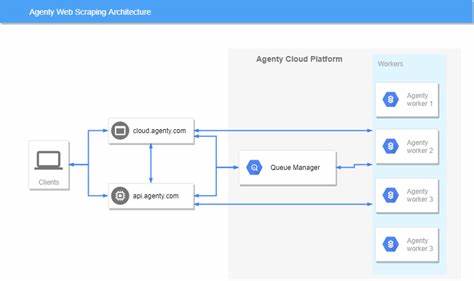

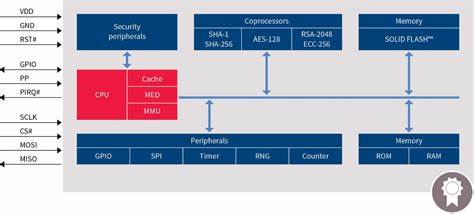

Viele Webseiten steuern den Zugriff anhand dieses User-Agents oder blockieren automatisierte Bots konsequent. Mit AnyCrawl lässt sich der User-Agent gezielt anpassen, sodass die Anfragen vertrauenswürdiger wirken und dadurch eine höhere Erfolgsquote beim Scrapen erzielt wird. Diese Funktion eröffnet neue Möglichkeiten, Daten auch von schwer zugänglichen oder stark geschützten Webseiten zu extrahieren. Darüber hinaus bietet AnyCrawl eine wesentlich erweiterte API, die Entwicklern eine tiefgreifende Kontrolle über den Scraping-Prozess ermöglicht. Das Toolkit unterstützt verschiedene Engines wie Cheerio für statische HTML-Verarbeitung, Playwright und Puppeteer für das dynamische Rendern von JavaScript-lastigen Webseiten.

Dadurch kann AnyCrawl HTML-Inhalte zuverlässig auslesen, selbst wenn sie erst durch Client-seitiges JavaScript generiert werden. Darüber hinaus unterstützt AnyCrawl beim Site-Crawling, also bei der vollständigen Durchsuchung ganzer Webseiten oder Domains. Nutzer können maximale Crawltiefen, Seitenbegrenzungen sowie spezifische Strategien wie das Limitieren auf gleiche Domain, Hostname oder Ursprung einstellen. Dies gewährleistet eine kontrollierte Datengewinnung, die sowohl umfassend als auch effizient ist. Ein weiteres Highlight ist die Batch-Verarbeitung, die AnyCrawl zu einem idealen Werkzeug für große, wiederkehrende Scraping-Aufgaben macht.

Die Kombination aus Multi-Threading und Multi-Processing sorgt für hohe Performance und stabile Verarbeitung selbst bei umfangreichen Datenmengen. Parallel dazu erlaubt die API den gezielten Einsatz von Proxy-Servern, was die Anonymität erhöht und die Risiken eines IP-Blocks reduziert. Standardmäßig enthält AnyCrawl hochwertige Proxy-Lösungen, die bei Bedarf mit eigenen Konfigurationen ersetzt werden können. Für Entwickler, die strukturierte Daten direkt für KI-Anwendungen benötigen, ist die LLM-Extraktion ein entscheidendes Feature. AnyCrawl nutzt moderne Large Language Models (LLM), um Inhalte auf Seiten in vorgegebenen JSON-Schemata zu extrahieren.

So können beispielsweise Unternehmensinformationen, Produktdetails oder Bewertungen gezielt ausgefiltert und in maschinenlesbarer Form vorgehalten werden. Dieses Feature macht AnyCrawl besonders attraktiv für die Integration in intelligente Datenanalyse- und Automatisierungsprozesse. Die Integration in bestehende Systeme gestaltet sich denkbar einfach. AnyCrawl stellt eine RESTful-API bereit, die mit klaren Endpunkten für Scrape, Crawl und Search ausgestattet ist. Authentifizierung erfolgt über API-Keys, was Sicherheit und Zugangskontrolle gewährleistet.

Die umfangreiche Dokumentation und der Playground für API-Tests erleichtern es auch weniger erfahrenen Nutzern, direkt produktiv zu werden und eigene Use-Cases umzusetzen. Ein weiterer Pluspunkt ist die Open-Source-Natur von AnyCrawl. Nutzer und Entwickler können den Quellcode studieren, anpassen und erweitern. So entsteht eine lebendige Community, die kontinuierlich zur Verbesserung beiträgt. Besonders für Unternehmen ist es wertvoll, eine flexible Plattform zu haben, die die individuellen Bedürfnisse abdeckt und gleichzeitig den Weg für Innovationen öffnet.

AnyCrawl kann in verschiedensten Branchen eingesetzt werden. Im E-Commerce lassen sich Preise, Produktinformationen oder Kundenbewertungen schneller und zielgerichteter erfassen und analysieren. Im Marketing und der Marktforschung hilft das Tool, Wettbewerber zu beobachten und Trends frühzeitig zu erkennen. Auch für Journalisten und Datenwissenschaftler öffnet AnyCrawl Türen zu automatisierten Recherchen und dem Aufbau eigener Datenbestände. Seit der Veröffentlichung von Version 0.

0.1-alpha.5 hat AnyCrawl seine Position als unverzichtbares Werkzeug für modernes Web-Scraping gestärkt. Die Kombination aus Performance, Flexibilität und innovativen Features wie individuellem User-Agent oder LLM-gestützter Extraktion macht das Tool zu einem Vorreiter im anspruchsvollen Bereich der Datengewinnung aus dem Netz. Mit der stetigen Weiterentwicklung und der offenen Lizenz bleibt AnyCrawl eine attraktive Wahl für diejenigen, die Wert auf zuverlässiges und zukunftsfähiges Crawling legen.

Dank der agilen Entwicklung und der aktiven Community ist eine kontinuierliche Verbesserung der Funktionen garantiert, was Anwendern langfristige Investitionssicherheit bietet. Zusammenfassend lässt sich sagen, dass AnyCrawl v0.0.1-alpha.5 weit mehr als ein simples Scraping-Werkzeug ist.

Es handelt sich vielmehr um eine umfassende Plattform, die moderne Anforderungen an Skalierbarkeit, Anpassbarkeit und datengetriebene Analyse optimal verbindet. Für Nutzer, die datenbasierte Entscheidungen treffen möchten, stellt AnyCrawl eine wertvolle Basis dar, um Informationen automatisiert zu erschließen und intelligent weiterzuverarbeiten. Damit definiert AnyCrawl den Standard für das Web-Scraping im 21. Jahrhundert entscheidend mit.