Erleben wir eine neue Ära des Drohnensports: autonome Systeme konkurrieren mittlerweile auf Augenhöhe mit den besten menschlichen Piloten der Welt. FPV-Drohnenrennen, bei denen Piloten ihre Quadrocopter durch anspruchsvolle 3D-Kurse steuern und dabei Blickwinkel aus der Ich-Perspektive nutzen, sind ein hochdynamischer, wettbewerbsintensiver Sport. Die Herausforderungen für autonome Systeme liegen darin, nicht nur mit der Geschwindigkeit und Flugdynamik menschlicher Piloten mitzuhalten, sondern sich auch ausschließlich auf Sensorinformationen an Bord zu verlassen. Die Entwicklung von Swift, einem autonomen System, das mit Deep Reinforcement Learning (RL) trainiert wurde, bringt die Robotik an einen Punkt, der zuvor für unmöglich gehalten wurde: die Konkurrenzfähigkeit gegen echte Weltmeister im FPV-Drohnenrennen. Das Spielfeld im FPV-Drohnenrennen ist extrem anspruchsvoll.

Die Quadcopter sind akrobatische Meisterwerke, die Geschwindigkeiten von über 100 km/h erreichen und bei scharfen Kurven bis zu fünffache ihrer eigenen Gewichtskraft aufbringen. Für menschliche Piloten entsteht durch die Videoübertragung eine immersive Erfahrung, bei der sie das Geschehen aus der Perspektive ihrer Drohne erleben. Autonome Systeme müssen die gleiche Perspektive einnehmen und durch Bild- und Inertialsensorik hochpräzise ihre Position und Geschwindigkeit erfassen. Anders als bei Simulationen oder Spielen, in denen Algorithmen oft auf perfekte Zustandsinformationen zurückgreifen können, arbeiten die physischen Fluggeräte nur mit den verrauschten, unvollständigen Daten der eingebauten Sensorik. Der Weg zur Entwicklung von Swift basierte auf der Kombination fortschrittlicher Wahrnehmungs- und Steuerungsmodule.

Das System besteht aus einem Wahrnehmungsteil, der visuelle und inertiale Daten verarbeitet, um eine präzise, aber low-dimensionale Repräsentation des aktuellen Zustands zu erstellen, sowie einer Steuerungspolitik, die diesen Zustand als Eingabe nutzt, um die Flugbefehle für die Drohne zu generieren. Diese Steuerungspolitik wird von einem neuronalen Netzwerk dargestellt, das mit model-freiem On-Policy Deep Reinforcement Learning im Simulator trainiert wurde. Bereits hier offenbart sich eine wichtige Eigenschaft der Lösung: Verbessertes Lernen in der Simulation, das durch sorgfältige Modelle und algorithmische Ansätze bestmöglich mit der Realität korrespondiert. Um den „Simulation-to-Reality“-Sprung erfolgreich zu schaffen, wurde die Diskrepanz zwischen der idealisierten Simulationsumgebung und der realen Welt miteinbezogen. Dazu gehörte das Erheben realer Sensor- und Dynamikdaten auf der Rennstrecke, um empirische Modelle für wahrnehmungsbedingte Rauschfaktoren und unmodellierte dynamische Effekte zu erstellen.

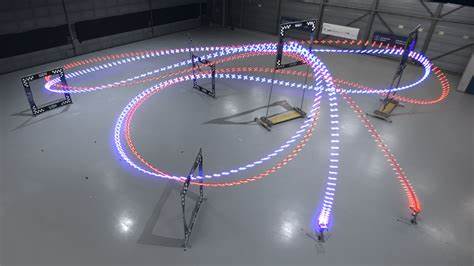

Diese werden als sogenannte Residualmodelle als Ergänzung zur physikalischen Simulation eingesetzt, so dass der Policy-Trainingsprozess die realen Gegebenheiten möglichst akkurat abbildet. Daraus resultiert eine robustere und realitätsnähere Steuerungsstrategie, die weithin als Schlüssel für die erfolgreiche Übertragung der künstlichen Intelligenz auf reale Flugzeuge erkannt wurde. Der Rennkurs, auf dem Swift gegen drei menschliche Weltmeister antrat, wurde von einem professionellen FPV-Piloten entworfen und ist typisch für hochkomplexe Rennbedingungen. Mehrere aufeinanderfolgende, quadratische Gates auf begrenztem Raum zwingen zu scharfen Wendemanövern, präziser Linienführung und perfektem Timing. Die Drohnen von Swift und den menschlichen Piloten sind identisch in Gewicht, Antrieb und Form.

Trotz der gleichen Hardware gelang es Swift, mehrere Rennen gegen jeden der menschlichen Piloten zu gewinnen und zudem die schnellste je aufgezeichnete Renndurchfahrt auf diesem Kurs zu erzielen. Die Analyse der Flugdaten zeigt, dass Swift bei schnellen Starts und engen Kurven besonders überlegen ist. Für den „Split S“ – ein komplexer Abschnitt mit einem abwärts geführten Halbkreis-Manöver – ist Swift in der Lage, engere, präzisere Flugbahnen zu nutzen. Die Differenz zu menschlichen Piloten könnte darin liegen, dass die KI langfristige Optimierungen besser verarbeiten kann, während Menschen tendenziell nur einen Schritt voraus planen. Zudem nutzt Swift zusätzlich den Vorteil der Inertialsensoren, die Bewegungsinformationen direkt erfassen, und die geringere Reaktionszeit aufgrund kürzerer Latenzen, was zu schnelleren Reaktionen auf plötzliche Situationen führt.

Trotzdem bringen menschliche Piloten weiterhin Stärken mit, etwa die Fähigkeit zur Robustheit nach einem Crash und Anpassung an sich ändernde Umweltbedingungen wie Lichtverhältnisse. Swift hingegen verlässt sich auf eine bekannte Umgebung und kämpft, wenn sich etwa die visuellen Eigenschaften verändern. Auch die KI ist nicht darauf trainiert, aus Abstürzen zu lernen und steht daher in Sachen Stabilität noch vor Herausforderungen. Die zugrunde liegende Technik hebt sich deutlich von klassischen Ansätzen ab. Während traditionelle Methoden der Flugsteuerung auf vordefinierte Trajektorien und Modellbasierte Regelungen setzen, die oft vollständig auf perfekte Zustandsinformationen angewiesen sind, nutzt Swift moderne hybride Ansätze.

Das Lernen im Simulator mit Echtwelt-Daten erlaubt eine generalisierbare Robustheit, die in Testszenarien mit Realitätsabweichungen klassische Algorithmen deutlich übertrifft. Insbesondere ist die Kombination aus Deep-RL, empirischen Residualmodellen und einer Kalman-Filter-basierten Sensorfusion innovativ und zeigt, wie künstliche Intelligenz praktisch nutzbar gemacht werden kann. Auf dem Hardware-Sektor setzt Swift eine durchdachte und für hohe Dynamik optimierte Plattform ein: Ein 870-Gramm-Quadcopter verfügt über leistungsfähige Motoren, die den nötigen Schub liefern, und eine Nvidia Jetson TX2 Recheneinheit zur Echtzeit-Bildverarbeitung und Steuerungsausführung. Die Bildverarbeitung umfasst Gate-Erkennung mittels neuronaler Netzwerke und die Visual-Inertial Odometry, ein Standardverfahren zur Bewegungs- und Positionsschätzung auf Basis von Kamerabildern und IMU-Daten. Jedes Element ist auf Echtzeitbetrieb und maximale Laufzeitoptimierung zugeschnitten.

Das Vertrauen in Swift wurde zusätzlich durch die Rückmeldungen der renommierten Piloten bestätigt, die den Wettkampf mit dem autonomen System als eine neue Herausforderung und Motivation einstufen. Ihre Statements sprechen von der faszinierten Erkenntnis der Leistungsfähigkeit von KI sowie vom Respekt vor dem unermüdlichen Einsatz einer Maschine im Gegensatz zum menschlichen Ermüdungsfaktor. Betrachtet man die technische Grundlage, so ist Proximal Policy Optimization als Trainingsalgorithmus hervorzuheben. Es handelt sich um eine moderne Methode, die stabilere Updates der KI-Policy erlaubt, indem größere Sprünge im Politikraum vermieden werden. Dadurch gelingt es, in nur rund 50 Minuten auf einer leistungsfähigen Workstation eine effiziente Steuerungsstrategie zu entwickeln, die bereits verfeinert werden kann, wenn echte Flugdaten in der Simulation einfließen.

Die Kombination aus Deep Learning, präziser Systemmodellierung und realen Flugdaten stellt zudem eine Blaupause für weitere Anwendungen außerhalb des Drohnensports dar. Autonome Systeme, etwa im Bereich selbstfahrender Autos, autonomer Flugobjekte oder Assistenzroboter, benötigen vergleichbare Fähigkeiten zur Wahrnehmung in komplexen Umgebungen, schnelle Reaktionsfähigkeit und dynamisches Steuern unter Unsicherheit. Die Erfolge von Swift zeigen, wie hybride Ansätze mit realweltlicher Datenintegration auch in anderen Bereichen zum Durchbruch führen können. Schließlich lässt sich sagen, dass der Erfolg von Swift eine Verschmelzung von Simulation, empirischer Modellierung und lernbasiertem Steuern ist, die die Brücke schlägt zwischen digitaler Intelligenz und physikalischer Welt. Dies eröffnet nicht nur neue Perspektiven für den Sport und Wettbewerb, sondern auch für die praktische Nutzung und Weiterentwicklung autonomer Robotersysteme.

Das Potenzial, das in der Verschmelzung von Reinforcement Learning mit realen Robotikplattformen steckt, wird künftig weitere bahnbrechende Innovationen hervorbringen. Zusammenfassend steht der 2023 vorgestellte Swift als Meilenstein für autonome mobile Systeme, die an der Spitze menschlicher Leistung konkurrieren können. Dies ist ein bedeutender Schritt auf dem Weg zu vielseitigen, hochdynamischen Robotersystemen, die in Echtzeit autonome Entscheidungen treffen, anwendungsorientiert lernen und gleichzeitig die harten Anforderungen physischer Umgebungen meistern.