Künstliche Intelligenz (KI) hat in den letzten Jahren enorme Fortschritte gemacht, doch herkömmliche Modelle basieren meistens auf der Verarbeitung riesiger Datenmengen, um komplexe Aufgaben zu bewältigen. Diese Vorgehensweise ist nicht nur kostenintensiv, sondern auch zeitaufwendig. Aktuelle Forschungsarbeiten werfen nun eine völlig neue Sichtweise auf das Training von KI-Systemen: Es reicht offenbar aus, ein einziges, perfekt gewähltes Beispiel zu nutzen, um die Leistungsfähigkeit eines Modells signifikant zu verbessern. Diese revolutionäre Erkenntnis könnte die Art und Weise, wie KI trainiert wird, grundlegend verändern und zahlreiche Branchen nachhaltig beeinflussen. Die Idee, dass ein überragendes Beispiel mehr bewirken kann als tausende Datenpunkte, öffnet Türen für einen effizienteren, ressourcenschonenderen Umgang mit KI-Technologie.

Traditionelles Training versus Ein-Beispiel-Training Typischerweise erfordern KI-Modelle, insbesondere große Sprachmodelle, eine enorme Menge an Trainingsdaten. Diese stellen sicher, dass das Modell vielfältige Muster erkennt, variantenreiches Wissen erlernt und somit auch schwierige Aufgaben zuverlässig lösen kann. Doch für viele spezialisierte Anwendungsfälle ist qualitativ hochwertiges, gelabeltes Datenmaterial schwer zu erhalten. Besonders im medizinischen, juristischen oder technischen Umfeld ist die Erstellung eines umfangreichen Datensatzes mit menschlicher Expertise unausweichlich teuer und aufwendig. Die jüngste Studie zeigt nun, dass eine Methode namens "One-Shot Reinforcement Learning with Value Replay" (1-shot RLVR) es ermöglicht, mit nur einem einzigen Beispiel die Fähigkeiten einer KI dramatisch zu verbessern.

Durch diese Methode kann das Modell nicht nur seine Präzision bei komplexen Mathematikaufgaben von etwa 36 Prozent auf mehr als 73 Prozent steigern, sondern erzielt auch verbesserte Ergebnisse bei allgemeinen logischen und reasoning-orientierten Aufgaben. Wie genau funktioniert die Methode? Der Schlüssel liegt in der Auswahl des Trainingsbeispiels. Dabei handelt es sich nicht um ein besonders komplexes oder schwieriges Beispiel, sondern um eines, das das Modell bereits teilweise versteht. Dies baut auf dem vorhandenen Wissen des KI-Systems auf, anstatt komplett neue Konzepte einzuführen. Man kann dieses Vorgehen mit dem Lernen eines Schüler vergleichen, der nicht von null beginnt, sondern seine bereits vorhandenen Fähigkeiten durch eine gezielte Aufgabe weiter verbessert.

Während des Trainings optimiert das Modell seine Entscheidungsstrategien durch einen sogenannten Policy Gradient Loss – ein Mechanismus, der das Modell anleitet, bessere Handlungen auszuwählen. Zusätzlich fördert eine sogenannte Entropie-Verlustfunktion die Exploration neuer Lösungsansätze, was der KI dabei hilft, kreativere und effektivere Strategien zu entwickeln. Interessanterweise zeigte das Modell sogar dann noch gute Leistungen, als seine Ausgabe für das Trainingsbeispiel in eine Art mehrsprachiges Kauderwelsch überging – eine Form der Übereignung, die im menschlichen Lernen selten beobachtet wird. Die Rolle von Überanpassung und falschen Antworten Ein besonders überraschendes Ergebnis betraf den Umgang mit falsch klassifizierten oder inkorrekten Ausgaben. Die Forscher fanden heraus, dass kleine Fehler in der Benennung oder Interpretation nicht zwangsläufig die Leistung mindern.

Wenn die falschen Antworten jedoch plausibel wirkten, aber eindeutig inkorrekt waren, schadete das dem Modell stärker als nonsenshafte Ergebnisse. Dieses Verhalten deutet darauf hin, dass die KI in gewissem Maße „erkennt“, wann sie fehlgeleitet wird und darauf entsprechend reagiert. Anwendungsbereiche und zukünftige Potenziale Die Implikationen dieser Forschung sind weitreichend. Besonders Branchen mit begrenztem Zugang zu umfangreichen Datensätzen könnten enorm profitieren. Das Auswählen und Nutzen weniger, aber effektiver Trainingsbeispiele reduziert gleichzeitig die Kosten und den zeitlichen Aufwand für die KI-Entwicklung.

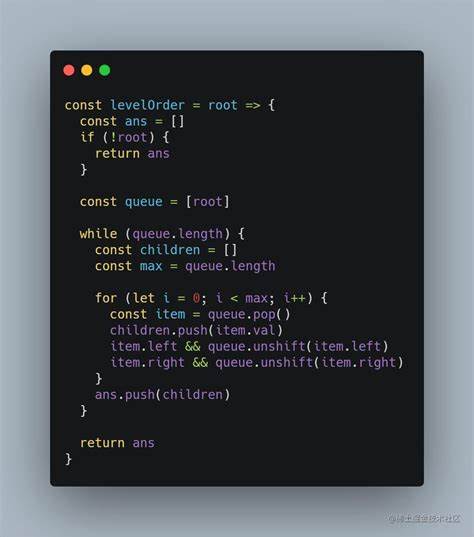

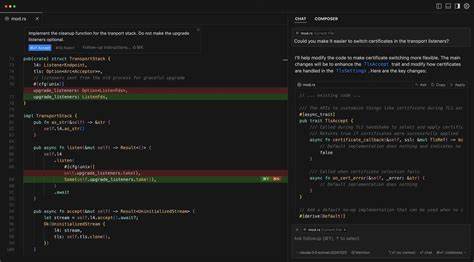

Dies schafft zugleich Möglichkeiten für kleineren Unternehmen und Forschungsteams, leistungsfähige KI-Anwendungen zu entwickeln, ohne auf riesige Ressourcen angewiesen zu sein. Neben mathematischen Problemstellungen zeigten sich auch Transfer-Effekte: Das Training mit einem Beispiel verbesserte die Leistung bei allgemeinen logischen Prüfungen sowie Herausforderungen in Bereichen, die auf analogem Denken basieren. Dieses Transferlernen erinnert an die Fähigkeit eines Menschen, von einer erlernten Fertigkeit auf andere Aufgaben zu schließen, und öffnet neue Wege für flexiblere KI-Systeme. Die Forschenden planen, das Verfahren weiterzuentwickeln und unter anderem auf die automatische Programmierung auszudehnen. Auch Anwendungen ohne kristallklar definierte korrekte Antworten stehen im Fokus, etwa explorative Erfahrungslernen oder kreative Problemlösung.

Hier gilt es, die Balance zwischen Überfitting und vielfältigem Denken zu meistern, um die Rechenmodelle möglichst universell einsetzbar zu machen. Herausforderungen und offene Fragen Trotz der beeindruckenden Fortschritte bleiben einige Fragen offen. Die theoretischen Grundlagen für die sogenannte „Post-Saturation Generalization“ – die fortschreitende Leistungssteigerung auch nachdem das Modell das Trainingsbeispiel komplett gemeistert hat – sind noch nicht vollständig verstanden. Außerdem stellt die Auswahl des optimalen Trainingsbeispiels eine neue Herausforderung dar. Der Prozess, dieses „perfekte“ Beispiel zu identifizieren, ist entscheidend für den Erfolg, erfordert jedoch noch systematische Methoden und tiefere Einsichten.

Langfristig könnte diese Paradigmenverschiebung beim KI-Training die Entwicklung nachhaltigerer und sozialverträglicherer Technologien fördern. Weniger Ressourcenverbrauch bei gleichbleibender oder verbesserter Leistung bedeutet auch einen geringeren ökologischen Fußabdruck, was in Zeiten zunehmender Kritik an der Umweltbilanz von KI-Systemen zunehmend an Bedeutung gewinnt. Fazit Die Erkenntnis, dass künstliche Intelligenz mit einem einzigen gut gewählten Beispiel komplexe Aufgaben deutlich besser lösen kann als mit Tausenden, ist ein Meilenstein in der KI-Forschung. Sie fordert etablierte Denkweisen rund um Datenmengen, Trainingszeiten und Kosten heraus. Qualität etwaiger Trainingsdaten wird zum entscheidenden Faktor und nicht mehr allein die Quantität.

Das veränderte Verständnis vom KI-Lernen öffnet Spielräume für effizientere, vielseitigere und zugänglichere KI-Lösungen in unterschiedlichsten Anwendungsgebieten. Diese Entwicklung ist nicht nur spannend für Wissenschaftler, sondern bietet auch Unternehmen und Entwicklern neue Werkzeuge, um KI sinnvoll einzusetzen, ohne immense Ressourcen investieren zu müssen. Schließlich zeigt sich: Manchmal reicht eben ein einziger, gut ausgewählter Impuls, um Großes zu bewirken.