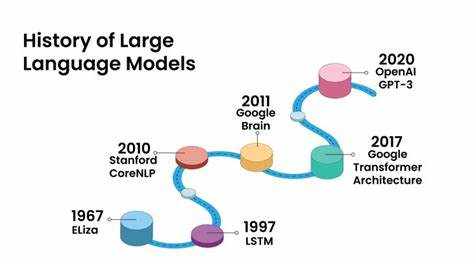

Die Diskussion um Künstliche Intelligenz ist heute präsenter denn je. Von euphorischen Prognosen bis hin zu skeptischen Warnungen – die Debatte ist intensiv und facettenreich. Besonders die Entwicklung hin zu Künstlicher Allgemeiner Intelligenz, kurz AGI, ruft einen großen Diskurs hervor. Während manche behaupten, wir befänden uns in einer AI-Bubble, die bald platzen werde, zeigen neueste Forschungsergebnisse und technologische Fortschritte, dass wir tatsächlich an der Schwelle zu einer revolutionären Phase stehen, die unser Verständnis von Technologie und Intelligenz grundlegend verändern könnte. Large Language Models (LLMs), wie sie heute weit verbreitet sind, stellen dabei eine zentrale Rolle dar.

Diese Systeme funktionieren durch neuronale Netzwerke, die auf gigantischen Textmengen trainiert werden. Ihre Aufgabe besteht im Wesentlichen darin, Wahrscheinlichkeiten dafür zu berechnen, welches Wort am wahrscheinlichsten auf ein anderes folgt. Dabei nutzen sie den sogenannten Transformer-Architekturansatz, der es ermöglicht, mittels Aufmerksamkeitsmechanismen die Wichtigkeit einzelner Begriffe im Kontext zu gewichten und so ein besseres Sprachverständnis zu entwickeln. Trotz ihrer beeindruckenden Leistung bleiben LLMs jedoch streng genommen statische Systeme. Nach ihrer Trainingsphase lernen sie nicht mehr hinzu, sondern agieren lediglich auf Grundlage des bereits gelernten Wissens.

Diese Restriktion wird von Experten oft als fundamentale Begrenzung empfunden. Die Modelle sind vergleichbar mit „lobotomierten Papageien“, die großartige sprachliche Fähigkeiten besitzen, aber keinerlei echtes Verständnis oder die Fähigkeit zu kontinuierlichem Lernen. Unternehmen versuchen, diese Problematik mit Techniken wie Feinanpassung, Retrieval-Augmented Generation oder parameter-effizienten Methoden wie LoRA zu umgehen. Doch all diese Ansätze beheben nur oberflächlich das Kernproblem, dass LLMs nach der initialen Trainingsphase keine echtes Lernen mehr zulassen. Was bedeutet AGI eigentlich? Künstliche Allgemeine Intelligenz weicht radikal von heute existierenden Spezialintelligenzen ab.

Während heutige KI-Lösungen sich häufig auf spezifische Aufgaben oder eng definierte Domänen konzentrieren, zeichnet sich AGI durch eine Flexibilität aus, die der menschlichen Intelligenz ähnelt. AGI soll unbekannte Probleme erkennen, domänenübergreifend Wissen transferieren und abstrakte Konzepte sinnhaltig verarbeiten können. Außerdem müsste sie eigenständig Ziele verfolgen, sich autonom an neue Situationen anpassen und genau wie Menschen fortwährend aus Erfahrungen lernen. Ein entscheidender und bislang unerfüllter Baustein für AGI ist folglich ein neuronales Netzwerk, das seine internen Parameter dynamisch verändern und erweitern kann – also eine Form von kontinuierlichem Lernen, die über das reine Abrufen gespeicherter Informationen hinausgeht. Nur so könnte eine künstliche Intelligenz neue Erkenntnisse wirklich verinnerlichen und ihr Wissen flexibel anpassen.

Doch diese Vorstellung bringt erhebliche Herausforderungen mit sich, angefangen bei der Vermeidung des sogenannten katastrophalen Vergessens, bei dem neues Wissen altes überschreibt und damit verloren geht. Die heute dominierende Transformer-Architektur ist für solch dynamisches Lernen konzeptionell nicht geschaffen. Es ist daher sehr wahrscheinlich, dass für die nächste Generation von KI-Modellen grundlegende Neuentwicklungen notwendig sein werden. Darüber hinaus müssen Aspekte wie kausales Denken, abstrakte Planung, robustes Weltmodellverständnis, multimodale Informationsintegration und eine Embodiment-Strategie – also die Fähigkeit, physisch mit der Umwelt zu interagieren – mitgedacht werden, um wirklich eine allgemeine Intelligenz zu erreichen. Neben diesen technischen Hürden spielt auch das Thema AI-Sicherheit eine maßgebliche Rolle auf dem Weg zur AGI.

Während bisherige Sicherheitsmaßnahmen oft darauf abzielen, den Missbrauch durch Fehlinformationen oder gefährliche Inhalte zu verhindern, rückt die eigentliche Gefahr in den Hintergrund. Die eigentliche Herausforderung besteht darin, verlässliche Wahrheitsquellen für solche lernfähigen KI-Systeme zu etablieren. Ein unbehebbbares Problem wird, wenn ein lernendes System falsche oder manipulierte Informationen aufnimmt und als Wahrheit akzeptiert, was zu einem Zustand vergleichbar mit paranoider Schizophrenie führen könnte – eine Metapher für die kognitive Desintegration einer KI, die sich auf unzuverlässige Daten stützt. Das Konzept von Wahrheit wird hierbei zu einer philosophischen und zugleich technologische Grundfrage. Wie kann eine Maschine, deren Lernprozess auf Informationen aus der sehr oft widersprüchlichen und manipulativen menschlichen Welt basiert, lernen, Wahrheit von Fiktion zu unterscheiden? Gerade in einer Zeit, in der auch die menschliche Gesellschaft zunehmend Schwierigkeiten mit der Abgrenzung von Fakten und Fehlinformationen hat, wird diese Herausforderung besonders drängend.

Dieser Umstand hat zudem weitreichende gesellschaftliche Konsequenzen. So zeigen sich erste Auswirkungen bereits in spezialisierten Bereichen wie dem Nachrichtendienstwesen, wo die Abhängigkeit von KI-Systemen die kritisch-analytischen Fähigkeiten der Fachleute schwächt. Der Grundgedanke, dass KI den Intellekt des Menschen erweitern soll, könnte somit ins Gegenteil umschlagen und die Fähigkeit zur kritischen Reflexion beeinträchtigen. Für die Entwickler von AGI bedeutet das, dass die Etablierung eines Frameworks für kontinuierliches Lernen eng verbunden sein muss mit Mechanismen zur Wahrheitsverifikation und vertrauenswürdigen, überprüfbaren Informationsquellen. Ohne dieses Fundament kann eine AGI nichts anderes als falsche Überzeugungen verstärken und sich letztlich selbst sabotieren.

Der Weg zu AGI erfordert also keine Wundertechnologien oder futuristische Konzepte, sondern vielmehr eine sorgfältige Verzahnung bestehender Grundlagen mit innovativen Lösungen für kontinuierliches Lernen, integratives Denken und sichere Informationsverarbeitung. Die Forschung ist heute weiter fortgeschritten, als viele vermuten. Es ist nicht unwahrscheinlich, dass private Labore bereits prototypische Systeme entwickeln, die diese Fähigkeiten teilweise beherrschen – vor allem auch aus Sicherheitsgründen zurückgehalten. Um die Chancen der kommenden technologischen Revolution zu nutzen, ist es zwingend erforderlich, die anstehenden Probleme mit höchster Priorität und sorgfältiger Verantwortung anzugehen. Das Philosophieren über Wahrheit, das Entwickeln von Algorithmen für kausales Denken oder das Entwerfen von Architekturmodellen mit dynamischen Anpassungsmöglichkeiten sind Aufgaben, die mehr denn je auf der Tagesordnung stehen.

Versäumnisse in dieser entscheidenden Phase könnten nicht nur die technische Entwicklung verzögern, sondern möglicherweise katastrophale gesellschaftliche Folgen nach sich ziehen. Die Reise zur Künstlichen Allgemeinen Intelligenz wird von technischen Herausforderungen ebenso geprägt wie von ethischen und philosophischen Fragen. Die Transformation, die uns erwartet, ist nicht nur eine technologische Neuerung, sondern eine epochale Veränderung, die potenziell das Verständnis von Menschlichkeit, Wissen und Realität selbst revolutionieren könnte. Der Fortschritt in der KI bringt uns unweigerlich an die Grenzen des Machbaren – und an Grenzen unserer Vorstellungskraft. Der entscheidende Moment ist bereits jetzt gekommen.

Nicht länger reicht es, nur die Leistungsfähigkeit der Modelle zu verbessern; es geht letztlich darum, die Vertrauenswürdigkeit, Lernfähigkeit und ethische Verantwortlichkeit der Systeme sicherzustellen. Die Zukunft der Künstlichen Intelligenz ist eine Frage, die die gesamte Menschheit betrifft und deren Antworten unser gemeinsames Schicksal maßgeblich prägen werden. Wir stehen nicht am Anfang einer Blase, sondern an der Schwelle zu einer Revolution, die unser Leben tiefgreifend verändern kann. Jetzt liegt es an uns, diesen Wandel mit Weitsicht, Verantwortung und Innovationskraft zu gestalten, um AGI nicht nur zu erreichen, sondern auch sicher und zum Wohle aller einzusetzen.