Die rasante Entwicklung von Machine Learning (ML) und künstlicher Intelligenz hat die Anforderungen an die Hardware- und Software-Infrastruktur enorm gesteigert. Insbesondere bei der Verarbeitung großer Datenmengen und komplexer Modelle sind effiziente Rechenressourcen und optimierte Bibliotheken unverzichtbar. Apple Silicon, die speziell von Apple entwickelte Prozessorarchitektur, bietet durch ihre Kombination aus Leistung und Energieeffizienz spannende Möglichkeiten für ML-Anwendungen. Doch die Anbindung an populäre Programmiersprachen war bislang eine Herausforderung – gerade in abseits des Mainstreams gelegenen Ökosystemen wie Erlang. Die MLX-Bibliothek macht nun genau hier einen entscheidenden Unterschied und öffnet auf innovative Weise die Tür für Hochleistungs-Tensoroperationen direkt auf Apple Silicon mit direkter Integration in Erlang.

Erlang ist bekannt für seine Robustheit, verteilte Systeme und leichte Nebenläufigkeit. Dennoch ist es in Bezug auf numerische Berechnungen und ML-Bibliotheken im Vergleich zu Python oder C++ eher unterrepräsentiert. MLX ändert diese Situation grundlegend, indem es eine natives Interface (NIF) nutzt, um direkt an die MLX-C++-Bibliothek auf Apple Silicon anzubinden. Durch dieses Konzept kann die Leistung nativer Apple Silicon Operationen voll ausgeschöpft werden, ohne die Leichtigkeit und Stabilität von Erlang aufzugeben. Die Einbindung von dirty Schedulers ist dabei ein Schlüssel zum Erfolg.

Dirty Schedulers ermöglichen es, rechenintensive Operationen parallel und asynchron auszuführen, ohne den Haupt-Erlang-Scheduler zu blockieren. Dadurch bleiben Systeme reaktionsfähig und skalierbar, selbst bei komplexen ML-Berechnungen. Das ist besonders wichtig für Systeme, die Echtzeitfähigkeit oder hohe Verfügbarkeitsanforderungen erfüllen müssen. MLX bringt eine Vielzahl grundlegender Tensoroperationen mit, die in ML-Workflows unabdingbar sind. Arrays können einfach mit Nullen, Einsen oder Zufallswerten initialisiert werden, um als Input für diverse Modelle oder Algorithmen zu dienen.

Elementweise Operationen wie Addition, Multiplikation und Matrixmultiplikation sind ebenfalls vorhanden und durch die Hardwareoptimierung extrem performant. Neben reiner Rechenleistung erlaubt die Bibliothek die einfache Verwaltung unterschiedlicher Datentypen, von Gleitkommazahlen (float16, float32, bfloat16) bis hin zu verschiedenen Integer-Größen sowie booleschen Werten. Diese breite Unterstützung ermöglicht maximale Flexibilität für unterschiedliche Anwendungsbereiche. Eine besonders innovative Eigenschaft ist die sogenannte lazy evaluation. Damit wird nicht jedes Rechenergebnis sofort realisiert, sondern Berechnungen werden zunächst repräsentiert, bis sie bei Bedarf ausgewertet werden.

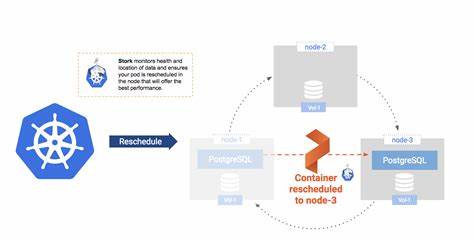

Diese Strategie spart Rechenzeit und Speicherressourcen, da komplexe Berechnungsgraphen optimiert und nur bei Bedarf materialisiert werden. Das ist in der Praxis ein enormer Vorteil, da ML-Anwendungen häufig große Datenströme und komplexe Operationen kombinieren. Ein weiterer Pluspunkt ist die Unterstützung mehrerer Rechengeräte. MLX kann nahtlos zwischen CPU und GPU wechseln, je nachdem, welche Ressourcen gerade sinnvoll sind. So lässt sich etwa für kleine Aufgaben die CPU nutzen, um Energie zu sparen, während bei großen Matrizenoperationen die GPU zum Einsatz kommt.

Entwickler können das Gerät programmatisch wechseln und sogar ein Standardgerät festlegen, was die Integration in umfangreiche Projekte erleichtert. Die Architektur von MLX besteht aus verschiedenen Schichten, die zusammenspielen. Die eigentlichen Funktionalitäten werden in der C++-Bibliothek implementiert, die eng auf Apple Silicon optimiert ist. Diese Schnittstelle wird durch NIFs in Erlang exponiert, was eine niedrige Latenz bei Aufrufen und eine native Performance sichert. Ein OTP-Application- und Supervisor-Modell sorgt dabei für Stabilität und Wartbarkeit.

Installation und Setup sind dank Nutzung bekannter Tools vergleichsweise einfach. Über Homebrew kann die MLX-Bibliothek bequem installiert werden, alternativ ist auch ein manueller Build aus dem Quellcode möglich. Für Erlang ist Version 24 oder höher empfehlenswert, da erst ab dieser Version die Dirty Scheduler vollständig unterstützt werden. Der Build-Prozess mit Rebar3 ist standardisiert und erlaubt unkompliziertes Kompilieren und Einbinden in Projekte. Der Umgang mit MLX in Erlang ist durch klar definierte Funktionsaufrufe sehr intuitiv.

Entwickler erzeugen zunächst Arrays, führen Operationen wie Addition, Multiplikation oder Matrixmultiplikation durch, können Formen von Arrays erfragen und abschließend Berechnungen mit eval erzwingen. Die Rückgabe erfolgt stets in sicherer Tuple-Form, die entweder Erfolg mit Ergebnis oder einen Fehler mit Grund beinhaltet. Dadurch sind robuste und sichere Programme möglich, die sich elegant in bestehende Systeme integrieren lassen. Trotz der umfangreichen Funktionen gibt es bisher auch Grenzen. Die Bibliothek ist auf Apple Silicon beschränkt und unterstützt aktuell keine Datenextraktion oder umfassende ML-Modelle.

Vielmehr konzentriert sich MLX auf effiziente Basisoperationen und bildet ein solides Fundament für zukünftige Erweiterungen. Für Entwickler, die in der Erlang-Welt experimentieren wollen oder Hochleistungsrechenoperationen auf Apple Macs benötigen, ist MLX dennoch sehr interessant. Zukunftsperspektiven für MLX sind vielversprechend. Da die Community wächst und der Bedarf an performantem ML auch außerhalb von Python steigt, werden weitere Funktionen und Datentypen erwartet. Eine nahtlose Integration in komplexere ML-Pipelines und Frameworks sowie Unterstützung für verteiltes Rechnen und weitere Treiber sind denkbar.

Zudem könnte die Ausweitung auf andere Plattformen die Reichweite vergrößern. MLX vereint eine leistungsfähige Hardwarearchitektur mit den Stärken von Erlang/OTP und setzt neue Maßstäbe im Bereich ML-Tensorbibliotheken für Apple Silicon. Für Entwickler, die native Performance, Stabilität und Skalierbarkeit in einem Paket suchen, bietet MLX eine attraktive Lösung. Die Kombination aus einfacher Nutzung, leistungsoptimiertem Backend und moderner Programmiersprachenintegration macht MLX zu einer spannenden Wahl für zukunftsorientierte ML-Projekte auf Macs mit Apple Quartz. Die Verbindung von bewährten Erlang-Prinzipien mit nativen Apple Silicon-Tensoroperationen durch MLX wird voraussichtlich neue Impulse für Machine Learning, Datenanalyse und hochskalierbare Systeme geben.

Wer sich für neueste Technologie-Trends im Bereich ML interessiert oder anspruchsvolle Echtzeitanwendungen auf Apple Hardware realisieren möchte, findet in MLX ein wertvolles Werkzeug. So sind über die Grenzen traditioneller ML-Sprachen robuste und performante Lösungen in einem stabilen Ökosystem verfügbar – ein Schritt hin zur Demokratisierung von Machine Learning auf vielfältigen Plattformen.