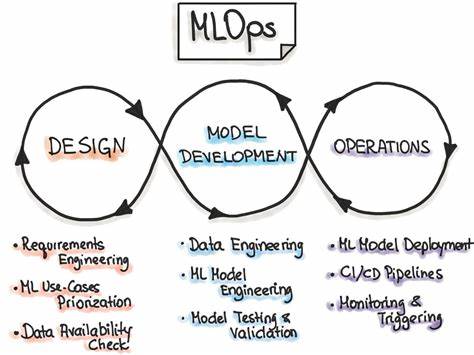

Im Zeitalter der Künstlichen Intelligenz und des maschinellen Lernens gewinnen Tools zur Überwachung und Verwaltung von Experimenten zunehmend an Bedeutung. Mit der explosionsartigen Verbreitung von ML-Modellen in verschiedensten Branchen sind Datentransparenz, Effizienz und Stabilität entscheidende Faktoren, um den Trainingsprozess zu optimieren und wertvolle Ressourcen zu schonen. Genau in diesem Kontext tritt mlop als offenes und innovatives Experiment-Tracking-Tool für Machine Learning hervor. mlop ist ein modernes Open-Source-Projekt, das sich als zuverlässiger Wegbegleiter für ML-Ingenieure etabliert, die ihre Modelle nicht nur besser verstehen, sondern auch schneller verbessern wollen. Anders als viele andere Lösungen konzentriert sich mlop intensiv auf Effizienz und Skalierbarkeit, um den zunehmenden Anforderungen moderner ML-Projekte gerecht zu werden und gleichzeitig ein hohes Maß an Performance sicherzustellen.

Die Besonderheit von mlop liegt in der durchdachten Architektur und dem Technologie-Stack, der sich aus mehreren hochperformanten Komponenten zusammensetzt. Der Serveranteil ist in Rust programmiert, einer Programmiersprache, die bekannt ist für ihre Geschwindigkeit und Sicherheit – ideal, um riesige Mengen an Trainingsdaten und Metriken schnell und zuverlässig zu verarbeiten. Ergänzend dazu stellt ein Node.js-Webserver die Benutzeroberfläche bereit, über die Anwender bequem auf alle Tracking-Daten zugreifen und diese analysieren können. Für verschiedene unterstützende Prozesse kommt Python zum Einsatz, das insbesondere bei der Datenanreicherung flexibel und unkompliziert agiert.

Auch der Client-Part in Python wurde mit Fokus auf minimale Ressourcennutzung und asynchrone Datenübertragung umgesetzt, sodass ML-Ingenieure während ihrer Entwicklungszyklen effektiv und ohne spürbare Verzögerungen arbeiten können. mlop verfolgt eine klare Vision: Es will ML-Ingenieuren eine Plattform an die Hand geben, die genau für ihre speziellen Anforderungen entwickelt wurde und von dieser Community auch mitgestaltet wird. Die Entwickler von mlop waren unzufrieden mit bestehenden ML-Observability-Tools, die häufig sperrig sind, zu viel Rechenleistung verbrauchen oder bei der Skalierung Probleme bereiten. Mit mlop soll der gesamte Trainingsprozess transparenter werden, indem alle wichtigen Kennzahlen und Parameter lückenlos über die komplette Pipeline hinweg verfolgt werden – vom initialen Parameter-Setup bis hin zur Protokollierung von Gradienten während des Trainings. Die Bedeutung eines solchen Tools wird besonders dann deutlich, wenn man an typische Probleme bei ML-Projekten denkt, etwa versteckte Fehler in der Datenvorbereitung, ineffiziente Hyperparameter oder schlichtweg das Einsparen von teurem Cloud-Compute.

mlop ermöglicht es, potenzielle Probleme frühzeitig zu erkennen und dadurch kostspielige Fehltrainings zu vermeiden. Durch die genaue Nachverfolgung von Modellentwicklungen können Entwickler nachvollziehen, welche Änderungen in der Architektur, in den Hyperparametern oder im Dataset zu welchen Ergebnissen geführt haben. Daraus ergeben sich nicht nur bessere Modelle, sondern auch ein effizienterer Entwicklungszyklus, der den Innovationsprozess beschleunigt. Open Source als Grundpfeiler von mlop ist ein weiterer Schlüssel zum Erfolg. Die freie Verfügbarkeit des Quellcodes fördert nicht nur die Transparenz und Sicherheit der Anwendung, sondern ermöglicht auch eine lebendige Mitgestaltung durch eine stetig wachsende Community von ML-Professionals und Entwicklern.

Durch den Einsatz einer permissiven Lizenz (GPL-3.0) können Nutzer mlop frei an ihre individuellen Needs anpassen oder Erweiterungen programmieren. Das schafft eine flexible Grundlage für verschiedenste ML-Szenarien, sei es in der Forschung, bei Start-ups oder in großen Unternehmen. Die Benutzererfahrung ist ein weiterer wichtiger Aspekt, denn gerade die Visualisierung und intuitive Verfügbarkeit von Metriken entscheiden oft über den Mehrwert eines Tracking-Tools. mlop bietet eine webbasierte Oberfläche, die Nutzern erlaubt, alle relevanten Trainingsdaten in Echtzeit einzusehen, zu vergleichen und auszuwerten.

Dadurch werden auch komplexe Experimente beherrschbar und der Blick aufs Wesentliche bleibt erhalten. Neben den Basismetriken wie Trainings- und Validierungsgenauigkeit oder Fehlerwerten können Anwender detaillierte Einblicke in Parameteränderungen, Gradientenflüsse und weitere technische Details gewinnen. Darüber hinaus profitieren Nutzer von mlop von der effizienten Datenverarbeitung, die ressourcenschonend implementiert ist. So wird die sonst häufig beobachtete Verzögerung bei der Protokollierung oder beim Abruf von Trainingsinformationen minimiert. Diese schnelle Reaktionszeit ist entscheidend, wenn Modelle in Echtzeit angepasst oder überwacht werden müssen, beispielsweise im Bereich des Reinforcement Learnings oder bei Online-Modellen, die ständig neue Daten erhalten.

Ein weiteres Argument für mlop ist die hervorragende Integration in bestehende Entwicklungsumgebungen und Workflows. Da mlop mit Python als Client-API arbeitet, können Machine-Learning-Ingenieure problemlos ihre gängigen Frameworks wie TensorFlow, PyTorch oder Scikit-Learn mit mlop verbinden. Somit entfällt die Notwendigkeit großer Umstellungen im Entwicklungsprozess, was gerade in agilen Teams ein bedeutender Vorteil ist. Auch in puncto Skalierbarkeit glänzt mlop. Gerade Unternehmen, die mehrere Projekte oder Teams managen, profitieren von einem Tool, das sowohl kleine Versuchsaufbauten als auch groß angelegte Trainingscluster unterstützt.

Durch die modulare Struktur von mlop lassen sich Funktionen erweitern oder Ressourcen je nach Bedarf dynamisch allokieren, ohne dass die Stabilität darunter leidet. Der Nutzen von mlop schöpft sich letztlich aus der Kombination von hochperformanter Technologie, benutzerfreundlichem Design und einer Community-getriebenen Öffnung, die flexibles Experimentieren mit ML-Modellen revolutioniert. Um nachhaltig von mlop zu profitieren, empfiehlt es sich, nicht nur das Werkzeug einzusetzen, sondern auch aktiv am Open-Source-Projekt mitzuwirken, etwa durch Feedback, Feature-Requests oder Codebeiträge. Zusammenfassend lässt sich sagen, dass mlop eine vielversprechende Option für alle ist, die ihre Machine-Learning-Experimente auf das nächste Level heben wollen. Es vereint Effizienz, Skalierbarkeit und Transparenz in einer Plattform, die speziell für die Bedürfnisse von ML-Ingenieuren konzipiert wurde.

Angesichts der steigenden Komplexität von ML-Workflows und der wachsenden Bedeutung von Rechenressourcenschonung bietet mlop eine Antwort auf zentrale Herausforderungen moderner KI-Entwicklung. Wer sich intensiver mit mlop beschäftigen möchte, findet umfangreiche Dokumentationen und eine aktive Entwicklungsumgebung auf GitHub. Die Offenheit und der Fokus auf echte Anwenderbedürfnisse machen mlop zu einem hilfreichen Partner für das Experimentieren, Verstehen und Verbessern von maschinellen Lernmodellen – mit einem klaren Ziel vor Augen: die Qualität von ML-Projekten nachhaltig zu steigern und Ressourcen besser zu nutzen.