Die Erstellung von Prompts für Large Language Models (LLMs) stellt Entwickler und Entwicklerinnen häufig vor zahlreiche Herausforderungen. Insbesondere bei komplexen Aufgaben, die konditionale Logik, umfangreiche Formatierungen und eine klare Struktur erfordern, wird die Verwaltung und Pflege der Prompts schnell unübersichtlich. Klassische Methoden wie einfache String-Konkatenation stoßen dabei schnell an ihre Grenzen und führen häufig zu fehleranfälligem Code, der schwer zu warten ist. Genau hier setzt eine innovative Lösung namens llm-prompt-tag an, die tagged template literals nutzt, um die Entwicklung von LLM-Prompts erheblich zu vereinfachen, lesbarer und vor allem wartbarer zu gestalten. Tagged Template Literals sind eine native Funktion von JavaScript und TypeScript, mit der es möglich ist, Template Strings mit einer eigenen Verarbeitungsfunktion zu kombinieren.

Dadurch lassen sich Textinhalte dynamisch formatieren, transformieren oder konditionell anzeigen, während die Syntax einfach und intuitiv bleibt. Die Bibliothek llm-prompt-tag baut genau auf diesem Mechanismus auf und erweitert ihn speziell für die Anforderungen bei der Prompterstellung für KI-Modelle. Ein zentrales Problem bei der Entwicklung von Prompts besteht darin, unterschiedliche Bestandteile übersichtlich und modular zu gestalten. Prompts enthalten oft Aufzählungen von Problemen oder Lösungen, Beschreibungen, Debug-Sektionen oder benutzerdefinierte Abschnitte, die je nach Kontext ein- oder ausgeblendet werden sollen. Mit llm-prompt-tag lassen sich solche Abschnitte dank optionaler Header und Bedingungen elegant realisieren.

So kann die Anzeige einzelner Sektionen an boolesche Bedingungen geknüpft werden, sodass unnötiger Text automatisch wegfällt und nur relevante Teile erhalten bleiben. Das erhöht nicht nur die Flexibilität, sondern verbessert auch die Lesbarkeit des Codes. Ein weiteres Highlight der Bibliothek ist die automatische Formatierung und Bereinigung von Leerzeichen sowie Zeilenumbrüchen. Entwickler müssen nicht selbst darauf achten, dass die Ausgabe des Prompts sauber strukturiert ist, da llm-prompt-tag automatisch unangenehme Formatierungsfehler verhindert. Dies ist besonders wichtig, weil unsaubere Eingaben die KI-Modelle negativ beeinflussen können und unerwartete Ergebnisse hervorrufen.

Darüber hinaus unterstützt llm-prompt-tag eine intelligente Verarbeitung von Arrays und komplexen Objekten. So werden beispielsweise Arrays standardmäßig mit doppelten Zeilenumbrüchen getrennt, was die Übersichtlichkeit der Ausgaben erhöht. Gleichzeitig können benutzerdefinierte Formatierer angegeben werden, um die Darstellung der Daten noch gezielter zu steuern, etwa durch Kommas als Trenner oder andere spezielle Seperator-Strings. Das ermöglicht es, Prompts individuell an unterschiedliche Anforderungen und Stile anzupassen. Ein besonders mächtiges Feature der Bibliothek ist die Möglichkeit, benutzerdefinierte Typen via „makePrompt“ zu registrieren.

Mit dieser Funktion lassen sich eigene Typprüfungen (Type Guards) und zugehörige Formatierungsfunktionen anlegen, um komplexe Datenobjekte sauber und wiederverwendbar in Prompts einzubinden. Damit gelingt eine klare Trennung von Inhalt und Darstellung sowie die Wiederverwendbarkeit von Formatierlogik über verschiedene Prompts hinweg. Dieses Konzept vermeidet die ansonsten oft eingesetzte manuelle Serialisierung oder das mühsame Zusammenfügen von Strings. Stattdessen wählt die Bibliothek automatisch die passende Formatierung basierend auf dem Typ der eingebetteten Daten aus und setzt diese einheitlich und lesbar um. Für Entwickler entsteht daraus eine enorme Zeitersparnis und geringe Fehlerwahrscheinlichkeit.

Die Möglichkeit, Prompts außerdem miteinander zu verschachteln und zusammenzusetzen, macht die Bibliothek auch für große Anwendungsfälle interessant. Komplexe Benutzeranfragen oder Systemnachrichten können modular und wiederverwendbar definiert und später zu einem vollständigen Prompt kombiniert werden. Diese Kompositionsfähigkeit führt zu klaren Strukturen, die das Testen und Anpassen deutlich erleichtern und die Wartung drastisch vereinfachen. Neben diesen funktionalen Vorteilen überzeugt llm-prompt-tag durch seine Leichtgewichtigkeit. Die Bibliothek kommt komplett ohne externe Abhängigkeiten aus, was Installationen schlank hält und Integrationen in bestehende Projekte unkompliziert macht.

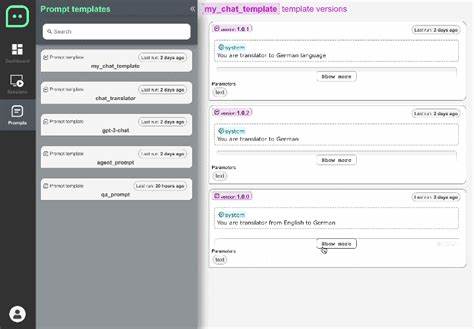

Zudem ist sie vollständig in TypeScript geschrieben und bietet daher Vorteile wie type-safe Funktionen und bessere Editor-Unterstützung. Die Installation erfolgt via npm mit einem einfachen Befehl, wodurch das Tool schnell in den Entwicklungsworkflow eingebunden werden kann. Die übersichtliche API beschränkt sich im Kern auf zwei Funktionen: prompt und makePrompt. Während prompt vor allem für einfache oder konditionelle Sektionen genutzt wird, ermöglicht makePrompt flexible Erweiterungen für die Verarbeitung spezieller Datentypen und die Anpassung der Standardformatierung. Auch im Entwicklungsprozess unterstützt llm-prompt-tag mit einer umfangreichen Reihe von Tests, die gängige Anwendungsszenarien abdecken.

So wird sichergestellt, dass auch bei Erweiterungen und Änderungen die Zuverlässigkeit und Konsistenz erhalten bleiben. Dies erhöht die Sicherheit, auf die Bibliothek langfristig zu setzen. Darüber hinaus erleichtert die Syntax dank Tagged Template Literals das Schreiben von Prompts erheblich. Ein häufiger Kritikpunkt in traditionellen Ansätzen ist, dass Prompts durch zu viele String-Konkatenationen schlecht lesbar sind und Änderungen oft umständlich durchgeführt werden müssen. Mit llm-prompt-tag sind Prompts nicht nur klar strukturiert, sondern haben zudem eine optisch ansprechende Darstellung im Quellcode, die nahe an der tatsächlichen Ausgabe liegt.

Das Tool eignet sich insbesondere für Entwickler und Teams, die Anwendungen mit LLM-Integration bauen und dabei Wert auf sauberen, wartbaren Code legen. Egal ob bei der Erstellung von Chatbot-Anweisungen, automatisierten Textgeneratoren oder anderen KI-gesteuerten Systemen – die Qualität und Klarheit der Prompts ist ein entscheidender Faktor für zuverlässige und relevante Ergebnisse. Mithilfe der vorgestellten Bibliothek lassen sich diese Anforderungen einfach erfüllen. Zusammenfassend bietet llm-prompt-tag eine elegante, moderne und leistungsfähige Lösung für alle Herausforderungen rund um die Erstellung von LLM-Prompts mit JavaScript und TypeScript. Die Kombination aus einfachen tagged template syntaktischen Mitteln, intelligenten Standardformatierungen sowie umfassender Erweiterbarkeit machen es möglich, komplexe Prompt-Logiken übersichtlich zu implementieren und zu verwalten.

Dadurch entsteht bei gleichzeitiger Flexibilität eine hohe Produktivität und Qualität in der Weiterentwicklung von KI-Anwendungen. Entwickler, die an einem sauberen und skalierbaren Ansatz für LLM-Prompt-Generierung interessiert sind, sollten llm-prompt-tag definitiv ausprobieren. Diese Bibliothek zeigt beispielhaft, wie moderne JavaScript-Features zielgerichtet eingesetzt werden können, um alltägliche Probleme in der KI-Entwicklung effektiv zu lösen. Ob in kleinen Projekten oder großen Softwarearchitekturen – mit llm-prompt-tag wird die Arbeit mit Prompts deutlich angenehmer, sicherer und leistungsfähiger.