Dialogorientierte Schnittstellen, oft auch als Conversational Interfaces bezeichnet, haben in den letzten Jahren eine bemerkenswerte Entwicklung durchlaufen. Während früher die Vorstellung von interaktiven Bots eher in den Bereich der Science-Fiction gehörte, ist heute die Technologie allgegenwärtig – von alltäglichen Sprachassistenten bis hin zu komplexen KI-Agenten, die Kundenservice und Automatisierung unterstützen. Doch trotz der immensen Fortschritte an der Backend-Seite, insbesondere durch den Einsatz leistungsfähiger Sprachmodelle wie GPT-5, klafft eine große Lücke in der Nutzererfahrung auf der Frontend-Seite. Diese Diskrepanz oft als Frontend-Stagnation bezeichnet, zeigt sich darin, dass Benutzer mit eher simplen, unflexiblen Textboxen und starren Chatfenstern interagieren, die den lebendigen und dynamischen Charakter menschlicher Gespräche nicht abbilden können. Es besteht ein dringender Bedarf, die Kunst der Mensch-zu-Mensch-Kommunikation zu verstehen und diese Prinzipien in den Bau von Bots einzuflechten, um eine natürlichere, menschlichere Interaktion zu ermöglichen.

Sprache ist die Basis allen Gesprächs, doch der wahre Kern dessen, was ein Gespräch ausmacht, liegt in den unausgesprochenen Regeln, Zeiten und Mustern, die es erst lebendig und nachvollziehbar machen. Gespräche sind keine bloße Abfolge von Worten, sondern ein kunstvoller Tanz aus Timing, Tonlage, Pausen und subtilen Signalen, die wir intuitiv verstehen – aber schwer in Code zu übertragen sind. Besonders faszinierend ist die Geschwindigkeit, mit der Menschen im Dialog reagieren: Oft liegen nur etwa 200 Millisekunden zwischen der letzten Äußerung und der Antwort. Diese Geschwindigkeit ist so hoch, dass selbst minimale Verzögerungen oder falsche Pausen die Bedeutung oder das Gefühl hinter einer Antwort komplett verändern können. Mit Blick auf den Zeitfaktor zeigt sich, dass die Dauer und Qualität von Pausen sowie die Intonation beim Sprechen Fortschritte in natürlichen Interfaces entscheidend beeinflussen.

So variiert etwa die Zeit, die Menschen benötigen, um mit „Ja“ oder „Nein“ zu antworten, ebenso wie die Geschwindigkeit, mit der eine nicht eindeutige Antwort gegeben wird. Auch bei der Zustimmung spielen Zeitaspekte eine subtile, aber bedeutende Rolle – je nachdem, wie schnell und bestimmend eine Zustimmung ausgesprochen wird, verändert sich die Wahrnehmung des Gesagten grundlegend. Um ein Gespräch glaubwürdig nachzuahmen, müssen Bots daher vorhersehen können, wann der Gesprächspartner fertig ist, was als nächstes kommen könnte, und den Zeitpunkt der eigenen Antwort so anpassen, dass sie nicht nur inhaltlich, sondern auch rhythmisch und emotional passt. Während Menschen dies über Gesichtsausdrücke, Augenkontakt und Tonlagen steuern, müssen künstliche Systeme dies mittels Stimmvariationen, der Analyse von Pausen und präziser Nutzung von Kontextinformationen erreichen. Die Herausforderung für Entwickler besteht darin, diese unsichtbaren Gesprächssignale zu erfassen und durch ein Interface zu vermitteln, das den Dialog keineswegs stört.

Dies führt zu einer Vielzahl an zu integrierenden Funktionen, darunter die exakte Erkennung von Enden einer Redephase, das Erkennen von Füllwörtern wie „ähm“ oder „wissen Sie“, die als indirekte Hinweise dienen, dass noch nicht beendet wird. Ein weiterer Schlüssel liegt in der Echtzeit-Vorhersage von nächsten Begriffen oder Sätzen, wodurch der Bot seinen nächsten Zug schon vorbereiten kann, noch bevor der Nutzer komplett gesprochen hat. Dies erfordert hochentwickelte Spracherkennungstechnologien, die ständig mit dem Input mitschwingen. Hinzu kommt die Fähigkeit, selbstständig kleine Überschneidungen im Gespräch zuzulassen, vor allem wenn es darum geht, in Notfällen höflich zu unterbrechen oder den Gesprächsfluss zu erhalten. Diese dynamischen Überlappungen machen eine Konversation viel natürlicher.

Dabei eröffnet sich auch die Notwendigkeit, den kulturellen Kontext zu berücksichtigen. Denn in verschiedenen Sprachen und Kulturen gelten unterschiedliche Regeln für Gesprächspausen, Überlappungen und den Umgang mit Unterbrechungen. So ist speziell in Japan der Wechsel zwischen den Gesprächsteilnehmern mit kaum wahrnehmbaren Pausen verbunden, während andere Kulturen längere Pausen respektieren und als höflich empfinden. Die Analogie zu Verkehrsampeln im Straßenverkehr veranschaulicht sehr gut, wie komplex die Gesprächssteuerung ist. Diese unsichtbaren Signale – Stehenbleiben, Losfahren, Warnhinweise – erleichtern Menschen das Turn-Taking, also das Wechseln zwischen Sprechen und Zuhören, und verhindern, dass sich Gesprächspartner ins Wort fallen.

Erfolgreiche KI muss ähnlich „Verkehrszeichen“ erkennen und senden: durch Stimmveränderungen, visuelle Hinweise am Display oder durch Soundeffekte soll der Nutzer jederzeit wissen, wann die künstliche Intelligenz zuhört, verarbeitet oder bereit zur Antwort ist. Ebenso sollte der Bot Rücksicht nehmen, wenn der Nutzer noch spricht, und gegebenenfalls höflich signalisieren, dass er wartet oder unterbricht, wenn es angebracht ist. Ein weiterer elementarer Aspekt menschlicher Kommunikation ist die Handhabung von Missverständnissen. Menschen sind Meister des „Reparierens“ von Gesprächen. Sobald etwas unklar oder missverständlich ist, wird nachgefragt, paraphrasiert oder umformuliert, damit die Kommunikation weiterfließen kann.

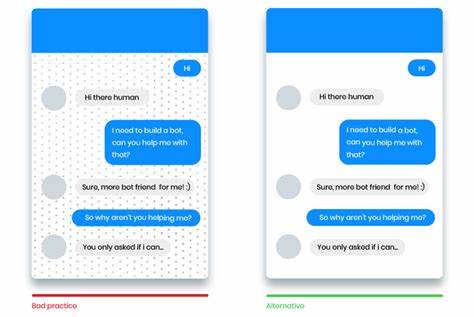

Dieses Prinzip des Repair, wie es in der Linguistik genannt wird, wird leider von vielen Bots kaum oder gar nicht umgesetzt. Häufig reagieren sie mit lapidaren „Ich habe Sie nicht verstanden“ oder schweigen komplett, was die Kommunikation abrupt beendet und die Nutzererfahrung massiv verschlechtert. Ein menschlicher wirkender Bot muss hingegen in solchen Situationen freundlich und unaufdringlich klären, etwa durch Nachfragen wie „Haben Sie das so gemeint?“ oder „Könnten Sie das bitte wiederholen?“ und dabei stets eine positive Gesprächsatmosphäre wahren. Dieses wohlwollende „Huh?“, wie es Linguisten bezeichnen, ist universell und signalisiert, dass Missverständnisse menschlich und reparierbar sind. Darüber hinaus sollten Bots flexibel sein, wenn Nutzer ihre Angaben im Verlauf korrigieren oder ändern, ohne dass der Dialog ins Stocken gerät.

Gesprächskontexte müssen sich dynamisch anpassen lassen, damit die Interaktion flüssig, agil und möglichst natürlich bleibt. Es ist wichtig, dass Entwickler bei der Gestaltung ihrer Systeme auch die kulturellen Unterschiede mitbedenken und individuell anpassbare Einstellungen ermöglichen. Denn nicht jede Kultur schätzt das gleiche Maß an Gesprächspausen, Höflichkeitsformen oder Unterbrechungen. Ein in Deutschland entworfener Bot mag deutlich andere Timingregeln brauchen als einer, der für den asiatischen Markt gedacht ist. Die Gestaltung von Schnittstellen, die neben Text vor allem auf gesprochene Sprache, Mimik und Körpersprache eingehen, steht ebenfalls noch am Anfang.

Zukünftige Interfaces könnten Kamera-gestützte Systeme integrieren, die Gefühle, Blickrichtungen oder Gesten erfassen und darauf reagieren. Dadurch wird der Dialog noch vielschichtiger und näher an menschlicher Kommunikation. Letztlich ist die Entwicklung wirklich menschlicher Bots kein rein technisches Thema, sondern auch eines der Sprachwissenschaft, Anthropologie und Psychologie. Die Herausforderung besteht darin, jahrzehntelange Forschungen über menschliche Gespräche mit moderner KI-Technologie zu verbinden und so Interfaces zu schaffen, die nicht nur funktionieren, sondern begeistern und Vertrauen aufbauen. Die Zukunft dialogorientierter Schnittstellen wird geprägt sein von der Verschmelzung technischer Präzision mit menschlicher Empathie, von schneller und präziser Reaktion gepaart mit intuitivem Verständnis.

Nur dann können Bots aus der Rolle des kalten Werkzeuges heraustreten und zu echten Gesprächspartnern werden, die Nutzer wirklich schätzen. Die Reise dahin ist noch lang, doch sie beginnt mit dem sorgfältigen Studium der unsichtbaren Regeln, die jeden menschlichen Dialog lebendig machen – und dem mutigen Versuch, sie kunstvoll in digitale Systeme zu gießen.