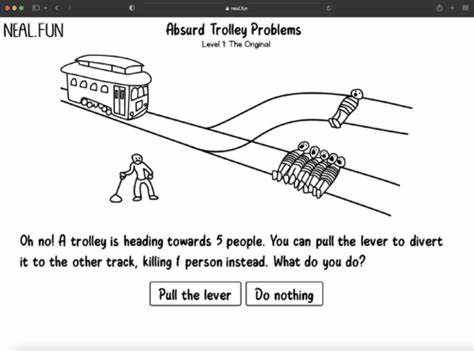

Das Thema Künstliche Intelligenz (KI) und ihre Fähigkeit, moralische Entscheidungen zu treffen, gewinnt zunehmend an Bedeutung. Insbesondere die sogenannten Trolley-Probleme – ethische Dilemmata, bei denen es darum geht, Entscheidungen in Situationen zu treffen, in denen Menschenleben auf dem Spiel stehen – bieten eine faszinierende Plattform, um die Leistungsfähigkeit und Grenzen moderner KI-Modelle zu erforschen. Die Entwicklung dieser Modelle zeigt, wie KI-Systeme heute nicht nur einfache Szenarien analysieren, sondern zunehmend komplexe und vielschichtige moralische Fragestellungen bewältigen können. Das Trolley-Problem ist ein klassisches Gedankenexperiment, das dazu dient, die Prinzipien ethischer Entscheidungsfindung zu hinterfragen. Es beschreibt eine Situation, in der eine Trolley-Bahn auf ein Gleis zusteuert, auf dem mehrere Personen stehen, die durch das Anhalten oder Umlenken der Bahn gerettet oder geopfert werden können.

Die Frage, ob man bewusst eingreifen darf, um eine größere Anzahl von Menschen zu retten und damit eine andere zu opfern, zwingt zur Abwägung zwischen utilitaristischen und deontologischen Positionen. In den letzten Jahren haben Forscher begonnen, KI-Modelle darauf zu trainieren, solche moralischen Dilemmata zu lösen. Dabei stehen sie vor der Herausforderung, wie viel Kontext die Algorithmen berücksichtigen sollten und welche ethischen Prinzipien ihnen zugrunde liegen. Diese Entwicklung bringt nicht nur technische Hürden mit sich, sondern fordert auch die ethische und philosophische Reflexion darüber, wem die Verantwortung in kritischen Situationen zukommt. Zunächst orientierten sich KI-Anwendungen bei der Lösung von Trolley-Problemen an vereinfachten Modellen, die klare Regeln befolgten, etwa den geringstmöglichen Schaden zu verursachen.

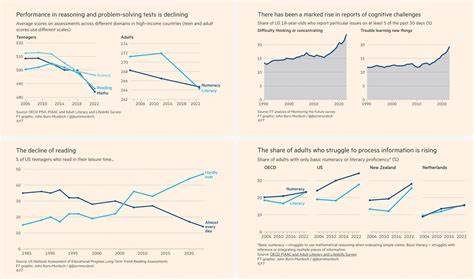

Doch realistische Situationen sind oft komplexer, da verschiedene Werte und Rechte miteinander konkurrieren und nicht alle Konsequenzen vorhersehbar sind. Beispielsweise können Kontextfaktoren wie das Alter der beteiligten Personen, ihre sozialen Rollen oder auch die Wahrscheinlichkeit großer Schäden berücksichtigt werden müssen. Moderne KI-Modelle, insbesondere die auf maschinellem Lernen basierenden Algorithmen, analysieren eine Vielzahl solcher Parameter. Sie lernen aus umfangreichen Datensätzen, die menschliche Entscheidungen in vergleichbaren Situationen widerspiegeln. Durch den Einsatz von künstlichen neuronalen Netzen gelingt es ihnen zunehmend, subtile Zusammenhänge zu erkennen und ethisch vertretbare Alternativen zu generieren.

Ein besonders interessantes Forschungsfeld ist die Integration von moralischer Philosophie und KI. Experten aus beiden Disziplinen arbeiten zusammen, um Modelle zu entwickeln, die nicht nur mathematische Optimierungen ausführen, sondern auch ethische Prinzipien berücksichtigen, wie Gerechtigkeit, Menschenwürde oder Fairness. Diese interdisziplinäre Zusammenarbeit soll gewährleisten, dass die KI in kritischen Situationen verantwortungsvoll entscheidet und gesellschaftliche Werte respektiert. Parallel dazu gewinnen Fragebögen und Studien an Bedeutung, die die Akzeptanz von KI-Entscheidungen in der Bevölkerung untersuchen. Menschen reagieren unterschiedlich auf moralische Entscheidungen von Maschinen, je nachdem, wie transparent die Entscheidungsprozesse dargestellt werden und wie nachvollziehbar die Kriterien erscheinen.

Vertrauen in KI-Technologien ist somit ein wesentlicher Faktor für deren erfolgreiche Implementierung, insbesondere in Bereichen wie autonomes Fahren oder medizinische Diagnostik, wo ethisch sensible Entscheidungen alltäglich sind. Eine weitere Herausforderung bei der Entscheidungsfindung durch KI liegt in der sogenannten moralischen Verantwortung. Während Menschen für ihre Handlungen persönlich haftbar gemacht werden können, stellt sich die Frage, ob und wie eine KI als eigenständiger Entscheidungsträger zur Verantwortung gezogen werden kann. Rechtliche und ethische Rahmenbedingungen müssen daher weiterentwickelt werden, um diese Debatte konstruktiv zu begleiten. Harte ethische Grenzen zu definieren, könnte dazu beitragen, den Einsatz von KI in hochsensiblen Kontexten zu regulieren und Missbrauch oder unvorhersehbare Folgen zu vermeiden.

Künstliche Intelligenz, die sich mit Trolley-Problemen befasst, steht auch symbolisch für den umfassenderen gesellschaftlichen Diskurs über den Einsatz von Technologie. Sie stellt uns vor die Frage, wie wir ethische Werte in einer digitalisierten Welt bewahren können und welche Rolle Maschinen bei der Entscheidungsfindung spielen sollen. Die Herausforderung besteht darin, KI-Systeme zu entwickeln, die nicht nur technisch leistungsfähig, sondern auch menschlich nachvollziehbar und moralisch verantwortbar sind. Der Fortschritt in der KI-Forschung bei der Lösung komplexer ethischer Dilemmata wie dem Trolley-Problem zeigt, dass Maschinen zunehmend in der Lage sind, Entscheidungen zu treffen, die früher allein dem Menschen vorbehalten waren. Dennoch unterstreicht er auch die Bedeutung der menschlichen Kontrolle und den kontinuierlichen Dialog über Werte und Normen.

Nur durch eine enge Zusammenarbeit zwischen Technik, Philosophie, Recht und Gesellschaft kann sichergestellt werden, dass KI nachhaltig und vertrauenswürdig eingesetzt wird. Die Zukunft der KI in ethisch komplexen Situationen wird maßgeblich davon abhängen, wie gut es gelingt, klare Prinzipien und Richtlinien zu etablieren und KI-Systeme darauf auszurichten. Somit ist die Beschäftigung mit Trolley-Problemen mehr als nur ein gedankliches Experiment – es ist ein Schlüssel zur verantwortungsvollen Gestaltung technologischer Innovationen zum Wohle aller.