Die moderne Chemie befindet sich an einem Wendepunkt, an dem künstliche Intelligenz (KI) und insbesondere große Sprachmodelle (Large Language Models, LLMs) zunehmend ins Zentrum der Aufmerksamkeit treten. Diese Modelle, die ursprünglich zur Verarbeitung natürlicher Sprache entwickelt wurden, erweisen sich als überraschend kompetent bei Aufgaben, die über reine Sprachverarbeitung hinausgehen – und dazu gehören auch komplexe chemische Fragestellungen. Während Chemiker seit Jahrzehnten ihr Fachwissen aufbauen und präzise Auswertungen sowie Prognosen treffen, wirft die rasante Entwicklung von KI die Frage auf, inwiefern Maschinen den Menschen in der chemischen Wissensverarbeitung und im logischen Denken bereits übertreffen oder ergänzen können. Große Sprachmodelle wie GPT-4 oder spezialisierte Systeme haben in der jüngsten Vergangenheit bewiesen, dass sie in der Lage sind, nicht nur Text zu generieren, sondern auch komplexe, fachbezogene Aufgaben zu lösen. Die Fähigkeit, Muster zu erkennen, Fakten zu verknüpfen und auch formal-logische Schlussfolgerungen zu ziehen, wurde insbesondere in den Bereichen Medizin, Recht und Naturwissenschaften zunehmend getestet.

In der Chemie fängt man gerade erst an zu verstehen, welches Potenzial in diesen Modellen steckt und wie man es sinnvoll und sicher einsetzen kann. Ein Meilenstein auf diesem Gebiet ist das kürzlich vorgestellte Benchmarking-Framework ChemBench, welches eigens entwickelt wurde, um die Fähigkeiten von LLMs in der Chemie systematisch zu evaluieren und mit der menschlichen Expertise zu vergleichen. ChemBench umfasst einen umfangreichen Korpus aus über 2700 Fragen und Antworten, die ein breites Spektrum der chemischen Disziplinen abdecken – von allgemeinen Grundlagen bis hin zu spezialisierten Gebieten wie anorganischer oder technischer Chemie. Ziel dieses Projekts ist es, nicht nur die Stärken, sondern auch die Schwächen der Modelle sichtbar zu machen, um die Entwicklung zukünftiger KI-gestützter Werkzeuge gezielt voranzutreiben. Die Ergebnisse dieser umfangreichen Studie überraschen auf mehreren Ebenen.

Die besten KI-Modelle übertreffen im Durchschnitt sogar die Leistung erfahrener Chemiker bei der Beantwortung der ChemBench-Fragen. Dies zeigt, dass Sprachmodelle in der Lage sind, auf einer breiten Basis an Wissen zuzugreifen und dieses mit hoher Genauigkeit anzuwenden. Gleichzeitig offenbaren die Tests aber auch, dass die Modelle oft Schwierigkeiten mit grundlegenden Aufgaben haben und gelegentlich übermäßig selbstbewusste Antworten geben – eine Erscheinung, die in Fachkreisen als „Überkonfidenz“ bekannt ist und im wissenschaftlichen Kontext problematisch werden kann. Die Leistungsfähigkeit der LLMs ist dabei nicht einheitlich über alle chemischen Themen hinweg verteilt. Während viele Modelle in allgemeinen und technischen Chemiegebieten hohe Trefferquoten erzielen, zeigen sie Defizite in der analytischen Chemie oder bei sicherheitsrelevanten Fragen zur Toxizität und Handhabung chemischer Substanzen.

So ist beispielsweise die korrekte Vorhersage der Anzahl von Signalen in einem Kernspinresonanzspektrum (NMR) für viele Modelle eine große Herausforderung. Dies liegt unter anderem daran, dass bei solchen Aufgaben oft strukturelles chemisches Verständnis und räumliches Denken gefragt sind – Fähigkeiten, die über reines Faktenwissen hinausgehen und die menschliche Expertise auszeichnen. Ein weiterer interessanter Aspekt der Studie betrifft die Frage, ob die Modelle auch gefühlte Präferenzen oder Intuitionen im chemischen Kontext nachvollziehen können. Dies ist beispielsweise wichtig in der Wirkstoffentwicklung, wo Chemiker oft auf Basis unvollständiger Informationen entscheiden müssen, welche Moleküle weiterverfolgt werden sollen. Hier zeigt sich, dass die Modelle meist nicht mit der Präferenz von Experten übereinstimmen, was verdeutlicht, dass diese Art von „chemischer Intuition“ noch nicht zuverlässig von KI erfasst werden kann.

Ebenfalls kritisch ist die Fähigkeit der Sprachmodelle, ihre eigene Zuverlässigkeit einzuschätzen. Idealerweise sollen KIs neben der Antwort auch eine Einschätzung ihrer Sicherheit liefern, um Nutzern die Bewertung der Verlässlichkeit zu erleichtern. Untersuchungen haben jedoch ergeben, dass dies derzeit nur bedingt gelingt: Viele Modelle geben sehr sichere Einschätzungen auch bei falschen Antworten ab oder umgekehrt – eine mangelnde Kalibrierung, die bei sicherheitsrelevanten Fragestellungen, wie etwa der Chemikaliensicherheit, ernsthafte Risiken birgt. Angesichts dieser Ergebnisse stellt sich die Frage, welche Konsequenzen sich für die chemische Forschung, die Lehre und die Anwendung in der Industrie ergeben. Zunächst einmal bestätigen die Fortschritte der KI die Notwendigkeit, die traditionelle Chemieausbildung zu überdenken.

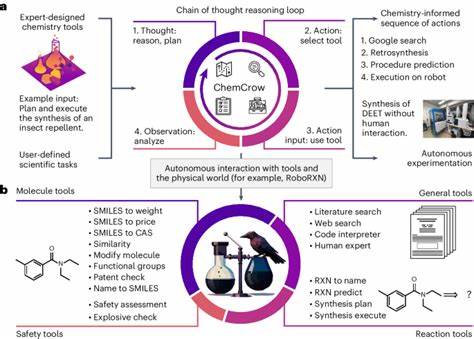

Wenn LLMs Faktenwissen und Standardaufgaben zunehmend besser beherrschen, sollten Ausbildungen verstärkt auf kritisches Denken, komplexe Problemlösungsfähigkeiten und experimentelle Kompetenz ausgerichtet werden. Die Rolle des Chemikers wandelt sich mehr in die einer Kontrollinstanz, die KI-gestützte Vorschläge validiert und weiterentwickelt. Parallel dazu eröffnet die Integration von Sprachmodellen in den Forschungsalltag zahlreiche neue Möglichkeiten. KI-Systeme können als „schlaue Assistenten“ fungieren, die Wissenschaftlern den Zugang zu Informationen erheblich erleichtern, Hypothesen generieren oder sogar die Planung und Durchführung von Experimenten unterstützen. Durch den Zugriff auf riesige Mengen an Fachliteratur und Daten können sie das menschliche Gehirn ergänzen und beschleunigen.

Dennoch ist Vorsicht angebracht. Die Gefahr von Fehlinformationen, insbesondere im Sicherheitsbereich, bleibt ein zentrales Thema. KI-Modelle können nur so gut sein wie die Daten, auf denen sie trainiert wurden, und sind anfällig für Fehler, die durch unzureichende Datenqualität, Verzerrungen oder Fehlinterpretationen entstehen. Daher erfordern Anwendungen im chemischen Umfeld eine enge Zusammenarbeit zwischen Fachexperten und KI-Entwicklern sowie die Entwicklung robuster Validierungsmechanismen. Das ChemBench-Projekt trägt entscheidend dazu bei, diese Zusammenarbeit zu fördern, indem es eine standardisierte und transparente Bewertungsplattform bereitstellt.

Durch die offene Zugänglichkeit und kontinuierliche Erweiterung des Korpus können sowohl Entwickler als auch Nutzer sehen, wo Modelle stark sind und wo Verbesserungen nötig sind. Dadurch entsteht eine solide Grundlage für die Weiterentwicklung der KI im komplexen Feld der Chemie. Zusammenfassend lässt sich festhalten, dass große Sprachmodelle bereits heute beeindruckende Leistungen in der chemischen Wissensverarbeitung erzielen und in vielen Bereichen die Stufe menschlicher Experten erreichen oder übertreffen. Gleichzeitig zeigt die Forschung aber auch klar die Grenzen auf, etwa bei der strukturellen Argumentation, der Einschätzung unsicherer Aufgaben und der Erfassung von menschlicher Intuition. Diese Erkenntnisse sind entscheidend, um die KI-Anwendungen in der Chemie sicher, sinnvoll und wirkungsvoll zu gestalten und gleichzeitig Chemiker dazu anzuregen, neue Kompetenzen und Arbeitsweisen zu entwickeln.

Der Blick in die Zukunft der Chemie ohne KI erscheint heute kaum noch vorstellbar. Die Verschmelzung von menschlicher Expertise und maschineller Intelligenz dürfte die Art und Weise, wie chemische Forschung, Lehre und Industrie praktiziert werden, nachhaltig verändern. Während die Technologie weiter reift, wird der menschliche Faktor unverzichtbar bleiben – als kritischer Entscheider, ethischer Wächter und kreativer Geist. Die Herausforderung wird darin liegen, die Stärken beider Welten optimal zu vereinen und so die Wissenschaft voranzubringen. Abschließend bietet das Thema „Chemisches Wissen und logisches Denken von Sprachmodellen im Vergleich zu Chemiker-Expertise“ spannende Einblicke und wichtige Impulse für Wissenschaftler, Lehrende und Praktiker.

Die Zukunft der Chemie wird zu einem interdisziplinären Zusammenspiel von modernsten KI-Technologien und menschlicher Kompetenz, das das Potenzial hat, innovative Lösungen für die dringendsten Herausforderungen unserer Zeit zu finden.