Die Forschung im Bereich des tiefen Lernens hat in den letzten Jahren einen erheblichen Fortschritt verzeichnet. Immer leistungsfähigere Modelle, getrieben durch die Ausweitung von Datenmengen und Rechenressourcen, haben Anwendungen in nahezu allen Bereichen der künstlichen Intelligenz revolutioniert. Von der Sprachverarbeitung über Bild- und Videoklassifizierung bis hin zur autonomen Steuerung – technische Innovationen scheinen kaum Grenzen gesetzt zu sein. Allerdings stellt sich zunehmend die Frage, ob die beeindruckenden Leistungssteigerungen auch mit einer Verbesserung der internen Repräsentationen der neuronalen Netze einhergehen. Mit anderen Worten: Bedeutet eine bessere Leistung auch, dass das Netzwerk die zugrunde liegenden Aufgaben auf eine sinnvollere, strukturiertere Weise versteht und repräsentiert? Die Annahme, dass dies zwingend so sein muss, wird oft als „repräsentationaler Optimismus“ bezeichnet und bildet die Grundlage vieler aktueller Überlegungen in der KI-Forschung.

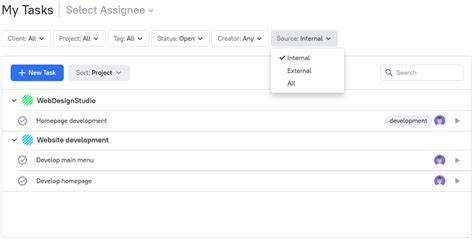

Doch neue Erkenntnisse werfen grundsätzliche Zweifel an dieser optimistischen Perspektive auf. Eine wegweisende Studie mit dem Titel „Questioning Representational Optimism in Deep Learning: The Fractured Entangled Representation Hypothesis“ geht dieser Problematik eingehend nach. Die Autoren Akarsh Kumar, Jeff Clune, Joel Lehman und Kenneth O. Stanley untersuchen den internen Aufbau neuronaler Netze, die die identische Aufgabe erfüllen: die Generierung eines einfachen Bildes. Dieser minimalistische Ansatz erlaubt eine klare Visualisierung der individuellen Funktionen jeder einzelnen versteckten Neuronebene, was normalerweise bei komplexeren Aufgaben mit komplexeren Modellen kaum möglich ist.

Das überraschende Ergebnis zeigt, dass zwei verschiedene Lernmechanismen – die klassische Methode des stochastischen Gradientenabstiegs (SGD) und ein evolutionärer Algorithmus – zum gleichen äußerlichen Verhalten des Netzwerks führen, aber drastisch unterschiedliche interne Repräsentationen hervorbringen. Während bei den SGD-trainierten Netzwerken eine Form von „zerklüfteter, vernetzter Repräsentation“ (Fractured Entangled Representation, FER) auftritt, zeichnen sich die evolutionär erzeugten Netzwerke durch eine wohldefinierte, nahezu einheitliche und faktorisierte interne Struktur aus, die die Autoren als „Unified Factored Representation“ (UFR) bezeichnen. Was bedeutet nun Zerklüftung und Vernetzung in der Repräsentation? Ein Netzwerk mit einer FER wirkt intern chaotisch und unstrukturiert. Trotz korrekter Ausgaben sind die zugrunde liegenden Repräsentationen fragmentiert und stark miteinander verwoben, sodass einzelne Neuronen nicht klar zugeordnet werden können. Das erschwert nicht nur die Interpretierbarkeit, sondern könnte auch die Fähigkeit des Modells beeinträchtigen, zu generalisieren, kreativ zu sein oder neue Aufgaben zu erlernen.

Demgegenüber zeigt die UFR eine wesentlich sauberere interne Organisation. Die Informationen sind klar in einzelne, faktorisierte Teile zerlegt. Neuronen übernehmen präzise Rollen und tragen zu einem strukturierten Gesamtbild bei. Eine solche klare interne Struktur wird oft als wünschenswert angesehen, da sie die Nachvollziehbarkeit und Erweiterbarkeit des Modells verbessert. Die Erkenntnisse werfen somit grundlegende Fragen an die gegenwärtige Praxis des tiefen Lernens auf.

Vor allem in Anbetracht großer, moderner Modelle wie GPT-4 oder Bildgeneratoren zeigen sich bei der reinen Skalierung mit SGD-basierter Optimierung Grenzen. Fortschritte in der Leistung bedeuten nicht automatisch bessere Repräsentationen. Das kann langfristig die Flexibilität und Robustheit solcher Systeme einschränken. Warum aber entsteht bei Standardtrainingsverfahren wie SGD die zerklüftete vernetzte Repräsentation? Einer der Gründe dürfte im Optimierungsverfahren selbst liegen. Der Gradientenabstieg optimiert lokal und ist stark darauf fokussiert, eine Fehlerfunktion zu minimieren.

Dabei wird nicht explizit auf die interne Struktur oder Verständlichkeit der Repräsentation geachtet. Als Folge bauen die Netzwerke ihre internen Strukturen pragmatisch auf – oft mit redundanten, überlappenden und hochgradig entangled Komponenten. Evolutionäre Algorithmen hingegen, die sich eher als offene Suchprozesse verstehen, scheinen von Beginn an dazu zu tendieren, klare, modularisierte Strukturen zu entwickeln. Dies liegt daran, dass sie mit Populationen von Lösungen arbeiten und vielfältige Varianten bewerten. Solche Verfahren fördern eine schrittweise Zusammensetzung von überschaubaren Modulen, die für einzelne subtile Aufgaben verantwortlich sind.

Dies erzeugt eine faktorisierte interne Repräsentation, die besser zu verstehen und weiterzuentwickeln ist. Die Implikationen gehen über theoretische Fragestellungen hinaus und berühren praktische Herausforderungen wie das lebenslange Lernen, die Fähigkeit eines Systems, auch nach Ende der ursprünglichen Trainingsphase kontinuierlich zu lernen und sich anzupassen. Zerklüftete Repräsentationen könnten hier hinderlich sein, weil sie das Einfügen neuer Informationen erschweren und zu katastrophalem Vergessen führen. Klare, modulare Repräsentationen hingegen würden eine stabilere und nachhaltigere Wissensbasis schaffen. Auch für kreative Anwendungen könnte das Verständnis und die Verbesserung interner Repräsentationen von grossem Vorteil sein.

Kreativität erfordert häufig die Kombination heterogener Konzepte auf neue Art und Weise. Modelle mit durchdachten, faktoriellen Repräsentationen können flexibler neue Verknüpfungen schaffen, während unstrukturierte Repräsentationen hier möglicherweise an ihre Grenzen stoßen. Ein weiterer Aspekt betrifft die Interpretierbarkeit und das Vertrauen in KI-Modelle. In sicherheitsrelevanten Bereichen wie Medizin, Recht oder autonomem Fahren sind nachvollziehbare Entscheidungen von höchster Bedeutung. Solide interne Darstellungen sind ein Schritt in die Richtung, Modelle transparenter und ihre Entscheidungen nachvollziehbarer zu machen – eine Forderung, die von zahlreichen Forschungseinrichtungen und Nutzern gleichermaßen unterstützt wird.

Die Analyse der zerklüfteten, vernetzten Repräsentation ist somit weit mehr als ein akademisches Thema. Sie kann zentrale Anregungen für die Zukunft der KI-Forschung liefern, indem sie deutlich macht, dass ein reines Hochskalieren von Daten und Parametern nicht zwangsläufig zu besserem Verständnis im Modell führt. Innovative Ansätze, die modularisierte, faktorisierte und klare interne Repräsentationen fördern, könnten der Schlüssel sein, um nachhaltige, anpassungsfähige und vertrauenswürdige KI-Systeme zu schaffen. Zusammenfassend lässt sich sagen, dass der Bereich des tiefen Lernens vor einer wesentlichen Herausforderung steht. Die Annahme, dass Leistungssteigerungen automatisch bessere interne Repräsentationen bedeuten, wird zunehmend hinterfragt.

Stattdessen offenbart das Konzept der zerklüfteten, vernetzten Repräsentationen die Grenzen herkömmlicher Trainingsmethoden und zeigt auf, dass neue, offenere und modularere Lernparadigmen erforderlich sind. Die Zukunft der KI hängt möglicherweise nicht nur von mehr Daten oder Rechenpower ab, sondern auch davon, wie wir das Innenleben neuronaler Netze verstehen und steuern können. Forscher, Entwickler und Unternehmen sollten diese Erkenntnisse ernst nehmen und vermehrt nach Methoden suchen, die sowohl die Performanz als auch die Qualität interner Repräsentationen verbessern. Dadurch könnte ein neues Zeitalter der KI eingeläutet werden, das nicht nur von beeindruckenden Ergebnissen, sondern auch von tieferem Verständnis und höherer Anpassungsfähigkeit geprägt ist.