Die Wahl der richtigen Datenbanktechnologie ist für moderne Unternehmen eine kritische Entscheidung, die die Skalierbarkeit, Leistungsfähigkeit und Kostenstruktur maßgeblich beeinflusst. In den letzten Jahren haben viele Firmen mit verteilten Datenbanksystemen wie CockroachDB experimentiert, die mit ihren Vorteilen im Bereich der horizontalen Skalierung und Mehrregionen-Support punkteten. Doch Erfahrung zeigt, dass steigende Nutzung, Kosten und operative Herausforderungen oft den Grundstein für eine Neuausrichtung legen – der Umstieg auf eine bewährte, reine relationale Datenbank wie PostgreSQL ist dabei eine attraktive Alternative. Ein Unternehmen, das seit Anfang 2022 CockroachDB nutzte, stand vor genau dieser Entscheidung, als die wachsende Nutzungsintensität und steigende Kosten zunehmend die Betriebseffizienz beeinträchtigten. Obwohl die Vorteile von CockroachDB, insbesondere die einfache horizontale Skalierung und der SQL-kompatible Zugang, anfangs verlockend waren, ergab sich mit zunehmendem Datenvolumen ein deutlich erhöhter Kostenaufwand.

Im Jahr 2024 hatte sich die Rechnung für die Nutzung von CockroachDB auf das Fünffache erhöht und erreichte mittlere sechsstellige Beträge. Gleichzeitig hatten sich noch keine Anforderungen an Datenlokalisierung in mehreren Regionen ergeben, sodass der komplexe Aufbau einer verteilten Architektur nicht mehr gerechtfertigt war. Technisch stellte sich heraus, dass die Anwendungsschicht durch den Einsatz eines Object-Relational Mapping (ORM) Frameworks, in diesem Fall Prisma, die Implementierung und Übersetzung von Datenbankoperationen erleichterte. Dies ermöglichte auch vergleichende Tests zwischen CockroachDB und PostgreSQL, da migrationsbedingte Anpassungen ohne großen Mehraufwand in beiden Systemen vergleichbar gemacht werden konnten. Die Migration selbst offenbarte erhebliche Unterschiede in der Bearbeitungszeit von Schemaänderungen.

Bei CockroachDB kam es wiederholt zu Ausführungszeitüberschreitungen (Timeouts) während Migrationen. Die Probleme führten dazu, dass Entwickler manuell und sorgfältig Migrationen in der CockroachDB-Konsole durchführen mussten, was den Deploy-Prozess teilweise auf zwei Stunden blockierte. Dagegen zeigte sich PostgreSQL als deutlich schneller: Eine vergleichbare Migration auf einer eingefrorenen Datenbankinstanz wurde hier im Schnitt in zehn Sekunden abgeschlossen. Diese Performanceunterschiede hatten weitere negative Folgen. Die Angst vor der Blockierung oder Sperrung der gesamten Datenbank führte Entwickler dazu, Operationen außerhalb der Datenbank auszuführen, was die Systemintegrität gefährden konnte.

Zudem erschwerten die Probleme mit CockroachDB Aktualisierungen auf neuere Versionen. Das Unternehmen war gezwungen, auf einer inzwischen veralteten Version 22 zu bleiben, was bei Supportanfragen zu verzögerten Reaktionszeiten führte. Auch der Bereich ETL (Extract, Transform, Load) war betroffen. Die Stabilität und Geschwindigkeit der Datenextraktion und -transformation litten unter den gleichen Problemen. Existierende Lösungen für die Replikation aus CockroachDB waren limitiert.

Nur ein Connector von Airbyte existierte im Alpha-Stadium, der zudem einen Speicherleck aufwies. Das führte dazu, dass Datenpipeline-Jobs häufig ausfielen oder stark verlangsamten, was den Betrieb empfindlich störte. Bei der Betrachtung von Abfragegeschwindigkeiten ergaben sich differenzierte Ergebnisse. Einige komplexe Abfragen wurden dank des Optimierers von CockroachDB schneller ausgeführt. Hier lag häufig eine intelligente Aggregation während der Abfrage vor.

Jedoch zeigte sich überwiegen, dass bei realen Geschäftsabfragen der SQL-Code, den Prisma generierte, von CockroachDB weniger effizient verarbeitet wurde. Das führte teilweise zu Full-Table-Scans, die hohe Latenzen verursachten. Im Vergleich dazu arbeitete PostgreSQL in vielen Fällen wesentlich schnörkelloser und schneller. Konkrete Praxisbeispiele zeigten, dass ein typisches Abfragebeispiel bei PostgreSQL bis zu zwanzig Mal schneller verlief als in CockroachDB. Das hatte unmittelbare Vorteile für die User Experience, da schnelle Datenbankantworten für moderne Web- und Mobile-Anwendungen essenziell sind.

Auch das Management von Datenbankindizes stellte sich bei CockroachDB als herausfordernd heraus. Insbesondere die UI zeigte oft an, dass eigentlich genutzte Indizes als unbenutzt klassifiziert wurden, was zu Verwirrung bei Entwicklern führte und ungewollte Indexlöschungen begünstigte. Neben Performanceproblemen waren technische Schwächen auch im Nutzererlebnis sichtbar. Das Abbrechen laufender Anfragen in CockroachDB erforderte aufwändige Konsolen-Interventionen und war fehleranfällig, während PostgreSQL einfache, komfortable Cancel-Optionen über SQL-Clients anbot. Der Support von CockroachDB wirkte unübersichtlich und langsam - mit getrennten Portalen und eintönigen, redundanten Formulareingaben, die in kritischen Situationen viel Zeit kosteten.

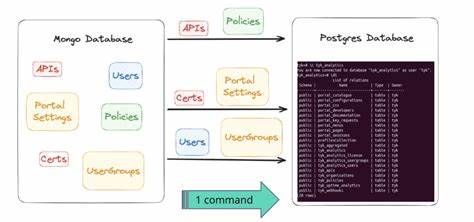

Auch infrastrukturelle Herausforderungen wie wiederkehrende Verbindungsabbrüche durch VPN-Netzwerke (Tailscale) waren ein Schmerzpunkt. Fehler wie "getaddrinfo ENOTFOUND" traten wiederholt auf und beeinträchtigten sowohl lokale als auch CI/CD-Umgebungen. Diese Probleme blieben ungelöst, während der spätere Wechsel zu PostgreSQL diese Netzwerkprobleme verschwinden ließ. Aufgrund des fehlenden robusten ETL-Supports und zunehmend kritischer Performanceprobleme wurde eine eigene ETL-Lösung entwickelt, um die komplette Datenbankmigration zu ermöglichen. Die Implementierung erfolgte mit der neu aufkommenden Runtime Bun, die neben Node.

js und Deno an Popularität gewann. Das Migrationsskript las die Schema-Informationen aus und exportierte die Daten tabellenweise in CSV-Dateien. Anschließend starteten Prozess-Threads, die die CSV-Daten streams einlasen und per INSERT-Befehlen in die neue PostgreSQL-Datenbank speisten. Eine wesentliche Herausforderung lag in der unterschiedlichen Byte-Kodierung von JSON-Arrays zwischen CockroachDB und PostgreSQL, was eine sorgfältige Verarbeitung und Umwandlung der Daten erforderte. Mithilfe angepasster CSV-Parsing-Routinen konnte sichergestellt werden, dass sämtliche Daten kompatibel und vollständig übertragen wurden.

Die finale Migration in der Produktion wurde auf einer leistungsstarken Cloud-VM mit 128 Kernen durchgeführt. Nach Aktivierung des Wartungsmodus und Begrenzung des Zugriffs erwies sich der Prozess als äußerst effizient, mit einer Gesamtdauer von ungefähr 15 Minuten. Auch die Ausfallzeit war mit unter einer Stunde aus betrieblicher Sicht überschaubar und es gab keinerlei Datenverluste. Im direkten Anschluss zeigte die neue PostgreSQL-Datenbank deutliche Verbesserungen. Aggregierte Antwortzeiten aller Anfragen reduzierten sich um circa ein Drittel.

Mithilfe erweiterter Werkzeuge wie PGAnalyze konnten zudem schwach performante Abfragen identifiziert und optimiert werden, was weitere Performancegewinne erlaubte. Zudem waren die eingesparten Betriebskosten erheblich: Das Unternehmen schätzte jährliche Einsparungen von über 110.000 US-Dollar, eine Summe, die mit weiterem Trafficwachstum noch steigen dürfte. Der Weg von CockroachDB zu PostgreSQL illustriert ein generelles Muster, das viele Unternehmen betrifft. Moderne Datenbanktechnologien bieten zwar innovative Features und Skalierungsmöglichkeiten, doch mit komplexen Systemen steigt auch das Risiko versteckter Kosten und Probleme.

Eine ideale Lösung verbindet daher technologische Innovation mit pragmatischer Stabilität, einfacher Wartbarkeit und Wirtschaftlichkeit. PostgreSQL hat sich als robustes, hochperformantes und umfangreich unterstütztes Open-Source-System etabliert, das selbst bei großen Datenmengen und komplexen Abfragen durch sein Ökosystem und seine Tools besticht. Migrationen müssen sorgfältig geplant und technisch versiert umgesetzt werden, doch die Vorteile für die langfristige Betriebssicherheit sind erheblich. Unternehmen, die sich für einen solchen Wechsel entscheiden, profitieren nicht nur von geringeren Betriebskosten, sondern auch von erhöhter Entwicklerproduktivität und einem verbesserten Kundenerlebnis dank schnellerer Reaktionszeiten. Die Erfahrungen aus der Praxis zeigen zudem, dass selbst umfangreiche Datenbanken mit hunderten Millionen Zeilen im Rahmen eines kontrollierten Wartungsfensters migriert werden können, ohne Datenverlust oder umfangreiche Ausfälle.

Insgesamt bietet der Umstieg auf PostgreSQL eine nachhaltige Strategie, um mit wachsenden Datenanforderungen Schritt zu halten, technologische Risiken zu minimieren und die Grundlage für künftige Innovationen zu schaffen. Dabei gilt es, sowohl technische Herausforderungen wie Datenkompatibilität und Performance-Optimierung zu meistern als auch operative Aspekte wie Support und Monitoring zu berücksichtigen. Wer diese komplexen Prozesse meistert, schafft die Basis für eine leistungsfähige und kosteneffiziente Datenbankinfrastruktur, die das Wachstum und die Wettbewerbsfähigkeit des Unternehmens auch in Zukunft unterstützt.