Die Migration von Datenbanken stellt für viele Unternehmen einen entscheidenden Meilenstein dar, insbesondere wenn es um den Wechsel von hochskalierbaren, aber kostspieligen Systemen wie CockroachDB zu bewährten relationalen Datenbanken wie PostgreSQL geht. Die Entscheidung, eine Datenbankplattform zu wechseln, ist oft von mehreren Faktoren geprägt, zu denen Performance, Kosten, Skalierbarkeit, Kompatibilität und Wartbarkeit zählen. Was genau führt Unternehmen dazu, eine Migration zu PostgreSQL durchzuführen, und welche Herausforderungen gilt es dabei zu meistern? Seit Anfang 2022 nutzte das Unternehmen Motion CockroachDB als Hauptdatenbank aufgrund seiner Vorteile wie nahtloser horizontaler Skalierung und hoher Verfügbarkeit. Insbesondere für mandantenfähige Systeme mit Multi-Region-Setups schien CockroachDB die optimale Wahl zu sein. Die Umsetzung der DSGVO machte eine regionale Datenhaltung zu einem zentralen Thema, weshalb eine verteilte Datenbankinfrastruktur zunächst als notwendig erachtet wurde.

Doch während das Unternehmen wuchs, zeigten sich auch die Schattenseiten dieses Ansatzes. Ein Hauptproblem bestand darin, dass der Kostenaufwand durch CockroachDB bis 2024 auf sechsstellige Beträge im mittleren Bereich anstieg. Dabei war der gesamte Aufwand für eine verteilte Datenbank in einer einzelnen Region mit vergleichsweise einfachen Transaktionen nicht gerechtfertigt. Außerdem traten Einschränkungen ins Blickfeld, die den Betrieb erschwerten: Migrationen dauerten unverhältnismäßig lang und führten häufig zu Timeouts, was wiederum zu Arbeit außerhalb der Datenbank führte, um Systemausfälle zu vermeiden. Technisch betrachtet können Migrationen bei CockroachDB problematisch sein, da Tools wie Prisma aufgrund der Datenmengen beim Anwenden von Änderungen oft zeitlich begrenzte Fehler verursachen.

Trotz des modularen Designs und der Möglichkeit manuelles Eingreifen vorzunehmen, blockierten diese Zeitüberschreitungen Deployment-Prozesse über Stunden hinweg. Vergleicht man ähnlichen Vorgang unter PostgreSQL, zeigt sich ein drastischer Unterschied: Migrationen, die auf CockroachDB mehrere Stunden benötigen, laufen auf PostgreSQL in wenigen Sekunden durch. Diese Effizienzsteigerung wirkt sich unmittelbar auf Entwicklungszyklen und die allgemeine Wartungsfähigkeit aus. Auch im Bereich ETL (Extract, Transform, Load) stellte sich heraus, dass CockroachDB weniger gut vorbereitet war. Herkömmliche ETL-Werkzeuge boten kaum Unterstützung für reibungslose Replikation oder Synchronisation.

Die einzige verfügbare Airbyte-Konnektion befand sich im Alpha-Stadium und erwies sich aufgrund eines Speicherlecks als unzuverlässig. Solche Probleme veranlassten das Unternehmen, eine eigens entwickelte ETL-Lösung zu implementieren, um den Datenumzug bewältigen zu können. Die Query Performance zwischen den beiden Datenbanksystemen zeigte sich ambivalent. Einige Abfragen, die auf komplexen Aggregationen basieren, liefen auf CockroachDB schneller dank eines ausgeklügelten Optimizers. Dabei handelte es sich meist um solche, bei denen der Abfrageplaner von CockroachDB aggregierende Operationen clever in die Ausführung einbettete.

Doch diese Vorteile verblassten bei realen, durch Prisma generierten Abfragen, die oft komplexe Joins sowie viele verschachtelte Filter enthielten. Die Regex-artigen SQL-Konstrukte führten dazu, dass CockroachDB häufig teure Full-Table-Scans durchführte, während PostgreSQL den Zugriff dank besserer Indexnutzung und Optimierung deutlich schneller bewältigte. Ein konkretes Beispiel verdeutlicht die Diskrepanz: Eine bei CockroachDB zwanzig Mal langsamere Abfrage auf die TeamTask-Tabelle konnte unter PostgreSQL deutlich beschleunigt werden. Gerade bei umfangreichen Datensätzen mit hundert Millionen Zeilen profitierten Anwendungen von einem schlankeren Abfrageplan stark. Die resultierende niedrigere Latenz trug nicht nur zu besseren Nutzererfahrungen bei, sondern bedeutete auch eine geringere Systembelastung.

Zusätzlich zu technischen Aspekten hatten Entwickler Schwierigkeiten mit Benutzeroberflächen und Support. CockroachDBs Dashboard zeigte irrigerweise genutzte Indizes als unbenutzt an, wodurch Entscheidungen zur Indexoptimierung schwierig wurden. Das Abbrechen von langfristigen Abfragen erwies sich als umständlich, da der verteilte Charakter verlangt, dass alle beteiligten Knoten den Abbruch vollziehen, was nicht immer reibungslos gelang. Zudem war der Supportprozess durch separate Portale und langsame Antwortzeiten geprägt, was in kritischen Situationen zu Verzögerungen führte. Infrastrukturseitig traten Probleme mit Netzwerkverbindungen auf, vor allem bei der Integration in Virtual Private Clouds und beim Einsatz von Tools wie Tailscale.

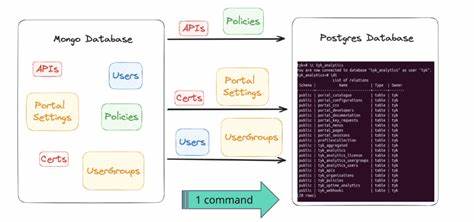

Diese Verzögerungen und Verbindungsverluste konnten nie vollständig eliminiert werden und beeinflussten sowohl Entwicklungs- als auch Produktionsumgebungen negativ. Im Vergleich dazu erwies sich PostgreSQL als stabiler und weniger fehleranfällig in der täglichen Nutzung. Die Migration selbst wurde durch den Einsatz von modernen Technologien wie dem JavaScript Runtime-Environment Bun unterstützt, was einen innovativen Ansatz bei der Datenübertragung darstellte. Die Strategie basierte darauf, die vollständige Datenbank zu exportieren, die Daten in CSV-Streams umzuwandeln und anschließend simultan in den Zielpostgresql-Cluster einzuspeisen. Dabei mussten jedoch Codierungsunterschiede, vor allem bei JSON- und Array-Typen, berücksichtigt und durch maßgeschneiderte Parser gelöst werden, um Konsistenz zu gewährleisten.

Das Ergebnis der Migration war beeindruckend: Die Gesamtzeit lag bei etwa 15 Minuten, die Ausfallzeit unter einer Stunde – ohne Verlust von Daten oder Integrität. Bereits unmittelbar nach Abschluss stiegen die Systemperformance signifikant an, was sich durch eine Reduzierung der Request-Latenzen um etwa ein Drittel manifestierte. Mit Hilfe bewährter Werkzeuge wie PGAnalyze konnten weitere Abfragen optimiert und so zusätzliche Performance-Gewinne realisiert werden. Nicht zuletzt spielte die Kostenersparnis eine zentrale Rolle bei der Entscheidung. Trotz überdimensionierter PostgreSQL-Infrastruktur wurden jährliche Einsparungen von über 110.

000 US-Dollar erzielt. Diese Summe dürfte mit wachsendem Datenvolumen und Nutzerzahlen weiter steigen. Die Erfahrungen zeigen, dass ein Umstieg von einer spezialisierten verteilten Datenbank auf PostgreSQL in bestimmten Szenarien nicht nur technisch machbar ist, sondern auch wirtschaftlich sinnvoll. Unternehmen profitieren von einer stabilen, leichter wartbaren Plattform, besserer Performance in Alltagsanwendungen, intensiver Community-Unterstützung und einem reichhaltigen Ökosystem an Tools für Analyse und Optimierung. Für Entwickler und Systemarchitekten ist es wichtig, die jeweiligen Anforderungen und die tatsächlichen Nutzungsmuster der Datenbank kritisch zu analysieren.

Eine Multi-Region-Architektur ist nicht immer zwingend erforderlich. Ein schlankes, lokal betriebenes PostgreSQL-System kann gerade bei weniger komplexen Workloads und einem Fokus auf Kostenkontrolle oftmals die bessere Wahl darstellen. Die Migration selbst erfordert sorgfältige Planung, insbesondere wenn es um Datenkompatibilität, ETL-Prozesse und Downtime-Management geht. Innovative Ansätze und moderne Technologien helfen dabei, Risiken zu minimieren. Zudem zeigt sich, dass ein erfahrener Einzelentwickler oder ein kleines Team mit der richtigen Herangehensweise eine komplette Migration erfolgreich stemmen kann.

Die Investition in Qualität und Testing zahlt sich durch geringere Betriebsrisiken und mehr Systemstabilität aus. Zusammenfassend lässt sich sagen, dass die Wahl der Datenbankplattform immer individuell im Kontext der Geschäftsanforderungen zu bewerten ist. Der Wechsel zu PostgreSQL hat sich dort bewährt, wo die Kosten für eine verteilte Architektur nicht gerechtfertigt sind und eine solide, performante Lösung mit großer Entwickler-Community gefragt ist. Die gewonnenen Erkenntnisse bieten wertvolle Orientierung für andere Unternehmen, die vor einer ähnlichen Entscheidung stehen und die Balance zwischen Skalierbarkeit, Performance und Wirtschaftlichkeit suchen.