In den letzten Jahren hat die rasante Entwicklung von Künstlicher Intelligenz (KI) und insbesondere von großen Sprachmodellen wie GPT-4 dazu geführt, dass immer mehr Anwendungen entstehen, die Nutzern erlauben, direkt mit KI-Systemen zu kommunizieren. Ob es darum geht, Dokumente zusammenzufassen, komplexe Daten zu analysieren oder Kundenanfragen zu bearbeiten – die Möglichkeiten erscheinen grenzenlos. Doch mit dieser neuen Technologie gehen auch neue Sicherheitsrisiken einher. Eines der größten und bislang oftmals unterschätzten Gefahrenfelder ist die sogenannte Prompt Injection. Dabei handelt es sich um eine Angriffsmethode, die sich mit den Möglichkeiten von LLMs (Large Language Models) auseinandersetzt und schwerwiegende Folgen haben kann.

Die Gefahr dieser Angriffe ist nicht nur real, sondern sie wächst mit der Verbreitung und Komplexität der KI-Systeme sprunghaft an. Prompt Injection wird zunehmend als die neue SQL Injection betrachtet – eine Bedrohung, die ähnlich verheerend und weitverbreitet sein könnte wie die bekannten Schwachstellen aus der Anfangszeit von Webanwendungen. Die Entstehung und Besonderheit von Prompt Injection lassen sich nur verstehen, wenn man die Funktionsweise von Sprachmodellen näher betrachtet. Sprachmodelle arbeiten, indem sie Texteingaben als sogenannten „Prompt“ erhalten und darauf basierend Outputs erzeugen. In der Praxis wird oft ein sogenannter Systemprompt genutzt, um das Verhalten der KI festzulegen, etwa indem sie als höflicher Kundendienstmitarbeiter agiert und sensible Informationen schützt.

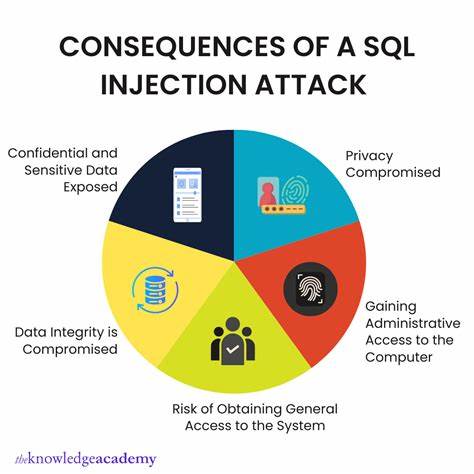

Die eigentliche Eingabe des Nutzers fließt dann in den Prompt ein und beeinflusst das Ergebnis. Genau hier lauert die Gefahr: Wenn ein Angreifer es schafft, bösartigen Code oder manipulierte Anweisungen in dieser Nutzereingabe zu verstecken, kann er die KI „überreden“, schädliche oder unerwartete Aktionen auszuführen. Dies kann von der Weitergabe vertraulicher Daten bis hin zur Veränderung von Systemzuständen reichen. Der Begriff Prompt Injection beschreibt demnach Manipulationen des Nutzereingabe-Prompts, die das Verhalten der Künstlichen Intelligenz unterwandern. Die Parallelen zur berüchtigten SQL Injection sind dabei nicht zufällig.

SQL Injection nutzt Schwachstellen in der Datenbankabfrage, indem Schadcode in Eingaben eingeschleust wird, um die Datenbank zu manipulieren. Ähnlich schlägt Prompt Injection die Tür zu KI-Systemen auf und bewirkt, dass diese ungewollt unerlaubte Befehle ausführen oder Informationen offenlegen. Während SQL Injection auf der Ebene von Datenbanken arbeitet, spielt Prompt Injection auf der Ebene der Sprachverarbeitung und KI-Logik. Der Unterschied macht die Abwehr komplexer, denn LLMs sind grundsätzlich darauf ausgelegt, flexibel und kontextsensitiv zu reagieren – genau das macht sie aber auch anfällig für solche Angriffe. Das Risiko durch Prompt Injection ist nicht nur theoretisch.

Bereits heute existieren dokumentierte Fälle, in denen Angreifer eine KI dazu gebracht haben, vertrauliche Informationen preiszugeben oder Sicherheitskontrollen zu umgehen. In Szenarien wie Chatbots für Kundenservice, automatisierten Beratern oder sogar internen Dokumentenanalyse-Systemen könnte eine erfolgreiche Prompt Injection schwerwiegende Folgen hinsichtlich Datenschutz, Compliance und Geschäftssicherheit haben. Ein zentraler Aspekt bei der Schwachstelle ist, dass viele Entwickler und Unternehmen die Sicherheit ihrer KI-Anwendungen noch nicht ausreichend abdecken. Die Schaffung sicherer Prompts wird oft vernachlässigt, oder es fehlen methodische Tests gegen manipulative Eingaben. Zudem ist die Technologie neu, weshalb viele Best Practices erst in Entstehung begriffen sind.

Dieses Defizit macht es Angreifern leicht, erfolgreich auszunutzen, was wiederum die Notwendigkeit betont, Prompt Injection als entscheidende Herausforderung in der KI-Sicherheit zu adressieren. Die Vielfalt der Angriffsmöglichkeiten ist dabei breit gefächert. Angreifer können versuchen, den KI-Assistenten dazu zu bringen, unautorisierte Auskünfte zu geben, Schadcode zu generieren, unerwünschte Befehle auszuführen oder schützenswerte Geschäftslogik zu ignorieren. Die Angriffe können zudem sehr kreativ sein und etwa verschlüsselte oder stark verschleierte Anweisungen enthalten, um Abwehrmechanismen zu umgehen. Gerade die Kombination von Flexibilität und Kontextsensitivität macht es so schwierig, dezidierte Regeln zu formulieren, die jede mögliche Manipulation ausschließen.

Um die Gefahr der Prompt Injection zu mindern, sind verschiedene Maßnahmen auf technischer und organisatorischer Ebene notwendig. Die erste Herausforderung besteht darin, bewährte Verfahren für das Erstellen von sicheren Prompts zu entwickeln. Dazu gehört, die Eingabe des Nutzers vor der Verarbeitung durch die KI rigoros zu überprüfen und zu filtern, etwa durch Whitelisting erlaubter Inhalte oder das Erkennen verdächtiger Muster. Gleichzeitig ist es wichtig, den Systemprompt so zu gestalten, dass er robust gegenüber manipulativen Einflüssen ist und klare Grenzen definiert, die auch bei subversiven Eingaben erhalten bleiben. Darüber hinaus sind Mechanismen zur Nachverfolgung und Protokollierung von KI-Antworten sinnvoll, um mögliche Verstöße zu erkennen und zu analysieren.

Monitoring-Tools können so frühzeitig alarmieren, wenn sich ungewöhnliches Verhalten abzeichnet. Ein weiterer Ansatzpunkt ist der Einsatz von mehrstufigen Sicherheitskontrollen, bei denen etwa besonders sensitive Anfragen oder Ausgaben nochmals durch menschliche Überprüfungen geführt werden. Die Sensibilisierung der Entwickler und Anwender von KI-Systemen ist ebenfalls von großer Bedeutung. Sicherheitsschulungen und Awareness-Programme können helfen, die Risiken von Prompt Injection besser zu verstehen und entsprechende Sicherheitsstandards einzuführen. Der Austausch in der Community über entdeckte Schwachstellen, Angriffsmuster und Schutzkonzepte trägt dazu bei, eine gemeinsame Wissensbasis zu schaffen und die allgemeine Resilienz zu erhöhen.

Ein weiterer wichtiger Aspekt ist die fortschreitende Forschung im Bereich der KI-Sicherheit. Wissenschaftler und Entwickler arbeiten intensiv daran, wirksamere Techniken zur Erkennung und Abwehr von Prompt-Injection-Angriffen zu entwickeln. Dazu gehören beispielsweise KI-gestützte Filter, die Eingaben in Echtzeit analysieren, oder der Entwurf von Sprachmodellen mit eingebauten Sicherheitsmechanismen, die manipulative Versuche frühzeitig erkennen und abwehren. Trotz der Herausforderungen bietet die zunehmende Verbreitung von KI auch Chancen für die Sicherheit. So können fortschrittliche KI-Systeme genutzt werden, um auch andere Bereiche der IT-Sicherheit zu verbessern, Sicherheitsanalysen zu automatisieren und Bedrohungen schneller zu identifizieren.