Die Zusammenarbeit zwischen Mensch und Künstlicher Intelligenz (KI) gewinnt in vielen Bereichen immer mehr an Bedeutung. In einem Zeitalter, in dem KI-Systeme zunehmend komplexe und kritische Entscheidungen unterstützen oder sogar automatisieren, steht die Frage im Vordergrund, wie Mensch und KI effizient und harmonisch zusammenarbeiten können. Die klassische Sichtweise konzentriert sich häufig darauf, KI als Ersatz für menschliches Entscheiden zu sehen. Doch oft ist eine Kombination aus beidem – kooperatives Entscheiden – deutlich sinnvoller und effektiver. Ein aktueller Pionieransatz verfolgt genau dieses Ziel durch eine sogenannte „Sufficient-Statistic“-Methodik, die sich besonders bei Klassifikationsproblemen anwenden lässt.

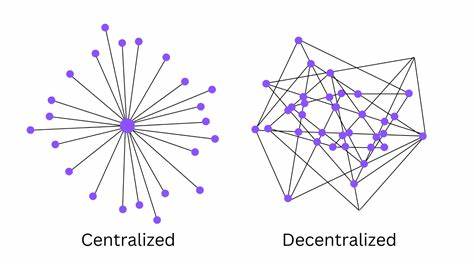

Das zugrundeliegende Konzept und die daraus abgeleiteten Erkenntnisse eröffnen neue Perspektiven für den praktischen Einsatz von KI in Zusammenarbeit mit menschlicher Expertise. Das Herzstück des Ansatzes liegt darin, die Art und Weise abzubilden, wie Menschen auf KI-Vorhersagen reagieren, ohne sich auf ein starr definiertes Modell menschlichen Entscheidungsverhaltens festzulegen. Menschen bringen bei der Bewertung von KI-Ergebnissen oft administrative Verzerrungen mit – beispielsweise eine Über- oder Unterschätzung der Zuverlässigkeit der KI, oder auch eine Tendenz, sich auf das eigene Urteil zu verlassen, selbst wenn die KI detailliertere Informationen liefert. Darüber hinaus kann die Präsenz von KI dazu führen, dass Menschen weniger eigenen Aufwand betreiben, eine Dynamik, die als „Effort Crowd-Out“ definiert wird. Der neue Ansatz integriert diese häufigen Verhaltensweisen, indem er die Interaktion anhand ausreichender Statistiken modelliert, also Schlüsselinformationen, die alle relevanten Daten zusammenfassen und ausreichen, um Entscheidungen zu treffen, ohne komplexe Modelle der internen Denkvorgänge zu brauchen.

Ein zentrales Experiment, das im Rahmen dieses Forschungsansatzes durchgeführt wurde, konzentrierte sich auf den Bereich der Faktenprüfung. Hier wurden Probanden mit KI-gestützten Vorhersagen konfrontiert, die sie in ihren Klassifikationsentscheidungen unterstützen sollten. Die Ergebnisse zeigten, dass Menschen die KI-Vorhersagen oft unterschätzen – sie reagieren zu wenig auf die Vorhersagen der KI, insbesondere wenn diese mit großer Sicherheit auftritt. Interessanterweise liegt dieses Verhalten nicht primär daran, dass Menschen der KI misstrauen, sondern eher an ihrer eigenen übersteigerten Zuversicht in die Qualität ihres eigenen Urteils. Das bedeutet, dass trotz transparentem Zugang zu KI-Ergebnissen die menschlichen Entscheider eine Art Selbstüberschätzung an den Tag legen.

Darüber hinaus ergab sich, dass die Aufwandsbereitschaft der Menschen sinkt, wenn die KI mit hoher Sicherheit einen Vorschlag macht. Dieses Phänomen der Aufwandseinsparung ist problematisch, da es die Leistung des Gesamtsystems beeinträchtigen kann, wenn die menschliche Komponente nicht mehr voll engagiert ist. Daraus leitet sich die Notwendigkeit ab, den optimalen Grad an Automatisierung sorgfältig abzuwägen. Die Forschung zeigt, dass es besonders sinnvoll ist, die Fälle, bei denen die KI mit großer Zuverlässigkeit vorhersagt, vollständig automatisiert zu bearbeiten. Unsichere oder komplizierte Fälle hingegen sollten den Menschen vorbehalten bleiben, allerdings mit voller Offenlegung der KI-Ergebnisse, um die bestmögliche Kooperation zu ermöglichen.

Dieser differenzierte Ansatz hat weitreichende Auswirkungen für Unternehmen und Organisationen, die Künstliche Intelligenz in ihre Entscheidungsprozesse integrieren wollen. Anstatt die Technologie lediglich als Unterstützung oder als vollständigen Ersatz des Menschen zu verwenden, bietet sich eine hybride Struktur an, die den Nutzen beider Welten maximiert. Dabei ist besonders die Transparenz entscheidend: Die Offenlegung der KI-Prognosen gegenüber den menschlichen Entscheidern muss stets gewährleistet sein, um eine fundierte Bewertung zu ermöglichen. Die theoretischen Grundlagen dieses Ansatzes basieren auf der Verwendung sogenannter ausreichender Statistiken, die entscheidende Aspekte der Daten zusammenfassen, die für die Entscheidung wichtig sind. Durch die Anwendung dieser Methodik gelingt es, komplizierte Interaktionen zwischen menschlichen Vorurteilen, dem Vertrauen in KI-Systeme und der tatsächlichen Leistung von Vorhersagemodellen ohne komplexe psychologische Modelle abzubilden.

Das macht den Ansatz flexibel und breit anwendbar, gerade auch in realen Umgebungen, wo menschliches Verhalten häufig unerwartet und schwer vorhersagbar ist. Praktisch gesehen ergeben sich aus diesen Erkenntnissen Empfehlungen für die Gestaltung von Schnittstellen und Entscheidungsprozessen in Bereichen wie Online-Faktenprüfung, medizinische Diagnose oder Finanzdienstleistungen. Die Automatisierung sollte stets auf Situationen beschränkt werden, in denen die KI mit hoher Sicherheit agieren kann. In weniger sicheren Fällen müssen Menschen entweder mittels klarer Informationen unterstützt werden oder selbst die Entscheidungsführung übernehmen. Die Herausforderung besteht darin, Unterschwelligkeiten wie menschliche Überzeugungskraft und Anstrengungsbereitschaft zu steuern und in die Systemgestaltung einzubauen.

In der Zukunft eröffnet die Arbeit weitere Forschungsfelder, insbesondere im Hinblick auf die Verbesserung menschlicher Schulung und KI-Transparenz. Zudem kann die Erforschung von Verhaltensmechanismen wie Overconfidence oder AI-Neglect dabei helfen, Werkzeuge zu entwickeln, die das Zusammenspiel noch effektiver machen. Der aktuelle Forschungsstand legt nahe, dass das optimale Zusammenwirken von Mensch und KI nicht durch strikte Automatisierung oder blinde Vertrauen gekennzeichnet ist, sondern durch eine fein abgestimmte, dynamische Kooperation, die beide Stärken berücksichtigt. Zusammenfassend zeigt der ausreichend-statistische Ansatz im Bereich der Mensch-KI-Kollaboration, dass es möglich ist, komplexe Entscheidungen effizienter zu gestalten, indem man sowohl menschliche Tendenzen als auch KI-Kompetenzen in einem flexiblen Rahmen berücksichtigt. Der Fokus auf Automatisierung der sicheren Fälle und menschliche Orientierung bei unsicheren Inhalten fördert die Qualität von Entscheidungen und steigert die Gesamtleistung von Systemen, in denen Mensch und KI Hand in Hand arbeiten.

Es handelt sich dabei um einen vielversprechenden Schritt in Richtung praktikabler und praxisnaher Lösungen für die Herausforderungen der modernen Entscheidungswelt.

![Designing Human-AI Collaboration: A Sufficient-Statistic Approach [pdf]](/images/43BA9116-D1F4-4B9B-BD32-23639373E4F8)