Die fortschreitende Entwicklung künstlicher Intelligenz hat in den letzten Jahren eine beispiellose Menge an digitalen Inhalten hervorgebracht. Insbesondere Large Language Models (LLMs) wie GPT-4 oder Claude 3.5 produzieren täglich Millionen von Artikeln, Geschichten und verschiedensten Textformen. Diese Innovationswelle sorgt zwar für mehr Effizienz und kreative Möglichkeiten, wirft jedoch eine ernste Frage auf: Was passiert, wenn KI künftig zunehmend von Inhalten lernt, die von anderen KI-Systemen erstellt wurden? Dieses Phänomen wird oft als „Ouroboros-Effekt“ bezeichnet, eine Metapher für die sich selbst fressende Schlange, die ihren eigenen Schwanz verzehrt. Im Kontext der KI bedeutet dies, dass generierte Inhalte wieder als Trainingsdaten verwendet werden, was das Risiko birgt, Qualitätsverluste und Verzerrungen in zukünftigen Modellen zu verstärken.

Die Entstehung und Ausweitung von KI-generierten Inhalten hat dazu geführt, dass sich die Quellenvielfalt im Internet verändert. Ursprünglich bildeten menschlich verfasste Texte die Hauptbasis für das Training von Modellen. Doch mit dem exponentiellen Wachstum KI-erzeugter Artikel sinkt der Anteil authentisch menschlicher Beiträge proportional. Dies führt zu einem Verlust an Vielfalt, Originalität und sprachlicher Nuance, die typischerweise menschlichen Autoren eigen sind. Die Modelle könnten sich somit allmählich in einer Filterblase eigener Kreationen verfangen – was zu einer Homogenisierung des Online-Contents führt.

Ein gravierendes Problem ist die potenzielle Verschlechterung der Inhaltsqualität. KI-Modelle, die auf bereits KI-generierten Texten trainiert werden, laufen Gefahr, bestehende Fehler, Ungenauigkeiten und sprachliche Schwächen unkontrolliert weiterzugeben. Dieser Effekt ähnelt dem bekannten Spiel „Stille Post“, in dem Informationen über mehrere Stationen hinweg zunehmend verfälscht werden. Bei wiederholtem Training auf solchen Texten drohen künftige KI-Modelle, sich von qualitativ hochwertigen und verifizierten Informationen zu entfernen und stattdessen Fehler und Verzerrungen zu verstärken. Darüber hinaus führt die mehrfache Verarbeitung von KI-generierten Inhalten zu einer problematischen Verstärkung von Biases.

Jede KI ist in gewisser Weise ein Spiegel ihrer Trainingsdaten und übernimmt vorhandene Voreingenommenheiten. Werden diese Vorurteile immer wieder reproduziert und vergrößert, kann dies zur systematischen Verzerrung von Ausgaben führen. Das kann sich negativ auf die Objektivität und Diversität der Informationen auswirken und soziale sowie ethische Risiken bergen. Ein weiteres Problemfeld ist die Verbreitung von Fehlinformationen. Wenn ein KI-Modell beispielsweise falsche Fakten generiert, werden diese möglicherweise in nachfolgenden Generationen als vermeintlich korrekte Daten betrachtet und weiterverbreitet.

Dies kann einen beschleunigten Kreislauf der Desinformation in Gang setzen, der kaum noch zu stoppen ist. Die Herausforderung, solche Fehler im großen Datenstrom zu erkennen und herauszufiltern, wächst damit parallel zur Menge der Inhalte. Die Unterscheidung zwischen menschlich und KI-generierten Texten wird immer schwieriger. Fortschritte bei der Stil- und Ausdruckssimulation führen dazu, dass KI-Texte kaum noch von menschlichen Arbeiten zu unterscheiden sind. Dies erschwert die Datenkuratierung erheblich, da Trainingsdatensätze zunehmend künstlich durchseucht werden, ohne dass dies eindeutig erkannt wird.

Verfahren wie das Labeln von KI-Inhalten oder automatisierte Erkennungssysteme stoßen hier an ihre Grenzen, besonders bei der gewaltigen Menge an produzierten Daten. Zudem ergibt sich eine paradoxe Situation im Umgang mit Trainingsdaten. Auf der einen Seite wäre der Verzicht auf KI-generierte Inhalte wünschenswert, um die Qualität und Diversität der Modelle zu erhalten. Andererseits spiegeln diese Texte aktuelle Sprach- und Nutzungstrends wider, die für den praktischen Einsatz von KI relevant sind. Modelle, die keine KI-Eingaben in ihren Trainingssets haben, könnten somit veraltet wirken oder neue kommunikative Muster nicht angemessen erfassen.

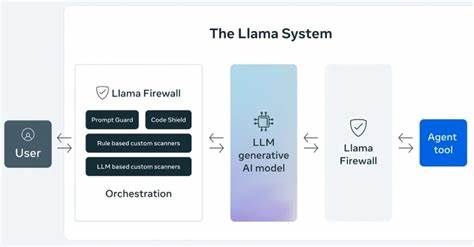

Vor diesem Hintergrund werden neue Ansätze zur Datenaufbereitung und Modellierung benötigt. Qualitätsbewertungssysteme, die Texte nach ihrer Zuverlässigkeit und menschlichen Originalität gewichten, gewinnen an Bedeutung. So könnte sichergestellt werden, dass hochwertige Quellen in den Vordergrund rücken und minderwertige Inhalte oder reine KI-Replikate weniger stark berücksichtigt werden. Die Entwicklung hybrider Datensätze, die eine ausgewogene Mischung aus sorgfältig geprüften, menschlich erstellten und vertrauenswürdigem KI-generierten Content bieten, ist ein weiterer Lösungsweg. Solche Datensätze unterstützen eine ausgewogenere Trainingsgrundlage und bewahren die für KI wichtigen Sprachmuster, ohne dabei in eine endlose Selbstreferenz zu geraten.

Darüber hinaus fördert die transparente Kennzeichnung von KI-generierten Inhalten die Bewusstseinsbildung in der Öffentlichkeit und erleichtert zugleich die Filterung dieser Daten in Trainingsprozessen. So hat beispielsweise Meta Initiativen gestartet, um KI-erschaffene Bilder klar auszuweisen, und ähnliche Strategien könnten zukünftig für Textinhalte Standard werden. Die menschliche Aufsicht bleibt trotz der Automatisierung weiterhin unverzichtbar. Experten müssen verantwortungsvoll die Entwicklung und das Training von KI-Modellen begleiten und als kritische Instanz agieren, die potenzielle Qualitätsprobleme frühzeitig erkennt und adressiert. Letztlich steht die KI-Gemeinschaft vor der Herausforderung, den Ouroboros-Effekt zu brechen oder zumindest abzumildern, bevor sich eine Spirale aus Qualitätsverlust und Informationsverfälschung etabliert.

Die Erforschung besserer Algorithmen für Inhaltsanalyse, die Förderung synthetisch erzeugter, gezielt hoher Datenmengen und die Verbesserung der Datenherkunftskontrollen bilden Schlüsselelemente einer nachhaltigen KI-Zukunft. Die Debatte um den Ouroboros-Effekt verweist auf eine wichtige Erkenntnis: Künstliche Intelligenz darf nicht als isoliertes System betrachtet werden. Sie ist Teil eines größeren Ökosystems aus Informationsproduktion, Verbreitung und Nutzung. Nur durch verantwortungsbewusste Entwicklung, transparente Prozesse und vielfältige menschliche Beteiligung kann sichergestellt werden, dass KI-Modelle langfristig qualitativ hochwertige, verlässliche und vielfältige Inhalte generieren und fördern. Mit dem stetigen Wachstum der KI-basierten Inhalte wachsen auch die Ansprüche an die Forschung und Industrie, dieses komplexe Problemfeld anzugehen.

Die kommenden Jahre werden zeigen, wie effektiv der Trend zur Selbstreferenzierung von KI-Inhalten gebremst werden kann und welche innovativen Lösungen sich im Spannungsfeld von Effizienz und Qualität durchsetzen. Zusammenfassend lässt sich sagen, dass der Ouroboros-Effekt eine bedeutende Herausforderung für die Zukunft der künstlichen Intelligenz darstellt. Er zeigt auf eindrückliche Weise, wie wichtig Qualitätssicherung, Transparenz und kontinuierliche menschliche Kontrolle im Umgang mit generierten Inhalten sind. Nur so kann verhindert werden, dass sich ein Teufelskreis bildet, der die Leistungsfähigkeit und Vertrauenswürdigkeit zukünftiger KI-Modelle gefährdet.