Die rasante Entwicklung der generativen KI und insbesondere der großen Sprachmodelle (LLMs) führt im Bereich der Evaluation zu einem Wandel, der viele überrascht: Statt sich ausschließlich auf rigorose quantitative Benchmarks zu verlassen, setzen Entwickler und Anwender zunehmend auf sogenannte Vibe Checks – eine informelle, intuitiv geprägte Methode zur Einschätzung der Modellqualität. Diese Art der Evaluierung basiert auf dem subjektiven Gefühl, das ein Modell hinterlässt, seiner Praxis- und Anwendungsfähigkeit sowie darauf, wie gut es im Alltag funktioniert. Dabei ist keineswegs die wissenschaftliche Strenge fehl am Platz, doch im Alltag der KI-Arbeit erweist sich der Vibe Check als praktikable und effizient nutzbare Herangehensweise. Die Idee, dass Intuition, Erfahrungswerte und das einfache „Sich-Gut-Anfühlen“ einer Leistung viel wert sein können, ist nicht neu. Schon lange setzen professionelle Entwickler, auch außerhalb der KI, auf heuristische Tests, die weniger mit Zahlenspielereien als vielmehr mit pragmatischer Einschätzung zu tun haben.

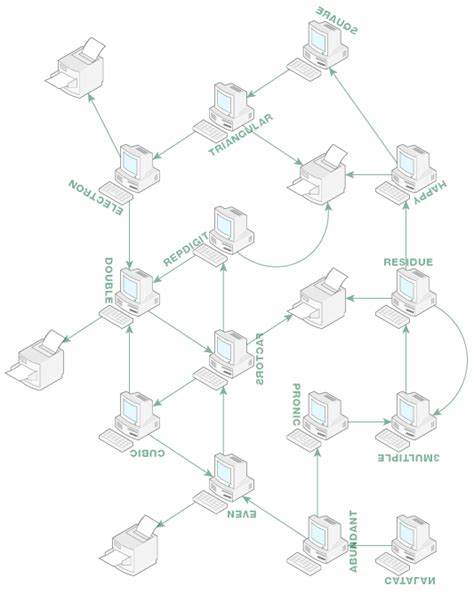

Daniel Olshansky, ein erfahrener Machine-Learning-Experte, beschreibt in seinem Newsletter, dass die überwiegende Mehrheit der KI-Entwickler genau so vorgeht. Die methodischen „goldenen Standards“ existieren zwar und sind wichtig für Forschung, Publikationen und automatisierte Tests. Doch im täglichen Umgang mit Modellen sind es die Vibe Checks, die die erste und oft wichtigste Ebene der Bewertung darstellen. Ein Blick auf andere Bereiche der Machine-Learning-Anwendung verdeutlicht diese Tatsache noch besser. Entwickelte man Anfang der 2010er Jahre bei Twitter Spam-Filter, orientierte man sich daran, ob eine Wortliste „nicht nett“ oder spamhaft wirkte.

Bei Magic Leap wurde bei der Gestaltung von Mixed-Reality-Erfahrungen oft entschieden, ob ein Ergebnis „gut aussah“ und für ein positives Nutzererlebnis sorgte. Selbst bei Waymo, einem Vorreiter im autonomen Fahren, standen lange intuitive Einschätzungen, etwa „sieht sicher aus“, im Vordergrund, bevor rigorose Datenanalysen und formal aussagekräftige KPIs ihre Wichtigkeit erhielten. Die Herausforderung mit modernen großen Sprachmodellen ist jedoch, dass sich viele Nutzerinnen und Nutzer nicht unbedingt mit komplexen Evaluationstechniken auseinandersetzen möchten oder können. Die neuesten KI-Systeme machen es möglich, Machine Learning auf eine Weise einzusetzen, die keine tiefen Kenntnisse in Statistik, Loss-Funktionen oder Hyperparameter-Tuning erfordert. Schon mit einfachem Prompting, ein wenig Kontextaufbau oder begrenztem Finetuning lässt sich ein Ausgangspunkt schaffen.

Vom mehrmaligen Austausch mit dem Modell erhält man eine Gefühl dafür, wie gut es in konkreten praktischen Aufgaben funktioniert. Hier setzen die Vibe Checks an und helfen, die Nützlichkeit jenseits von bloßer Zahlenreihen einzuschätzen. Wichtig ist aber, dass die subjektiven Beurteilungen auch ihre Grenzen haben. Gerade wenn man seine Lieblingsmodelle täglich nutzt, entsteht ein gewisser Gewöhnungseffekt. Man entwickelt wortwörtlich eine Arbeitsbeziehung zum Modell, als wäre es ein Kollege.

Das macht es oft schwer, objektive Vergleiche zwischen verschiedenen LLMs zu ziehen, denn die persönliche Präferenz färbt das Urteil mit ein. Simon Willison, ein Entwickler und Datenexperte, bringt es auf den Punkt: Man braucht eine längere Zeit mit einem Modell, um dessen Stärken und Schwächen wirklich zu verstehen. Das begrenzt letztlich, wie viele Modelle jemand sinnvoll evaluieren kann. Doch auch wenn man sich ab und zu formalisierte Benchmarks und Leaderboards anschaut – etwa chat.lmsys.

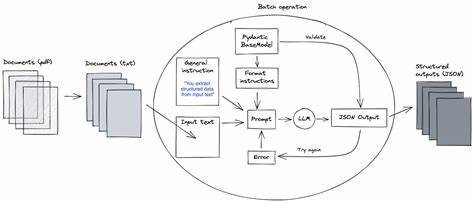

org oder scale.com/leaderboard –, geben diese Listen zwar einen groben Überblick, doch für die tägliche Arbeit sind sie oft zu schwierig, zu wenig individuell relevant oder zu starr. So kann man beispielsweise ein Modell wie Llama 3 zwar offiziell auf Benchmarks vergleichen, doch im individuellen Erlebnis mit einer eigenen Anpassung zeigt sich, ob es die persönliche Anforderungen besser erfüllt als etwa GPT-4. Dieser Faktor der emotionalen und praktischen Passgenauigkeit ist schwer in Zahlen zu fassen, aber umso wichtiger in der praktischen Verwendung. Eine von Andrej Karpathy geteilte Erfahrung unterstreicht das Problem guter Evaluationsmethoden noch einmal deutlich: Das Erstellen von hochwertigen Evaluationen ist extrem zeit- und arbeitsintensiv.

Ein Drittel der Entwicklungszeit floss in Datenaufbereitung, ein weiteres Drittel in die Evaluierung selbst, bevor man überhaupt mit der eigentlichen Entwicklung beginnen konnte. Gute Evaluationen müssen umfassend, repräsentativ und so gestaltet sein, dass sie einen echten Gradienten- oder Lernsignal liefern – also weder zu einfach noch zu schwer sind. Bei der Vielzahl der auftretenden Herausforderungen ist es verständlich, wenn Entwickler und Nutzer alternativ auf eine schnell verfügbare Intuition setzen. Ein weiterer spannender Punkt ist, dass sich viele Befürchtungen, ein Modell könnte sich zu stark an Prüfungsdaten anpassen (Overfitting), bestätigt haben. Das bedeutet, dass sich die Leistungsfähigkeit auf formalen Benchmark-Daten nicht immer auf den Alltag übertragen lässt.

Die eigentliche Qualität zeigt sich oft erst in der subjektiven Nutzung. Gerade bei kreativen Aufgaben oder beim Programmieren kommt es auf Flexibilität, Kontextverständnis und Reaktionsfähigkeit an – Fähigkeiten, die durch bloße Punktzahlen nicht immer ausreichend erfasst werden. Zurück zu den Vibe Checks: Sie ermöglichen es jeder Person, ohne langwierige Evaluationsprozesse und ohne Expertenwissen direkt mit Modellen zu arbeiten und deren Leistung einzuschätzen. In einer Zeit, in der generative KI immer mehr in den Alltag der Softwareentwickler, Content Creator und Unternehmen Einzug hält, ist das ein enorm wichtiger Entwicklungsschritt. Die democratization of AI bedeutet auch die Demokratisierung von Evaluation.

Zwar werden verlässliche mechanische Messgrößen immer eine Rolle spielen, doch die menschliche Intuition behält ebenso ihren Stellenwert. Für Unternehmen und Einzelpersonen ist es daher sinnvoll, sich auf diese Art der Einschätzung einzulassen und ihr Vertrauen zu schenken, zugleich aber offen für neue, bessere, systematisierte Methoden zu bleiben. Wer sich dieser neuen Realität anpasst, profitiert von mehr Flexibilität, schnellerem Feedback und besserer persönlicher Passgenauigkeit in der Auswahl und Nutzung von KI-Modellen. Wie bei zwischenmenschlichen Beziehungen, so ist es auch bei Maschinen: Ein gutes Gefühl, eine abgestimmte Harmonie, ein guter Vibe – das kann oft der wichtigste Indikator sein, ob die Zusammenarbeit gelingt oder nicht. Die Zukunft der KI-Evaluation wird deshalb wohl ein hybrides Modell sein – eine Kombination aus wissenschaftlicher Genauigkeit und menschlichem Gespür.

Die Herausforderung wird darin liegen, die Vorteile beider Welten zu vereinen, ohne den Aufwand unnötig in die Höhe zu treiben. Bis dahin bieten Vibe Checks pragmatische, effektive und zugängliche Lösungen für den Alltag in der KI-Entwicklung und -Anwendung.