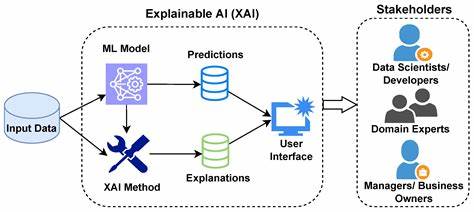

Die rasante Entwicklung der künstlichen Intelligenz stellt Gesetzgeber weltweit vor enorme Herausforderungen. Besonders die Europäische Union versucht, mit dem geplanten EU AI Act (KI-Gesetz) einen klaren Rahmen zu schaffen, der Innovation fördert, aber auch die Risiken kontrolliert. Dabei stößt sie jedoch zunächst auf ein grundsätzlicheres Problem: die Definition von künstlicher Intelligenz selbst. Ohne eine präzise und praktikable Definition fällt es schwer, wirksame Regulierungen zu entwerfen, die sowohl technologische Entwicklungen angemessen abbilden als auch klare Rechtsgrundlagen schaffen. Die EU hat sich entschlossen, diesen Prozess offen und partizipativ zu gestalten, indem sie öffentliche Konsultationen einlädt, um die Definition und die Reichweite von General-Purpose-AI-Modellen zu klären.

Doch was macht die Definition von KI so kompliziert, und warum ist sie so entscheidend für die Regulierung? Die Geschichte zeigt, dass grundlegende Technologien wie Elektrizität ebenfalls einen langen Weg hinter sich haben, bis sie erfolgreich reguliert werden konnten. In den Anfangstagen elektrischer Infrastruktur führte das Fehlen von Standards zu Gefahren wie Bränden und Stromschlägen. Erst die Etablierung verbindlicher Sicherheitsprotokolle und verbindlicher Tests sorgte für Vertrauen und Interoperabilität. Analog könnte die KI-Regulierung davon profitieren, allgemeine Standards und Sicherheitsprüfungen zu etablieren, bevor einzelne Anwendungsfälle bewertet werden. Doch KI ist kein statisches Produkt, sondern ein dynamisches und sich ständig weiterentwickelndes Feld.

Die Komplexität ergibt sich vor allem daraus, dass KI-Modelle extrem vielseitig sein können. Die EU versucht derzeit, sogenannte general-purpose AI Modelle anhand des Trainingsaufwands zu definieren, gemessen in FLOPs (Floating Point Operations). Doch das ist ein pragmatischer, jedoch begrenzter Ansatz. Der reine Fokus auf Trainingscomputationalen Aufwand erfasst nicht unbedingt die Fähigkeiten eines Modells. Kleinere Modelle, die durch Verfahren wie Distillation trainiert wurden, können trotz geringerem Trainingsaufwand breitgefächerte Fähigkeiten zeigen.

Ebenso ist die Definition, welche Modelle überhaupt als general-purpose gelten, derzeit auf Text- und Bildgenerierung beschränkt, was Multi-Modal-Modelle und solche, die Audio oder Video generieren, nicht komplett einschließt. Das wirft die Frage auf, ob die Definition für die modernen, oft multimodalen KI-Systeme erweitert werden muss. Darüber hinaus zeigt aktuelle Forschung, dass Modelle mit ursprünglich enger Zielsetzung, wie etwa Code-Generierung, überraschenderweise über emergente Fähigkeiten verfügen, die allgemeinere KI-Fertigkeiten aufweisen. Das spricht für eine flexiblere, mehrdimensionale Bewertung jedes Modells. Die Idee, einen EU-weiten Benchmark-Test einzuführen, der Modellfähigkeiten, Robustheit und Sicherheitsprofile evaluiert, gewinnt entsprechend an Bedeutung.

Solch ein "EU-Bench" könnte ähnlich funktionieren wie Sicherheitsprüfungen bei elektrischen Geräten – Modelle müssten eine Reihe von Tests bestehen, um sicher und verantwortungsvoll eingesetzt zu werden. Neben der Definition wirft der Entwurf der EU-Richtlinien auch praktische Fragen zur Handhabung von Modell-Veränderungen auf. So würde etwa das Fine-Tuning eines Modells unter bestimmten Bedingungen dazu führen, dass das Ergebnis als neues general-purpose AI Modell anzusehen ist. Dabei ist die Schwelle für den verwendeten Rechenaufwand auf ein Drittel des ursprünglichen Trainingsaufwandes gesetzt. Diese Regelung bringt jedoch Unsicherheiten mit sich, wie der genaue Trainingsaufwand für Fine-Tuning und synthetisch generierte Trainingsdaten zu berechnen ist.

Am Beispiel eines veröffentlichten Modells wurde deutlich, dass die Ermittlung vergleichender FLOPs nicht nur komplex, sondern auch interpretationsbedürftig ist. Ein weiterer Kritikpunkt ist die Definition des „Inverkehrbringens“ von Modellen. Schon das Hochladen auf öffentliche Repositorien könnte demnach als Inverkehrbringen angesehen werden und bestimmte Verpflichtungen auslösen. Dies könnte besonders in der Open-Source-Community zu Bedenken führen, da das Teilen und Experimentieren mit Modellen eine zentrale Rolle für die Entwicklung der KI darstellt. Auch wenn der EU AI Act Ausnahmen für nicht-kommerzielle, offene Modelle vorsieht, verschwinden diese, sollte ein Modell als systemisches Risiko eingestuft werden.

Die derzeitige Unsicherheit und Weite des Begriffs eines solchen Risikos fordert eine differenziertere Herangehensweise, beispielsweise mit abgestuften Einschränkungen je nach Nutzungskontext. Überdies besteht die Regelung, dass Anbieter bereits vor Beginn des Trainings einer risikoreichen KI-Plattform die EU darüber informieren müssen. Der Zweck ist die Nachvollziehbarkeit und frühzeitige Kontrolle großer Ressourcenbindungen. Dennoch könnte eine derartige Vorabmeldepflicht Innovationen und Experimente verlangsamen, da nicht jede geplante Entwicklung letztlich umgesetzt wird. Wesentlicher wäre eine Benachrichtigung zum Zeitpunkt der Markteinführung oder Veröffentlichung, wenn das tatsächliche Risiko besser eingeschätzt werden kann.

Insgesamt bietet die aktuelle Debatte um die Definition und Regulierung der KI einen wertvollen Rahmen, um Prinzipien und Standards anzustoßen, die die Zukunft der Technologie verantwortungsvoll gestalten. Die EU setzt mit dem AI Act einen bedeutenden Schritt, der ohne eigene historische Vorbilder ist. Aus der Vergangenheit lernen bedeutet, dass eine Kombination aus technischen Standards, Risikobewertung anhand mehrerer Parameter und abgestuften Kontrollmechanismen notwendig ist. Nur so können Innovation und Sicherheit im Gleichgewicht bleiben. Ein flexibles und vielseitiges Evaluationssystem, das nicht allein auf Trainingsaufwänden beruht, sondern Einsatzgebiete, Fähigkeiten und potentielle Risiken umfasst, wird essenziell sein.