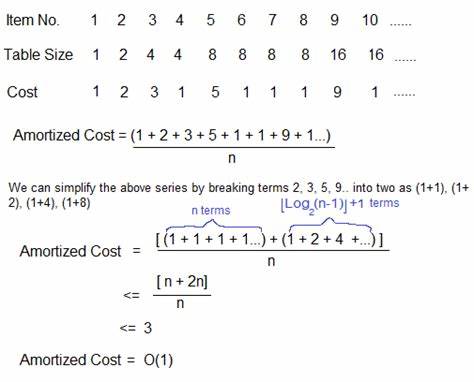

Amortisierte Analyse ist ein grundlegendes Konzept in der Informatik, das sich mit der Bewertung der Gesamtkosten einer Folge von Operationen auf Datenstrukturen beschäftigt. Anders als die Worst-Case-Analyse, die sich auf die Kosten einer einzelnen Operation konzentriert, betrachtet die amortisierte Analyse die Gesamtkosten über viele Operationen hinweg, um den Durchschnittswert pro Operation abzuschätzen. Diese Technik wird vor allem dann relevant, wenn einzelne Operationen hin und wieder teuer sein können, das Gesamtsystem aber als effizient gilt. Ein klassisches Beispiel, das diese Dynamik illustriert, ist die sogenannte "batched queue" – eine spezielle Warteschlange, die auf einer Paarung von Listen basiert und sowohl in der Theorie als auch in der Praxis breit Anwendung findet. Die Warteschlange ist ein grundlegender Datentyp, der Daten nach dem Prinzip First-In-First-Out (FIFO) organisiert.

Er erlaubt das Hinzufügen von Elementen am Ende (enqueue) und das Entfernen von Elementen am Anfang (dequeue). Die einfachste Implementierung dieser Struktur besteht darin, eine einfache Liste zu verwenden, wobei neue Elemente am Ende angehängt und Elemente vom Anfang entfernt werden. Diese Umsetzung ist intuitiv, allerdings problematisch in Bezug auf ihre Laufzeit, da das Anhängen von Elementen an das Ende einer Liste eine Operation mit linearer Komplexität in der Länge der Liste ist. Dies bedeutet, dass bei sehr langen Listen das Hinzufügen eines neuen Elements besonders ineffizient sein kann. Die batched queue stellt eine effizientere Alternative dar, indem sie die Warteschlange als ein Paar von Listen modelliert: einer Eingangs- und einer Ausgangsliste.

Neue Elemente werden an die Eingangsliste angehängt, wobei sie in umgekehrter Reihenfolge gespeichert werden, während die Ausgangsliste für das Entfernen von Elementen verwendet wird. Wenn die Ausgangsliste leer wird, wird die Eingangsliste umgedreht und zur neuen Ausgangsliste, wodurch die Queue-Operationen insgesamt effizienter werden. Die Kosten für das Umdrehen der Liste treten weniger häufig auf, sodass über eine Folge von Operationen hinweg der durchschnittliche Aufwand niedrig bleibt. Um die korrekte Funktionsweise der batched queue sicherzustellen und zu beweisen, ist es sinnvoll, sogenannte Abstraktionsfunktionen zu verwenden. Diese Funktionen übersetzen den konkreten Zustand der Datenstruktur in ein abstraktes semantisches Modell – im Fall der batched queue also zurück in eine einfache Liste, die das Warteschlangen-Element ordnet.

Die Abstraktionsfunktion gewährleistet, dass alle Operationen auf der realen Datenstruktur dem Verhalten der abstrakten Spezifikation entsprechen. Die Verifikation gelingt, indem man zeigt, dass die Abstraktionsfunktion homomorph ist, das heißt, Operationen auf der konkreten Datenstruktur durch Übersetzung gleichbedeutend mit den entsprechenden Operationen auf der abstrakten Darstellung sind. Dieses Verfahren unterstützt nicht nur die Verifikation der funktionalen Korrektheit, sondern eröffnet auch Ansatzpunkte für eine formale Analyse der Kosten. Hier treten Kostenannotationen ins Spiel. Kosten werden in Form von abstrakten Zählerelementen in den Code eingebracht – etwa durch eine Ladungsfunktion, die bei Ausführung Zeichen ausgibt, die als Kosteneinheiten gezählt werden können.

Auf diese Weise wird die abstrakte Laufzeit sichtbar gemacht und zugleich von der eigentlichen Ausführung isoliert. Im Beispiel der batched queue sind die Kosten vor allem in der Umkehrung der Eingangslisten konzentriert, die regelmäßig aber selten auftritt. Die amortisierte Analyse betrachtet diese Verteilung der Kosten über die Gesamtabfolge von Operationen und zeigt, dass, obwohl einzelne Operationen teuer sind, der Durchschnitt über viele Operationen konstant bleibt. Dies wird formal durch die Nutzung von sogenannten Potentialfunktionen beschrieben, die jedem Zustand der Datenstruktur einen "Energiezustand" zuordnen, der die zukünftige Aufwandsbelastung symbolisiert. Beim Übergang von einem Zustand zum nächsten zwingt diese Potentialfunktion die Summe von realer Operation plus Veränderung des Potentials in Übereinstimmung mit den spezifizierten amortisierten Kosten.

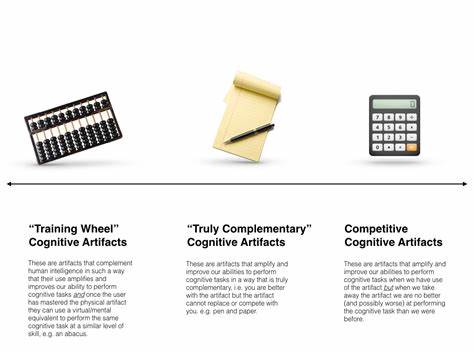

Damit kann man beweisen, dass die Kosten einer Sequenz von Operationen durch einfache Größenschätzungen kontrolliert und vorhergesagt werden können. Ein revolutionärer Gedanke ist es, diese Potentialfunktion als Bestandteil der Abstraktionsfunktion selbst zu betrachten – eine Verschmelzung von Verhalten und Kosten in einer gemeinsamen mathematischen Struktur. Anstatt Kosten nur außerhalb der korrekten Funktionsweise zu betrachten, wird die Abstraktionsfunktion um Kostenaspekte erweitert. So ist die Abstraktionsfunktion nicht mehr nur ein Übersetzer von Zuständen, sondern kann auch als "kostenbewusste Abstraktionsfunktion" verstanden werden. Die Kosten, die bisher separat durch eine Potentialfunktion modelliert wurden, werden unmittelbar beim Übergang abgebildet.

Dies ermöglicht nicht nur eine elegantere und kompaktere Verifikation, sondern auch einen tieferen Einblick in die Komplexität der Datenstruktur. Praktisch wird dies umgesetzt, indem die ursprüngliche Abstraktionsfunktion um entsprechende Ladungsaufrufe erweitert wird, die die aktuellen Potenziale kodieren. Im batched queue Beispiel entspricht dies einem Kostenbetrag, der der Länge der Eingangslisten entspricht. Betrachtet man die Operation enqueue, so erhöht sich die potenzielle "Energie" aufgrund eines weiteren eingehängten Elements, was in der Ladungsfunktion zum Ausdruck kommt. Das dequeue reduziert diese Energie durch Umkehrung der Liste.

Das formale Gleichgewicht zwischen den Ladungsbeiträgen und den tatsächlichen Operationen ist dann ein direkter Ausdruck der amortisierten Kostenanalyse. Dieser Ansatz hat weitreichende Konsequenzen in der formalen Verifikation von Programmen und Datenstrukturen. So wurde bereits gezeigt, dass durch die Kombination von Verhalten und Kosten in einer einzigen Abstraktionsfunktion der Verifikationsaufwand erheblich reduziert werden kann. Dort, wo früher mehrere hundert Zeilen Code für die Kostenauswertung benötigt wurden, genügen in vielen Fällen einige Dutzend Zeilen, was sowohl den Entwicklungsaufwand als auch die Fehlersuche deutlich erleichtert. Zudem ist dieser Ansatz kompatibel mit modernen automatisierten Tools zur Ressourcen- und Kostenanalyse, was ihn besonders attraktiv für den Einsatz in praktischen Projekten macht.

Darüber hinaus ist die Verwendung von amortisierter Analyse als kostenbewusste Abstraktionsfunktion nicht auf einfache Beispiele wie batched queues beschränkt. Die Methodik lässt sich auf komplexere Datenstrukturen, etwa Heaps, Bäume oder Puffermanagementsysteme, übertragen. Auch in Szenarien, in denen die amortisierten Kosten nur als obere Schranke auf die tatsächlichen Kosten dienen, beispielsweise bei Systemen mit „Energieverlust“, kann dieses Konzept angewandt werden. Der allgemeine Rahmen bietet somit eine robuste und flexible Grundlage für moderne Programmverifikation und Ressourcenmanagement. Die Kombination von Potentialfunktionen und Abstraktionsfunktionen stellt in der Praxis einen Paradigmenwechsel dar.

Wo bisher Kostenanalysen und Verifikationen getrennt betrachtet wurden, ermöglichen integrierte kostenbewusste Abstraktionsfunktionen eine holistische Perspektive. Dies ist nicht nur aus akademischer Sicht wichtig, sondern auch für die Entwicklung von Software hochrelevanter denn je, da die Effizienz und Korrektheit von Programmen gerade in ressourcenbeschränkten Systemen und bei großen Datenmengen entscheidend sind. Zusätzlich zu der verbesserten Verifikation und Analyse tragen diese Konzepte zur besseren Verständlichkeit und Wartbarkeit von Code bei. Entwickler können durch die explizite Einbeziehung von Kosten in die Abstraktion nachvollziehen, wie sich einzelne Operationen langfristig auf die Performance auswirken. Dies verbessert das Design von Algorithmen und Datenstrukturen, ermöglicht präzise Vorhersagen und unterstützt die Optimierung direkt im Entwicklungsprozess.

Insgesamt steht die amortisierte Analyse als kostenbewusste Abstraktionsfunktion für eine elegante und effiziente Möglichkeit, das Verhalten und die Kosten von Datenstrukturen formal zu verbinden. Die Methodik ermöglicht nicht nur theoretisch nachvollziehbare Ergebnisse, sondern ist zugleich praxisnah und kompatibel mit bestehenden Werkzeugen und Programmiersprachen. Für Softwareentwickler, Forscher und alle, die sich mit der Implementierung und Verifikation komplexer Datenstrukturen beschäftigen, bietet dieser Ansatz wertvolle Einsichten und Hilfestellungen, die über traditionelle Analysemethoden hinausgehen.

![Tactics and Keyframes: Visualizing Lean 4 Proofs in Blender [video]](/images/6A434198-3379-4CCB-85ED-4B348A85D8D8)

![Bayesian yacht sinking preliminary report [pdf]](/images/A7DAB7EC-1D60-48A2-8FEE-4F9442C407D4)