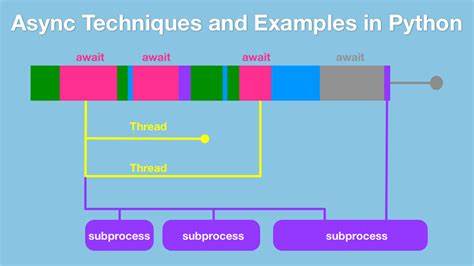

Im Bereich der asynchronen Programmierung hat Python mit dem asyncio-Modul eine wichtige Grundlage geschaffen, um nebenläufige Abläufe effizient und übersichtlich zu gestalten. Doch trotz der Fortschritte, die asyncio und verwandte Werkzeuge bieten, bleiben Herausforderungen in Sachen Skalierbarkeit und Performance vor allem bei massivem gleichzeitigen Warten bestehen. Eine dieser Herausforderungen stellt die gängige asyncio.Event-Klasse dar, die beim Umgang mit zahlreichen Wartenden signifikante Probleme aufweist – sowohl im Hinblick auf den Speicherverbrauch als auch bezüglich der Latenz beim Aufwecken der Warteprozesse. Genau hier setzt das innovatives Konzept von Blazeio.

SharpEvent an und bietet eine Python-Async-Primitive, die sich durch außergewöhnliche Effizienz und Skalierbarkeit auszeichnet und das Potenzial hat, bestehende Muster grundlegend zu verändern. Die Schwachstellen des traditionellen asyncio.Event treten vor allem bei hohem parallelem Warten zutage. Standardmäßig verwaltet asyncio.Event für jeden einzelnen Wartenden ein separates Future-Objekt.

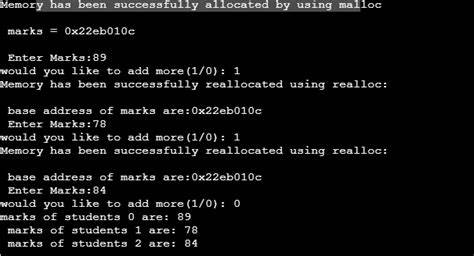

Dies bedeutet, dass bei einer Million gleichzeitiger Wartender der Speicherbedarf alleine nur für diese Futures astronomisch steigt – im Beispiel werden ca. 48 Megabyte allein nur für den Speicher aller Futures verbraucht. Zusätzlich kommt das Problem der Aufwecklatzenz hinzu: asyncio.Event weckt Wartende sequenziell auf und nutzt hierfür mehrere Systemaufrufe, was unter dem Python-GIL (Global Interpreter Lock) zu einer linearen Komplexität in Bezug auf die Anzahl der Wartenden führt. Solche Verzögerungen sind gerade für Echtzeitanwendungen ein großes Hindernis.

Blazeio.SharpEvent revolutioniert diesen Ansatz, indem es eine Lösung konzipiert, die diese zwei Hard-Limits – Speicherverbrauch und Latenz – überwiegend eliminiert. Im Gegensatz zu asyncio.Event verwendet SharpEvent nicht für jeden Würtenden ein eigenes Future, sondern teilt sich einen einzigen gemeinsamen Future für sämtliche Wartenden. Das bedeutet, dass die Speicherbelegung unabhängig von der Anzahl der wartenden Prozesse konstant bleibt.

Mit gerade einmal 48 Bytes für eine Million Wartende stellt SharpEvent somit eine enorme Reduktion des Speicherbedarfs gegenüber dem traditionellen Modell dar. Gleichzeitig gelingt es SharpEvent, alle Wartenden in einem einzigen Schritt zu wecken, wodurch die wakeup-Latenz auf eine konstante Zeit reduziert wird – unabhängig davon, ob tausend oder eine Million Prozesse warten. Diese Leistungsvorteile sind nicht nur theoretisch, sondern auch empirisch messbar. Benchmark-Tests zeigen, dass die Aufweckzeit einer Gruppe von tausend Wartenden bei SharpEvent bei etwa einer Mikrosekunde liegt, während asyncio.Event für dieselbe Anzahl rund eine Millisekunde benötigt.

Bei einer Million Wartenden bricht asyncio.Event sogar zusammen oder stürzt ab, während SharpEvent den Aufweckvorgang immer noch in etwa einer Mikrosekunde realisiert. Ein weiterer Vorteil entsteht daraus, dass SharpEvent komplett in reinem Python implementiert ist, sich aber dennoch schneller als die CPython-eigene C-Implementierung von asyncio.Event zeigt – ein beeindruckendes Ergebnis bezüglich Spracheffizienz und des gewählten Algorithmus. Mit SharpEvent eröffnen sich vielfältige neue Anwendungsfelder vor allem in Szenarien, bei denen hohe Parallelität und Echtzeitverarbeitung essentiell sind.

Anwendungen im Bereich Websockets, Multiplayer-Spiele oder hochfrequenter Handel profitieren besonders von der vorhersehbaren, extrem kurzen Latenz beim Aufwecken der wartenden Tasks. Ebenso profitieren große IoT-Systeme, die mit tausenden bis Millionen gleichzeitiger Verbindungen arbeiten, von der deutlich verbesserten Ressourcenauslastung und der konstanten Skalierbarkeit von SharpEvent. Die verlässliche und schnelle Synchronisation von zahlreichen Prozessen wird auf diese Weise problemlos möglich. Natürlich stellt sich die Frage nach potentiellen Nachteilen oder Einschränkungen. SharpEvent ist weniger geeignet, wenn individuelle Wartezeiten oder die präzise Kontrolle von einzelnen Abbruchbedingungen bei Futures notwendig sind.

In solchen Fällen müsste man eine Wrapper-Lösung implementieren, die individuelle Timeout- oder Abbruchbedingungen für jeden Wartenden ermöglicht. Dennoch sind die meisten Anwendungsfälle, die mit synchronisierten Massen-Warteprozessen arbeiten, genau jene, bei denen eine Bulk-Aufweckung ausreichend und sogar bevorzugt ist. Die Einfachheit von SharpEvent ist zudem bemerkenswert. Durch das Interface, das awaitables wie das wartende asyncio.Event abbildet, ist es ein direkter Drop-in-Ersatz mit minimalem Mehraufwand in der Integration.

Entwickler können ihre bereits vorhandenen Codebasen nahezu unverändert umstellen und profitieren sofort von den Performance- und Skalierungsvorteilen. Das Projekt Blazeio, unter dem SharpEvent entwickelt wurde, steht auf GitHub als Open-Source-Bibliothek zur Verfügung und ratet zur Erprobung und Anpassung in eigenen Projekten an. Die Resonanz auf Entwicklerplattformen wie Hacker News zeigt großes Interesse an der Technologie, und sie stellt einen willkommenen Fortschritt im Python-asynchronen Ökosystem dar. Insgesamt markiert Blazeio.SharpEvent einen Meilenstein für die effiziente asynchrone Programmierung mit Python in großem Maßstab.

Durch die Beseitigung von Speicher- und Latenzengpässen bei Millionen wartender Tasks ermöglicht SharpEvent eine neue Dimension von Echtzeitfähigkeit und Parallelverarbeitung, die bisher nur mit erheblich mehr Aufwand oder gar nicht erreichbar war. Dieses Konzept wird sich aller Voraussicht nach als Standardlösung in anspruchsvollen High-Concurrency-Anwendungen etablieren und kann den Weg für zukünftige Entwicklungen im Async-Bereich ebnen. Für Entwickler, die mit Python und Coroutine-basiertem Concurrency arbeiten, bietet SharpEvent somit nicht nur eine effiziente und skalierbare Synchronisierungsmöglichkeit, sondern auch eine praxisnahe Antwort auf die Herausforderungen, die skalierbare und latenzarme Systeme immer öfter stellen. Ein Blick auf Blazeio lohnt sich für alle, die moderne asynchrone Software schreiben und auf Leistung und Ressourcenschonung bei massenhaften gleichzeitigen Wartenden setzen.