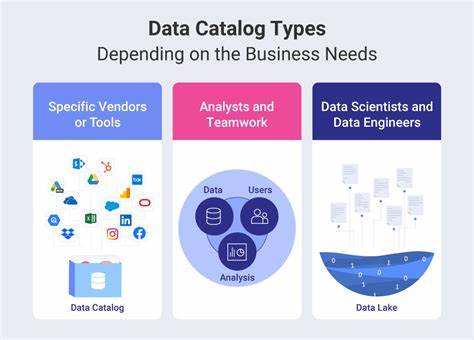

In der heutigen datengetriebenen Welt stehen Unternehmen vor stetig wachsenden Herausforderungen beim Umgang mit großen Datenmengen. Traditionelle Data Lakes sind oft schwerfällig, komplex und leidenschaftslos in puncto Performance und Verwaltung. Genau hier setzt DuckLake an, ein neuartiges und integriertes Data Lake- und Katalogformat, das von den DuckDB-Entwicklern konzipiert wurde, um die Schwächen herkömmlicher Lösungen zu überwinden. Durch die clevere Kombination von Parquet-Dateien als Speicherformat und bewährten SQL-Datenbanksystemen für das Management der Metadaten bietet DuckLake eine einfache, dennoch leistungsfähige Lösung für moderne Data-Warehouse-Anforderungen. DuckLake vereint die Vorteile von Data Lakes mit der Struktur und Zugänglichkeit von Data Warehouses, ohne dabei auf komplizierte Lakehouse-Architekturen zurückgreifen zu müssen.

Zugleich erlaubt es den Anwendern, mithilfe etablierter SQL-Datenbanken wie PostgreSQL, MySQL, SQLite oder auch DuckDB selbst den Katalog zu verwalten. Diese Flexibilität eröffnet vielfältige Einsatzszenarien und erleichtert die Integration in bestehende Infrastrukturen. Ein wesentliches Merkmal von DuckLake ist der Verzicht auf komplexe Verwaltungsgesten herkömmlicher Lakehouse-Formate. Statt starre Hardwareressourcen oder aufwändige Prozesse einzusetzen, nutzt DuckLake die Vorteile leichtgewichtiger Snapshots, um Datenhistorie und Zeitreiseabfragen zu ermöglichen. So können Nutzer neben aktuellen Daten auch frühere Versionen einfach abfragen, ohne jedes Mal große Datenkomponenten neu zusammenführen oder reorganisieren zu müssen.

Die Unterstützung von Schema-Evolution und Partitionierung gewährleistet zudem, dass sich der Data Lake dynamisch an wechselnde Anforderungen anpasst. Das Prinzip von ACID-Transaktionen in DuckLake erlaubt parallelen Zugriff auf die Daten, während gleichzeitig Konsistenz und Integrität über mehrere Tabellen hinweg sichergestellt werden. Diese Eigenschaft ist besonders für Unternehmen relevant, die mit Echtzeitdaten arbeiten oder in kollaborativen Umgebungen agieren. Dank des Einsatzes von Statistiken für Filter-Pushdown gelingt DuckLake sehr effizientes Abfragen großer Datenmengen. Filter werden möglichst früh im Abfrageprozess angewandt, um die zu lesenden Datenmengen gering zu halten und so die Performance zu steigern.

Da DuckLake als offenes und eigenständiges Format vom DuckDB-Team entwickelt wurde, ist es nicht an proprietäre Systeme gebunden. Die Community profitiert von transparenter Entwicklung, umfangreicher Dokumentation und einer lebendigen Diskussionskultur rund um die Weiterentwicklung. DuckDB selbst bietet erste „First-Class“-Unterstützung für DuckLake und stellt eine leichtgewichtige, aber leistungsstarke SQL-Datenbank bereit, die als plattformübergreifendes Extension-Modul verwendet werden kann. Diese Kombination ermöglicht eine einfache Erstellung, Verwaltung und Abfrage von DuckLake-Daten. Die Installation und Integration sind unkompliziert, sodass Anwender schnell produktiv arbeiten können, egal ob sie DuckDB, PostgreSQL, MySQL oder SQLite als Katalogdatenbank einsetzen möchten.

Die klare Trennung von Metadaten-Management und Datenspeicherung in Form von Parquet-Dateien ist ein weiterer Pluspunkt. Parquet ist ein weit verbreitetes, spaltenbasiertes, komprimiertes und optimiertes Dateiformat, das sich ideal für analytische Workloads eignet. So nutzt DuckLake modernste Technologie, um Skalierbarkeit, Flexibilität und Performance bestmöglich zu vereinen. Ein weiterer Vorteil von DuckLake gegenüber vielen anderen Lakehouse-Ansätzen liegt in der Vermeidung aufwändiger Kompaktierungsprozesse. Nutzer können beliebig viele Snapshots anlegen, ohne dass diese zwangsläufig zusammengeführt werden müssen.

Das reduziert Verwaltungsaufwand und Betriebskosten erheblich, was gerade in großen Datenumgebungen ein entscheidender Faktor ist. Neben den technischen Aspekten spielt auch die Philosophie von DuckLake eine wichtige Rolle. Das DuckLake Manifesto unterstreicht die Idee, SQL als universelle Sprache für das Data-Lake-Management zu etablieren. SQL ist seit Jahrzehnten Standard in der Datenanalyse und Datenverwaltung und bietet eine vertraute, ausgereifte Syntax für Entwickler und Analytiker. DuckLake nutzt diesen Vorteil, um die Komplexität von Big-Data-Systemen radikal zu reduzieren.

Auch das Thema Zugänglichkeit wird dabei nicht vernachlässigt. DuckLake unterstützt derzeit als Katalogdatenbanken beliebte und leicht verfügbare Systeme wie PostgreSQL, SQLite und MySQL sowie DuckDB selbst. Diese Vielfalt ermöglicht eine einfache Integration in unterschiedlichste Szenarien – vom einzelnen Entwickler auf dem Laptop bis hin zu großen Enterprise-Umgebungen. Zukunftsweisend ist ebenfalls die Unterstützung von Time-Travel-Funktionalitäten. Unternehmen können somit ihre Daten nicht nur in der aktuellen Version abfragen, sondern zu jedem beliebigen Zeitpunkt zurückgehen und historische Datenzustände analysieren.

Das ist z.B. nützlich für Audits, Compliance-Anforderungen oder die Fehlersuche in Datenpipelines. DuckLake ist zudem auf Performance ausgelegt und profitiert von der aktiven Weiterentwicklung des DuckDB-Projekts. DuckDB ist eine In-Memory-SQL-Datenbank mit Fokus auf analytischen Workloads, die bereits vielfach in der Entwicklung und Produktion bewährt ist.

Durch die enge Verzahnung zwischen DuckLake und DuckDB ergeben sich Synergieeffekte, die nicht nur Geschwindigkeit, sondern auch Usability und Stabilität garantieren. Zusammenfassend zeichnet sich DuckLake durch eine Reihe von Eigenschaften aus, die es zu einer echten Innovation im Bereich Data Lakes und Lakehouse-Formate machen. Es verbindet Einfachheit mit Leistungsfähigkeit, Offenheit mit Professionalität, und stellt einen pragmatischen Ansatz dar, der sowohl Entwickler als auch Unternehmen bei der Datenverwaltung unterstützt. Wer auf der Suche nach einer modernen, SQL-zentrierten Lösung ist, die Erdung in bewährten Technologien findet und zugleich zukunftsfähig sowie flexibel bleibt, sollte DuckLake näher kennenlernen. Das System erlaubt eine individuelle Skalierung, bewahrt vollständige Datenintegrität und bietet alle Features, die ein modernes Data Lake benötigen kann.

Damit erzielt es eine neue Qualität im Datenmanagement und hilft dabei, Big Data effizienter und einfacher handhabbar zu machen. Die Kombination aus offenen Standards, durchdachter Architektur, praktischer Nutzbarkeit und einer starken Community macht DuckLake zu einem vielversprechenden Kandidaten für die nächste Generation von Data-Lake-Lösungen.

![I Hacked Balatro to Get an Impossible Score [video]](/images/532D98E3-1EFF-4CAE-B264-16DFADD7DD5F)