Reaktive Dienste gewinnen in der heutigen, stark vernetzten Welt immer mehr an Bedeutung. Anwendungen, die in Echtzeit auf Eingabeveränderungen reagieren und unmittelbar aktualisierte Datenströme bereitstellen, sind für viele Unternehmen unverzichtbar geworden. Die effiziente Skalierung solcher reaktiven Systeme stellt jedoch eine erhebliche Herausforderung dar, insbesondere wenn die Nutzerzahl sprunghaft ansteigt oder komplexe Datenverarbeitungen zu bewältigen sind. Hier setzt Skip an, eine innovative Technologie, die das Erstellen und Betreiben reaktiver Dienste revolutioniert. Mit der jüngsten Integration von Kubernetes-Funktionalitäten wird das dynamische Skalieren von Skip-Diensten nun noch einfacher und leistungsfähiger.

Skip ist eine Programmiersprache und Plattform, die speziell für reaktive Berechnungen entwickelt wurde. Im Zentrum steht ein hochoptimierter reaktiver Berechnungsgraf, der es ermöglicht, Ausgabeergebnisse effizient und ressourcenschonend zu aktualisieren, sobald sich Eingabewerte ändern. Der Fokus liegt darauf, unnötige Wiederholungen von Berechnungen zu vermeiden und den Systemaufwand zu minimieren. Auf diese Weise können Anwendungen in Echtzeit reagieren, während gleichzeitig Rechenressourcen gespart werden. Doch selbst die beste Technologie stößt an Grenzen, wenn der Traffic extrem wächst, wie zum Beispiel bei viralen Events oder plötzlichen Zugriffsspitzen.

Ein einzelner Server kann oft nicht mehr alle Anforderungen bewältigen, da Speicher, CPU-Leistung und andere Ressourcen an ihre Grenzen geraten. Um solche Szenarien abzufedern, ist es wichtig, den Dienst horizontal zu skalieren, also auf mehrere Maschinen beziehungsweise Instanzen zu verteilen. Genau an dieser Stelle zeigt Skip seine Stärken in Kombination mit einer neuen Leader/Follower-Architektur. Die grundsätzliche Idee dieser Architektur besteht darin, den gemeinsamen Berechnungsgrafen, der für alle Nutzer gilt, auf einen sogenannten Leader zu konzentrieren. Dieser Leader verwaltet alle gemeinsamen Datenstrukturen, Aggregationen und teilweise berechnete Ergebnisse, die unabhängig von individuellen Anfragen stets aktuell gehalten werden.

Die eigentlichen, individuellen Anfragen und damit verbundene Resourcen-Instanzen werden hingegen auf sogenannte Follower verteilt. Diese Follower spiegeln den zugrundeliegenden Zustand vom Leader wider, übernehmen aber die Berechnung spezifischer, nutzerspezifisch zugeschnittener Datenströme und bedienen somit die einzelnen Client-Anforderungen. Diese Aufteilung hat zwei wesentliche Vorteile. Zum einen kann die Last der Ressourceninstanzen proportional zur Anzahl der Nutzer unter mehreren Followern aufgeteilt werden. Das ist vor allem bei hoher Nutzeranzahl entscheidend, denn während der Leader die globale Datenlage pflegt, sorgt eine wachsende Anzahl an Followern dafür, dass eine hohe Zahl an parallelen Anfragen effizient abgearbeitet werden kann.

Zum anderen verhindert diese Architektur, dass der gemeinsame Berechnungsgraf mehr Ressourcen als nötig beansprucht, da er nur einmal vom Leader verwaltet wird. In der Praxis bedeutet das, dass ein Client, beispielsweise Nutzer A, wenn er einen Live-Datenstrom anfragt, durch einen Reverse Proxy automatisch an einen verfügbaren Follower weitergeleitet wird. Dieser Follower baut dann einen reaktiven Berechnungsgrafen auf, der den Nutzerkontext und etwaige spezifische Abfrageparameter integriert, sowie die vom Leader bereitgestellten gemeinsamen Eingaben nutzt. Über diese Vorgehensweise können wesentlich mehr Nutzer mit individuellen Datenströmen versorgt werden, ohne dass es zu signifikanten Verzögerungen oder Engpässen kommt. Für Entwickler und Unternehmen bedeutet das konkret, dass eine reaktive Anwendung mit Skip sowohl robust als auch performant auch bei großen Nutzerzahlen funktioniert und wartbar bleibt.

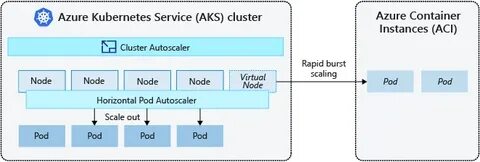

Skip stellt darüber hinaus Beispiele bereit, etwa den bekannten Hackernews-Dienst, der lokal einfach gestartet werden kann und die Möglichkeiten der verteilten Skip-Architektur praxisnah demonstriert. Doch wie sieht es mit dem Betrieb solcher verteilten Dienste in modernen Cloud-Umgebungen aus? Hier kommt Kubernetes ins Spiel. Kubernetes hat sich in der IT-Welt als führende Open-Source-Plattform für das Orchestrieren von Containern etabliert und bietet unter anderem die Möglichkeit, Anwendungen dynamisch hoch- und herunterskalieren zu lassen. Skip wurde durch spezielle Konfigurationen so erweitert, dass es sich nahtlos in Kubernetes-Umgebungen einfügt, was die Skalierung von reaktiven Diensten enorm erleichtert. Mit der neuen Kubernetes-Integration können Skip-Services als StatefulSets betrieben werden.

Jedes dieser StatefulSets besteht aus mehreren Pods mit stabilen Netzwerkidentitäten und unveränderlichen Hostnamen, was in einer verteilten Architektur unerlässlich ist. Wenn ein weiterer Pod als Follower hinzugefügt oder entfernt wird, registriert sich dieser automatisch beim Ingress-Load-Balancer des Clusters. Dieser Load-Balancer stellt sicher, dass eingehende Anfragen stets an die richtigen Skip-Instanzen weitergeleitet werden. Gleichzeitig wird bei einem Skalierungsereignis (etwa wenn die Anzahl der Replikate verändert wird) für einen reibungslosen Übergang ohne Ausfallzeiten gesorgt. Für ein Unternehmen oder Entwicklerteam bedeutet das: Das Skalieren der Anwendung ist so einfach wie das Ausführen eines Befehls wie kubectl scale --replicas=3, um beispielsweise von zwei auf drei Instanzen zu skalieren.

Dabei bleibt die Anwendung durchgängig erreichbar, Clients merken während des Skalierungsvorgangs keine Unterbrechung, und es sind keine Änderungen an der Anwendung selbst notwendig. Die Kombination aus Skip und Kubernetes bringt damit erhebliche Vorteile für die Praxis. Besonders bei Anwendungen mit hohem Traffic-Potenzial können Ressourcen optimal genutzt werden, um Kosten zu sparen und gleichzeitig eine hohe Performance zu gewährleisten. Gleichzeitig bleibt die Komplexität für Entwickler überschaubar, da sie sich auf bewährte Tools und Standards stützen können. Der offene Umgang von SkipLabs mit ihrer Technologie fördert zudem eine breite Nutzung und Weiterentwicklung.

Beispielsweise steht das Hackernews-Beispielprojekt offen zur Verfügung, sodass Interessenten direkt erleben können, wie die verteilte Architektur funktioniert und wie die Skalierung in Kubernetes realisiert wird. Zudem bietet das Unternehmen Support an und ermutigt die Gemeinschaft, Feedback und Wünsche einzubringen, etwa für weitere Framework- oder Tool-Integration. Ein weiterer Pluspunkt liegt in der Architektur selbst: Die Trennung zwischen dem globalen Berechnungsgrafen auf dem Leader und den spezialisierten Ressourceninstanzen auf den Followern macht Skip-Dienste nicht nur skalierbar, sondern auch wartbar und verständlich. Komplexe Systemlogik wird so strukturiert, dass sie mit der Nutzerzahl mitwächst, ohne dass die gesamte Infrastruktur proportional teuer oder kompliziert werden muss. Die Reduzierung unnötiger Berechnungen sorgt außerdem für eine hervorragende Ressourcenauslastung.

Diese Technologie eignet sich besonders für Anwendungsfälle, bei denen Echtzeitdaten wichtig sind – sei es in Social-Media-Plattformen, Finanzinstrumenten, Monitoring-Lösungen oder im Bereich Internet of Things. Die Verknüpfung von Skip mit Kubernetes vereinfacht die Verwaltbarkeit solcher Anwendungen nachhaltig und macht moderne Reaktivität auch für Unternehmen mit dynamischen Skalierungsanforderungen einfach zugänglich. Zusammenfassend bringt die dynamische Skalierung von reaktiven Diensten mit Skip und Kubernetes eine neue Qualität in den Betrieb hochperformanter Echtzeitservices. Die Kombination aus durchdachter Architektur, leistungsfähiger Programmiersprache und modernem Orchestrationswerkzeug bietet Entwicklern und Unternehmen eine zukunftssichere Grundlage, um wachsende Anforderungen zu meistern. Egal, ob der Traffic plötzlich explodiert oder sich wieder beruhigt – der Dienst passt sich flexibel an, ohne dass Ausfallzeiten drohen oder das Nutzungserlebnis leidet.

Für Interessierte lohnt es sich daher, die Skip-Plattform genauer zu betrachten, eigene Prototypen mit den bereitgestellten Beispielen zu bauen und die Kubernetes-Integration im eigenen Umfeld zu testen. Die Möglichkeit, auf eine engagierte Community und Unterstützung durch SkipLabs zurückgreifen zu können, rundet das Angebot ab und verspricht eine spannende Zukunft für das dynamische Skalieren reaktiver Dienste.