Die rasante Entwicklung im Bereich der Künstlichen Intelligenz hat vor allem die Nutzung von großen Sprachmodellen revolutioniert. Mit der steigenden Verbreitung von Llama-Modellen durch Meta und anderen Institutionen rückt die Frage in den Fokus, wie bestehende Prompt-Strategien, die für andere große Sprachmodelle (LLMs) erstellt wurden, nahtlos migriert und für Llama optimiert werden können. Dabei geht es nicht nur um eine reine Übertragung, sondern um eine intelligente Anpassung, um bestmögliche Resultate zu erzielen. Das Werkzeug llama-prompt-ops bietet hierfür innovative Lösungen und definiert damit die Herangehensweise an die Arbeit mit Prompts neu. Bei der Arbeit mit Sprachmodellen ist der Prompt das Herzstück der Interaktion.

Ein gut gestalteter Prompt beeinflusst direkt die Qualität der generierten Antworten. Doch die unterschiedliche Architektur und Funktionsweise der Modelle bedeutet, dass ein Prompt, der bei einem Modell sehr gut funktioniert, bei einem anderen nicht dieselbe Wirkung entfalten muss. Die Herausforderung besteht darin, bestehende Prompts, die beispielsweise für Modelle wie GPT-3 oder andere proprietäre LLMs optimiert wurden, so zu transformieren, dass sie mit Llama-Sprachmodellen ebenso effektiv oder sogar besser arbeiten. llama-prompt-ops setzt genau hier an. Es handelt sich um ein auf Python basierendes Tool, das eine automatische Optimierung von Prompts speziell für Llama-Modelle ermöglicht.

Durch eine datengetriebene Herangehensweise werden bestehende Prompts nicht einfach übernommen, sondern anhand von realen Frage-Antwort-Datensätzen an die Eigenschaften und Stärken von Llama angepasst. Ein wesentliches Merkmal dieses Werkzeugs ist die Möglichkeit, den manuellen Aufwand bei der Optimierung drastisch zu reduzieren. Bisher war die Optimierung häufig ein zeitintensiver Prozess von Trial und Error – verschiedene Versionen von Prompts mussten ausprobiert, getestet und neu angepasst werden. llama-prompt-ops nimmt diese Herausforderung durch automatisierte Analyse und Verbesserung und beschleunigt die Entwicklung erheblich. Die Funktionsweise ist dabei übersichtlich und nutzerfreundlich gestaltet.

Zunächst benötigt man einen vorhandenen System-Prompt, der bisher gut mit anderen Sprachmodellen funktioniert hat. Als Grundlage dient weiterhin ein Datensatz mit echten Beispiel-Query-Response-Paaren, der der Optimierung zugrunde gelegt wird. Zudem wird eine Konfigurationsdatei im YAML-Format erstellt, die Parameter wie Modellhyperparameter und spezifische Optimierungsdetails festlegt. Anschließend erfolgt der eigentliche Migrations- und Optimierungsprozess mittels eines einfachen Befehls. Das Tool verwandelt den ursprünglichen Prompt, orientiert sich bei der Bewertung der neuen Variante an aussagekräftigen und anpassbaren Metriken und liefert am Ende ein optimiertes Prompt mit dokumentierten Leistungsdaten.

Diese Transparenz erlaubt Nutzerinnen und Nutzern einen klaren Vergleich zwischen Original und optimierter Version, so dass sie genau nachvollziehen können, wie sich die Anpassung auf das Ergebnis auswirkt. Besonders spannend sind die erzielten Ergebnisse bei komplexen Aufgabenstellungen. Ein Beispiel hierfür ist der HotpotQA-Benchmark, der für die Evaluierung bei Multi-Hop Reasoning entwickelt wurde – also die Fähigkeit, komplexe Fragen zu beantworten, die Informationen aus mehreren Quellen zusammenführen müssen. In Tests zeigten sich deutliche Verbesserungen bei der Leistungsfähigkeit von Llama-Modellen nach der Optimierung der Prompts mit llama-prompt-ops, was die Wirksamkeit dieses Ansatzes belegt. Neben der technischen Exzellenz überzeugt das Tool auch durch seine praktische Anwendung.

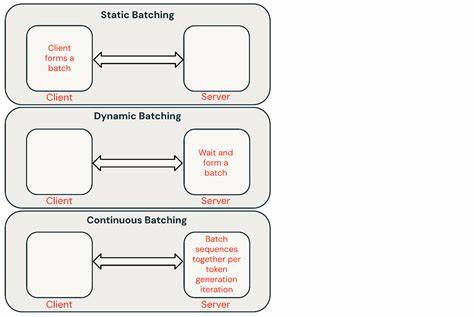

Die Installation und erste Nutzung sind einfach gehalten, sodass auch Anwender ohne tiefe technische Vorkenntnisse schnell starten können. Die Voraussetzungen umfassen das Anlegen eines virtuellen Python-Umgebung, die Installation via PyPI oder direkt aus der Quelle sowie die Erstellung eines Projekts mit Beispielkonfiguration und Datensatz. Zudem unterstützt das Tool verschiedene Provider für die Modellausführung, darunter Cloud-basierte APIs wie OpenRouter sowie lokale Deployment-Optionen wie vLLM und NVIDIA NIMs. Dadurch ist eine flexible Integration in unterschiedlichste Infrastrukturen möglich. Ein weiterer Vorteil liegt in der Möglichkeit zur Anpassung an individuelle Datenformate.

Während ein einfaches Standardformat für Frage-Antwort-Paare genutzt werden kann, besteht auch die Option, eigene Dataset-Adapter zu entwickeln. Dies ermöglicht die optimale Einbindung unterschiedlichster Datenquellen und den feinen Schliff bei der Optimierung. Die Bedeutung der Prompt-Optimierung wächst kontinuierlich, da Sprachmodelle immer vielfältiger eingesetzt werden – von Kundenservice und Textanalyse bis hin zu komplexen Recherchen. Wer bestehende Prompts aus anderen Modellen einfach eins zu eins übernehmen möchte, läuft Gefahr, das Potenzial von Llama nicht voll auszuschöpfen. Die intelligente Migration und Anpassung ist daher eine Schlüsselstrategie, um die Interaktion mit KI-Systemen effizienter, präziser und benutzerfreundlicher zu gestalten.

Neben dem klaren Fokus auf den technischen Nutzen lohnt es sich auch, die soziale und wirtschaftliche Dimension zu betrachten. Durch die beschleunigte Optimierung sparen Unternehmen und Entwickler Zeit und Kosten, die sonst in mühevolle manuelle Anpassungen investiert würden. Gleichzeitig steigt die Zuverlässigkeit der Modelle, was gerade im produktiven Einsatz essenziell ist. Die offene Verfügbarkeit des Tools unter der MIT-Lizenz fördert zudem eine breite Community und kontinuierliche Weiterentwicklung. Durch Mitwirkung von Nutzerinnen und Nutzern entstehen Verbesserungen, die wiederum allen zugutekommen.

Für all jene, die mit LLMs arbeiten und ihre Systeme effizienter gestalten möchten, stellt llama-prompt-ops daher ein wertvolles Hilfsmittel dar. Die Möglichkeit, schnell aus bestehenden Prompts maßgeschneiderte, leistungsstarke Varianten für Llama zu generieren, schafft Freiraum für kreative und produktive KI-Nutzung. Im Kern steht dabei eine datenbasierte, iterative Methodik, bei der konkrete Ergebnisse im Vordergrund stehen – gleichwohl ermöglicht das Tool auch weiterführende Anpassungen, etwa bei den Evaluationsmetriken oder den Hyperparametern. Diese Flexibilität macht es zu einer guten Wahl für Anfänger und Experten gleichermaßen. Zusammenfassend lässt sich sagen, dass die Zukunft der Sprachmodell-Nutzung maßgeblich von effektiver Prompt-Gestaltung abhängt.

Durch moderne Werkzeuge wie llama-prompt-ops wird diese Herausforderung greifbar und lösbar. Der Übergang von anderen LLMs zu Llama kann so reibungslos, zielgerichtet und ergebnisorientiert gestaltet werden. Für Entwickler, Forscher und Anwender sind die daraus resultierenden Effizienzgewinne und die gesteigerte Modellqualität ein echter Fortschritt, der neue Anwendungen und Einsatzfelder eröffnet. Im globalen Wettbewerb um KI-Exzellenz gewinnt die Fähigkeit, Prompts smart zu migrieren und zu optimieren, zunehmend an Bedeutung – wer diese Kompetenzen beherrscht, kann seine Projekte nachhaltig erfolgreicher gestalten und von der Leistungsfähigkeit moderner Sprachmodelle maximal profitieren.