Die rasante Entwicklung künstlicher Intelligenz und maschinellem Lernen hat in den letzten Jahren einen bedeutenden Wandel im Bereich der Sprachmodelle mit sich gebracht. Während große Sprachmodelle zwar beeindruckende Leistungen erzielen, stellen sie oft hohe Anforderungen an Rechenressourcen und eine dauerhafte Internetverbindung. Hier kommen kleine Sprachmodelle ins Spiel, die direkt auf Endgeräten laufen – sogenannte On-Device Small Language Models (SLMs). Diese Modelle sind nicht nur ressourcenschonend, sondern bringen auch bahnbrechende Neuerungen durch Multimodalität, Retrieval-Augmented Generation (RAG) und Funktionsaufrufe mit sich. Diese Kombination verspricht eine neue Ära der KI-Anwendungen, die effizient, privat und vielseitig sind.

\n\nDie Multimodalität ist ein entscheidender Fortschritt, der es kleinen Sprachmodellen erlaubt, verschiedene Arten von Eingaben zu verarbeiten – darunter Text, Bilder, Videos und Audio. Mit solchen Fähigkeiten auf dem Gerät ist es möglich, interaktive Anwendungen zu entwickeln, die weit über reine Textverarbeitung hinausgehen. Beispielsweise können Techniker in abgelegenen Gebieten ohne Internetverbindung ein Foto eines Maschinenteils machen und über Sprach- oder Texteingabe spezifische Fragen dazu stellen. Die Fähigkeit, verschiedene Modalitäten lokal zu interpretieren und zu kombinieren, eröffnet Unternehmen neue Wege, ihre Produkte intelligent und benutzerfreundlich zu gestalten.\n\nEin prominentes Beispiel für diese Technologie ist das Gemma 3n Modell, das in Varianten mit zwei und vier Milliarden Parametern verfügbar ist.

Es ermöglicht native Unterstützung für textliche als auch visuelle und auditive Datenströme direkt auf mobilen Geräten. Trotz der großen Leistungsfähigkeit bleibt die Modellgröße mit knapp über einem Gigabyte überschaubar, was eine breite Einsatzmöglichkeit auf unterschiedlichen Hardwareplattformen unterstützt. Eine der wichtigsten Errungenschaften ist die Optimierung und Quantisierung der Modelle – insbesondere die neue int4-Quantisierung. Diese Technik reduziert die Modellgröße erheblich, ohne dass spürbare Einbußen bei der Qualität auftreten. Die Folge sind reduzierte Latenzzeiten und weniger Speicherverbrauch, was die nahtlose Integration in mobile und Edge-Computing-Anwendungen nachhaltig erleichtert.

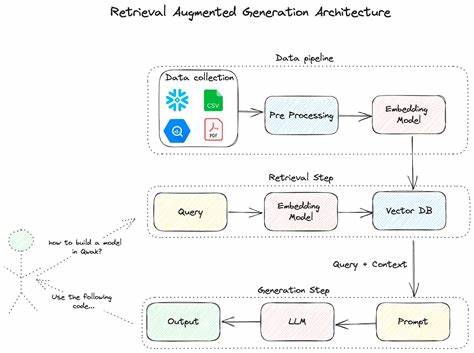

\n\nNeben der Verarbeitungsfähigkeit von multimodalen Daten steht die Kontextualisierung im Fokus moderner KI-Anwendungen. Retrieval-Augmented Generation (RAG) stellt eine Möglichkeit dar, kleine Sprachmodelle mit spezifischem, anwendungsspezifischem Wissen zu erweitern, ohne das Grundmodell aufwendig neu zu trainieren. Stattdessen wird eine separate Datenquelle genutzt, aus der relevante Informationen dynamisch abgerufen und in die Modellantworten integriert werden. Dadurch lassen sich beispielsweise tausende Seiten Text oder eine große Anzahl von Bildern nutzbar machen, um die Generierung von Antworten genauer und kontextbewusster zu gestalten.\n\nDie Integration von RAG direkt auf dem Gerät bedeutet, dass Anwendungen auch ohne Internetzugang personalisierte und fundierte Antworten liefern können.

Die Flexibilität, eigene Datenbanken oder sogar maßgeschneiderte Such- und Abrufprozesse zu implementieren, macht diese Technik besonders attraktiv für Unternehmensanwendungen mit hohen Datenschutzanforderungen. So können etwa medizinische Apps patientenindividuelle Informationen zuverlässig einbinden, ohne die Daten in die Cloud übertragen zu müssen.\n\nVervollständigt wird die neue Generation von auf dem Gerät laufenden Sprachmodellen durch die Einführung von Funktionsaufrufen (Function Calling). Mithilfe spezieller Bibliotheken können Entwickler eigene Funktionen oder API-Endpunkte in ihre Anwendungen integrieren, die vom Sprachmodell autonom erkannt und aufgerufen werden. Dies bedeutet, dass Spracheingaben nicht nur verarbeitet, sondern unmittelbar in Aktionen innerhalb der Anwendung umgesetzt werden können.

\n\nEin anschauliches Beispiel findet sich in medizinischen Anwendungen, bei denen der Nutzer per Sprache beispielsweise Patientendaten oder Symptome mitteilt. Das Sprachmodell extrahiert relevante Informationen, ruft die entsprechenden Funktionen auf und füllt so automatisch Formulare oder Datenfelder aus. Diese Interaktivität fördert eine nahtlose Nutzererfahrung, bei der langwierige manuelle Eingaben entfallen. Die Funktionalität ist jedoch nicht auf reine Formulareingaben beschränkt, sondern lässt sich vielseitig einsetzen – von der Steuerung smarter Geräte bis hin zur komplexen Datenanalyse.\n\nDie Unterstützung von Funktionsaufrufen auf dem Gerät verkürzt zudem die Antwortzeiten und verbessert den Datenschutz signifikant, da keinerlei Daten extern gesendet werden müssen.

In Kombination mit der RAG-Technologie entstehen damit hocheffiziente Systeme, die lokal lernen, abrufen und handeln können. Diese technologische Symbiose ebnet den Weg zu intelligenten Edge-Anwendungen, die besonders für Bereiche mit eingeschränkter Netzabdeckung, hohen Datenschutzanforderungen oder geringer Latenztoleranz geeignet sind.\n\nEntwickler profitieren erheblich von den bereitgestellten Tools, wie etwa Kolaborationsumgebungen zum einfachen Feintuning der Modelle innerhalb von Google Colab oder gut dokumentierten Modelldaten in der LiteRT Hugging Face Community. Dort sind vielfältige Modelle verfügbar, die sich durch wenige Codezeilen auf unterschiedlichsten Endgeräten ausführen lassen. Die zentrale Sammlung und aktive Community fördern Innovation und beschleunigen die Entwicklung neuer Lösungen mit On-Device KI.

\n\nZusätzlich zu den technischen Vorteilen ist die Skalierbarkeit hervorzuheben. Die Modelle sind so konzipiert, dass sie auf verschiedensten mobilen Geräten mit unterschiedlichen Leistungsreserven laufen können. Während das Gemma 3 1B Modell mit seinem kleinen Speicherbedarf auch auf älteren Smartphones problemlos performt, sind leistungsstärkere Varianten wie das Gemma 3n ideal für Unternehmensanwendungen mit umfangreicher Multimodalität. Dies schafft eine breite Basis, auf der Entwickler maßgeschneiderte Anwendungen für verschiedenste Nutzergruppen gestalten können.\n\nDie Möglichkeiten der On-Device SLMs eröffnen nicht nur neue Einsatzfelder in traditionellen Branchen wie dem Gesundheitswesen, der Logistik oder dem Einzelhandel, sondern auch im Bereich smarter Consumer-Produkte.

Sprachgesteuerte Assistenzsysteme werden durch multimodale Eingabefähigkeiten und schnelle, lokale Verarbeitung deutlich intuitiver und zuverlässiger. Die damit verbundene gesteigerte Privatsphäre profitiert Nutzer und Entwickler gleichermaßen.\n\nZukunftsweisend ist zudem die kontinuierliche Weiterentwicklung von Quantisierungsverfahren und Optimierungsalgorithmen, mit denen die Balance zwischen Modellgröße, Geschwindigkeit und Präzision stetig verbessert wird. Die daran anknüpfenden Erweiterungen der RAG- und Function Calling-Bibliotheken versprechen zunehmend vielseitigere und einfach zu integrierende KI-Komponenten. Die Aussicht, diese Technologien bald auch auf weiteren Plattformen jenseits von Android verfügbar zu haben, erweitert den Horizont zusätzlicher Anwendungen enorm.

\n\nFür Unternehmen und Entwickler bedeutet dies eine neue Freiheit, KI-Lösungen direkt am Ort der Anwendung zu betreiben. Das reduziert Abhängigkeiten von Cloud-Infrastrukturen, minimiert Kosten für Datenübertragung und verbessert die Datensicherheit. Zudem können Innovationen schneller und flexibler in marktfähige Produkte umgesetzt werden. Die Kombination aus Multimodalität, Retrieval-Augmented Generation und Funktionsaufrufen bildet somit eine solide Basis für eine neue Generation intelligenter, leistungsfähiger und privater KI-Anwendungen auf mobilen Geräten und Edge-Plattformen.\n\nAbschließend lässt sich festhalten, dass der Fortschritt bei kleinen Sprachmodellen auf dem Gerät gestützte KI in vielerlei Hinsicht revolutioniert.

Sie schafft Voraussetzungen für personalisierte, schnelle und datenschutzfreundliche Anwendungen, die weit über traditionelle Sprachassistenzfunktionen hinausgehen. Die technologischen Innovationen, von der effizienten Modellquantisierung über hybride Wissensverknüpfung mittels RAG bis hin zur nahtlosen Interaktion mit eingebetteten Funktionen, sorgen für eine lebendige und zukunftssichere KI-Landschaft. Entwickler, Unternehmen und Nutzer können somit gleichermaßen von der nächsten Evolutionsstufe der künstlichen Intelligenz profitieren.