Im Mai 2025 sorgte der „Making Our Children Healthy Again“ (MAHA)-Bericht, veröffentlicht vom Weißen Haus unter der Leitung von Gesundheitsminister Robert F. Kennedy Jr., für heftige Kontroversen. Einst als wegweisende und transformative Analyse der Ursachen für die rückläufige Lebenserwartung in den Vereinigten Staaten sowie der chronischen Gesundheitsprobleme von Kindern angepriesen, offenbarten Experten bald gravierende Mängel in der wissenschaftlichen Fundierung des Dokuments. Insbesondere die Nutzung von Künstlicher Intelligenz (KI) bei der Erstellung der wissenschaftlichen Quellenangaben führte zu massiven Fehlern, fehlerhaften Zitationen und sogar erfundenen Studien.

Das warf grundlegende Fragen hinsichtlich der Glaubwürdigkeit des Berichts und der politischen Folgen auf. Der MAHA-Bericht wurde im Auftrag der US-Regierung verfasst und sollte die vielfältigen Faktoren beleuchten, die zur anhaltenden Gesundheitskrise bei Kindern beitragen. Ursachen wie Umweltgifte, schlechte Ernährung und vermehrte Bildschirmzeit wurden als Hauptprobleme identifiziert. Doch die wissenschaftlichen Grundlagen mussten bald mit Argwohn betrachtet werden, nachdem eine Überprüfung durch die Washington Post und andere Medien zahlreiche Dubletten unter den 522 Fußnoten aufdeckte, die sich auf Studien und Berichte bezogen. Zudem wurden viele Referenzen mit falschen Autorenangaben versehen oder waren schlichtweg nicht auffindbar.

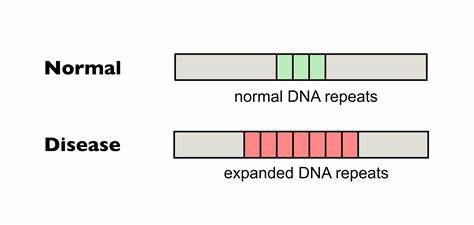

Der Fund mehrerer URLs mit der Endung „oaicite“ gab einen weiteren Hinweis darauf, dass bei der Recherche KI-Technologie von OpenAI zum Einsatz kam. KI-Tools wie ChatGPT sind zwar nützliche Hilfsmittel zur raschen Informationsbeschaffung, doch ihre Schwächen sind bekannt: Sie neigen zu sogenannten „Halluzinationen“, das heißt, sie generieren Inhalte oder Quellenangaben, die plausibel klingen, tatsächlich aber nicht existieren. Bei einem der zitierten Berichte hieß es etwa, dass Kinder bei Asthma übermäßig mit oralen Kortikosteroiden behandelt würden. Doch besagte Studie existierte nicht. Stattdessen wurde eine ähnlich betitelte Arbeit von 2017, allerdings mit anderen Autoren, nachträglich in den Bericht eingefügt.

Solche Ungenauigkeiten sind für die wissenschaftliche Integrität fatal und untergraben den Anspruch des Berichts als seriöse Grundlage für politische Entscheidungen. Weitere Fehler offenbarten sich bei Verweisen auf Medienberichte, die doppelt aufgeführt oder falsch zugeordnet wurden. So war beispielsweise ein Artikel über die Bewegungszeit von Kindern bei U.S. News & World Report von falschen Autoren signiert.

Eine Korrektur brachte später echten Autorennamen, was zeigt, dass der ursprüngliche Rechercheprozess mangelhaft war. Zumeist waren Links zu wissenschaftlichen Studien aktiv verlinkt, doch viele davon führten ins Leere, was bei einer derart umfassenden Untersuchung inakzeptabel ist. Die Kritik an dem Bericht reicht über die offensichtlichen Fehler hinaus. Fachleute wie Georges C. Benjamin, Direktor der American Public Health Association, bezeichneten das Dokument als „nicht evidenzbasiert“ und „praktisch wertlos für die Politikgestaltung“.

Die Glaubwürdigkeit des gesamten Berichts stehe auf dem Spiel, was seiner Meinung nach dazu führen sollte, dass er zurückgezogen oder zumindest überarbeitet wird. Karoline Leavitt, Pressesprecherin des Weißen Hauses, verteidigte hingegen die Substanz und Qualität des Berichts und verwies auf die unmittelbar folgenden Berichtigungen bei Zitaten und Formatierung. Dennoch stieß die Verteidigung bei vielen Experten auf Skepsis. Die Problematik der KI-gestützten Recherche zieht breite Kreise. Mitunter wurden in anderen Bereichen, wie der Justiz oder bei politischen Berichten, bereits ähnlich fehlerhafte Quellenangaben entdeckt.

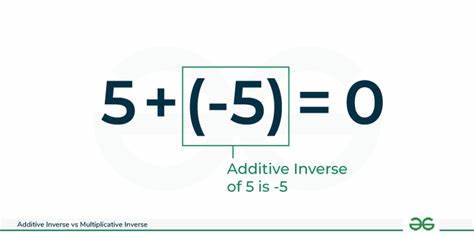

Als Beispiel wurde der frühere Gouverneur Andrew Cuomo genannt, der einen Bericht veröffentlichte, der ebenfalls ChatGPT-Nutzung und damit verbundene Fehler enthielt. Fachleute warnen davor, dass die unreflektierte Nutzung von KI-Systemen bei wissenschaftlichen Analysen zu einer Verwässerung der wissenschaftlichen Standards führt. Die Ursachen für die Fehler liegen auch in den inhärenten Eigenschaften heutiger KI-Modelle. Sie generieren Antworten auf Basis von Wahrscheinlichkeiten und statistischen Zusammenhängen, ohne ein echtes Verständnis von Fakten, Beweiskraft oder wissenschaftlicher Methodik. Steven Piantadosi von der Universität Berkeley erklärte, dass KI weder Wahrheit noch strenge logische Argumente nachvollziehen könne, weshalb sie leicht falsche oder erfundene Informationen verbreite.

Im Fall des MAHA-Berichts offenbart sich damit ein grundsätzliches Dilemma: Einerseits erleichtern moderne KI-Werkzeuge schnelle Datenbeschaffung und Verarbeitung in der Forschung. Andererseits bedarf es einer sorgfältigen menschlichen Kontrolle und Validierung, um Qualität und Glaubwürdigkeit zu gewährleisten. Das Versäumnis, derartige Kontrollmechanismen anzuwenden, führte hier zu massiven Fehlern, die nicht nur die Reputation des Berichts, sondern auch das Vertrauen in die politische Arbeit und die öffentliche Gesundheitskommunikation beschädigen. Aus inhaltlicher Sicht strebt der MAHA-Bericht eine Revolution der amerikanischen Gesundheitspolitik an, besonders im Hinblick auf Kinder. Er will langfristige Trends bei chronischen Erkrankungen sowie soziale und umweltbedingte Ursachen beleuchten.

Trotz seiner fehlerhaften Quellen nutzt er wichtige gesellschaftliche Debatten über Ernährung, Umweltbelastungen und Technologieverbrauch als Anlass zur Reform. Allerdings verlieren diese Anliegen an Wirkung, solange die wissenschaftliche Grundlage wackelt. Der Umgang des Weißen Hauses mit der Kritik zeigt, wie schwierig der Spagat zwischen Transparenz, politischem Anspruch und wissenschaftlicher Genauigkeit ist. Das Nachbessern von Zitaten wird als ausreichend dargestellt, während grundlegende Fragen etwa nach der Validität der angeblichen KI-Unterstützung unbeantwortet bleiben. Gerade bei so bedeutenden Politikdokumenten ist es aus Sicht der Fachwelt notwendig, die Methodik offen zu legen und Fehler umfassend zu korrigieren, um Vertrauen zurückzugewinnen.

Der MAHA-Bericht dient als warnendes Beispiel für die Grenzen von KI in komplexen wissenschaftlichen Untersuchungen. Er unterstreicht die Notwendigkeit, den Einsatz automatisierter Tools kritisch zu begleiten und menschliche Expertise nicht durch Scheinsicherheit zu ersetzen. Für die Zukunft bleibt zu hoffen, dass Behörden und Institutionen diese Lehren beherzigen, wenn sie Technologie mit Verantwortung verbinden wollen. Die Forderung nach mehr wissenschaftlicher Sorgfalt und nach besserer Regulierung des KI-Einsatzes in der Forschung wird weltweit lauter. Insgesamt zeigt die Debatte um den MAHA-Bericht eine gewichtige Herausforderung in einer zunehmend digitalisierten Informationsgesellschaft.

Gerade in politisch sensiblen Bereichen wie Gesundheit ist eine fundierte, verlässliche Faktenbasis unverzichtbar. Der Einsatz von Künstlicher Intelligenz darf daher nicht zu einer Verwässerung der wissenschaftlichen Standards führen, sondern muss von qualifizierten Expertinnen und Experten begleitet werden, die Qualität und Vertrauenswürdigkeit sicherstellen. Nur so lässt sich verhindern, dass wichtige gesundheitspolitische Dokumente nicht zum Gegenstand von Skepsis, sondern von konstruktiver Veränderung werden.