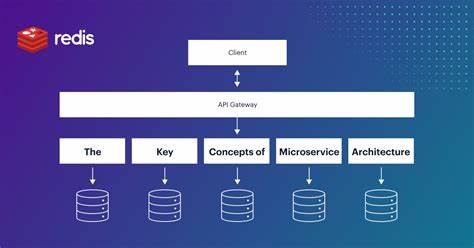

In der heutigen Welt der Softwareentwicklung haben sich Microservices als äußerst effektive Architektur durchgesetzt. Die Flexibilität und Skalierbarkeit dieser verteilten Systeme bringen allerdings auch besondere Herausforderungen mit sich. Eine davon ist das Management von Mocks, also simulierten Schnittstellen, die in Entwicklungs- und Testphasen verwendet werden, um Interaktionen zwischen den verschiedenen Services unabhängig voneinander zu gewährleisten. Die Frage, die sich viele Teams stellen: Wer sollte eigentlich die Verantwortung für das Mocking tragen – die API-Produzenten, die die Services entwickeln, oder die API-Konsumenten, die diese Services integrieren und nutzen? Diese Entscheidung hat weitreichende Auswirkungen auf Effizienz, Qualität und Wartbarkeit in der gesamten Organisation. Zunächst ist es wichtig zu verstehen, was unter Mocking im Kontext von Microservices zu verstehen ist.

Das Mocking ermöglicht es Entwicklern, Abhängigkeiten zwischen Services zu simulieren, sodass ein Team seine Komponenten testen kann, ohne dabei auf das echte Verhalten oder das Vorhandensein anderer Microservices angewiesen zu sein. Gerade in Umgebungen mit Dutzenden oder sogar Hunderten von Services hilft dies, Entwicklung und Continuous Integration unabhängig voneinander zu gestalten und Ausfallzeiten oder Verzögerungen in der Pipeline zu vermeiden. Der gängigste Ansatz heute ist, dass die Konsumenten die Verantwortung für ihre eigenen Mocks übernehmen. Das heißt, wenn ein Team einen API-Endpunkt konsumiert, erstellt es eine eigene Simulation dieses Endpunkts für die Testzwecke. Das hat gleich mehrere praktische Vorteile.

Entwickler-Teams, die eine bestimmte API nutzen, wissen genau, welche Endpunkte relevant sind und wie diese für ihre Tests aussehen müssen. Eine Frontend-Mannschaft zum Beispiel, die ein Dashboard baut, benötigt vermutlich nur eine kleine Auswahl an spezifischen API-Funktionen in einer ganz bestimmten Datenkonstellation. Daher können sie mit pragmatischen Mocks ihre Testabläufe optimieren, die speziell auf ihre Anwendungsszenarien zugeschnitten sind. Diese individuelle Mock-Erstellung reduziert die Komplexität auf Team-Ebene und ermöglicht es, Mocks exakt auf die Bedürfnisse zuzuscheiden. Entwickler sparen Zeit, indem sie nicht unnötig große oder komplexe Mock-Datenmodelle pflegen müssen.

Außerdem sind ihre Tests dadurch fokussierter und aussagekräftiger. Allerdings treten bei der Konsumenten-orientierten Verantwortung auf Organisationsebene schnell gravierende Nachteile zutage. Vor allem bei häufigen API-Änderungen entstehen hohe Wartungsaufwände. Sobald ein API-Produzent eine Änderung vornimmt, etwa eine Parameteränderung oder die Einführung eines neuen Authentifizierungsmechanismus, sind alle Mocks bei den Konsumenten potenziell ungültig. Dies führt unter Umständen zu inkonsistenten Tests oder Überraschungen im Produktionsbetrieb, wenn unerwartete Fehler auftauchen, die in den Mocks nicht abgebildet wurden.

Die Folge ist teure Doppelarbeit: Jedes Team muss seine Mocks permanent aktuell halten, was von der eigentlichen Feature-Entwicklung ablenkt. Große Konzerne berichten von einem Aufwand von bis zu zwanzig Prozent der Entwicklungszeit allein für die Pflege und Synchronisation von Mock-Implementierungen. Zudem entstehen durch die individuellen Anpassungen der unterschiedlichen Teams häufig leicht abweichende Mock-Versionen ein und derselben API. Das führt zu Inkonsistenzen im Verhalten der Mocks und erschwert die Fehlersuche und Validierung. Diese Probleme zeigen, dass das klassische Modell der ausschließlichen Konsumenten-Verantwortung nicht skalierbar ist und zu Ineffizienzen und Qualitätseinbußen führt, besonders in großen organisationsübergreifenden Projekten.

Auf der anderen Seite bietet der Ansatz, bei dem API-Produzenten die Mocks bauen und warten, klare Vorteile: Es entsteht eine zentrale, konsistente Mock-Quelle, die dem aktuellen API-Stand entspricht. Teams können diese Mocks gemeinsam nutzen und sparen sich den individuellen Aufwand. Gerade bei stabilen internen APIs, deren Struktur und Verhalten sich wenig ändern, kann dies eine praktikable Lösung sein. Die Herausforderung bei producer-seitiger Verantwortung liegt jedoch darin, dass Produzententeams meist nicht alle Testbedürfnisse der Konsumenten kennen oder abdecken können. Für Edge-Cases oder spezielle Szenarien, die einzelne Konsumenten benötigen, sind die producerseitigen Mocks oft zu generisch oder unvollständig.

Die Folge sind unzureichende Tests und der Bedarf, bei speziellen Anforderungen doch eigene Konsumenten-Mocks zu ergänzen. Neben diesen zwei Entwurfsprinzipien sind in der Praxis weitere Lösungsansätze etabliert, die auf Automatisierung und Spezifikation basieren. Automatisiertes API-Recording beispielsweise erlaubt es, reale API-Interaktionen aufzuzeichnen und daraus Mocks zu generieren, die einen echten Nutzungsmustern folgen. Insbesondere bei stabilen externen APIs kann diese Methode helfen, das Mocking aktuell zu halten und den Wartungsaufwand zu reduzieren. Allerdings funktionieren aufgezeichnete Mocks bei zeitabhängigen Daten oder dynamischen Szenarien nur bedingt, weil die Daten schnell veralten.

Eine weitere Möglichkeit ist die Nutzung von OpenAPI-Spezifikationen als Grundlage für Mock-Validierung. Produzententeams pflegen ihre API-Spezifikationen zentral, während Konsumenten die Mocks anhand dieser Spezifikation validieren und aufbauen. So wird zumindest die strukturelle Konsistenz sichergestellt. Allerdings ersetzt dies nicht die Validierung der geschäftlichen Logik: Ein Mock kann technisch korrekt sein, aber unmögliche oder unerwünschte Szenarien abbilden. Die moderne Antwort auf das Problem liegt in einem hybriden und kollaborativen Modell, das sowohl Produzenten als auch Konsumenten einbindet.

WireMock Cloud etwa verfolgt einen solchen Ansatz, indem es zentrale Mock-Definitionen ermöglicht, die von Produzenten zunächst auf Basis ihrer OpenAPI-Spezifikationen erstellt werden. Konsumenten können darauf aufbauend ihre spezifischen Testszenarien ergänzen, ohne die Grundstruktur selbst neu definieren zu müssen. Dieser kollaborative Prozess verhindert doppelte Arbeit und sorgt für hohe Konsistenz über Teams hinweg. Intelligentes Recording ergänzt die Möglichkeiten, indem Entwickler reale API-Interaktionen lokale erfassen können, selbst bei komplexen Authentifizierungen. Ergänzt wird dies durch eine automatische Validierung gegen die Spezifikation während der Testläufe, die Abweichungen und Inkompatibilitäten aufdeckt, bevor sie Produktion beeinträchtigen.

Darüber hinaus wird Künstliche Intelligenz zunehmend eingesetzt, um Mocks auf Basis von Codebasis und Anforderungen automatisch anzupassen. Solche Tools, wie zum Beispiel WireMock MCP in Verbindung mit GitHub Copilot, bieten vielversprechende Ansätze, um die Wartung von Mocks erheblich zu erleichtern oder gar zu automatisieren. Zusammenfassend zeigt sich, dass ein Entweder-Oder beim Mocking in Microservices-Umgebungen sehr selten sinnvoll ist. Stattdessen profitieren Organisationen von einer geteilten Verantwortlichkeit, in der Produzenten die strukturellen Grundlagen und korrekten Spezifikationen bereitstellen, während Konsumenten ihre funktionalen Testbedarfe mit maßgeschneiderten Szenarien abdecken. Der Einsatz automatisierter Tools und Validierungstechniken unterstützt diesen Prozess erheblich und erhöht die Zuverlässigkeit der Tests und den gesamten Entwicklungsprozess.

Letztlich hängt die optimale Verteilung der Mock-Verantwortung stark vom Kontext der Organisation, der Stabilität der APIs und der Entwicklungsprozesse ab. Unternehmen sollten daher Wege wählen, die sowohl Flexibilität als auch Konsistenz gewährleisten und gleichzeitig den Aufwand für Wartung und Pflege möglichst gering halten. Die Kombination aus Spezifikationsmanagement, kollaborativen Mocking-Frameworks und innovativen Automatisierungstechniken ist der Schlüssel, um in komplexen Microservices-Landschaften erfolgreich zu test- und entwicklungsfähigen Umgebungen zu gelangen.