In der heutigen Welt, in der künstliche Intelligenz zunehmend komplexe Textverarbeitung übernimmt, gewinnen große Sprachmodelle (Large Language Models, kurz LLMs) immer mehr Bedeutung. Diese Modelle, ausgestattet mit der Fähigkeit, immense Datenmengen zu analysieren und zu verstehen, sind mittlerweile in der Lage, Textabschnitte von 100.000 bis hin zu einer Million Tokens zu verarbeiten. Doch wie gut funktionieren sie tatsächlich bei der Handhabung so langer Kontexte und vor allem, wie zuverlässig sind sie, wenn klassische Methoden der wörtlichen Übereinstimmung nicht ausreichen? Die Antwort liefert NoLiMa, ein innovativer Evaluationsrahmen, der genau diese Fragestellung adressiert und dabei neue Maßstäbe setzt. NoLiMa, kurz für "Long-Context Evaluation Beyond Literal Matching", wurde im Rahmen der ICML 2025 vorgestellt.

Die Forscher konzentrieren sich auf das Problem, das bei herkömmlichen Verfahren oft übersehen wird: Während viele bisherige Benchmarks die Suche nach einer relevanten Information – einer sogenannten Nadel – in einem riesigen, oft irrelevanten Kontext – dem Heuhaufen – durch wörtliche Übereinstimmung erleichtern, geht NoLiMa bewusst darüber hinaus. Das bedeutet, dass Fragen und zugehörige Informationsstücke kaum lexikalische Gemeinsamkeiten aufweisen. Stattdessen müssen Modelle latente, implizite Zusammenhänge erfassen und Schlussfolgerungen ziehen, um überhaupt zu identifizieren, wo die gesuchte Information verborgen liegt. Diese konzeptionelle Verschiebung ist bedeutend, denn sie macht den Evaluationsprozess realistischer und anspruchsvoller. In der Praxis haben Nutzer oft keine Garantie, dass die exakten Suchbegriffe identisch im Zieltext vorkommen.

Vielmehr sind Assoziationen, indirekte Hinweise oder komplexe Ketten von Fakten gefragt, um relevante Antworten zu finden. NoLiMa reagiert auf diese Herausforderung und misst die Fähigkeit der LLMs, über das oberflächliche Matching hinauszugehen. Die Ergebnisse der Evaluierung zeigen ein durchwachsenes Bild. Während viele der bekanntesten Modelle bei kurzen Kontexten von weniger als 1.000 Tokens nahezu perfekte Ergebnisse erzielen, verschlechtert sich ihre Leistung mit zunehmender Kontextlänge drastisch.

Bei 32.000 Tokens sinken die Erfolgsraten von zehn der zwölf getesteten Modelle auf weniger als die Hälfte ihres Ausgangsniveaus. Selbst Topmodelle wie GPT-4o verlieren von fast vollständiger Genauigkeit auf unter 70 Prozent. Diese Leistungseinbußen offenbaren eine fundamentale Einschränkung vieler heutiger Aufmerksamkeitssysteme, die Schwierigkeiten haben, relevante Informationen in langen Texten auch ohne direkte Wortübereinstimmungen zu identifizieren. Die Analyse von NoLiMa unterstreicht, dass die Funktionsweise der Aufmerksamkeit, auf der viele LLMs basieren, bei extrem langen Kontexten ihre Grenzen erreicht.

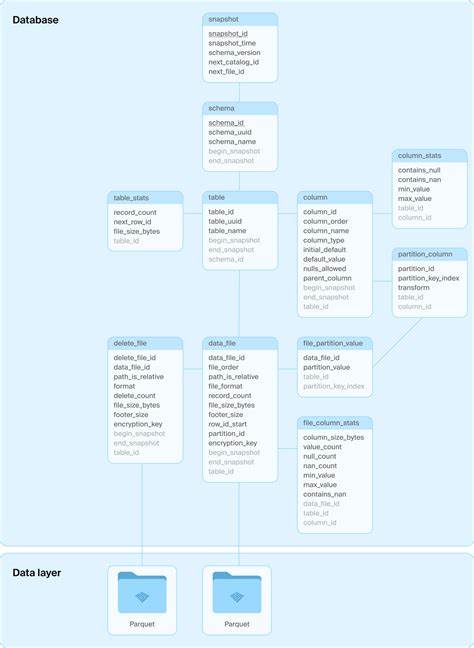

Ohne klare lexikalische Anhaltspunkte kann das Modell den Fokus nicht präzise genug setzen, wodurch die Retrieval-Fähigkeit massiv leidet. Dies hat tiefgreifende Folgen für Anwendungen, die auf die Verarbeitung großer Dokumente oder Textkorpora angewiesen sind – etwa in Recht, Medizin, Wissenschaft oder bei der Analyse von Unternehmensdaten. NoLiMa bietet dabei nicht nur eine belastbare Methode zur Leistungsbewertung, sondern auch einen praktischen Werkzeugkasten für Entwickler und Forscher. Die Veröffentlichung beinhaltet nämlich neben dem Benchmark selbst auch umfangreiche Codebasis und Datensätze, die den Zugang und die Nachvollziehbarkeit der Ergebnisse ermöglichen. Dadurch wird eine gemeinsame Grundlage geschaffen, um bestehende Modelle kritisch zu vergleichen, neue Architekturen zu entwickeln und letztlich die Grenzen der Langzeitkontextverarbeitung zu verschieben.

Die Methodik hinter NoLiMa umfasst verschiedene anspruchsvolle Szenarien, darunter die Suche nach Informationen inmitten zahlreicher irrelevanter Daten, die Kombination mehrerer Fakten in Ketten sowie die Einbettung von In-Context Reasoning. Besonders prägnant ist dabei die Gestaltung der "Needle Sets". Diese wurden mit großer Sorgfalt so entworfen, dass die Fragen keine direkten sprachlichen Übereinstimmungen mit den Zieltexten enthalten. Nur durch tiefes inhaltliches Verständnis und Schlussfolgerungen kann die gesuchte Information richtig lokalisiert werden. Neben der reinen Genauigkeitsbewertung werden bei NoLiMa auch sogenannte "Hard Set"-Tests eingesetzt, die besonders schwierige Frage-Antwort-Paare umfassen.

In diesen Tests sinken die meisten Modelle auf Werte unter 50 Prozent, wobei selbst GPT-4.1 und GPT-4o nur knapp diese Schwelle halten können. Modelle, die explizit mit Fähigkeiten zum Kettenargumentieren (Chain-of-Thought, CoT) ausgestattet sind, zeigen zwar teilweise eine bessere Robustheit, aber auch hier ist die Abhängigkeit von der Kontextlänge signifikant. Die faszinierende Erkenntnis aus diesen Ergebnissen ist, dass die Effektivität eines Modells in langen Kontexten nicht nur von seiner Größe oder der Anzahl der Parameter abhängt, sondern vor allem von der zugrundeliegenden Architektur und den Mechanismen zur Informationsverarbeitung. Modelle wie Gemini 2.

5 Pro und GPT-o1, die speziell für das reasoning optimiert sind, schneiden im Vergleich besser ab und verdeutlichen, dass gezielte Anpassungen der Denkstrategien und der Aufmerksamkeitssysteme notwendig sind, um die Langzeitverarbeitung zu verbessern. Für die Praxis bedeutet dies: Unternehmen und Entwickler, die mit großen Dokumentensammlungen arbeiten oder Anwendungen für lange Textpassagen entwickeln, müssen sich der Grenzen aktueller LLMs bewusst sein. Die Ergebnisse von NoLiMa vermitteln somit nicht nur ein realistisches Bild des Status quo, sondern bieten gleichzeitig eine Richtschnur für die Entwicklung effizienterer Modelle. Die Herausforderung besteht darin, neue Formen der Informationsaggregation und des relationalen Verständnisses zu fördern, die nicht auf exakte Wortübereinstimmung angewiesen sind. Ein weiterer bedeutender Vorteil des NoLiMa-Frameworks liegt in seiner Offenheit und Zugänglichkeit.

Durch die Bereitstellung von Datensätzen, Evaluationspipelines und konkreten Anleitungen zur Implementierung und Auswertung erleichtert es Forschern und Entwicklern weltweit den Zugang. So können neue Modelle getestet, verglichen und durch iterative Verbesserungen weiterentwickelt werden. Insbesondere angesichts der rasanten Fortschritte im Bereich der KI ist ein offenes, gemeinsames Benchmarking von unschätzbarem Wert. Auch aus akademischer Perspektive eröffnet NoLiMa interessante Einsichten. Die Studie liefert empirische Belege für die Grenzen bisheriger Aufmerksamkeitstechniken bei extrem langen Texten.

Gleichzeitig verweist sie auf die Möglichkeiten, die sich durch hybride Ansätze ergeben könnten, etwa durch die Kombination von Retrieval-Systemen mit reasoning-basierten Modellen oder durch innovative Gedächtnis- und Filtermechanismen. Solche Innovationen könnten die nächste Generation von LLMs prägen, die nicht nur große Mengen an Text verarbeiten, sondern auch komplexe, nicht-wörtlich verankerte Zusammenhänge zuverlässig erkennen und nutzen. Zusammenfassend lässt sich sagen, dass NoLiMa weit mehr als ein einfaches Testset für LLMs ist. Es ist ein Meilenstein in der Evaluation von Sprachmodellen, der das Verständnis für die Herausforderungen und Möglichkeiten der Langzeitkontextverarbeitung vertieft. Insbesondere die Fokussierung auf die Überwindung wörtlicher Übereinstimmung ebnet den Weg für den nächsten Schritt in der Entwicklung künstlicher Intelligenz – hin zu echter semantischer Tiefe, kontextuellem Verständnis und nachhaltiger Wissensverfügbarkeit.

Für Unternehmen, Forschungseinrichtungen und Entwickler ist NoLiMa deswegen ein unverzichtbares Werkzeug, um den Status, die Stärken und die Schwächen ihrer KI-Systeme realistisch einzuschätzen. Das Benchmarking fördert nicht nur Transparenz und Vergleichbarkeit, sondern inspiriert auch die Suche nach neuen Lösungsansätzen, die den Bedürfnissen einer zunehmend datengetriebenen Gesellschaft gerecht werden. Die Zukunft der Langzeitkontextverarbeitung liegt darin, Modelle zu schaffen, die nicht nur über große Datenmengen verfügen, sondern diese auch intelligent, tiefgründig und zuverlässig erschließen können – eine Vision, der NoLiMa entscheidende Impulse verliehen hat.