Die Verarbeitung langer Kontextinformationen stellt eine der größten Herausforderungen im Bereich der Künstlichen Intelligenz (KI) dar. In der heutigen Welt, in der immer komplexere Aufgaben von Maschinen übernommen werden, spielt die Fähigkeit, umfangreiche Datenkontexte zu verstehen und zu nutzen, eine entscheidende Rolle für den Fortschritt von KI-Systemen. Nikolay Savinov, ein führender Forscher bei Google DeepMind, widmet sich intensiv diesem Thema. Seine Arbeit zeigt auf, wie KI durch innovative Ansätze die Verarbeitung langer Kontextinformationen effizienter und effektiver gestalten kann. Die Bedeutung langer Kontextverarbeitung rührt vor allem daher, dass viele Anwendungsbereiche der KI, wie maschinelles Übersetzen, Textzusammenfassung oder Dialogsysteme, weit mehr als nur kurze Ausschnitte von Daten benötigen, um überzeugende Ergebnisse zu erzielen.

Klassische Modelle stoßen hier oft an ihre Grenzen, da sie in der Regel nur eine begrenzte Menge an Informationen in einem bestimmten Fenster verarbeiten können. Dies führt oft dazu, dass wichtige Kontextinformationen verloren gehen, was sich negativ auf die Leistung des Systems auswirkt. Die Forschung von Nikolay Savinov beschäftigt sich insbesondere mit Methoden, die es erlauben, den gesammelten Kontext über sehr lange Zeiträume zu erfassen und effektiv zu nutzen. Dabei kommen verschiedene Techniken aus den Bereichen neuronale Netze und maschinelles Lernen zum Einsatz. Ein Schwerpunkt liegt darauf, das Thema langfristiger Abhängigkeiten in Sprachmodellen zu bewältigen, wodurch beispielsweise die semantische Kohärenz in umfangreichen Texten erhalten bleibt.

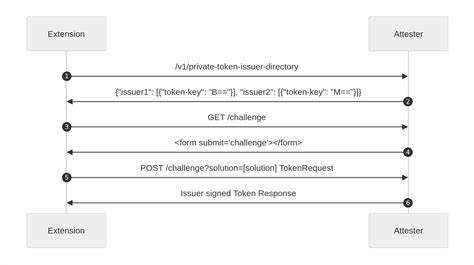

Die Herausforderung besteht darin, diese sogenannten langen Abhängigkeiten auch bei sehr großen Datenmengen effizient zu verarbeiten, ohne die Rechenressourcen unverhältnismäßig zu beanspruchen. Google DeepMind hat in diesem Kontext bereits bedeutende Fortschritte gemacht, indem es neue Architekturen entwickelt, die auf sogenannten „memory-augmented neural networks“ basieren. Diese Netzwerke ermöglichen es dem Modell, vergangene Informationen explizit zu speichern und bei Bedarf abzurufen, ähnlich wie ein menschliches Gedächtnis. Dadurch wird nicht nur die Kapazität zum Verarbeiten großer Datenmengen erhöht, sondern auch die Flexibilität verbessert, unterschiedliche Informationsquellen gezielt miteinander zu verknüpfen. Ein weiterer wichtiger Aspekt von Savinovs Arbeit ist die Skalierbarkeit der Modelle.

Längere Kontextverarbeitung führt naturgemäß zu einem exponentiellen Anstieg der zu verarbeitenden Informationen. Deshalb müssen die Modelle so optimiert werden, dass sie trotz wachsender Kontextlänge nicht an Geschwindigkeit und Effizienz verlieren. Hier kommen Verfahren wie Sparse Attention und effiziente Approximationstechniken zum Einsatz, die den Ressourcenverbrauch drastisch senken und gleichzeitig hohe Genauigkeit ermöglichen. Neben technologischen Innovationen spielt auch die Evaluation eine große Rolle. Um die Erfolge bei der langen Kontextverarbeitung messbar zu machen, entwickeln Forschende bei DeepMind spezielle Benchmark-Tests, die realistische Aufgaben abbilden, bei denen lange Abhängigkeiten und großer Kontext eine entscheidende Rolle spielen.

Diese Tests helfen dabei, die Leistungsfähigkeit der neuen Methoden objektiv zu bewerten und gezielt weiter zu verbessern. Das Potenzial, das durch die Verbesserung der langen Kontextverarbeitung entsteht, ist enorm. Anwendungen könnten künftig deutlich kontextsensitiver und menschlicher in ihrer Interaktion mit Nutzern werden. Beispielsweise könnten virtuelle Assistenten in der Lage sein, über längere Konversationen hinweg den Zusammenhang zu behalten und somit deutlich präzisere Antworten liefern. Auch in der Wissenschaft etwa bei der Analyse umfangreicher Forschungstexte oder in der Medizin mit der Verarbeitung langer Patientenakten eröffnen sich neue Möglichkeiten.

![Deep Dive into Long Context – With Google DeepMind's Nikolay Savinov [video]](/images/54BA7D7D-585F-4E6F-BA4F-E42D83B2F14E)