In den letzten Jahren hat die Transformer-Architektur die Welt der Künstlichen Intelligenz und insbesondere der großen Sprachmodelle maßgeblich geprägt. Modelle wie GPT oder LLaMA basieren auf dem Transformer-Prinzip, das durch seine Selbst-Attention-Mechanismen eine erstaunliche Fähigkeit besitzt, Texte menschlich und kohärent zu generieren. Trotz dieser beeindruckenden Leistung stößt die Technologie bei langen Textsequenzen an ihre Grenzen: Die quadratische Steigerung der Rechen- und Speicherkosten führt zu Verzögerungen und beschränkter Effizienz. Genau hier setzt Bamba an – ein neuartiges, offen zugängliches Modell, das Transformer mit State-Space-Modellen (SSM) kombiniert und so das Beste aus beiden Welten bietet. IBM Research entwickelt Bamba in Zusammenarbeit mit führenden Forschungseinrichtungen wie der Carnegie Mellon University und Princeton University, was dem Projekt einen starken wissenschaftlichen Rückhalt gibt.

State-Space-Modelle sind ein etablierter Ansatz aus der Elektrotechnik und Steuerungstheorie, der zeitabhängige Systeme durch sogenannte verborgene Zustände beschreibt. Diese Modelle sind bekannt für ihre Fähigkeit, Sequenzen effizient zu verarbeiten und dabei eine konstante Speichergröße zu wahren. Während Transformers alle Tokens in der Eingabesequenz simultan gewichten, fasst das SSM die Vergangenheit in einem kompakten, kontinuierlich aktualisierten Zustandsvektor zusammen. Durch diese Eigenschaft eignen sich State-Space-Modelle hervorragend für lange Kontextfenster und nachhaltige Verarbeitung. Allerdings erreichten sie bisher in der Sprachmodellierung nicht die Ausdruckskraft der Transformer.

Bamba überwindet diese Schwäche durch eine geschickte Hybridisierung. Indem es Transformer-Schichten mit SSM-Elementen kombiniert, erlaubt das Modell sowohl die lokale Abhängigkeitserfassung durch Aufmerksamkeit als auch die günstige Langzeitkontext-Verarbeitung mithilfe des State-Space-Mechanismus. So entsteht ein System, das die Quadratische Komplexitätsfalle der Transformer meidet und gleichzeitig eine hohe Qualität der generierten Texte beibehält. Durch diese Verringerung der Auslastung der Key-Value-Cache-Speicher erreicht Bamba signifikante Leistungssteigerungen im Vergleich zu herkömmlichen Transformer-Modellen ähnlicher Größe.Die Entwickler von Bamba trainierten das Modell zunächst auf gigantischen Mengen von über zwei Billionen Tokens, um eine breite Abdeckung sprachlicher Muster und Domänen zu gewährleisten.

Das Training erfolgte mit hochentwickelten Techniken, die eine effiziente Verteilung auf große Rechnercluster ermöglichen. Zudem sorgten sie durch den Einsatz von Quantisierungsmethoden dafür, dass das Modell trotz seiner Komplexität nur noch die Hälfte des ursprünglichen Speicherplatzes benötigt. Mit einer Reduktion auf 8-Bit-Präzision konnte Bamba eine reduzierte Speicherlast erzielen, ohne dabei an Genauigkeit einzubüßen. Dies macht das Modell besonders attraktiv für den Einsatz in Unternehmen und Forschung, die hohe Ansprüche an Effizienz stellen.Bamba schafft eine bemerkenswerte Balance zwischen Schnelligkeit und Präzision.

Benchmark-Tests zeigen, dass es mit Meta’s LLaMA 3.1 8B konkurrieren kann, obwohl LLaMA mit deutlich mehr Trainingsdaten gefüttert wurde. Die Fähigkeit, lange Gesprächsverläufe mit bis zu 32.000 Tokens zu verarbeiten, eröffnet neue Möglichkeiten für komplexe Aufgaben wie Dialogsysteme, technische Dokumentationen oder andere Anwendungen, die einen ausgedehnten Kontext benötigen. Experten gehen sogar davon aus, dass Bamba eines Tages mit wenig Optimierungen in der Lage sein wird, Kontextlängen von bis zu einer Million Tokens zu bewältigen, was die Grenzen heutiger Sprachmodelle revolutionieren könnte.

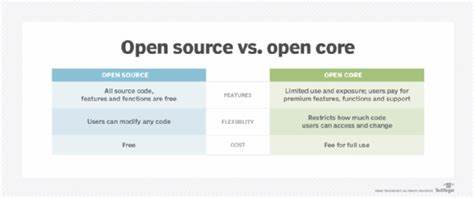

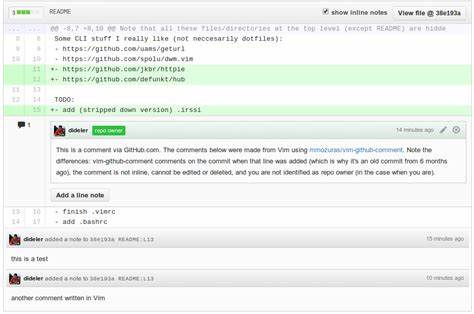

Neben seinen beeindruckenden technischen Eigenschaften verfolgt Bamba einen offenen Entwicklungsansatz. IBM pubblicierte nicht nur das Modell selbst, sondern auch sämtliche Komponenten der Trainingspipeline, Datensätze, Datenladesysteme sowie Werkzeuge zur weiteren Effizienzsteigerung, um die Zusammenarbeit innerhalb der KI-Community zu fördern. Dies erleichtert Forschern und Entwicklern den Zugriff auf modernste Technik und beschleunigt die Innovation im Bereich der Sprachverarbeitung. Durch die Integration in offene Inferenzplattformen wie vLLM konnten bestehende Herausforderungen beim Betrieb von SSM-Hybriden gemeistert werden, um ein reibungsloses Open-Source-Ökosystem zu schaffen.Die hybride Architektur von Bamba spiegelt die wachsende Erkenntnis wider, dass die nächste Generation von KI-Modellen nicht auf einzelne Technologien beschränkt ist, sondern deren Kombination neue Horizonte eröffnet.

Während Transformer für kurze bis mittellange Abhängigkeiten unübertroffen sind, bieten State-Space-Modelle eine effiziente Methode, Informationen über sehr lange Zeitfenster zu speichern. In Bamba werden diese Stärken vereint und so ein Modell geschaffen, das sowohl skalierbar als auch vielseitig einsetzbar ist.Weiterhin zeigt Bamba das Potenzial, branchenübergreifend eingesetzt zu werden. Vom Gesundheitswesen über Finanzdienstleistungen bis zur Fertigung kann das Modell mit seiner Langzeitgedächtnis-Fähigkeit und schnellen Verarbeitung neuartige Anwendungen realisieren. Beispiele sind etwa automatisierte Patientenaktenanalyse, Echtzeitprognosen oder erweiterte Produktionsüberwachung – jeweils unterstützt durch die Fähigkeit, sehr große Mengen an sequenziellen Daten zu verstehen und zu verarbeiten.

Abschließend ist Bamba ein Meilenstein auf dem Weg zu effizienteren, leistungsstärkeren großen Sprachmodellen, die mit wachsendem Kontext umgehen können, ohne hohe Rechenkosten zu verursachen. Die offene Natur des Projekts verspricht, die Community zur Mitgestaltung einzuladen und den Fortschritt im Bereich der künstlichen Intelligenz weiter voranzutreiben. Mit Bamba wird nicht nur ein technisches Problem gelöst, sondern auch eine neue Ära der Kollaboration zwischen Wissenschaft, Wirtschaft und Entwicklung eingeläutet – ganz im Sinne einer nachhaltigen und zugänglichen KI-Zukunft. Die Kombination aus Transformer und State-Space-Modellen könnte zukünftig zum Standard werden und eine Vielzahl von innovativen Anwendungen und Diensten ermöglichen, die heute noch undenkbar sind.