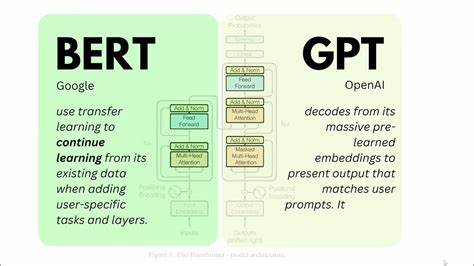

In der modernen Welt der Künstlichen Intelligenz und des maschinellen Lernens gewinnt die automatische Textklassifikation zunehmend an Bedeutung, insbesondere im Bereich der natürlichen Sprachverarbeitung (Natural Language Processing, NLP). Große Sprachmodelle (Large Language Models, LLMs) wie GPT haben die Möglichkeiten automatisierter Annotationen revolutioniert und bieten neue Wege, um kleinere, spezialisierte Modelle wie BERT-Klassifikatoren mit synthetisch generierten Labels zu verbessern. Doch trotz des offensichtlichen Potenzials dieser Methode gibt es gewichtige Risiken und Herausforderungen, die nicht außer Acht gelassen werden dürfen. Die verbreitete Praxis, von LLMs generierte Annotationen als Trainingsgrundlage für kleinere Encoder-basierte Modelle zu verwenden, hat sich in vielerlei Hinsicht als effizient und kostensparend erwiesen. Vor allem in Szenarien, in denen hochwertige manuelle Label nur begrenzt verfügbar oder sehr teuer sind, erscheinen automatisch erzeugte Labels als attraktive Alternative.

Allerdings zeigt die jüngste empirische Forschung, dass genau diese Herangehensweise eine Art „Fluch synthetischer Daten“ mit sich bringt, der sich deutlich auf Leistung und Zuverlässigkeit auswirkt. Eine zentrale Erkenntnis ist, dass Modelle, die auf LLM-generierten Labels trainiert werden, im Vergleich zu Modellen, die auf echten, von Menschen erstellten Labels basieren, eine spürbare Verschlechterung in Bezug auf Genauigkeit und F1-Score aufweisen. Dies ist besonders besorgniserregend, wenn die Modelle in kritischen Anwendungen wie der medizinischen Diagnose, juristischen Textanalyse oder anderen hochsensiblen Bereichen eingesetzt werden sollen. Dort kann jeder Fehler schwerwiegende Konsequenzen haben. Neben der reinen Leistungsabnahme beobachten Forschende auch eine deutlich höhere Instabilität während der Trainingsläufe.

Während bei Modellen mit Gold-Labeln die Trainingsresultate stabil und reproduzierbar sind, zeigen Modelle, die mit LLM-Annotationen versorgt wurden, starke Schwankungen in ihrer Leistung. Dies erschwert nicht nur die Modellbewertung, sondern auch die zuverlässige Integration in produktive Umgebungen. Darüber hinaus neigen diese Modelle dazu, frühzeitig in sogenannte Performance-Plateaus zu laufen. Das bedeutet, dass die Lernkurve konstant flacht und keine weiteren Verbesserungen erzielt werden, selbst wenn zusätzliche Trainingszeit investiert wird. Eine Ursache ist die Natur der Fehler in den generierten Labels: Sie sind nicht zufällig, sondern systematisch, wodurch das Modell in seinen Fehlannahmen bestärkt wird und keine Möglichkeit hat, solche Fehler eigenständig zu korrigieren.

Dieses Phänomen lässt sich durch das Konzept der Fehlerfortpflanzung erklären. Fehlerhafte Annotationen führen dazu, dass das nachfolgende Modell auf falschen Informationen aufgebaut wird. Besonders problematisch ist, dass diese Fehler oft zusammenhängend und nicht gleichmäßig verteilt sind. Dadurch entstehen Verzerrungen, die sich verstärken und sich negativ auf die Generalisierungsfähigkeit des Modells auswirken. Um die negativen Auswirkungen zu mildern, wurden im aktuellen Forschungsrahmen einige praktische Strategien vorgeschlagen.

Eine davon sind Entropie-basierte Filtermechanismen. Hierbei wird der Grad der Unsicherheit in den LLM-Annotationsvorhersagen genutzt, um besonders zweifelhafte Labels auszusortieren. Solche Filter können zwar den Anteil besonders problematischer Trainingsbeispiele reduzieren, sind aber nicht in der Lage, alle Risiken vollständig auszuschalten. Ein weiteres bekanntes Vorgehen sind Ensemble-Techniken, bei denen mehrere Modelle parallel trainiert und deren Ergebnisse kombiniert werden. Durch die Aggregation verschiedener Modelle können durch die unterschiedlichen Fehlerprofile einzelne Fehlentscheidungen ausgeglichen werden.

Allerdings erhöht sich durch Ensembles der Rechenaufwand signifikant, was im Einsatz geringer Ressourcen eine große Herausforderung darstellt. Trotz dieser Methoden bleibt eine grundsätzliche Vorsicht bei der Verwendung von LLM-Annotationen zur Feinabstimmung kleinerer Modelle geboten. Insbesondere bei Anwendungen mit hohem Stakeholder-Risiko sollten synthetisch erzeugte Labels bestenfalls als Ergänzung und nicht als Ersatz für sorgfältig kuratierte Gold-Labels dienen. Die Kombination aus automatisierter Annotation und menschlicher Kontrolle kann hier einen Mittelweg bieten, um sowohl Effizienz als auch Verlässlichkeit zu gewährleisten. Ausblickend zeigen sich einige spannende Forschungsfelder, um die Probleme der Fehlerfortpflanzung und Instabilität weiter zu adressieren.

Beispielsweise könnten verbesserte Unsicherheitsmessungen in LLMs oder innovative Lernverfahren, die Robostheit gegenüber systematischen Annotationen erhöhen, zukünftig helfen, die Defizite zu überwinden. Auch der interdisziplinäre Austausch zwischen maschinellem Lernen, Statistik und Domänenexpertise wird zunehmend an Bedeutung gewinnen. Zusammenfassend lässt sich sagen, dass die Verwendung von LLM-generierten Annotationen zur Schulung von BERT-Klassifikatoren zwar vielversprechende Vorteile in Bezug auf Skalierbarkeit und Kostenersparnis bietet, gleichzeitig jedoch erhebliche Risiken birgt. Die durch fehlerhafte Labels entstehenden Herausforderungen wirken sich negativ auf Performance, Stabilität und Zuverlässigkeit aus und müssen kritisch betrachtet werden. Mit gezielten Strategien wie Entropie-basiertem Filtern und Ensemble-Methoden kann man zwar einige Probleme abmildern, doch eine vollständige Eliminierung der Risiken ist derzeit nicht möglich.

Verantwortungsbewusste Anwendung und sorgfältige Validierung bleiben daher zentral, um den optimalen Nutzen aus diesen Technologien zu ziehen, ohne deren Grenzen zu ignorieren.