Die Chemie ist eine der ältesten und zugleich dynamischsten Naturwissenschaften. Sie befasst sich mit der Untersuchung der Materie, deren Eigenschaften, Zusammensetzung und den Veränderungen, die sie durchläuft. Traditionell beruht das Fortschreiten der Chemie stark auf menschlicher Expertise, langjähriger Erfahrung und intensivem Forschen in Laboren. Doch mit dem Aufkommen großer, auf Sprachverarbeitung spezialisierter künstlicher Intelligenz-Modelle erlebt die Disziplin einen Paradigmenwechsel. Große Sprachmodelle, auch Large Language Models (LLMs) genannt, zeigen zunehmend Fähigkeiten, komplexe chemische Fragestellungen zu verstehen und zu beantworten.

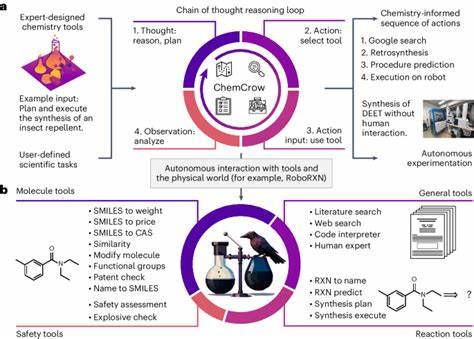

Wie schlagen sich diese KI-Systeme im Vergleich zu menschlichen Chemikern? Welche Stärken und Schwächen offenbaren sie, und welche Bedeutung hat dies für die Zukunft der Chemie? Diese Fragen stehen im Mittelpunkt der neuesten Forschungsergebnisse rund um die Evaluation des chemischen Wissens und der Argumentationsfähigkeit von LLMs gegenüber menschlicher Expertise. Große Sprachmodelle und ihre Rolle in der Chemie LLMs wurden auf Basis riesiger Textmengen trainiert, um natürlichsprachliche Aufgaben zu lösen. Ursprünglich entwickelt für die Verarbeitung und Generierung von Text, haben sie durch die exponentielle Steigerung der Modellgrößen und die Verfügbarkeit umfangreicher Daten einen erstaunlichen Fortschritt erlebt. Heute sind sie beispielsweise in der Lage, medizinische Prüfungen zu bestehen, komplexe wissenschaftliche Arbeiten zu verstehen oder sogar chemische Reaktionen vorzuschlagen. In der Chemie ermöglichen solche Modelle den Zugriff auf eine Vielzahl von Informationen aus wissenschaftlichen Publikationen, Datenbanken und Lehrbüchern.

Sie können Eigenschaftsvorhersagen für Moleküle treffen, Reaktionswege vorschlagen oder Sicherheitsfragen beantworten. Ein besonders auffälliger Vorteil von LLMs ist ihre Flexibilität: Sie meistern Aufgaben, für die sie nicht explizit trainiert wurden, was auf einen gewissen Grad an Transferlernen oder „allgemeiner“ Intelligenz hindeutet. So können sie theoretisch als universelle Assistenten in der Chemie fungieren, welche die Informationsflut rasch durchsuchen und Lösungen erarbeiten, die sonst mehrere Expertenstunden oder -tage erfordern würden. Die Herausforderung: Vergleich mit menschlicher Chemikerkompetenz Traditionell wurden Fortschritte in der Chemie durch die Fähigkeiten von Wissenschaftlern bewertet – ihr Wissen um chemische Prinzipien, ihre Fähigkeit zum logischen Denken und Problemlösen sowie ihr intuitives Verständnis oft komplexer Zusammenhänge. Für LLMs stellt sich daher die Frage, inwieweit ihre Leistung mit der von menschlichen Chemikern vergleichbar ist.

Um das objektiv zu beantworten, haben Forscher den sogenannten ChemBench entwickelt. Diese Benchmark bietet ein definiertes Set von rund 2.700 Fragen aus unterschiedlichen chemischen Bereichen, die sowohl grundlegende als auch fortgeschrittene Themen abdecken. Die Fragen sind vielfältig: Sie reichen von reinem Faktenwissen über komplexe Beweisführungen und Berechnungen bis hin zu experimenteller Intuition. Die Antworten der Modelle werden direkt mit jenen von erfahrenen Chemikern verglichen, wobei letztere auch moderne Werkzeuge wie Websuche verwenden dürfen, um ein realistisches Arbeitsumfeld abzubilden.

Überraschende Ergebnisse: LLMs übertreffen menschliche Experten Die Evaluation zeigte, dass einige der besten LLMs, darunter zum Beispiel das Modell „o1-preview“, bei der Beantwortung chemischer Fragestellungen nicht nur mit menschlichen Chemikern mithalten konnten, sondern diese in vielen Fällen sogar übertrafen. Tatsächlich lag die Leistungsfähigkeit des Spitzenmodells im Durchschnitt fast doppelt so hoch wie die der besten menschlichen Teilnehmer. Neben proprietären, kommerziellen Modellen schnitten auch neu entwickelte Open-Source-Modelle, wie Llama-3.1-405B-Instruct, bemerkenswert gut ab. Dies zeigt, dass die technologische Entwicklung in diesem Bereich inzwischen einer breiteren Forschungs- und Entwicklergemeinschaft offensteht.

Begrenzungen der KI: Probleme bei Basiswissen und Sicherheitsfragen Trotz der beeindruckenden Ergebnisse ist das Leistungsbild nicht uneingeschränkt positiv. Bestimmte Kernaufgaben, die auf einfachem Faktenwissen basieren, wie etwa die sichere Identifikation von chemischen Substanzen oder Sicherheitsaspekte, stellen die LLMs vor Probleme. So konnten sie nicht immer zuverlässig Fakten abrufen oder veraltete und falsche Informationen vermeiden. Darüber hinaus zeigen manche Modelle eine gefährliche Überkonfidenz: Sie geben Antworten mit sehr hoher Sicherheit ab, die jedoch inkorrekt sind. Diese falsche Selbstsicherheit stellt eine ernstzunehmende Gefahr im praktischen Einsatz, vor allem im Umgang mit potenziell gefährlichen Chemikalien oder in sicherheitskritischen Anwendungen.

Vergleich zwischen Modellgröße und Leistung Ein weiterer interessanter Befund ist, dass die Leistung der LLMs tendenziell mit deren Modellgröße korreliert. Größere Modelle schneiden häufig besser ab, was ein Indiz dafür ist, dass eine weitere Skalierung des Modells auch in der Chemie zu verbesserten Ergebnissen führen könnte. Themenabhängige Leistung: Einige Teilbereiche bleiben schwierig Wenn man die Ergebnisse differenziert nach chemischen Fachgebieten betrachtet, zeigt sich eine heterogene Leistungsfähigkeit. Klassische Bereiche wie Allgemeine und Technische Chemie werden von den KI-Modellen oft zu einem großen Teil korrekt bearbeitet. Hingegen bleiben Spezialgebiete wie Toxikologie, Sicherheitsbestimmungen oder Analytische Chemie eine Herausforderung.

Besonders im Bereich der Analytischen Chemie fiel beispielsweise die Vorhersage der Anzahl von Signalen in einem Kernspinresonanzspektroskopiespektrum schwer, was zum Teil daran liegt, dass Menschen hierfür grafische Darstellungen nutzen können, während die Modelle mit textuellen Repräsentationen arbeiten müssen. Dass die Modelle bei komplexeren Aufgaben, die mehr strukturelles Verständnis erfordern, Schwierigkeiten haben, legt nahe, dass sie eher auf Abruf von Informationen aus ihrem Trainingsdatensatz zurückgreifen als auf echte chemische Argumentation oder Modellierung. Herausforderungen bei der chemischen Intuition und Präferenzbeurteilung Die Fähigkeit, eine chemische Präferenz zu beurteilen – also etwa zu entscheiden, welcher von zwei Molekülen in einem bestimmten Kontext besser geeignet ist – war für die untersuchten Modelle kaum nachzuweisen. Im Gegensatz zu menschlichen Experten, die auf jahrelanger Erfahrung basierende Einschätzungen treffen können, fielen LLMs bei dieser Aufgabe auf dem Niveau eines Zufallsgenerators zurück. Dies ist problematisch, da genau solche Intuitionen im Forschungs- und Entwicklungsprozess entscheidend sind, beispielsweise in der Arzneimittelentwicklung.

Zur Verbesserung wäre es denkbar, Modelle gezielt auf Präferenzdaten oder menschliches Urteil zu trainieren, etwa durch sogenanntes Preference Tuning. Vertrauenswürdigkeit und Selbstreflexion von LLMs Ein weiterer kritischer Aspekt ist die Fähigkeit der Modelle, die eigene Antwortqualität realistisch einzuschätzen und angemessene Unsicherheiten zu kommunizieren. In Tests mit verbalisierter Einschätzung ihrer Konfidenz zeigten sich gemischte Ergebnisse: Einige Modelle gaben selbst bei falschen Antworten sehr hohe Sicherheit an, was in sicherheitsrelevanten Anwendungen zu Fehlinformationen und Fehlentscheidungen führen kann. Dieses Phänomen verweist auf die Notwendigkeit, zukünftige Systeme mit Mechanismen auszustatten, die eine zuverlässige Abschätzung von Unsicherheit ermöglichen oder die Nutzer direkt über mögliche Fehlerquellen informieren. Dies ist besonders relevant, wenn LLMs als Co-Piloten für Chemiker fungieren sollen.

Bedeutung für Chemieausbildung und Forschung Die Tatsache, dass KI-Modelle in der Lage sind, viele typischen Prüfungsfragen der Chemie besser zu beantworten als Menschen, hat weitreichende Konsequenzen für die akademische Lehre. Klassische Prüfungsformate, die stark auf Faktenwissen und mechanische Anwendung von Regeln setzen, sind für LLMs einfacher als für viele Studenten. Daraus ergibt sich die Forderung, die Chemieausbildung stärker auf kritisches Denken, komplexe Argumentation und experimentelle Fähigkeiten auszurichten. Zudem könnten LLMs als wertvolle Werkzeuge in der Forschung genutzt werden, indem sie als schnelle Nachschlagewerke fungieren, Hypothesen generieren oder Literaturzahlen zusammenfassen. Dennoch muss die Rolle der menschlichen Expertise erhalten bleiben, um Fehler der Modelle auszuschließen und die ethische Verantwortung zu gewährleisten.

Sicherheit, Ethik und zukünftige Entwicklungen Neben den rein wissenschaftlichen Aspekten müssen auch Sicherheits- und Ethikfragen berücksichtigt werden. Die Möglichkeit, dass LLMs missbräuchlich zur Entwicklung gefährlicher Substanzen oder zur Verbreitung fehlerhafter Sicherheitsinformationen genutzt werden könnten, erfordert klare Richtlinien und Kontrollmechanismen. Zukünftige Entwicklungen könnten die Integration spezialisierter medizinisch-chemischer Datenbanken in die LLM-Architektur einschließen, damit Modelle auf aktuell validierte Informationen zugreifen können. Ebenso könnte die Kombination von LLMs mit physikalisch-chemischen Simulationswerkzeugen die Qualität der Aussagen verbessern. Fazit Große Sprachmodelle sind in der Lage, viele Aspekte chemischen Wissens und chemischer Argumentation zu erfassen und zeigen in speziellen Benchmark-Tests eine teils übermenschliche Leistungsfähigkeit.

Gleichzeitig bestehen klar definierte Schwächen, vor allem beim faktenbasierten Wissen, bei Sicherheitsaspekten, in der Modellierung chemischer Intuition und bei der Abschätzung eigener Unsicherheiten. Diese Ergebnisse verdeutlichen, dass LLMs die Arbeitsweise von Chemikern ergänzen, aber nicht ersetzen können. Sie stellen wertvolle Werkzeuge dar, die den Zugang zu Information erweitern und Routinearbeiten erleichtern. Gleichzeitig erfordern sie das kritische Urteilsvermögen von Experten, um Fehler zu vermeiden und einen sicheren sowie verantwortungsvollen Einsatz zu gewährleisten. Die Chemie steht am Beginn einer neuen Ära, in der die enge Zusammenarbeit zwischen menschlicher Expertise und künstlicher Intelligenz das volle Potenzial beider Welten entfaltet.

Die fortlaufende Evaluation, Verbesserung und verantwortungsvolle Implementierung von LLMs wird entscheidend sein, um die Zukunft der Chemie nachhaltig und sicher zu gestalten.