In der modernen Softwareentwicklung spielen Microservices eine zentrale Rolle bei der Schaffung skalierbarer, wartbarer und leistungsfähiger Anwendungen. Besonders die Programmiersprache Go etabliert sich als Favorit für die Entwicklung von Microservices, nicht zuletzt wegen ihrer effizienten Concurrency-Modelle, sparsamen Speicherverwaltung und der Kompilierbarkeit, die zu schneller Ausführung führt. Dennoch stellt die Optimierung von Go-Microservices hinsichtlich niedriger Latenzzeiten und hoher Durchsatzkapazitäten eine anspruchsvolle Aufgabe dar, die sowohl technische Finesse als auch strategisches Vorgehen erfordert. Die Balance zwischen der schnellen Bearbeitung einzelner Anfragen und der Verarbeitung großer Mengen an gleichzeitig eingehenden Anfragen beeinflusst entscheidend die Benutzererfahrung und Skalierbarkeit der Systeme. Latenz und Durchsatz sind zentrale Leistungskennzahlen im Kontext von Microservices.

Latenz bezeichnet die Zeit, die ein Service benötigt, um eine einzelne Anfrage zu bearbeiten, während Durchsatz die Anzahl der erfolgreich verarbeiteten Anfragen pro Sekunde widerspiegelt. Häufig steht die Optimierung der einen Metrik der anderen gegenüber, weshalb es essenziell ist, verschiedene Techniken zu kombinieren, um das Optimum für die jeweilige Anwendung zu erreichen. Go bietet mit seiner nativen Unterstützung für Goroutinen und Channels eine ideale Grundlage für asynchrone und parallele Verarbeitung von Anfragen, wodurch sich signifikante Verbesserungen erzielen lassen. Konkret ermöglichen Goroutinen das Starten von vielen leichten, parallelen Ausführungseinheiten mit geringem Overhead. Kombiniert mit effektiven Synchronisationsmechanismen wie dem WaitGroup-Pattern, lassen sich Anfragen effizient und gleichzeitig bearbeiten, was sowohl Latenz reduziert als auch den Durchsatz erhöht.

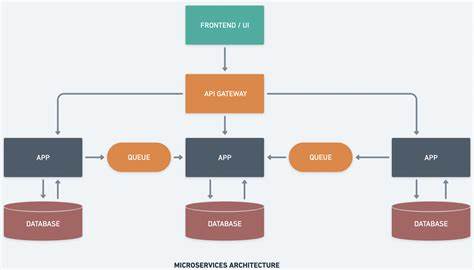

Eine bewährte Methode zur Steuerung des nebenläufigen Zugriffs auf Ressourcen ist die Implementierung eines Worker-Pools. Dadurch kann verhindert werden, dass das System durch zu viele parallele Prozesse überlastet wird. Der Worker-Pool beschränkt die Anzahl an gleichzeitig arbeitenden Goroutinen, indem Arbeitsaufträge in einem Queue gesammelt und kontrolliert abgearbeitet werden. Ein durchdachtes Pool-Design trägt maßgeblich dazu bei, Ressourcen effizient zu nutzen und „thundering herd“-Probleme zu vermeiden, die bei hoher Parallelität oft auftreten. Neben dem grundsätzlichen Design und dem Concurrency-Modell spielt der Einsatz von Redis eine Schlüsselrolle bei der Optimierung von Go-Microservices.

Redis fungiert als extrem schneller In-Memory-Datenspeicher mit einer Vielzahl von Einsatzmöglichkeiten, die darauf ausgelegt sind, Latenzzeiten drastisch zu senken und den Durchsatz zu steigern. Am einfachsten lässt sich Redis als Cache implementieren, wodurch häufig abgerufene Daten aus speicherresidenten Strukturen und nicht von deutlich langsameren Datenbanken stammen. Durch den Einsatz von Multi-Level-Caches, bei denen Redis als verteilte Cache-Ebene mit lokaler In-Memory-Cacheschicht (beispielsweise mithilfe von Bibliotheken wie Ristretto) kombiniert wird, lassen sich Antwortzeiten auf Mikrosekundenebene realisieren. Darüber hinaus eignet sich Redis hervorragend für Rate Limiting, eine essenzielle Funktion zum Schutz von Microservices vor Überlastung. Durch die Nutzung von Redis Sorted Sets kann die Anzahl der Anfragen pro Nutzer, IP-Adresse oder anderen Kriterien in definierten Zeitfenstern überwacht und begrenzt werden.

Diese Technik verhindert den Missbrauch von Services und sorgt für Stabilität unter hoher Last. Redis bietet auch verteilte Locking-Mechanismen, die in Microservice-Systemen unabdingbar sind, wenn mehrere Instanzen konkurrierend auf die gleichen Ressourcen zugreifen. Das Verwenden von Locking mit SETNX-Befehlen in Redis sorgt für zuverlässige Zustandsverwaltung, ohne dass dabei komplexe Koordinationsdienste benötigt werden. Das sogenannte „Redlock“-Pattern ist dabei eine verbreitete Praxis, um Locks auch in hochverteilten Umgebungen ausfallsicher zu gestalten. Ein weiterer Anwendungsfall von Redis in der Microservice-Architektur ist die Nutzung von Pub/Sub-Messaging für die Interprozesskommunikation.

Die schnelle, entkoppelte Auslieferung von Nachrichten zwischen einzelnen Microservices wird durch Redis Pub/Sub realisiert, was zeitkritische Kommunikationsflüsse, wie beispielsweise in Event-Driven-Architekturen, stark beschleunigt. Dabei wird durch asynchrone Verarbeitung die Latenz weiter reduziert und Skalierbarkeit erhöht. Abgesehen von Redis sollte der Entwicklungsprozess auch die Optimierung des Speichermanagements in Go berücksichtigen. Objekt-Pooling zum Beispiel ist eine bewährte Technik, um den Druck auf den Garbage Collector zu minimieren, indem häufig verwendete Objekte wiederverwendet statt neu allokiert werden. Das kann gerade bei kurzlebigen Strukturen, wie Buffern oder Webrequest-Händlern, signifikante Performancegewinne bringen.

Im Zusammenspiel mit bewusster Vermeidung unnötiger Speicherallokationen lassen sich Garbage-Collection-Pausen reduzieren, was sich direkt auf die Latenzzeit niederschlägt. Auch die Optimierung der Netzwerkkommunikation ist für Go-Microservices von großer Bedeutung. Der Einsatz von Connection Pooling bei HTTP-Clients und Datenbankverbindungen vermeidet teure Verbindungsaufbauten und reduziert dadurch die Kommunikationslatenz erheblich. Moderne Protokolle wie HTTP/2 und insbesondere gRPC bieten darüber hinaus durch Features wie Multiplexing, Header-Kompression und binäres Übertragungsformat eine deutlich höhere Effizienz gegenüber klassischen REST-Over-HTTP-1.1-Verbindungen.

Die Datenbankinteraktion stellt häufig einen Flaschenhals im Microservice-Stack dar. Effizientes Management der Datenbankverbindungen ist daher essenziell. Die richtigen Pooling-Parameter verhindern die Erschöpfung von Datenbankressourcen und ermöglichen stabile Antwortzeiten. Zudem kann Batch-Processing in der Datenbankabfrage, beispielsweise beim Einfügen oder Aktualisieren von Datensätzen in größeren Mengen, Netzwerk-Turnarounds reduzieren und die Gesamtperformance erhöhen. Auf Systemebene helfen CPU-Profiling und das gezielte Tuning von Betriebssystemparametern dabei, Leistungsengpässe aufzudecken und auszuräumen.

Profiling-Tools wie Go's pprof ermöglichen Entwicklern, Hotspots im Code zu identifizieren, während Anpassungen an Systemeinstellungen wie der Erhöhung von Netzwerksocket-Puffergrößen und Warteschlangenlängen (etwa durch sysctl-Parameter) hohe Lasten besser abfedern können. Der Einsatz eines Service Mesh in Kombination mit intelligentem Load Balancing erweitert die Resilienz und Flexibilität von Microservices, indem Anfragen dynamisch zu weniger belasteten Instanzen geleitet werden. Ebenfalls integrierte Circuit Breaker schützen Services vor Ausfällen benachbarter Komponenten und tragen insgesamt zu einer höheren Stabilität und optimierten Antwortzeiten bei. Monitoring und Observability sind unerlässlich, um die Performance von Microservices kontinuierlich zu überwachen. Metriken über Anfragestatus, Antwortzeiten und Systemressourcen bieten Einblick in reale Betriebsbedingungen und dienen als Grundlage für fundierte Optimierungsentscheidungen.

Insbesondere die Überwachung von Redis-Systemen bezüglich Speicherverbrauch, Operationen pro Sekunde und Cache-Hits ermöglicht eine genaue Justierung der Caching-Strategien und verhindert Engpässe. Benchmarking und Lasttests sind weitere wichtige Werkzeuge, um die Auswirkungen von Änderungen objektiv zu beurteilen. Durch systematische Messungen in kontrollierten Umgebungen können Optimierungsmaßnahmen validiert und potenzielle Regressionen frühzeitig erkannt werden. Letztlich ist die Optimierung von Go Microservices für niedrige Latenz und hohen Durchsatz ein fortlaufender Prozess, der strategisches Denken, technisches Know-how und sorgfältige Messungen erfordert. Die Kombination von Go's nativen Sprachfeatures mit Redis als vielseitiges Performance-Tool ermöglicht es, mikroservicebasierte Systeme skalierbar, reaktionsschnell und robust zu gestalten.

Durch die individuelle Anpassung der vorgestellten Techniken an konkrete Anwendungsfälle lassen sich signifikante Verbesserungen erzielen, die sowohl die Nutzerzufriedenheit steigern als auch die Betriebskosten reduzieren.