Im digitalen Zeitalter hat die Informationskontrolle eine entscheidende Bedeutung für den wirtschaftlichen Erfolg von Unternehmen und auch für geopolitische Strategien gewonnen. Große Sprachmodelle, wie sie in der künstlichen Intelligenz (KI) eingesetzt werden, revolutionieren dabei nicht nur die Kommunikations- und Produktionsprozesse, sondern bieten auch neue Werkzeuge für industrielle Sabotage. Durch den Einsatz von KI-generierter Desinformation entstehen heute Bedrohungen, die weit über klassische Spionage oder Marktbetrug hinausgehen und die gesamte Industrie- und Wirtschaftswelt fundamental verändern können. In der Vergangenheit war die aktive Beeinflussung von Informationsflüssen vor allem das Metier staatlicher Geheimdienste, wie es zum Beispiel die KGB-aktive Maßnahmeeinheit in der Zeit des Kalten Krieges gezeigt hat. Damals wurden gefälschte Unternehmensberichte oder dezidierte Geheimdokumente gestreut, um Konkurrenten zu schwächen oder Investoren zu verunsichern.

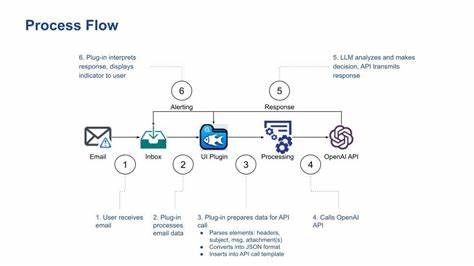

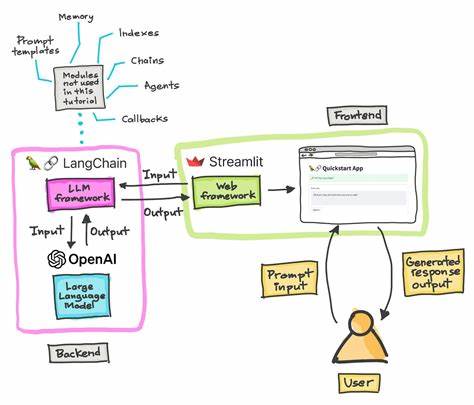

Heute bildet die Digitalisierung und insbesondere die Fortschritte bei großen Sprachmodellen einen Quantensprung in der automatisierten Herstellung von „Wahrheit durch Täuschung“. Mit geringem Aufwand können falsche Daten, manipulierte Studien oder fingierte Online-Präsenzen erzeugt werden, die den Anschein von Seriosität erwecken und darauf abzielen, strategische Fehlentscheidungen bei Wettbewerbern auszulösen. Die Macht der Skalierung ist hierbei besonders besorgniserregend. Wo einst ein Team von Operativen monatelang Fehlinformationen vorbereiten musste, genügen heute wenige Mausklicks oder API-Aufrufe, um massenhaft täuschend echte Inhalte zu generieren. Diese automatisch erstellten Texte, gefälschten Forschungsarbeiten oder manipulierten Social-Media-Profile verbreiten sich in Windeseile und schaffen eine heterogene, scheinbar vielfältige Informationswelt, die tatsächlich von einer einzigen verzerrten Wahrheit gelenkt wird.

Dieses Phänomen der „verwalteten Pluralität“ sorgt dafür, dass die Grenze zwischen Wahrheit und Lüge zusehends verschwimmt und zugleich die Effektivität von Gegenmaßnahmen erschwert wird. Die finanzielle Dimension verstärkt die Gefahr zusätzlich. Der Einsatz künstlicher Intelligenz zur Desinformation ist vergleichsweise günstig und bietet potenziell enorme Renditen. Wird es etwa geschafft, mit gefälschten Benchmarks Manager zu Fehlentscheidungen zu verleiten oder Investoren mit manipulierten Statistiken zu täuschen, können ganze Produktlinien oder Geschäftsbereiche Schaden nehmen – bis hin zu einem nachhaltigen Vertrauensverlust in Marken und Märkte. Staaten wie China setzen bereits aktive Forschungsressourcen darauf, frei zugängliche Sprachmodelle wie Metas Llama für soziale Bot-Netzwerke und Einflussoperationen zu nutzen.

Angreifer können somit mit geringem finanziellen Aufwand strategische Vorteile erzielen, die weit über das investierte Kapital hinausgehen. Die Illusion der Wahrheit, wie sie Joseph Goebbels einst formulierte, wird durch LLMs verstärkt. Diese Technologie verbindet eine überzeugende Erzählweise mit der Fähigkeit, sowohl wahre als auch erfundene Fakten nahtlos zu vermischen. Das Ergebnis ist eine informationsökologische Situation, in der objektive Wahrheiten zugunsten manipulierter Narrativen ausgehöhlt werden. Hannah Arendts Beobachtung, dass Fakten ihre Bedeutung verlieren, wenn sie mit Lügen vermengt werden, trifft heute stärker denn je zu – denn Sprachmodelle produzieren oft eine Mischung aus fundierten Zusammenfassungen und auf Halbwahrheiten oder sogar reinen Fiktionen basierenden Informationen.

Dazu kommt, dass viele Nutzer und vor allem Führungskräfte unkritisch den Worten moderner KI-Systeme vertrauen, weil deren Ausgaben flüssig und technisch überzeugend klingen. Untersuchungen zeigen, dass Menschen dazu tendieren, Informationen als wahr anzunehmen, solange keine starken Zweifel ausgelöst werden – das sogenannte Truth-Default-Theory-Prinzip. Sprachmodelle nutzen dieses Prinzip, indem sie selbst bei falschen Aussagen Sicherheit und Überzeugung ausstrahlen. So werden Fehlinformationen nicht nur produziert, sondern gelangen dank der menschlichen Psychologie schnell in Entscheidungsprozesse, insbesondere wenn Zeitdruck oder mangelnde Fachkenntnis bestehen. Ein besonders gefährliches Szenario ergibt sich, wenn Manager oder Produktverantwortliche KI-Ausgaben ungeprüft als belastbare Fakten einbeziehen.

In Einzelfällen haben sich Unternehmensentscheidungen auf halluzinierte Zahlen von KI-Systemen gestützt, was immense wirtschaftliche Schäden zur Folge haben könnte. Die Bereitschaft, KI-Daten Glauben zu schenken, wird oft durch die Bestätigung eigener Vorannahmen noch verstärkt. Das Zusammenspiel dieser Faktoren schafft ein hochriskantes Umfeld für industrielle Sabotage, dessen Auswirkungen heute noch unterschätzt werden. Technologischer Fortschritt macht darüber hinaus auch Manipulationen im Bereich von Medieninhalten und Kommunikation einfacher. Deepfakes, also KI-generierte realistisch wirkende Fälschungen von Audio- und Videoinhalten, ermöglichen es, Entscheidungsträger oder Öffentlichkeit mit gefälschten Botschaften in die Irre zu führen.

So könnten etwa fingierte Videos eines Vorstandsmitglieds, das negative Aussagen über Zukunftsstudien oder Technologiefähigkeiten trifft, Marktkurse beeinflussen oder Unternehmensreputation beschädigen. Gegen diese neuen Bedrohungen sind traditionelle Methoden wie journalistische Faktenprüfung oder regulatorische Kontrollen nur begrenzt effektiv. Die schiere Menge an automatisch generierten Inhalten übersteigt bereits heute die Kapazitäten konventioneller Überprüfungsprozesse. Deshalb setzen Experten auf eine mehrschichtige Verteidigungsstrategie, die nicht nur technologische Lösungen, sondern auch menschliches Urteilsvermögen und Bildung umfasst. Eine der wichtigsten technischen Antworten liegt in der Einführung von Herkunftsnachweisen (Provenance-Technologien).

Standards wie das C2PA-Protokoll erlauben es, Inhalte mit kryptographischen Signaturen zu versehen, um Echtheit und Ursprung nachprüfbar zu machen. Allerdings ist die Implementierung und Durchsetzung solcher Verfahren bei großen Plattformen und in öffentlichen Netzwerken bislang mangelhaft. Die schlichte Akzeptanz von Metadaten seitens Benutzer oder Anbieter ist ein Hindernis, das überwunden werden muss, um der Flut sogenannter Fake-News wirksam zu begegnen. Gleichzeitig ist die Förderung von Medienkompetenz und kritischem Denken unerlässlich. Untersuchungen legen nahe, dass Menschen durch gezieltes „Priming“ oder Erziehung darin unterstützt werden können, Informationen skeptischer zu bewerten und die Verbreitung von Fehlinformationen zu reduzieren.

Ein dauerhafter skeptischer Umgang mit Quellen und Daten ist daher nicht nur für Verbraucher wichtig, sondern insbesondere auch für Führungskräfte, die auf fundierte Entscheidungsgrundlagen angewiesen sind. Darüber hinaus wird die Forderung nach Transparenz in der Entwicklung und Nutzung großer KI-Modelle immer lauter. Aktuelle Systeme sind häufig undurchsichtig und optimiert darauf, Nutzer zu überzeugen – nicht unbedingt die Wahrheit darzustellen. Externe Audits, unabhängige Prüfstellen und Offenlegungspflichten wären daher sinnvolle Schritte, um die Risiken von KI-gesteuerter Desinformation zu minimieren. Solche Prüfungen müssen streng, wirklich unabhängig und in der Lage sein, Manipulationen und Fehler im System aufzudecken, um Vertrauen in KI-Technologien auch in sicherheitskritischen Industrien zu gewährleisten.

Adversarielle Tests, die auch gezielt auf das Erkennen und Abwehren von Falschinformationen ausgerichtet sind, können als Teil eines umfassenden Sicherheitskonzeptes helfen. Doch sie bergen die Gefahr, eine „Wettrüstung“ zu initiieren, bei der KI-Systeme immer besser darin werden, Erkennungsmethoden zu umgehen. Dieses Risiko gilt es bei der Entwicklung nationaler und internationaler Strategien gegen industrielle Sabotage zu beachten. Insgesamt zeigt sich, dass LLM-basierte industrielle Sabotage keine ferne Zukunftsmusik ist, sondern eine reale und ansteigende Gefahr darstellt. Die ökonomischen Anreize für manipulative Akteure sind enorm, die technischen Werkzeuge zugänglich und die menschlichen Schwachstellen bekannt.

Die vernetzte Welt macht es einfacher als je zuvor, Desinformation zu verbreiten und Entscheidungen zu beeinflussen – sei es durch staatlich gelenkte Einflussoperationen oder durch Konkurrenten in einem globalisierten Markt. Der Schutz vor solchen Angriffen erfordert eine Kombination aus Technologie, Aufklärung und institutioneller Kontrolle. Unternehmen müssen ihre Strategien anpassen, um verlässliche Datenquellen zu identifizieren und sich gegen klug inszenierte Desinformationskampagnen zu wappnen. Regierungen, Branchenverbände und Plattformbetreiber sind gefragt, um Standards für Transparenz, Verifikation und ethische KI-Nutzung durchzusetzen. Ein besonders wichtiger Aspekt dabei ist die Sensibilisierung von Entscheidungsträgern.

Die Bereitschaft, KI-Ausgaben kritisch zu hinterfragen, ist ein entscheidender Faktor, um die vielfältigen Manipulationsversuche durch automatisierte Systeme zu erkennen und abzuwehren. Nur wer bereit ist, vermeintliche Evidenz nicht verblendet zu akzeptieren, kann das Vertrauen in Märkte und die Stabilität von Unternehmen langfristig schützen. Die Geschichte lehrt uns, dass Lügen, die oft genug erzählt werden, zur gefühlten Wahrheit werden können. Im modernen Kontext der KI-getriebenen Informationsanarchie ist dieser Mechanismus deshalb so wirkmächtig, weil künstliche Intelligenz die Herstellung und Verbreitung dieser Lügen auf ein beispielloses Niveau hob. Der Wettlauf um die Kontrolle der Wahrheit hat längst begonnen.

Es liegt nun an Wirtschaft, Technologie und Gesellschaft, die richtigen Abwehrmaßnahmen zu finden, um den Missbrauch von LLMs in industrieller Sabotage zu verhindern und eine fundierte, faktenbasierte Entscheidungsgrundlage zu sichern.