Meta Platforms, ehemals bekannt als Facebook, hat mit der Einführung seines Llama API Service einen bedeutenden Schritt hin zum Aufbau eines eigenen Cloud-Angebots gemacht. Damit positioniert sich das Unternehmen nicht nur als führender Entwickler von sozialen Netzwerken, sondern auch als ernstzunehmender Anbieter im Bereich der Künstlichen Intelligenz (KI) und Cloud-Services. Der neue Service ermöglicht es Unternehmen und Entwicklern weltweit, auf die leistungsstarken Llama-4-Sprachmodelle zuzugreifen, ohne große eigene Infrastruktur aufbauen zu müssen. Damit schafft Meta einen innovativen Zugang zu KI-Anwendungen und verstärkt seine Rolle als Technologiekonzern weit über das soziale Netzwerk hinaus.Die Geschichte von Meta und der Weg zum Llama API Service ist eng mit der Philosophie der Offenheit und Open Source verbunden.

Meta hat in den vergangenen Jahren immer wieder wichtige Infrastrukturkomponenten, etwa Rechenzentrumsdesigns, Speichersysteme und Softwareframeworks, als Open Source veröffentlicht und damit zur Demokratisierung von Technologie beigetragen. Mit der Llama-Modellfamilie setzt Meta diese Tradition fort. Bereits 2023 wurden Llama 1 und 2 freigegeben, was der Entwickler-Community den Zugang zu leistungsfähigen, quelloffenen Sprachmodellen ermöglichte. Die Ankündigung auf der LlamaCon 2025, nun auch ein API-Service anzubieten, der Llama 4 als bezahlten Dienst verfügbar macht, bedeutet eine kommerzielle Erweiterung mit großer strategischer Bedeutung.Der Llama API Service von Meta ist mehr als nur ein weiterer KI-Dienstleister im Markt.

Er markiert den Eintritt des Unternehmens in das Cloud-Geschäft, eine Domäne, die bislang von Hyperscalern wie Amazon Web Services, Microsoft Azure oder Google Cloud dominiert wird. Meta, das bisher vor allem als Betreiber riesiger Rechenzentren für seine eigenen Plattformen bekannt war, wird mit dem API-Service nun selbst zum Anbieter von Cloud-Computing und KI-Diensten. Dieser Schritt verwandelt Meta in einen „Platform Cloud“-Anbieter, der nicht nur Infrastruktur bereitstellt, sondern auch die Software und Modelle, die Entwickler nutzen, um KI in ihren Anwendungen zu integrieren.Einer der wichtigsten Vorteile des Llama API Services liegt in der Kombination aus hoher Leistungsfähigkeit und geringer Kostenbelastung. Die neuesten Llama 4 Modelle, insbesondere die Varianten Maverick und Scout, laufen auf Meta-eigener Hardware sowie auf Infrastruktur von Partnern wie Cerebras Systems und Groq.

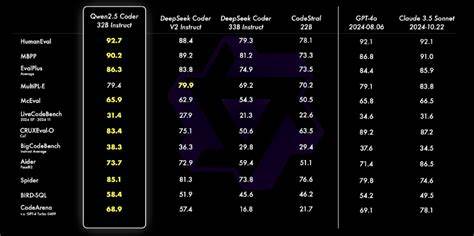

Diese Zusammenarbeit sichert eine skalierbare und effiziente Verarbeitung hochwertiger multimodaler KI-Modelle, die Text, Bild, Video und Audio interpretieren können. Im Vergleich zu Konkurrenzangeboten wie OpenAI oder Googles Gemini-Modelle punktet Llama insbesondere mit einem attraktiven Kostenverhältnis: Die Preise pro verarbeitetem Token liegen deutlich unter denen der Wettbewerber, bei ähnlicher oder sogar besserer Performance in diversen Benchmark-Tests.Technologisch basiert Llama 4 auf einem komplexen Expertenmodell-Ansatz, der es ermöglicht, teilweise sehr große Modelle mit bis zu zwei Billionen Parametern effektiv und performant zu betreiben. Dabei fungiert der größte Variante, „Behemoth“, als eine Art Lehrer-Modell, das kleinere Modelle mit aktiven und speziell optimierten Komponenten trainiert und auf bestimmte Einsatzbereiche zuschneidet. Diese Effizienzsteigerung macht Llama genau für Unternehmen interessant, die hohe Ansprüche an Kontextlänge und Vielseitigkeit stellen, zum Beispiel durch extrem lange Eingabekontexte oder multimodale Datenintegration.

Formale Prüfungen zeigen, dass Llama 4 besonders in den Varianten Maverick und Scout somit geeignet ist, komplexe Aufgaben zu bewältigen, ohne die ansonsten exorbitanten Rechenkosten herkömmlicher Großmodelle zu verursachen.Neben technologischen Faktoren spielt die Strategie, die API als Pay-per-Use-Dienst anzubieten, eine zentrale Rolle bei der Kommerzialisierung des Llama-Stacks. Dies gibt Entwicklern und Unternehmen großen Handlungsspielraum: Statt eine eigene, teure KI-Infrastruktur aufbauen zu müssen, können sie die leistungsfähigen Llama-Modelle flexibel nutzen und lediglich für das bezahlen, was sie tatsächlich verbrauchen. Dieses Modell unterstützt auch Startups und kleinere Firmen dabei, Zugang zu fortgeschrittenster KI-Technologie zu erhalten, ohne die klassischen Investitionshürden. Die potenziellen Effekte für die KI-Entwicklung und den Wettbewerb sind enorm, da offene, zugängliche und dennoch professionelle KI-Modelle die Innovationskraft einer viel breiteren Nutzergemeinde fördern.

Eine wichtige Besonderheit ist Meta Platforms' Verpflichtung zu Open Source und Community-Einbindung. Während viele führende KI-Anbieter ihre Modelle weitgehend proprietär halten, setzt Meta auf Transparenz und Rückkopplung mit Softwareentwicklern. Dieser Ansatz erhöht nicht nur die Sicherheit durch Prüfung im „Licht der Öffentlichkeit“, sondern fördert auch kontinuierliche Verbesserungen und Anpassungen an verschiedene Anwendungsfälle. Offene Modelle können einfacher ausgerichtet, getunt und angepasst werden. Diese Flexibilität wird gerade von Unternehmen geschätzt, die eigenen Datenschutzanforderungen oder spezifische Branchenbedürfnisse gerecht werden müssen.

Meta hebt damit die Open-Source-KI nicht nur als technisches Konzept hervor, sondern positioniert sie als nachhaltiges Geschäftsmodell.Auch finanziell eröffnet der Llama API Service für Meta einen neuen Einnahmenzweig neben dem bislang extrem werbefokussierten Geschäftsmodell. Derzeit stammen über 97 Prozent der Umsätze des Konzerns aus Werbung. Mit der Entwicklung eines eigenen Cloud-Angebots, das KI-Entwicklern und Unternehmen direkt zur Verfügung steht, verschiebt sich das Geschäftsprofil langfristig. Praktisch kann es sein, dass Meta in den kommenden Jahren diesen Teil als eigenen Umsatz- und Gewinnbereich ausweisen muss, sobald er eine relevante Größenordnung erreicht.

So könnte das Llama Cloud-Geschäft den Konzern unabhängiger von Werbeeinnahmen machen und die Investitionen in AI-Infrastruktur und Softwareentwicklung langfristig absichern.Der Wettbewerb wird dabei härter, denn Meta mischt sich nun in ein Terrain ein, das von OpenAI, Google, Microsoft und weiteren spezialisierten Firmen prägend gestaltet wird. Allerdings hat Meta einen entscheidenden Vorteil: das tiefe technische Know-how, die langjährigen Erfahrungen als Hyperscaler mit eigener Hardware und den Flair für Open Source als Wachstumstreiber. Zudem bleibt die Anbindung an populäre Frameworks wie PyTorch und Programmiersprachen wie Python durch Meta-Entwickler gewährleistet, was es Entwicklern leicht macht, den Llama API Service in bestehende Softwarelandschaften zu integrieren.Insbesondere die Integration der Spitzentechnologien von Cerebras und Groq in den API-Betrieb weist auf eine technische Offenheit hin, die andere Anbieter nicht ohne Weiteres aufweisen.

Während die meisten Cloud-Unternehmen weitgehend auf GPU-Infrastruktur setzen, erweitern Meta und Partner die Hardwarebasis gezielt mit spezialisierten KI-Beschleunigern, um Skalierbarkeit und Effizienz weiter zu erhöhen. Dies könnte dazu führen, dass Meta nicht nur in Bezug auf Kostenstruktur, sondern auch bei der Latenz und Geschwindigkeit der KI-Dienste Vorteile gegenüber der Konkurrenz hat. Für Endkunden bedeutet das bessere Performance bei zugleich attraktiveren Preisen.Der Wandel, den Meta mit dem Llama API Service einläutet, ist aber nicht nur für Meta selbst bedeutsam, sondern für den gesamten KI-Markt und die Cloud-Industrie. Für Unternehmen bedeutet die cloudbasierte Verfügbarkeit von offenen, aber technisch hochentwickelten LLMs, dass Kollaborationsmöglichkeiten und Innovationsspielräume auf einem neuen Niveau erschlossen werden.

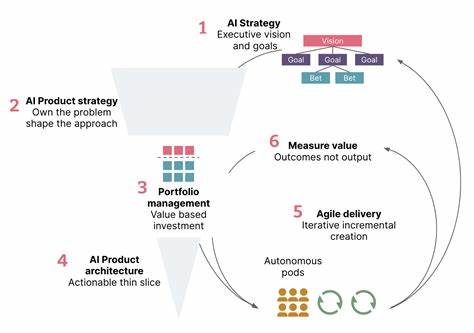

Die Grenzen zwischen internen KI-Forschungsabteilungen und externem KI-Zugriff verwischen. Gleichzeitig öffnet Meta die Türen für Entwickler aus aller Welt, was insbesondere in aufstrebenden Märkten neue Chancen bieten kann, KI sinnvoll zu nutzen, ohne hohe Eintrittshürden zu überwinden.Meta abseits seines traditionellen Kerngeschäfts investiert damit in eine Zukunft, in der KI nicht nur unterstützende, sondern zentrale Technologie in Software- und Geschäftsprozessen wird. Der Aufbau einer eigenen Plattform Cloud mit dem Fokus auf KI ist Ausdruck eines langfristigen strategischen Plans. Es zeigt auch, dass Meta die Bedeutung von Open Source für die Sicherheit, Transparenz und Skalierbarkeit von KI erkannt hat.

In einem Feld, in dem Datenschutz, ethische Fragestellungen und Konkurrenzdruck massiv wachsen, können offen zugängliche, aber kommerziell betriebene KI-Dienste zum Erfolgsmodell werden.Damit steht Meta nicht nur neben Google, Microsoft und Amazon als weiterer Cloud-Anbieter. Das Unternehmen definiert das Spielfeld neu, indem es Technologieoffenheit, Leistungsfähigkeit und günstige Preise verbindet. Der Llama API Service markiert einen Paradigmenwechsel, von einem werbefinanzierten Social-Media-Riesen hin zu einem Tech-Ökosystem mit starkem KI-Schwerpunkt und Cloud-Dienstleistungen. Für viele Entwickler und Firmen weltweit dürfte dies bald eine wichtige Option sein, um die Kraft der Künstlichen Intelligenz für eigene Produkte und Services zu nutzen – ohne selbst ein Datacenter betreiben zu müssen.

In der dynamisch wachsenden AI-Landschaft hat Meta so einen festen Fuß in der Tür zum lukrativen und zukunftsweisenden Cloud-Geschäft.