Generative Künstliche Intelligenz (GenAI) hat das Potenzial, Unternehmen in verschiedensten Branchen grundlegend zu verändern. Von automationsunterstützten Arbeitsprozessen bis hin zu intelligenten Assistenzsystemen eröffnen sich völlig neue Möglichkeiten, die Effizienz und Innovationskraft von Organisationen zu steigern. Trotz der vielversprechenden Technologie berichten jedoch rund 80 Prozent der Unternehmen von fehlenden spürbaren Ergebnissen bei der Einführung von GenAI-Anwendungen auf Unternehmensebene. Ein zentraler Grund dafür liegt nicht selten in der Art und Weise, wie Tech-Teams strukturiert sind, um diese komplexen und oft neuartigen Aufgaben zu bewältigen. Um ambitionierte GenAI-Features erfolgreich zu entwickeln und zu skalieren, bedarf es einer überlegten Organisationsstruktur, die sowohl die technischen als auch die prozessualen Besonderheiten dieser Innovationen berücksichtigt.

Generative KI-Projekte unterscheiden sich grundlegend von traditionellen Softwareentwicklungen oder klassischen Machine Learning-Initiativen. Während einfache API-Integration auf den ersten Blick schnell umzusetzen scheint, offenbaren sich bei der produktiven Nutzung der Modelle viele Herausforderungen. Die Komplexität der Ausgaben von großen Sprachmodellen (LLMs) erfordert sorgfältige Maßnahmen in puncto Genauigkeit, Robustheit und Sicherheit. So wird die vermeintliche Leichtigkeit, mit der LLM-Funktionen prototypisch umgesetzt werden können, schnell durch die Notwendigkeit komplexer Evaluationsmechanismen und enger Qualitätskontrollen relativiert. Vor allem die präzise Formulierung von Eingaben – das sogenannte Prompt Engineering – nimmt einen immer höheren Stellenwert ein.

Es ersetzt gewissermaßen das klassische Feature Engineering und verlangt die Fähigkeit, fachliche Anforderungen verständlich und exakt in klare Anweisungen für das Modell zu übersetzen. Diese Disziplin ist entscheidend, um die Potenziale von GenAI ohne kostenintensive Feinabstimmungen zu heben. Die Bewertung der LLM-Ausgaben gestaltet sich dagegen als besonders schwierig. Klassische Metriken der Machine Learning-Welt, wie Präzision oder Genauigkeit, lassen sich auf freie Textantworten kaum sinnvoll anwenden. Stattdessen müssen Kriterien definiert werden, was eine passende Antwort ausmacht, und manuelle Evaluierungen durch Fachexperten sind oft unverzichtbar, jedoch mit hohen Kosten verbunden.

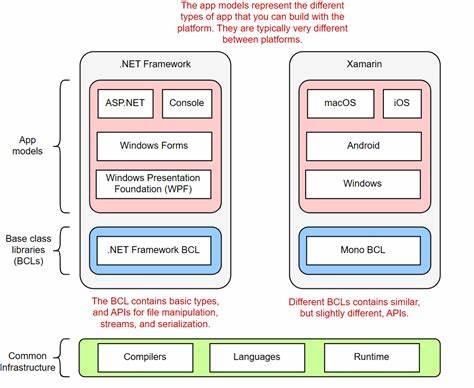

Die Automatisierung der Qualitätskontrolle durch LLMs selbst bringt zwar Effizienzvorteile, ist allerdings weniger verlässlich. Diese Komplexität der Evaluation macht spezialisierte Tools und Fachwissen unumgänglich. Ein weiterer entscheidender Faktor ist die Notwendigkeit spezialisierter Werkzeuge und Governance-Strategien. Architekturkomponenten wie Agenten-Orchestrierung, Retrieval-Augmented Generation (RAG) Pipelines und Vektor-Einbettungen verlangen eine Schnittstellenkompetenz an der Schnittstelle von Machine Learning, Softwareentwicklung und Data Engineering. Gleichzeitig entstehen neue Risiken, darunter sogenannte Prompt Injection-Angriffe oder Halluzinationen der Modelle, die gezielt adressiert werden müssen.

Darüber hinaus schränken regulatorische Anforderungen wie Datenschutzrichtlinien die Nutzung externer Modelle insbesondere in sensiblen Branchen ein und erfordern einen bewussten Umgang bei der Integration. Vor dem Hintergrund dieser vielschichtigen Herausforderungen hat sich eine neue Rolle innerhalb von Tech-Teams etabliert: die des AI Engineers. Aufbauend auf der Tradition des ML Engineers, der als Bindeglied zwischen Data Science und Softwareentwicklung fungierte, erweitert der AI Engineer sein Kompetenzspektrum um spezielle Kenntnisse der GenAI-Werkzeuge und -Prozesse. Während ML Engineers den Brückenschlag zwischen Forschung und produktiver Nutzung von Modellen realisieren, fokussieren sich AI Engineers auf die Fingerfertigkeit in der Handhabung von LLM-spezifischen Entwicklungsmethoden, Monitoring und Evaluationsframeworks. Sie agieren als Experten, die das Zusammenspiel von anspruchsvollen AI-Technologien und reibungslosen, skalierbaren Produktprozessen gewährleisten.

Jedoch stellt sich die Frage, ab wann die Einbindung eines dedizierten AI Engineers zwingend notwendig wird. Große und technologisch fokussierte Organisationen profitieren klar von spezialisierten Rollen, um anspruchsvolle Projekte mit hohem Zuverlässigkeitsanspruch zu realisieren. Andererseits können kleinere Unternehmen oder Teams mit allgemeinen ML- oder Datenfähigkeiten teilweise selbstständig einfache, risikoarme GenAI-Funktionen umsetzen. Die Zuordnung hängt dabei maßgeblich von zwei Kriterien ab: dem erforderlichen Level an Zuverlässigkeit des Features und dem Umfang des zu lösenden Problems. Je höher die Anforderungen hinsichtlich Fehlerfreiheit und der Komplexität der Problemstellung sind, desto stärker wächst die Notwendigkeit, Experten von AI Engineers einzubeziehen.

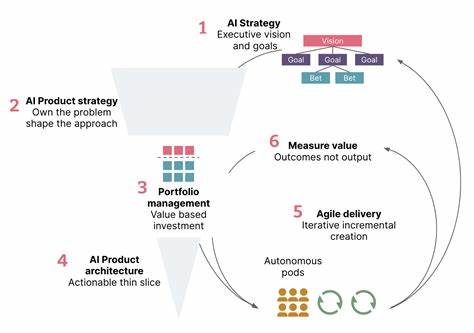

Eine viel diskutierte organisatorische Frage betrifft die optimale Verteilung der AI-Kompetenz im Unternehmen. Traditionell stehen zwei Ansätze im Vordergrund: Eine zentrale AI-Einheit, die gesamtunternehmensweite Standards definiert und ambitionierte, bereichsübergreifende Projekte steuert, oder eine dezentrale Struktur, in der AI-Fachkräfte direkt in Produktteams eingebettet sind. Zentralisierte Teams sorgen für kohärente Infrastruktur und Qualitätssicherung, laufen jedoch Gefahr, zur Engstelle für die Produktentwicklung zu werden. Dezentrale Teams profitieren von engerem Austausch mit Fachbereichen, schnelleren Iterationen und größerer Proaktivität, kämpfen jedoch mit uneinheitlichen Vorgehensweisen und redundanten Lösungen. Einen vielversprechenden Kompromiss stellt eine hybride Organisationsform dar, die die Vorteile beider Welten kombiniert.

In diesem Modell erhalten produktfokussierte Teams – insbesondere solche mit langfristigen AI-Initiativen – einen eigenen AI Engineer, der maßgeblich die Entwicklung und Implementierung von hochpriorisierten Use Cases verantwortet. Zeitgleich befähigen zentrale AI-Teams alle übrigen Softwareentwickler, geringfügige oder risikoarme GenAI-Features selbstständig zu realisieren. Die zentrale Einheit fungiert neben der Umsetzung auch als Hüterin von Standards in Bezug auf Evaluation, Tooling und Monitoring. Dadurch werden konsistente Qualitätsmaßstäbe gesetzt und wertvolle Synergien geschaffen, ohne die Agilität in den Produktteams zu blockieren. Die erfolgreiche Umsetzung von GenAI im Unternehmen ist also eng an eine ganzheitliche Betrachtung der Teamstruktur und Rollenverteilung gekoppelt.

Nur durch die Investition in zielgerichtete Spezialisierungen wie die AI Engineers und die gezielte Befähigung weiterer Entwickler gelingt es, das volle Potenzial von Agenten, LLMs und deren komplexen Umgebungen zu heben. Gleichzeitig empfiehlt es sich, gerade bei begrenztem Budget zunächst auf klar abgrenzbare, kleinere Projekte mit messbarem Nutzen zu setzen. Ein schrittweiser Aufbau von Kompetenz und Vertrauen ebnet den Weg für ambitionierte Vorhaben und langfristige Fördermöglichkeiten. Generative AI verändert die Anforderungen an technische Teams grundlegend. Die Kombination aus neuen Rollen, hybriden Organisationsformen und spezialisierten Tools schafft eine Struktur, die Innovationskraft mit Stabilität verbindet.

Unternehmen, die diese Entwicklungen proaktiv gestalten, sichern sich einen entscheidenden Wettbewerbsvorteil auf dem Weg zur digitalen Transformation. Mit klarer Strategie, qualifizierten Mitarbeitern und einer auf GenAI zugeschnittenen Teamorganisation lassen sich ambitionierte Projekte realisieren, die echten Mehrwert für Kunden und Business schaffen.