In der digitalen Welt von heute verändert sich die Art und Weise, wie Menschen mit Technologien interagieren, rasant. Klassische Frontend-Benutzeroberflächen, wie wir sie seit Jahrzehnten kennen – mit visuellen Elementen wie Buttons, Menüs und Formularen –, verlieren zunehmend an Bedeutung. Stattdessen gewinnen Voice User Interfaces (VUI), also sprachgesteuerte Schnittstellen, immer mehr an Bedeutung. Die Kombination aus künstlicher Intelligenz, natürlicher Sprachverarbeitung und leistungsfähigen Backend-Systemen eröffnet vollkommen neue Möglichkeiten für Unternehmen, Entwickler und Nutzer. Es zeichnet sich eine Revolution ab, bei der traditionelle Frontends nicht mehr zwingend notwendig sind, sondern die Steuerung ganzer Systeme immer häufiger per Sprache erfolgt.

Die klassische Frontend-Benutzeroberfläche ist seit frühester PC-Ära das zentrale Element jeder Software oder Webanwendung gewesen. Sie stellt die Brücke zwischen Nutzer und System dar und sorgt für die überschaubare, intuitive Nutzung von Softwarefunktionen. In den letzten Jahrzehnten wurde viel in die Gestaltung und Optimierung von UI (User Interface) investiert. Die visuelle Gestaltung wird seit jeher als entscheidend für die Nutzerfreundlichkeit und Customer Experience angesehen. Doch heute stehen wir an einem Wendepunkt.

Sprachsteuerung und künstliche Intelligenz sind so weit ausgereift, dass die Notwendigkeit klassischer Benutzeroberflächen deutlich schrumpft. Im Kern liegt die Attraktivität von Voice User Interfaces darin, dass sie natürliche Kommunikation ermöglichen. Anstatt komplexe Menüs oder kryptische Bedienungshilfen einzusehen und zu bedienen, genügt es gewöhnlich, Fragen zu stellen, Befehle zu sprechen oder Anfragen zu formulieren – ähnlich wie in einer Unterhaltung mit einem menschlichen Assistenten. Dadurch entfällt die gewöhnliche Lernkurve, die oft mit herkömmlichen Nutzerinterfaces verbunden ist. Auch für Menschen mit motorischen Einschränkungen oder besonderen Bedürfnissen eröffnen VUI völlig neue Barrierenfreiheitspotentiale.

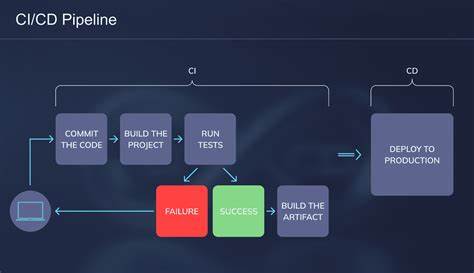

Die natürliche Sprache ist universell und intuitiv. Somit liegt es auf der Hand, dass sich die Interaktion mit Software hin zu sprachgesteuerten Elementen verlagert. Ein wesentlicher Treiber dieses Wandels liegt in der Weiterentwicklung moderner Backend-Architekturen und künstlicher Intelligenz. Während das Frontend bislang den Großteil der Komplexität in der Nutzersteuerung darstellte, verlagert sich diese Intelligenz nun in den Backendbereich. Über gut definierte APIs, insbesondere GraphQL oder REST-Schnittstellen, können Sprachagenten nahezu alle Funktionalitäten bereits bestehender Systeme zugänglich machen und steuern.

Der Benutzer greift dabei nicht mehr auf klassisch designte Frontends zu, sondern bleibt über eine Voice User Interface mit deinem Backend verbunden. Das bedeutet einen Paradigmenwechsel im Software-Design: „frontless“ heißt das Zauberwort. Systeme werden zunehmend als reine Backends mit modularen Verbindungs- und Kontroll-Providern (MCP) konzipiert. Dieser Ansatz vereinfacht den Entwicklungsprozess erheblich und beschleunigt die Time-to-Market von Anwendungen. Unternehmen müssen nicht mehr zeit- und kostenintensiv aufwändige visuelle Oberflächen gestalten und pflegen, sondern können sich auf die Kernlogik ihrer Services konzentrieren.

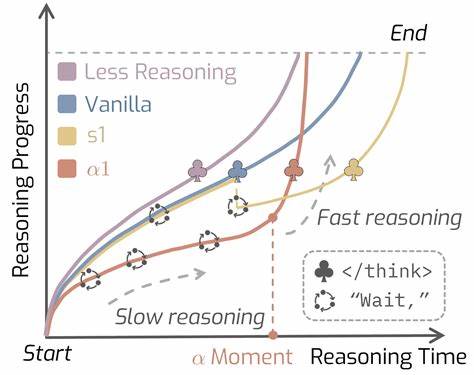

Die notwendigen Schnittstellen werden so entworfen, dass sie von Sprachagenten verstanden und kontrolliert werden können. Ein Beispiel ist die Integration eines MCP-Servers, der zwischen Backend-APIs und sprachlichen Steuerungsdiensten vermittelt. Mit Tools wie Claude Desktop MCP oder VS Code Voice lassen sich solche Systeme heute bereits testen und anpassen. Dies ermöglicht es Entwicklern, vorhandene Backend-Systeme ohne großen Mehraufwand sprachsteuerfähig zu machen. Die Integration von intelligenten Sprachagenten wie Claude.

ai oder ChatGPT wird diese Entwicklung weiter vorantreiben. Diese Systeme können Anfragen verstehen, interpretieren und kontextbezogen verarbeiten. Die Nutzerschnittstelle wird so zu einer Art Gesprächspartner, der problemlos mit unterschiedlichen APIs interagieren und dem Benutzer komplexe Abläufe vereinfachen kann. Zum Beispiel kann ein Kunde seine Bankgeschäfte per Sprachbefehl erledigen oder selbst komplizierte Datensätze aus einer SaaS-Lösung einfach per Sprache abfragen. Aus wirtschaftlicher Sicht eröffnen sich durch Voice User Interface völlig neue Geschäftschancen.

Neue SaaS-Produkte entstehen immer häufiger ohne klassische Benutzeroberflächen, sogenannte „frontless“ Produkte. Ein Beispiel hierfür sind Plattformen, die ausschließlich über API-Schichten und MCP-Connectoren zu bedienen sind – ähnlich wie es Zapier bereits heute mit seinem MCP-Modell vormacht. Die Bedienung durch Endanwender erfolgt dabei direkt über die intelligente Sprachsteuerung. Visuelle Bedienoberflächen werden nur bei Bedarf als Fallback angeboten, etwa für administrative Tätigkeiten oder komplexere Eingaben. Langfristig erwartet man, dass alle bestehenden SaaS-Anbieter ihre Systeme durch zusätzliche MCP-Schichten erweitern.

So wird der Zugang zu den Diensten wesentlich einfacher und flexibler, da keine klassischen User Interfaces mehr notwendig sind, die häufig an bestimmte Endgeräte oder Betriebssysteme gebunden sind. Sprachsteuerung über MCP ermöglicht eine geräteunabhängige Steuerung – ob per Smartphone, Smart Speaker oder eingebetteten Systemen. Auch User Experience wird sich stark verändern. Die natürliche Sprache als Interaktionsmedium ist nicht nur intuitiv und schnell, sondern erlaubt auch eine höhere Personalisierung und Anpassungsfähigkeit. Algorithmen passen sich fortlaufend an die individuellen Vorlieben und den Kontext des Nutzers an.

Die Grenzen zwischen Mensch und Maschine verschwimmen zunehmend, da Sprachagenten sensibel auf Nuancen, Emotionslage und Gesprächsverläufe reagieren können. Dadurch ergeben sich nicht nur produktive, sondern auch emotionale Nutzererlebnisse. Die Rolle von Entwicklern und Designern wandelt sich. Während früher viel Zeit in grafische Gestaltung und Nutzerführung floss, wird der Schwerpunkt nun auf die Ausgestaltung der zugrundeliegenden Logik und auf die intelligente Steuerung gelegt. Entwickler werden mehr Zeit damit verbringen, natürliche Sprachprozesse, kontextuelle Analyse und dialogische Abläufe zu entwickeln.

Gleichzeitig erhöht sich der Bedarf an semantischem Verständnis sowie an der Integration von Metadaten, die Sprachagenten bei der Kontextualisierung helfen. Allerdings ist die Umstellung auf eine rein sprachgesteuerte Steuerung nicht ohne Herausforderungen. Datenschutz und Sicherheit sind hier besonders wichtig, da Sprachdaten besonders sensibel sind. Ebenso müssen Nutzer bei komplexen Anwendungen manchmal visuelle Unterstützung erhalten, sodass hybride Konzepte aus Voice und klassischen Oberflächen häufig die Übergangslösung darstellen. Auch kulturelle und sprachliche Unterschiede müssen berücksichtigt werden, damit VUI-Technologien weltweit akzeptiert werden.

Mit Blick auf die Zukunft ist Voice User Interface mehr als nur ein weiterer Trend. Es ist ein grundlegender Wandel in der Art der Mensch-Maschine-Interaktion und wird in verschiedenen Branchen nachhaltige Spuren hinterlassen. Von Gesundheitswesen über Finanzdienstleistungen bis hin zur Industrie 4.0 werden sprachgesteuerte AI-Agenten die Arbeitsweise und Nutzererfahrung grundlegend verbessern. Die Technologie wird nicht nur schneller, sondern auch intelligenter, natürlicher und nahtloser integriert in unseren Alltag.