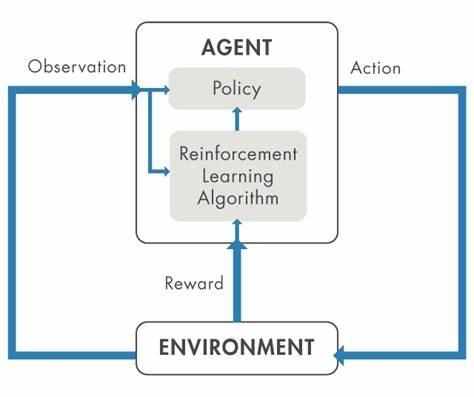

Im Zeitalter der Künstlichen Intelligenz gewinnen große Sprachmodelle, auch bekannt als LLMs (Large Language Models), immer mehr an Bedeutung. Von der Unterstützung beim Programmieren über die Erstellung von Texten bis hin zu Empfehlungen und Analysen – die Einsatzbereiche der Technologie sind nahezu grenzenlos. Doch trotz der hohen Leistungsfähigkeit dieser Modelle stellt sich eine entscheidende Frage: Wie können Anwender sicherstellen, dass die Antworten und Ergebnisse der LLMs für ihre individuellen Anforderungen zuverlässig, relevant und korrekt sind? Die Antwort liegt in der Etablierung sogenannter privater Evaluierungen oder Private Evals. Private Evals sind individuelle, maßgeschneiderte Tests, die Anwender selbst erstellen, um das Verhalten und die Leistung von LLMs für spezifische Aufgaben zu überprüfen. Während öffentliche Benchmarks in der KI-Forschung zwar wichtige Einblicke liefern, erlauben sie keine vollständige Bewertung in realen, oft komplexeren Anwendungsszenarien.

Das führt dazu, dass viele Nutzer LLM-Ausgaben blind vertrauen oder im schlimmsten Fall Fehlinformationen akzeptieren, die nicht den eigenen Qualitätsansprüchen genügen. Private Evals sind deshalb wesentlich, um aus passiven Nutzern aktive und kritische Anwender zu machen. Der Übergang von der bloßen Nutzung zu einer kritischen und reflektierten Verwendung von LLMs ist essenziell. Häufig neigen unerfahrene Nutzer dazu, die Modelle mit großen Erwartungen zu überfrachten, ohne ihre Grenzen zu hinterfragen. Diese Herangehensweise wird oft als „Hit and Hope“ bezeichnet: Man probiert verschiedene Fragen oder Aufgaben aus, hofft auf passende Antworten und akzeptiert mögliche Fehler.

Dies ist nicht nur ineffizient, sondern auch riskant, insbesondere bei sensiblen oder wertvollen Arbeitsprozessen. Im Gegensatz dazu entwickeln erfahrene Nutzer von LLMs private Evaluierungen, mit denen sie gezielt prüfen, ob das Modell in ihrem individuellen Kontext zuverlässig arbeitet. Die Idee private Evals zu etablieren stammt aus der Arbeit vieler erfahrener Entwickler und Forscher, die früh erkannt haben, dass der reine Einsatz von LLMs ohne eigene Qualitätskontrolle zu unangenehmen Überraschungen führen kann. Sie speichern typische und wichtige Fragestellungen, Probleme oder Use-Cases aus ihrem Alltag und prüfen wiederholt die Antworten des Modells. Dadurch entlarven sie systematische Fehler, Schwächen oder fehlerhafte Auffassungen und können so die Qualität der LLM-Ausgaben systematisch verbessern.

Die Auswahl der richtigen privaten Evaluationskriterien ist dabei eine Kunst für sich. Es gilt, jene Aufgaben auszuwählen, bei denen der persönliche Sachverstand besonders ausgeprägt ist. Denn nur wer selbst fundiertes Wissen in einem Bereich hat, kann auch zuverlässig beurteilen, ob ein LLM gute Leistungen abliefert oder nicht. So zeigt die Erfahrung, dass Juristen private Evals im Rechtsbereich erstellen, Programmierer eigene Tests für Code-Generierung entwickeln und Experten in Nischenbereichen wie der Botanik spezielle Fragestellungen definieren. Weiterhin sollten die ausgewählten Tests relevant und herausfordernd sein.

Aufgaben, die leicht von aktuellen LLMs gelöst werden können, bieten keinen Mehrwert bei der Qualitätskontrolle. Ebenso wenig sinnvoll sind Tests, bei denen der Anwender selbst keine ausreichende Expertise besitzt, da dies zu falschen Bewertungen führen kann. Eine ideale private Eval ist ganzheitlich und anspruchsvoll, sodass sie sowohl dem Modell als auch dem Anwender echten Erkenntnisgewinn liefert. Neben dem Inhalt spielt auch die Automatisierung eine wichtige Rolle. Während viele Privatnutzer ihre Evals manuell festhalten und auswerten – beispielsweise in Tools wie Notion – kann eine teilweise Automatisierung mithilfe von Skripten und Frameworks erheblich Zeit sparen und die Wiederholbarkeit erhöhen.

Dabei sollte jedoch bedacht werden, dass nicht alle Testfälle problemlos automatisiert werden können, vor allem bei komplexen, qualitativen Fragestellungen oder Kreativaufgaben. Es gehört daher zur guten Praxis, einen sinnvollen Mix aus automatisierten und manuellen Bewertungen einzusetzen. Die Bandbreite der möglichen privaten Evaluierungen ist dabei enorm. So lassen sich LLMs beispielsweise auf ihre Fähigkeit hin überprüfen, lokale Empfehlungen zu geben. Ein konkretes Beispiel wäre die Frage nach den besten Cafés im eigenen Wohngebiet unter bestimmten Kriterien.

Hier stoßen LLMs oft noch an ihre Grenzen, da aktuelle Modelle häufig veraltete oder falsche Informationen liefern. Das zeigt eindrücklich, dass in realweltlichen Anwendungen der Expertenmeinungen und der eigenen Erfahrung oft mehr Vertrauen geschenkt wird als automatisierten Antworten. Ähnlich lassen sich private Review-Tests gestalten, bei denen der LLM beispielsweise Fehler in langen Code-Snippets identifizieren oder komplexe Zusammenhänge erklären soll. Gerade bei der Fehlererkennung hat sich gezeigt, dass moderne LLMs beeindruckende Fähigkeiten besitzen, die jedoch gezielt geprüft und verifiziert werden müssen. Diese Prüfungen können von einfachen automatischen Script-basierten Tests bis hin zu detaillierten manuellen Reviews reichen.

Im Coding-Bereich wiederum sind automatisierte Tests besonders gut geeignet, da Code ausgeführt und auf Korrektheit geprüft werden kann. Kritisch ist allerdings die sichere und sandboxed-Ausführung, um Risiken und Nebenwirkungen zu vermeiden. Auch die Bewertung von visuellen Ausgaben ist eine spannende Herausforderung. Aktuelle Forschung nutzt dabei visuelle LLMs, die Bilder interpretieren und bewerten können, um etwa die Ausgabe eines Code-Programms grafisch zu analysieren. Eine weitere interessante Kategorie sind Design-Evals, in denen komplexe Planungen oder Architekturentscheidungen bewertet werden.

Derartige Tests sind häufig sehr spezifisch und erfordern eine hohe fachliche Expertise, werden daher oft individuell aufgesetzt und weniger automatisiert betrieben. Ähnliches gilt für schriftliche Arbeiten: Hier können LLMs beispielsweise als Editoren oder Kritiker fungieren und Vorschläge zur Verbesserung liefern. Auch diese Funktion gilt es durch private Tests auf ihre Effektivität hin zu überprüfen. Wer mit dem Gedanken spielt, private Evals zu implementieren, sollte auch auf vorhandene Starterpakete und Frameworks zurückgreifen. Es gibt Open-Source-Repositories und Tools, die den Einstieg erleichtern und eine solide Basis liefern.

Dennoch empfiehlt sich ein schlanker, individuell angepasster Ansatz, der speziell auf die eigenen Bedürfnisse und Ressourcen zugeschnitten ist. So kann man den Aufwand niedrig halten und dennoch maximalen Nutzen erzielen. Last but not least ist das Einüben einer kritischen Haltung gegenüber LLM-Ausgaben essenziell. Private Evals sind nicht nur technische Werkzeuge, sondern Teil einer Grundhaltung, die LLMs nicht als perfekte Orakel, sondern als mächtige, jedoch fehlerhafte Werkzeuge begreift. Nur so lassen sich die Chancen der Technologie realistisch einschätzen und nachhaltig nutzen.

Zusammenfassend lässt sich sagen, dass private Evaluierungen im Umgang mit LLMs unverzichtbar sind. Sie machen die leistungsstarken Modelle berechenbar und kontrollierbar, erhöhen die Qualität der Outputs und fördern eine skeptische, reflektierte Nutzung. Ob im professionellen Umfeld oder im privaten Kontext: Wer LLMs ernsthaft einsetzt, sollte sich die Zeit nehmen, eigene Prüfungen zu entwickeln, zu pflegen und immer wieder anzupassen. So wird aus der spannenden, jedoch komplexen Technologie ein zuverlässiges Werkzeug, das den individuellen Bedürfnissen gerecht wird und das Vertrauen der Anwender verdient.