In der modernen Computerwelt gewinnen GPUs (Graphics Processing Units) immer mehr an Bedeutung, nicht nur für grafikintensive Anwendungen, sondern ebenfalls für wissenschaftliche Berechnungen, maschinelles Lernen und Datenanalyse. AMD als einer der führenden Hersteller von Grafikkarten spielt dabei eine zentrale Rolle mit seiner leistungsstarken Hardware und optimierten Software-Ökosystemen. Die Programmierung von AMD GPUs mit der Programmiersprache Julia ist eine spannende Möglichkeit, um hochperformante Rechenoperationen effizient und zugänglich zu gestalten. Diese Kombination ermöglicht Entwicklern, die Power von AMD Grafikkarten in ihren Anwendungen zu nutzen, ohne auf komplexe oder schwer wartbare Low-Level-Codebasen angewiesen zu sein. Julia ist eine moderne Hochsprache mit wissenschaftlichem Fokus, die speziell für performante numerische Berechnungen entwickelt wurde und dank ihrer benutzerfreundlichen Syntax und rasanten Laufzeit ideal für GPU-Programming geeignet ist.

Die Nutzung von AMDGPU.jl, einem spezialisierten Julia-Paket, erlaubt den direkten Zugriff auf die Rechenressourcen von AMD GPUs und sorgt so für eine optimale Performance bei parallelen Workloads. Voraussetzung dafür sind aktuelle Versionen von Julia, idealerweise ab Version 1.10, wobei für spezifische AMD-Modelle wie den MI300X sogar mindestens Julia 1.12 benötigt wird.

Betriebssystemseitig werden 64-Bit-Versionen von Linux oder Windows unterstützt. Die Installation und Konfiguration sind dank klarer Anforderungen und gut strukturiertem Setup-Prozess über das offizielle AMDGPU.jl-Paket unkompliziert. Wichtige Bestandteile des Software-Stacks umfassen dabei ROCm (Radeon Open Compute), eine von AMD bereitgestellte Plattform für GPU-Computing unter Linux. Unter Windows wird stattdessen die AMD Adrenalin Edition empfohlen, die unter anderem die HIP-Bibliothek sowie weitere essenzielle Komponenten für GPU-Beschleunigung beinhaltet.

Der Vorteil dieser Integration ist die nahtlose Unterstützung moderner AMD-Hardware und das Erschließen komplexer paralleler Rechenoperationen mit minimalem Aufwand. Die Entwicklergemeinde wird zusätzlich durch umfangreiche Tests unterstützt. Nach der Installation lässt sich über ein simples Kommando der vollständige Funktionsumfang des Pakets prüfen. Dadurch wird sichergestellt, dass die Plattform korrekt eingerichtet ist und die GPU wie erwartet angesprochen werden kann. Ein praktisches Beispiel, um einen Einstieg in die Programmierung mit AMD GPUs in Julia zu erhalten, ist die elementweise Vektoraddition.

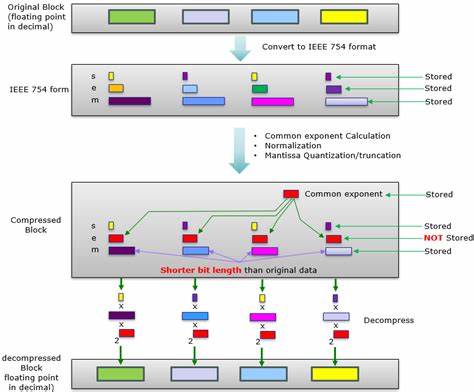

Dieses Beispiel illustriert die Verbindung von hoher Abstraktion mit der direkten Nutzung von Hardware-Ressourcen. Die Implementierung des Kernels erfolgt in Julia selbst und nutzt grundlegende Konzepte wie Workitem-Indexierung und Grid-Dimensionen, um jedem GPU-Thread eine eigene Aufgabe zuzuweisen. Konkret werden drei Arrays angelegt, von denen zwei mit Einsen initialisiert werden. Anschließend wird das Ergebnisarray mit Nullen vorbereitet. Die Kernel-Funktion berechnet dann die Summe für jedes Element parallel.

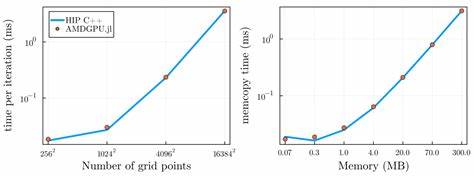

Über Parameter wie die Gruppengröße (groupsize) und Anzahl der Gruppen (gridsize) wird die Auslastung der GPU gesteuert. Die Ausführung mit dem @roc Makro ermöglicht eine klare und unkomplizierte Anwendung des Kernels auf der Zielhardware. Am Ende der Berechnung wird das Resultat gegen eine herkömmliche Array-Addition validiert. Diese Kombination aus einfacher Syntax, hoher Effizienz und direkter Hardwarekontrolle macht AMDGPU.jl zu einer attraktiven Wahl für Julia-Entwickler, die das Potenzial moderner AMD-GPUs ausnutzen möchten.

Die Community rund um Julia und GPU-Programmierung ist lebendig und wächst stetig. Nutzer haben die Möglichkeit, Fragen und Probleme in spezialisierten Foren wie dem Julia Discourse oder in speziellen Echtzeitkanälen auf Julia Slack zu diskutieren. Der offene Dialog fördert nicht nur das schnelle Lösen technischer Hindernisse, sondern auch den Austausch von Ideen und neuen Ansätzen zur Steigerung der Performance. Darüber hinaus werden Beiträge zum Projekt stets willkommen geheißen. Durch die modulare Struktur und das offene Entwicklungskonzept können Entwickler neue Features integrieren oder bestehende optimieren.

Dies trägt langfristig zur Stabilität und Innovationskraft des Ökosystems bei und hilft neuen Anwendern, schneller Fortschritte zu erzielen. Technisch basiert AMDGPU.jl auf den Arbeiten erfahrener Entwickler, die bereits im CUDA.jl- und LLVM.jl-Umfeld aktiv waren.

Dadurch profitiert das Paket von bewährten Verfahren und einer engen Verzahnung mit den zugrundeliegenden Compiler-Technologien. Die Lizenzierung unter der MIT License sichert Offenheit und freie Nutzung für verschiedenste Projekte, egal ob privat, akademisch oder kommerziell. Rückblickend zeigt sich, dass der Einsatz von AMD GPUs mit Julia eine attraktive Möglichkeit für moderne Hochleistungsanwendungen darstellt. Die Programmiersprache bringt dabei eine perfekte Mischung aus Flexibilität, Geschwindigkeit und Nutzerfreundlichkeit mit. Die Kombination aus aktuellen AMD-Grafikkarten und der passenden Software-Infrastruktur bildet eine leistungsstarke Plattform für eine Vielzahl von Einsatzgebieten – von wissenschaftlichen Simulationen über KI-basierte Systeme bis hin zu Echtzeitdatenverarbeitung.

Zukünftige Entwicklungen wie die Integration neuer Hardware-Features, verbesserte Compilerunterstützung oder noch intuitivere API-Designs versprechen, diesen Trend weiter zu verstärken. Insgesamt blickt die Community gespannt auf die kontinuierliche Weiterentwicklung und die wachsenden Möglichkeiten, die eine programmatische Nutzung der neuesten AMD GPUs mit Julia bietet. Für alle Entwickler, die auf der Suche nach leistungsfähigen, zugleich aber leicht zugänglichen Werkzeugen sind, eröffnet AMDGPU.jl beste Chancen, die Potenziale moderner GPU-Architekturen voll auszuschöpfen.