Die effiziente Vorbereitung von Datenbeständen vor dem Import oder Upload in komplexe Softwaresysteme stellt für viele Unternehmen eine entscheidende Herausforderung dar. Systeme wie Salesforce, Workday oder NetSuite arbeiten häufig mit spezifischen Import-Templates, die strikte Anforderungen an Struktur, Formatierung und Datenintegrität stellen. Ohne eine sorgfältige Bereinigung und Transformation der Daten drohen fehlerhafte Importe, Datenverluste oder inkonsistente Informationen, die den Geschäftsbetrieb erheblich beeinträchtigen können. Zu Beginn dieses Prozesses steht die Frage, wie sich heterogene Rohdaten in ein konsistentes Format überführen lassen. Eine der zentralen Aufgaben ist die Vereinheitlichung von Datumsangaben, da unterschiedliche Quellsysteme oft verschiedene Datumsformate verwenden.

Kernpunkte hierbei sind sowohl die Standardisierung als auch die Validierung von Datumswerten, sodass sie den Anforderungen der Zielsysteme entsprechen und keine fehlerhaften Einträge entstehen. Ein weiterer komplizierter Punkt sind die sogenannten Code-Mappings. Häufig wurden in Altsystemen oder verschiedenen Quellen unterschiedliche Kodes für dieselben Kategorien, Produkte oder Status verwendet. Um eine reibungslose Migration sicherzustellen, muss eine klare Zuordnung und Transformation dieser Codes erfolgen. Dabei sind oft manuelle Abstimmungen zwischen Business-Verantwortlichen und Datenexperten erforderlich, um die semantische Übereinstimmung zu gewährleisten.

Auf der Ebene der Tools und Technologien sehen viele Fachleute unterschiedlichen Ansätze gegenüber. Traditionell gern eingesetzt werden Tabellenkalkulationsprogramme wie Microsoft Excel. Diese bieten einfache Tools zum Sortieren, Filtern und Bearbeiten von Daten. Allerdings stößt Excel schnell an seine Grenzen, insbesondere wenn es um automatisierbare, wiederholbare Prozesse oder das Handling großer Datenmengen geht. Ein klassisches Problem ist hier die fehlerhafte Interpretation von Datentypen, zum Beispiel wenn Excel versucht, Text als Zahl zu formatieren oder umgekehrt, was zu unbemerkt falschen Daten führen kann.

Zur Bewältigung dieser Herausforderungen greifen viele Unternehmen auf Programmierlösungen zurück. Python hat sich als de facto Standard für die Datenvorbereitung etabliert, was unter anderem an der breiten Verfügbarkeit von Bibliotheken wie Pandas, NumPy oder Polars liegt. Diese Frameworks ermöglichen präzise, flexible und nachvollziehbare Transformationen, von der Datumsformatierung bis zur komplexen logischen Prüfung verschiedener Bedingungen. Ebenso bietet sich die Nutzung von Skripts in Java, Typescript oder C# an, wo je nach Organisation und Infrastruktur entsprechende Expertise vorliegt. Neben individuellen Skripten verwenden manche Teams spezialisierte ETL-Tools (Extract, Transform, Load), die oftmals eine grafische Oberfläche und vordefinierte Transformationen bieten.

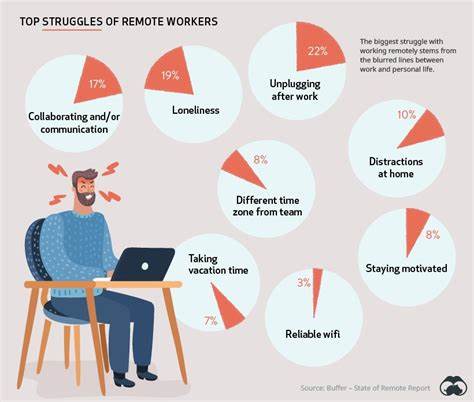

Diese können besonders für weniger technische Anwender die Datenvorbereitung vereinfachen. Dennoch beschreiben viele Anwender, dass die ETL-Lösungen oft „90 Prozent der Arbeit“ abdecken, in den letzten zehn Prozent der feinen, jedoch kritischen Anpassungen jedoch doch wieder maßgeschneiderte Programmierung notwendig wird. Die Nutzung von Low-Code- oder No-Code-Plattformen gewinnt zunehmend an Bedeutung, ebenso wie die Integration von KI-gestützten Werkzeugen. Große Sprachmodelle wie ChatGPT können mittlerweile bei der Automatisierung von Transformationsskripten unterstützen, indem sie aus wenigen Beispielen oder einer Datenbeschreibung passende Code-Snippets generieren. So können auch weniger erfahrene Nutzer komplexere Workflows initiieren.

Dennoch gilt es auch hier, die Ergebnisse sorgfältig zu validieren, da automatische Modelle manchmal unvollständige oder fehlerhafte Annahmen treffen. Parallel zum technischen Aspekt ist die Zusammenarbeit zwischen Fachabteilungen, Datenexperten und Implementierungsteams ein weiterer wesentlicher Erfolgsfaktor. Das gemeinsame Verständnis über die Datenstruktur und qualitätsbezogene Anforderungen ist häufig komplex. Besonderes Augenmerk liegt auf der Handhabung unstrukturierter oder mehrdeutiger Daten, die häufig manuelle Abstimmungen erfordern. Dazu gehören auch gezielte Qualitätskontrollen wie die Prüfung von Daten-Duplikaten, Plausibilitätsanalysen oder die Validierung von Referenzen über externe API-Dienste, etwa zur Adressprüfung.

Bei umfangreichen Datenmigrationen oder regelmäßigen Uploads wird die Nachverfolgbarkeit der Datenverarbeitungsschritte immer wichtiger. Versionierung und Dokumentation der Transformationslogiken sind entscheidend, damit Änderungen transparent und reproduzierbar bleiben. Insbesondere bei der Arbeit mit Excel-Dokumenten hat sich gezeigt, dass fehlende Versionskontrolle zu Informationsverlusten oder fehlerhaften Konsequenzen führen kann. Deshalb setzen viele Organisationen zunehmend auf automationsgetriebene Pipelines und auf den Einsatz von Jupyter Notebooks oder vergleichbaren Tools, die saubere, nachvollziehbare und modifizierbare Arbeitsschritte ermöglichen. Neben den erwähnten Herausforderungen gibt es praktische Tipps, die den Aufwand verringern können.

So sollten immer unbearbeitete Originaldatenbestandteile archiviert werden, um den Prozess bei Bedarf wiederholen zu können. Die Festlegung eines klaren, stabilen Interfaces für den Import und vor allem für wiederkehrende Transformationen vereinfacht die Automation erheblich. Dort, wo möglich, ist es ratsam, Schema- und Validierungsregeln gemeinsam mit den Datenlieferanten frühzeitig abzustimmen, um Probleme komplett im Vorfeld zu minimieren. Zukunftsträchtig sind Lösungen, die die Fachdomain und Datenlogik in formaler Weise erfassen. Ansätze wie die Modellierung von Datenschemata mittels Tools wie Pydantic für Python oder die Verwendung von YAML-Konfigurationen zur Beschreibung von Ein- und Ausgabeformaten erhöhen die Wiederverwendbarkeit und erleichtern Wartung und Weiterentwicklung.

Auch der Einsatz von Data-Wrangling-Libraries, welche deklarative Datenoperationen ermöglichen, gewinnt an Bedeutung. Darüber hinaus bietet der Einstieg in moderne Datenbanktechnologien wie DuckDB oder SQLite neue Möglichkeiten, Daten temporär strukturiert zu speichern und skalierbar zu transformieren. Gerade bei größeren Datenmengen ist der Weg über eine SQL-basierte Zwischenschicht häufig schneller und weniger fehleranfällig als reine Skriptverarbeitung auf flachen Dateien. Alles in allem bleibt die Datenbereinigung und -transformation ein vielschichtiges Thema mit technischen, organisatorischen und menschlichen Aspekten. Die erfolgreiche Umsetzung erfordert ein ausgewogenes Zusammenspiel von geeigneten Tools, klaren Prozessen und einer engen Zusammenarbeit verschiedener Expertengruppen.

Nur so können Daten im gewünschten Qualitätsniveau ins Zielsystem importiert werden und als verlässliche Grundlage für Geschäftsprozesse dienen.