Die Entwicklung von Sprachmodellen hat in den letzten Jahren enorme Fortschritte gemacht, angetrieben durch die stetige Zunahme an Parametern und Rechenleistung. Große Sprachmodelle, die heutige Maßstäbe setzen, benötigen immense Ressourcen sowohl während der Trainingsphase als auch bei der Inferenz. Dabei stellte sich lange Zeit die allgemeine Annahme, dass Leistungssteigerungen zwangsläufig mit einem enormen Kostenanstieg bei Speicher und Rechenzeit einhergehen müssen. Die neuartige Parallel Scaling Law gibt dieser Überlegung nun eine frische Wendung und bietet eine effizientere Skalierungsmethode, die sowohl Training als auch Inferenz revolutionieren könnte. Der traditionelle Weg zur Leistungsverbesserung von Sprachmodellen erfolgt hauptsächlich über zwei Skalierungsarten: Parameter-Skalierung und Inferenzzeit-Skalierung.

Parameter-Skalierung bedeutet, immer größere Modelle mit mehr Gewichten und Schichten zu bauen, was oft zu exponentiell steigenden Anforderungen an Speicher und Rechenleistung führt. Inferenzzeit-Skalierung meint die Verlängerung der Ausgabe, also das Generieren längerer Textpassagen, was ebenfalls den Ressourcenverbrauch erheblich erhöht. Hier setzt die sogenannte Parallel Scaling Law, kurz ParScale, an, die einen dritten Weg eröffnet. Statt nur Parameterzahl oder Ausgabelänge zu erhöhen, wird die parallele Verarbeitung der Modellinstanzen ins Zentrum gestellt. Konkret heißt das, dass das Input-Signal durch eine Vielzahl unterschiedlicher und lernbarer Transformationen geschickt wird.

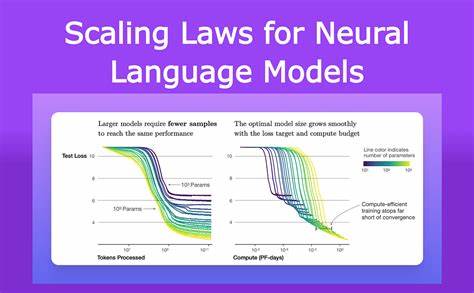

Das Modell wird dann parallel mehrfach durchlaufen, wobei unterschiedliche Ausgaben entstehen, die schließlich dynamisch zusammengeführt werden. Dieses Vorgehen führt zu einer erhöhten Parallelität in der Nutzung der bestehenden Modellkapazitäten, ohne dass die Anzahl der Parameter zwangsläufig vergrößert werden muss. Aus theoretischer Sicht formulieren die Forscher eine neue Skalierungsgesetzmäßigkeit. Ein mit P parallelen Strömen ausgestattetes Modell zeigt eine Leistungsverbesserung, die äquivalent zur Erhöhung der Parameteranzahl um den Faktor der logarithmischen Funktion von P ist. Das heißt ein lineares Wachstum bei den parallelen Streams liefert eine deutlich langsamere, aber ressourcenschonendere Verbesserung der Modellleistung als ein primäres Hochskalieren der Parameter.

Ein zentrales Argument für ParScale ist die gesteigerte Effizienz. Im Vergleich zur klassischen Parameter-Skalierung kann ParScale den Speicherverbrauch bis zu 22-fach verringern und die Latenzzeit beim Inferenzprozess um den Faktor sechs reduzieren. Diese drastische Einsparung bei den Ressourcen öffnet Türen für den Einsatz größerer oder leistungsfähigerer Sprachmodelle in Szenarien mit begrenztem Hardware-Budget oder in ressourcenschwachen Umgebungen. Eine weitere Stärke dieses Ansatzes liegt in der sogenannten Recycling-Fähigkeit. Vortrainierte Modelle, die bereits in der Breite eingesetzt werden, können durch eine vergleichsweise kurze Nachtrainingsphase auf kleinen Datensätzen so umgebaut werden, dass sie parallel skalieren.

Diese Nachjustierung reduziert signifikant den Trainingsaufwand, der sonst bei der Entwicklung komplett neuer Modelle anfallen würde. Wie lässt sich die praktische Relevanz dieser Methode bewerten? Gerade im Zeitalter wachsender KI-Anwendungen und komplexer Sprachgenerationen steigen die Anforderungen an Hardware-Ressourcen exponentiell. Unternehmen und Forschungseinrichtungen stehen oft vor der Herausforderung, den Spagat zwischen Modellgröße und Verfügbarkeit von Rechenkapazitäten optimal zu meistern. Die Parallel Scaling Law bietet eine Möglichkeit, die Leistung durch intelligente Parallelisierung zu steigern, ohne linear mit den Kosten zu wachsen. Damit wird nicht nur ein effizienterer Ressourceneinsatz ermöglicht, sondern auch eine umweltfreundlichere KI-Entwicklung gefördert, da weniger Energie und Speicherplatz verbraucht werden.

Zudem eröffnet die Methode neue Chancen für die Forschung und Industrie, indem Modelle schneller an neue Aufgaben angepasst oder auf kleineren Hardwareplattformen implementiert werden können. Von der theoretischen Grundlage über umfangreiche Validierung durch große Pre-Trainingsphasen bis hin zur Demonstration praktischer Nutzen ist ParScale ein bedeutender Fortschritt im Feld der maschinellen Sprachverarbeitung. Das Konzept, dass parallele Streams von Ein- und Ausgaben ähnlichkeitsbildend wirken wie eine logarithmische Skalierung der Parameteranzahl, führt zu einem leistungsfähigen Paradigmenwechsel. Die Möglichkeit, eine bessere Modellqualität bei zugleich reduzierten Betriebskosten zu erzielen, könnte in Zukunft die Verbreitung von KI-Anwendungen deutlich fördern. Vor allem in Anwendungsfällen, in denen niedrige Latenz und geringe Hardware-Ressourcen entscheidend sind – etwa auf mobilen Geräten oder eingebetteten Systemen – kann die Parallel Scaling Law einen entscheidenden Unterschied machen.

Insgesamt zeigt die Forschung klare Perspektiven, wie durch parallele und dynamisch aggregierte Verarbeitungsschritte Sprachmodelle flexibler und skalierbarer gestaltet werden können, ohne die exorbitanten Kosten herkömmlicher Skalierungsansätze zu verursachen. Die Zukunft der KI wird durch solch innovative Methoden maßgeblich mitgeprägt, weil sie den Fleiß und die Kreativität der Wissenschaft mit praktischer Effizienz vereinen. Parallel Scaling Law repräsentiert somit nicht nur eine Methode zur Leistungssteigerung, sondern auch einen Schritt in Richtung nachhaltiger und zugänglicher KI-Technologie, die sowohl Forscher als auch Anwender weltweit begeistert und voranbringt.