Die Wahl des richtigen Datenbanksystems stellt für Unternehmen eine grundlegende Weiche im Hinblick auf Skalierbarkeit, Kosten und Performance dar. Insbesondere im Bereich wachsender Anwendungen und zahlreicher Nutzer gewinnt die Entscheidung zunehmend an Bedeutung. Während verteilte SQL-Datenbanken wie CockroachDB attraktive Vorteile bieten, können Nutzer mit der Zeit auf unerwartete Hürden stoßen, die die Kosten und die Effizienz des Systems beeinträchtigen. Ein Weg, Kosten zu senken und gleichzeitig die Abfragegeschwindigkeit und Operationen zu verbessern, kann der Wechsel zu einer bewährten relationalen Datenbank wie PostgreSQL sein. Dieser Beitrag beleuchtet die Erfahrungen des Unternehmens Motion, das nach über zwei Jahren Nutzung von CockroachDB den Schritt zur Migration auf PostgreSQL wagte, und stellt zentrale Erkenntnisse zu Herausforderungen, Migrationsprozessen und Performanceverbesserungen vor.

Motion entschied sich seinerzeit für CockroachDB aufgrund der vielversprechenden Vorteile im Bereich der horizontalen Skalierung und der hohen Verfügbarkeit, maßgeblich vor dem Hintergrund geplanter Multi-Region-Setups wegen rechtlicher Anforderungen wie der DSGVO. Der verteilte Ansatz von CockroachDB stellte insbesondere für die künftige Datenlokalisierung eine interessante Option dar und bot eine nahezu nahtlose SQL-Schnittstelle. Doch mit zunehmendem Wachstum und größer werdenden Datenbanken zeigte sich schnell, dass die initialen Vorteile mit steigenden Kosten und technischen Limitierungen erkauft wurden. Bis 2024 hatten sich die Ausgaben bei CockroachDB verfünffacht und stiegen in den mittleren sechsstelligen Bereich an. Überraschenderweise entfielen die meisten Anfragen noch auf einen einzigen Regionseinsatz mit vergleichsweise unkomplizierten Transaktionsabfragen, sodass die Kosten für ein verteiltes System unverhältnismäßig wirkten.

Einer der größten Schmerzpunkte stellte das Management von Datenbankmigrationen dar. Das eingesetzte ORM Prisma kam bei großen Datenmengen häufig an seine Grenzen und verursachte wiederholt Timeouts beim Ausführen von Migrationsskripten. Dies führte zu einem erheblichen Mehraufwand, da Migrationsschritte manuell auf der CockroachDB-Konsole nacheinander ausgeführt werden mussten. Solche Verzögerungen führten in der Folge zu langen Deployments mit teilweise mehreren Stunden Stillstand, was den Entwicklungsprozess und die Auslieferung neuer Funktionen stark einschränkte. Im Vergleich dazu bewies PostgreSQL bei vergleichbaren Migrationstests am selben Datenbestand seine Stärke: Die neue Spalte wurde in Sekunden hinzugefügt, ohne nennenswerte Verzögerung oder Timeouts.

Neben den direkten Operationen in der Datenbank schlugen sich die Timeouts und Performanceeinbußen auch negativ auf ETL-Prozesse aus. Die für Datenexport und -import eingesetzten Schnittstellen, beispielsweise Airbyte, litten unter mangelnder Stabilität und technischen Problemen wie Speicherlecks. Dadurch kam es immer wieder zu Fehlern oder Verzögerungen beim Synchronisieren der Daten, was den täglichen Betrieb weiter erschwerte. Zudem ist das Ökosystem an robusten, voll ausgereiften ETL-Tools, die eine saubere Anbindung an CockroachDB ermöglichen, bis dato recht dünn besiedelt. PostgreSQL glänzt hier hingegen mit einer breiten Palette an erprobten Integrationen und einer stabilen Infrastruktur für Datenpipelines.

Auch bei den Abfragezeiten wiesen die Vergleichstests ein differenziertes Bild auf. In einigen speziell optimierten Fällen zeigte der CockroachDB-Query-Planer seine Effizienz, indem komplexe Aggregationen schneller ausgeführt wurden als in PostgreSQL. Doch dies war eher die Ausnahme. Die Mehrzahl der realen Anwendungsabfragen, besonders solche, die von Prisma generiert und mit komplexen Joins und vielfältigen Spaltenkombinationen arbeiteten, profitierten von der klareren, effizienteren Planung der PostgreSQL-Abfrageoptimierer. So konnte zum Beispiel eine besonders umfangreiche Abfrage auf der TeamTasks-Tabelle in PostgreSQL etwa zwanzig Mal schneller ausgeführt werden als im verteilten System.

Dieses massive Leistungsplus lässt sich auf eine bessere Indexnutzung und die Fähigkeit von PostgreSQL zurückführen, Operationen effizienter zu planen und reine Full-Table-Scans zu vermeiden. Neben rein technischen Aspekten kamen bei der Nutzung von CockroachDB auch einige UI- und Support-Probleme hinzu. Die Nutzeroberfläche zur Analyse ungenutzter Indices war wenig verlässlich und führte teilweise zu falschen Empfehlungen, was Entwickler verunsicherte. Zudem war das manuelle Abbrechen laufender, teurer Abfragen innerhalb des Cockroach-Clusters komplex und fehleranfällig, während PostgreSQL die Einstellung und Beendigung von Abfragen deutlich einfacher gestaltete. Die Support-Erfahrungen waren ebenfalls herausfordernd.

Separat voneinander laufende Portale, lange Reaktionszeiten und zeitraubende Eingabewiederholungen erschwerten die schnelle Problemlösung in kritischen Situationen, beispielsweise bei Bugs die zu Ausfällen führten. Ein weiterer Störfaktor waren strategische Probleme bei der Konnektivität. Über zwei Jahre hinweg traten wiederholt unerklärliche Verbindungsverluste zu CockroachDB-Clustern durch Tailscale-Komponenten auf, was sich durch die gesamte Infrastruktur bis hin zu lokalen SQL-Clients zog. Diese temporären Ausfälle konnten längerfristig nicht behoben werden und stellten eine kontinuierliche Belastung für den Betrieb dar. Solche Probleme sind nach Umstieg auf PostgreSQL nicht mehr aufgetreten.

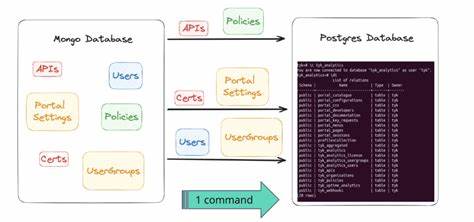

Der eigentliche Migrationsprozess von einem verteilten zu einem klassischen relationalen System kann nach anfänglichen Sorgen sehr schnell und effizient vonstattengehen, sofern die richtigen Tools und Herangehensweisen gewählt werden. Motion entschied sich, die Migration mittels eines eigenen ETL-Skripts in der aufstrebenden Bun-Umgebung zu realisieren. Dabei wurden strukturierte Dumps der Daten aller Tabellen erzeugt, welche dann durch eigenständige Prozesse ingestreamt und in PostgreSQL importiert wurden. Eine der größten Herausforderungen lag in den feinen Unterschieden bei der Datenformatierung, insbesondere bei JSON- und Array-Datentypen, die von CockroachDB leicht anders kodiert werden als von PostgreSQL. Eine individuelle Umformung dieser Formate war notwendig, um eine lückenlose und identische Datenspiegelung zu gewährleisten.

Trotz der Komplexität war der komplette Import des rund 100 Millionen Zeilen starken Datenbestands in der Produktivumgebung in unter 15 Minuten abgeschlossen. Wichtiger als die reine Geschwindigkeit während der Migration war die Vermeidung von Datenverlust sowie die Minimierung der Ausfallzeiten. Durch eine akribische Planung und schichtweise Wiederinbetriebnahme konnte die Downtime auf weniger als eine Stunde reduziert werden. Dank Wartungsmodus und vorsichtigem Traffic-Management konnten darüber hinaus Störungen für Endnutzer beinahe vollständig vermieden werden. Nach dem erfolgreichen Umstieg erlebte das Unternehmen eine sofortige und spürbare Verbesserung bei den Antwortzeiten der API-Anfragen, die Messungen zufolge um etwa ein Drittel schneller wurden.

Dies ging auf die effizientere Abfrageausführung und optimierte Indizes zurück. Zudem ermöglichte die wohl etablierte PostgreSQL-Toollandschaft mit Werkzeugen wie PGAnalyze weitere Optimierungen, die in kurzer Zeit diverse schlecht performende Abfragen identifizierten und beheben halfen. Auch die äußeren Rahmenbedingungen wie stabilere Netzwerkverbindungen, besserer Support-Zugang und allgemein geringere Betriebskosten überzeugten das Entwicklungsteam und das Management. Finanziell ergab sich durch die Migration eine erhebliche Entlastung des Budgets mit Einsparungen im Bereich von über 110.000 US-Dollar jährlich, selbst bei weiterhin wachsendem Daten- und Nutzeraufkommen.

Zudem schuf die Migration die Grundlage für eine flexiblere und skalierbarere Architektur, die in Zukunft bessere Voraussetzungen für neue Funktionalitäten und weitere Expansionen bietet. Die Migration von verteilten Datenbanken wie CockroachDB zu PostgreSQL kann demnach eine äußerst sinnvolle Strategie sein, wenn der primäre Fokus auf Stabilität, Kosteneffizienz und Performance bei transaktionalen Workloads liegt und die zusätzlichen Features einer verteilten Datenbank nicht voll ausgeschöpft werden. Es bedarf jedoch sorgfältiger Planung, um Datenkodierungsdifferenzen und Migrationsströme sauber zu handhaben. Gleichzeitig empfiehlt es sich, auf bewährte Tools und bewährte Praktiken zurückzugreifen, um die Ausfallzeiten möglichst gering zu halten und ein reibungsloses Umschalten zu gewährleisten. Die Erfahrungen von Motion zeigen, dass selbst große Datenbestände mit der richtigen Strategie und Technik schnell und zuverlässig migriert werden können, ohne dass dramatische Unterbrechungen anfallen oder Funktionen verloren gehen.

Darüber hinaus eröffnen sich durch den Wechsel zu PostgreSQL vielfach verbesserte Möglichkeiten zur Performance-Optimierung und Administration. Für Unternehmen, die vor ähnlichen Herausforderungen stehen und eine vertikale Skalierung und optimierte Operationen suchen, kann eine Migration zu PostgreSQL somit ein lohnenswerter Schritt darstellen.