Die rasante Verbreitung von Künstlicher Intelligenz und insbesondere von großen Sprachmodellen verändert das Spielfeld in nahezu allen Branchen. Doch je stärker Unternehmen KI und LLMs (Large Language Models) mit eigenen Daten füttern wollen, desto dringlicher wird die Frage: Wie erkennt man eigentlich, welche Daten sensibel sind und geschützt werden müssen? Die Antwort auf diese Frage ist alles andere als trivial. Noch vor der eigentlichen Datensicherung steht die Herausforderung der Datenklassifikation, die in vielen Fällen komplexer und aufwändiger ist als der Datenschutz selbst. Datenklassifikation bezeichnet den Prozess, bei dem Daten hinsichtlich ihres Inhalts bewertet und kategorisiert werden. Im Kontext von KI geht es um die Identifikation von persönlich identifizierbaren Informationen (PII), geistigem Eigentum (IP) oder anderen sensiblen Informationen, die nicht ungefiltert in KI-Modelle eingespeist werden sollten.

Nur mit einer präzisen Klassifikation lässt sich festlegen, welche Daten maskiert, pseudonymisiert oder gar ausgeschlossen werden müssen. Andernfalls riskieren Unternehmen Datenschutzverstöße, Reputationsschäden und rechtliche Konsequenzen. Noch immer basiert die Datenklassifikation in vielen Betrieben auf manuellen Prozessen oder einfachen Skripten, die bestimmte Schlüsselwörter oder Muster erkennen sollen. Diese Herangehensweise hat sich jedoch als überaus zeitintensiv und fehleranfällig herausgestellt. Gerade bei großen Datenvolumina – etwa Kundendatenbanken, E-Mails, Finanzdokumenten oder Produktbeschreibungen – stößt man an Grenzen.

Die Unterschiede zwischen sensiblen und unkritischen Informationen sind mitunter subtil und abhängig vom Kontext. Zudem steigen die Anforderungen durch gesetzliche Vorschriften wie die Datenschutz-Grundverordnung (DSGVO) oder branchenspezifische Regelungen stetig. Viele der in der Praxis eingesetzten Tools leiden unter einer begrenzten Genauigkeit bei der Erkennung sensibler Daten. Ein häufiger Pain Point ist die hohe Fehlerrate – entweder werden sensible Informationen nicht erkannt (False Negatives) oder harmlose Daten werden fälschlicherweise als sensibel markiert (False Positives). Ersteres birgt Datenschutzrisiken, letzteres verursacht unnötigen Aufwand bei der Nachbearbeitung.

Die im Alltag verwendeten Lösungen haben oft Schwierigkeiten, mit variantenreichen, unstrukturierten und mehrsprachigen Daten umzugehen. Trotz zahlreicher Fortschritte in der KI-basierten Texterkennung und Verarbeitung steht die Datenklassifikation immer noch vor einem relevanten manuellen Mehraufwand. Viele Teams berichten, dass ein Großteil der Ressourcen in die Überprüfung und Korrektur der Ergebnisse investiert wird. Die Kombination aus automatischen Tools und Expertenwissen scheint derzeit der pragmatischste Weg, um Ergebnisse mit akzeptabler Qualität zu erzielen. Trotzdem bleibt der Prozess insgesamt zeitintensiv und kompliziert.

Aus Sicht vieler Unternehmen ist die Datenklassifikation keineswegs als gelöstes Problem zu betrachten. Stattdessen prägt oft ein Gefühl der Frustration den Umgang mit der Datenvorbereitung für KI-Anwendungen. Die Herausforderung liegt auch darin, dass sich das Datenportfolio ständig verändert – neue Datenströme entstehen, alte Daten werden überarbeitet, und die Anforderungen an den Datenschutz entwickeln sich weiter. Somit ist die Datenklassifikation ein andauernder Prozess, der regelmäßige Wartung und Anpassung erfordert. Welche Eigenschaften sollte nun ein ideales Tool zur KI-Datenklassifikation besitzen, um diesem Problem gerecht zu werden? Nutzer wünschen sich vor allem eine hohe Präzision kombiniert mit einer einfachen Integration in bestehende Arbeitsabläufe.

Wichtig ist auch, dass die Lösung verständlich erklärt, warum bestimmte Daten als sensibel klassifiziert wurden – Transparenz ist essenziell, um Vertrauen zu schaffen. Eine KI-gestützte Klassifikation, die sich selbst lernt und anpasst, spart Mitarbeitende Zeit und reduziert Fehler. Zudem sollten moderne Lösungen in der Lage sein, eine breite Palette an Datenformaten, Datenquellen und Sprachen abzudecken. Flexibilität ist ebenfalls entscheidend, um branchenspezifische Besonderheiten abzubilden und individuelle Compliance-Anforderungen einzuhalten. Idealerweise erhält das Team eine Plattform, die sowohl bei der automatischen Erkennung sensibler Daten, bei der Nachbearbeitung als auch bei der Einbindung in Datenschutz- und Sicherheitsprozesse unterstützt.

Auf der operativen Ebene erweist sich häufig als hilfreich, die Datenklassifikation in mehrere Stufen aufzuteilen: zunächst eine grobe automatische Analyse, gefolgt von einer manuellen Validierung und Feinjustierung. So lässt sich der Aufwand gezielt reduzieren, ohne die Sicherheit zu gefährden. Trotz dieser hybriden Ansätze bleibt die Datenklassifikation in der Praxis jedoch oft eine Herausforderung, die sich nicht vollständig automatisieren lässt. Ein weiterer zentraler Punkt ist die Datenschutzrichtlinie eines Unternehmens. Diese muss klar definieren, welche Datenkategorien als sensibel gelten und welche Schutzmaßnahmen jeweils erforderlich sind.

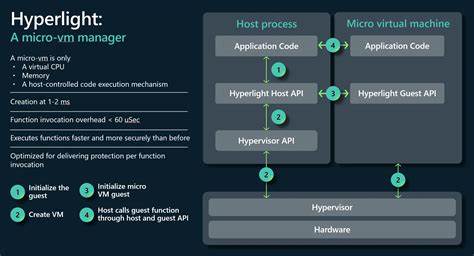

Nur mit einem abgestimmten Rahmenwerk und regelmäßigem Training aller Beteiligten kann die Qualität der Datenklassifikation nachhaltig gesteigert werden. Schulungen und Awareness-Programme sind unerlässlich, um Fehler durch menschliches Versagen zu vermeiden. Technologisch gesehen entsteht gegenwärtig ein Trend hin zu KI-Systemen, die in der Lage sind, semantischere Analysen durchzuführen und das Datenumfeld besser zu erfassen. Damit lassen sich sensiblere und präzisere Klassifizierungen erreichen, die über reine Stichworterkennung hinausgehen. Diese Next-Generation-Tools versprechen, die Datenaufbereitung für KI wesentlich effizienter zu gestalten.

Trotzdem ist man sich bewusst, dass auch die beste Technik nicht alle Herausforderungen allein lösen kann. Der sichere Umgang mit sensiblen Informationen bleibt eine gemeinsame Aufgabe von Technologie, Management und Mitarbeitenden. Eine kontinuierliche Weiterentwicklung der Klassifikationsmethoden und deren Anpassung an neue Anforderungen ist notwendig, um den steigenden Ansprüchen gerecht zu werden. Zusammenfassend lässt sich sagen, dass die Klassifikation von Daten für KI-Anwendungen heute oft als größere Hürde empfunden wird als deren Schutzmaßnahmen. Ein fundiertes Verständnis der Daten und ein sorgfältiger Umgang sind essenziell, um Risiken zu minimieren und das Potenzial von KI nutzbringend einzusetzen.

Die Entwicklung innovativer, KI-unterstützter Klassifikationswerkzeuge steht daher ganz oben auf der Agenda vieler Unternehmen. Eine stärkere Zusammenarbeit zwischen Entwicklern, Datenschützern und Fachbereichen sowie der Austausch bewährter Praktiken können helfen, diesen komplexen Prozess besser zu bewältigen. Die Zukunft wird zeigen, ob sich die Datenklassifikation durch fortschrittliche Technologien und intuitive Werkzeuge deutlich vereinfachen lässt – eine Entwicklung, die die sichere Nutzung von KI-Daten nachhaltig erleichtern würde.