Big Data gehört mittlerweile zu den essenziellen Themen in der digitalen Welt. Unternehmen und Entwickler stehen ständig vor der Herausforderung, immer größere und komplexere Datenmengen effizient zu verarbeiten und auszuwerten. Die damit verbundenen Systeme sind jedoch nicht frei von Fallstricken, die oft als "Big Data Tar Pits" bezeichnet werden. Diese tückischen Probleme können enorme Zeitverluste und Kosten verursachen, wenn sie nicht rechtzeitig erkannt und adressiert werden. Ein tieferes Verständnis der grundlegenden Herausforderungen und ihrer möglichen Lösungen ist daher entscheidend für den Erfolg von Big Data Projekten.

Der Begriff Big Data ist weit gefasst und entzieht sich einer eindeutigen Definition. Im Kern versteht man darunter Datenverarbeitung, die spezielle Ansätze benötigt, um Zeit- oder Speicherbegrenzungen zu überwinden. Wikipedia beschreibt Big Data als Datensätze, die so groß oder komplex sind, dass traditionelle Datenverarbeitungs-Software sie nicht bewältigen kann. Dabei entstehen oftmals zwei maßgebliche Herausforderungen: das Datenvolumen und die Datenverarbeitungs-Geschwindigkeit, auch als Volume beziehungsweise Velocity bezeichnet. Traditionelle Ansätze stoßen an ihre Grenzen, sobald diese Dimensionen erreicht werden.

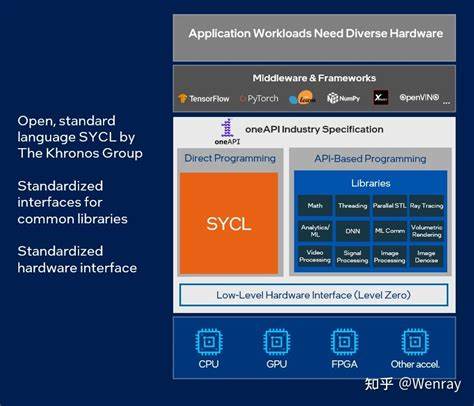

Um mit solchen Datenmengen umzugehen, setzen moderne Systeme häufig auf verteilte Datenverarbeitungs-Architekturen. Diese verteilen sowohl Daten als auch Rechenoperationen auf mehrere Knoten innerhalb eines Clusters. Bekannte Frameworks wie Hadoop, Spark oder Flink abstrahieren die technische Komplexität, doch die Verteilung bringt fundamentale Besonderheiten mit sich, die Entwickler berücksichtigen müssen. Der parallelisierte und verteilte Ansatz führt zu einer Vielzahl von Nebenwirkungen, die klassische Annahmen über Datenkonsistenz oder Reihenfolgen aushebeln. Einer der verheerendsten Fallen beim Umgang mit verteilten Big Data Systemen ist die Annahme einer zuverlässigen und globalen Zeitordnung von Ereignissen.

Im Kontext eines Beispiels – einer Spieleplattform, die Location-Updates von Spielern sammelt – unterstreicht sich dieses Problem besonders. Spieler senden kontinuierlich Updates, um ihre Bewegungen auf einer Spielkarte abzubilden. Nachrichten können aufgrund unterschiedlicher Netzwerklatenzen oder Verarbeitungsprioritäten in falscher Reihenfolge eintreffen oder verarbeitet werden. Eine scheinbar einfache Lösung ist die Verwendung von Zeitstempeln zur Sortierung der Ereignisse. Doch in der Praxis sind Zeitstempel oft unzuverlässig.

Uhren auf Client-Geräten können nicht synchron sein, und selbst Server-Systeme leiden unter Zeitabweichungen und Latenz. Eine robustere Lösung besteht darin, nicht auf Zeitstempel zu vertrauen, sondern auf explizite Sequenznummern. Diese ermöglichen zumindest eine lokale, also spielerspezifische, Reihenfolge der Ereignisse. Jeder Update-Event bekommt fortlaufend eine eigene Nummer zugewiesen, die garantiert, dass später eintreffende Nachrichten mit höherer Sequenznummer aktualisiert werden. Dieser Mechanismus vermeidet inkonsistente Zustände wie die Anzeige eines alten Standortes nach einem neueren Ereignis.

Elementar ist dabei, dass das Überprüfen und Aktualisieren des Spielerzustandes atomar geschieht, um keine Race Conditions entstehen zu lassen. Moderne Datenbanken und verteilte Key-Value Stores wie HBase, DynamoDB oder Postgres bieten solche atomaren Operationen an. Ein weiteres bedeutendes Thema im Big Data Umfeld ist die Partitionierung der Daten. Da keine einzelne Maschine das gesamte Datenvolumen bewältigen kann, muss das System die Daten intelligent aufteilen und parallel verarbeiten lassen. Diese Partitionierung erfolgt in zwei wesentlichen Dimensionen: für die Verarbeitung und für die Speicherung bzw.

Abfrage. Bei der Verarbeitung zielt eine gute Partitionierung darauf ab, die Daten gleichmäßig auf Rechenknoten zu verteilen. Wichtig dabei ist, dass Knoten idealerweise kontinuierlich mit Arbeit versorgt werden, um keine Ressourcen ungenutzt zu lassen. Gleichzeitig kann eine Partitionierung auch genutzt werden, um logische Zusammengehörigkeiten abzubilden – im Beispielspiel können alle Updates eines Spielers auf einen Rechner geleitet werden. So kann der Knoten lokal den Zustand dieses Spielers verwalten, was Abhängigkeiten und Synchronisationsprobleme mindert.

Der Nachteil einer zu starren Partitionierung besteht darin, dass bei weniger Spielern als Knoten manche Knoten gar nicht arbeiten, was Skalierungspotential verschenkt. Die Partitionierung für die Speicherung ist noch komplexer, da unterschiedliche Abfragen oft unterschiedliche Datenzugriffsmuster ermöglichen. Ein datenbasiertes Partitionsschema spiegelt meistens genau diese erwarteten Abfragen wider. Wenn beispielsweise häufig nach bestimmten Aktionen innerhalb von Zeiträumen gesucht wird, kann die Datenpartitionierung entlang dieser Dimensionen erfolgen. Daten können etwa nach Aktionstyp, Spieler und Datum partitioniert werden.

Dieses Vorgehen ermöglicht Abfragen, die nur die relevanten Partitionen lesen, was die Performance maßgeblich steigert. Andererseits führt eine zu eng definierte Partitionierung dazu, dass andere Abfragetypen schlechter performen, da nach wie vor große Datenmengen gescannt werden müssen. Die Herausforderung besteht darin, eine Partitionierung zu entwerfen, die die wichtigsten Anwendungsfälle optimal unterstützt und dennoch Flexibilität für zukünftige Anforderungen bietet. Fehler und Ausfälle sind in verteilten Big Data Systemen nicht die Ausnahme, sondern die Regel. Netzwerkausfälle, fehlerhafte Hardware oder fehlerhafter Code führen dazu, dass einzelne Datenverarbeitungsschritte scheitern.

Daher ist eine zentrale Komponente im Systemdesign die Planung und Umsetzung eines Reprocessing-Konzepts. Dieses stellt sicher, dass fehlerhafte oder verlorene Daten erkannt, bereinigt und neu eingespielt werden können, ohne das Gesamtsystem dauerhaft zu beeinträchtigen. Ein zentraler Entscheidungsfaktor bei der Verarbeitung ist, ob die Daten mindestens einmal (at-least-once) oder höchstens einmal (at-most-once) verarbeitet werden sollen. Eine exakte einmalige Verarbeitung ist aufgrund der Komplexität im verteilten System selten praktikabel. Bei at-least-once Verarbeitung wird ein Datenelement möglicherweise mehrfach verarbeitet, was idempotente Verfahren voraussetzt.

Das Beispiel eines Spielerstandortes illustriert dies anschaulich: Selbst wenn dasselbe Ereignis mehrfach verarbeitet wird, kann die Verwendung von Sequenznummern dafür sorgen, dass nur sinnvolle Updates das System beeinflussen. At-most-once Verarbeitung hingegen akzeptiert Datenverlusten, stellt aber sicher, dass kein Ereignis doppelt verarbeitet wird. Diese Variante ist nützlich für Szenarien, in denen Wiederholungen die Berechnung verfälschen könnten, beispielsweise bei Durchschnittswerten. Hier wird das Risiko, dass einige Datenpunkte verloren gehen, gegen die Gefahr verzerrter Berechnungen abgewogen. Die Entscheidung für eine Verarbeitungsstrategie hängt daher stark von den Anforderungen der Anwendung und deren Toleranz gegenüber Fehlern ab.

Das Vermeiden von Big Data Fallen erfordert also ein tiefes Verständnis über die Eigenschaften verteilt arbeitender Systeme, die Datenstruktur und deren Abfrageverhalten. Die Einführung von expliziten Sequenznummern für Ereignisse, eine durchdachte Partitionierung, eine klare Fehlerbehandlungsstrategie und eine passende Verarbeitungssemantik bilden die Grundlage für robuste Systeme. Oft werden gravierende Probleme erst erkannt, wenn das System schon in Betrieb ist. Die Kosten für die Beseitigung der Ursachen und die erforderlichen Umbauten sind dann erheblich höher. Wer diese potenziellen Fallstricke bereits bei der Planung berücksichtigt, spart nicht nur Zeit und Geld, sondern kann seine Big Data Systeme wesentlich effizienter, skalierbarer und zuverlässiger gestalten.

Daher lohnt es sich, sowohl auf technischer als auch auf organisatorischer Ebene, diesen Herausforderungen frühzeitig Aufmerksamkeit zu schenken und geeignete Architekturen sowie Prozesse zu entwickeln. Denn in der Welt der Big Data entscheidet letztlich nicht die schiere Datenmenge über den Erfolg, sondern das geschickte Management der damit verbundenen Komplexität.