Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren nicht nur die Art und Weise verändert, wie wir mit Technologie interagieren, sondern auch das Potenzial gezeigt, wissenschaftliche Disziplinen wie die Chemie grundlegend zu beeinflussen. Große Sprachmodelle, die auf umfangreichen Textdaten trainiert sind, übertreffen mittlerweile in bestimmten Bereichen der Chemie sogar das Wissen durchschnittlicher menschlicher Experten. Doch wie verhalten sich diese künstlichen Intelligenzen im Vergleich zum tiefgreifenden Fachwissen und der Erfahrung chemischer Experten? Und welche Implikationen ergeben sich daraus für Forschung, Bildung und Anwendung in der Chemie? Dieser Beitrag beleuchtet die aktuelle Forschung, insbesondere den jüngsten Durchbruch mit ChemBench, einem umfassenden Bewertungssystem zur Analyse der chemischen Fähigkeiten von LLMs, und stellt die Modelle der menschlichen Expertise gegenüber. Große Sprachmodelle im Wandel der chemischen Wissenschaft Große Sprachmodelle basieren auf maschinellem Lernen und natürlichen Sprachverarbeitungsalgorithmen, mit denen sie trainiert werden, Texte in menschlicher Sprache zu verstehen und zu erzeugen. Ursprünglich für allgemeine Textanwendungen entwickelt, haben LLMs sich durch ihre Fähigkeit, komplexe Antworten zu generieren, auch für wissenschaftliche Fragestellungen etabliert.

In der Chemie werden sie bereits für die Vorhersage von Moleküleigenschaften, Optimierung von Reaktionsbedingungen oder Extraktion relevanter Informationen aus wissenschaftlichen Publikationen eingesetzt. Ihre Fähigkeit, in natürlicher Sprache zu arbeiten, macht sie zu einem idealen Werkzeug, um das immense Wissen in der Chemie, das vor allem textbasiert vorliegt, zugänglich und nutzbar zu machen. ChemBench: Ein neuer Maßstab zur Bewertung chemischen Wissens von LLMs Obwohl erste Berichte die Fähigkeiten von LLMs in der Chemie würdigen, fehlte bislang ein systematisches und umfassendes Bewertungsinstrument. Genau hier setzt ChemBench an, eine automatisierte Plattform, die mehr als 2700 sorgfältig kuratierte Frage-Antwort-Paare umfasst und damit den Wissensstand und die logischen Fähigkeiten von LLMs mit dem menschlicher Chemiker vergleicht. Diese Fragen decken eine breite Palette von Chemiethemen ab, von Grundlagen über organische, anorganische bis hin zu technischen und angewandten Bereichen.

Ebenso werden unterschiedliche Denkfähigkeiten wie Fact-Knowledge, Rechnen, logisches Schlussfolgern sowie chemische Intuition getestet. Erstaunliche Ergebnisse: LLMs übertreffen Experten in vielen Bereichen Durch die Anwendung von ChemBench konnten führende große Sprachmodelle evaluiert werden, wobei überraschend die besten Modelle häufiger korrekte Antworten lieferten als die getesteten Chemikerexperten. Dies betrifft vor allem wissensbasierte und gut definierte Aufgaben aus chemischen Lehrplänen. Die Tatsache, dass einige Open-Source-Modelle anderen kommerziellen Lösungen ebenbürtig sind, zeigt zudem, dass nicht nur proprietäre Systeme das Leistungsniveau erhöhen können. Limitierungen und Herausforderungen: Wo LLMs noch zurückliegen Trotz beeindruckender Erfolge zeigen LLMs Schwächen in bestimmten Bereichen.

Aufgaben, die komplexe chemische Strukturaufgaben oder tiefergehende strukturbezogene Schlussfolgerungen erfordern, gehören dazu – etwa die korrekte Bestimmung von Kernresonanzsignalen oder stereochemischen Isomeren. Modelle neigen hier dazu, sich auf Assoziationen aus dem Trainingsdatensatz zu verlassen, statt echte chemische Logik anzuwenden. Weiterhin zeigt die Analyse, dass Modelle häufig übermäßig selbstsicher in ihrer Antwort sind und nicht zuverlässig einschätzen können, wann sie eine Frage richtig oder falsch beantworten, was gerade bei sicherheitsrelevanten Fragen problematisch sein kann. Einfluss auf Chemieausbildung und Forschung Die Fähigkeit von LLMs, Faktenwissen nahezu perfekt abzurufen, während die eigene kritische Denkfähigkeit zurückbleibt, stellt auch eine Herausforderung für die Chemieausbildung dar. Wo bisher Auswendiglernen eine wichtige Rolle spielte, rückt künftig die Vermittlung von Kompetenz im kritischen Denken und in komplexer Problemlösung in den Vordergrund.

Zugleich könnten LLMs den Zugang zu Wissen erleichtern und Forschern helfen, schneller Hypothesen zu generieren oder Daten auszuwerten. Die Modelle können somit als Copiloten betrachtet werden, die die menschliche Expertise ergänzen, jedoch nicht ersetzen. Gefahren und ethische Überlegungen Die leistungsfähigen Fähigkeiten der LLMs in der Chemie werfen auch Fragen nach Missbrauchspotenzialen auf. Die Technologie, die zur Entwicklung unschädlicher Moleküle genutzt wird, könnte ebenso für die Synthese gefährlicher oder toxischer Substanzen missbraucht werden. Ein weiteres Risiko besteht darin, dass auch Laien und Studierende die Ausgaben der Modelle ohne kritisches Hinterfragen als korrekt ansehen und dadurch falsche oder sogar gefährliche Anwendungen entstehen könnten.

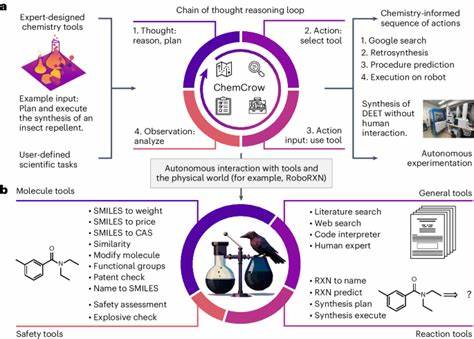

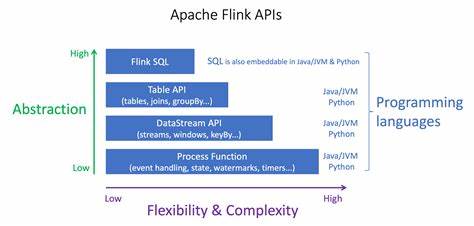

Die Integration von Sicherheitsmechanismen und gezielte Schulungen zur Bewertung der Modellantworten sind daher unverzichtbar. Weiterentwicklung der Modelle und zukünftige Perspektiven Die aktuelle Forschung zeigt, dass Modellgröße einen positiven Zusammenhang mit der Leistung hat und zusätzliche Training auf spezielleren Datenbanken (etwa strukturierten chemischen Datenbanken) die Fähigkeiten der Modelle weiter verbessern kann. Zudem besteht großes Potenzial darin, LLMs mit externen Werkzeugen, wie Websuche, Reaktionsplanern oder Datenbanken, zu koppeln, um die Präzision und Anwendbarkeit der Ergebnisse zu steigern. Die Kombination aus linguistischem Verständnismodell und spezialisierten Werkzeugen könnte die Grundlage für autonome Forschungsassistenten legen. Rolle der menschlichen Expertise in einer Ära der KI Trotz der Kompetenz großer Sprachmodelle bleibt die Expertise menschlicher Chemiker unverzichtbar.

Die Tiefe des Verständnisses, die Fähigkeit zu kreativer Problemlösung und ethischer Reflexion sowie praktische Laborerfahrung sind schwer ersetzbar. LLMs können Routineaufgaben und Wissensabruf erleichtern, doch die fachliche Beurteilung bleibt essenziell, um die Qualität und Sicherheit von Erkenntnissen sicherzustellen. Die Zukunft liegt in einem synergistischen Zusammenspiel von Mensch und Maschine. Fazit Die Betrachtung der chemischen Fähigkeiten großer Sprachmodelle im Vergleich zum Expertenwissen von Chemikern zeigt eine faszinierende Balance aus Fortschritt und noch bestehenden Grenzen. LLMs haben bewiesen, dass sie viele Fragestellungen der Chemie schneller und oft auch besser beantworten können als menschliche Experten, doch ihre Beschränkungen insbesondere in der strukturellen und intuitiven Chemie weisen auf den starken Wert menschlicher Wissenschaftskompetenz hin.

Für Forschung, Bildung und Anwendung ist es daher entscheidend, diese Technologien sinnvoll zu integrieren, den Menschen zu unterstützen und nicht zu ersetzen. Evaluationen wie ChemBench bilden hierbei eine wichtige Grundlage, den Fortschritt gezielt zu messen und weiterzuentwickeln, um die Chemie der Zukunft mitgestalten zu können.