Die Videoproduktion durchläuft gerade einen tiefgreifenden Wandel. Die Entwicklung von KI-basierten Technologien hat die Art und Weise revolutioniert, wie Bewegtbilder erstellt und verarbeitet werden. In diesem Kontext ist das Modell LTXV-13B ein Meilenstein: es ermöglicht die Erzeugung hochqualitativer Videos in Echtzeit und bietet damit vielfältige Anwendungsmöglichkeiten für Kreativschaffende, Entwickler und Unternehmen. Diese bahnbrechende Technologie nutzt modernste Diffusionsmodelle und wurde von Lightricks, einem führenden Entwickler auf dem Gebiet der KI-gestützten Medienbearbeitung, entwickelt. Doch was steckt hinter LTXV-13B und wie überzeugt dieses Modell in puncto Geschwindigkeit, Qualität und Vielseitigkeit? Im Folgenden erfahren Sie alles Wissenswerte über die innovative Technologie, ihre Funktionsweise sowie ihre potenziellen Anwendungsbereiche in der Praxis.

LTXV-13B ist das erste DiT-basierte (Diffusion Transformer) Videoerzeugungsmodell, das es schafft, Videos in Echtzeit zu produzieren, und zwar mit einer Bildrate von 30 Bildern pro Sekunde bei einer beeindruckenden Auflösung von 1216 x 704 Pixel. Das Besondere dabei: Die Erstellung verläuft schneller als die Wiedergabe, was es ermöglicht, Videos praktisch in dem Tempo zu generieren, wie man sie ansieht. Das Modell wurde auf einer großen und vielfältigen Sammlung von Videoinhalten trainiert, wodurch es in der Lage ist, realistische und abwechslungsreiche Videos in hoher Auflösung zu erzeugen. Die Flexibilität des Modells erlaubt dabei sowohl die Generierung aus Textbeschreibungen als auch aus Kombinationen von Bildern und Text. Aufgrund dieser Kombination aus Schnelligkeit, Qualität und Vielseitigkeit eröffnet LTXV-13B neue Horizonte in der computergenerierten Videoproduktion.

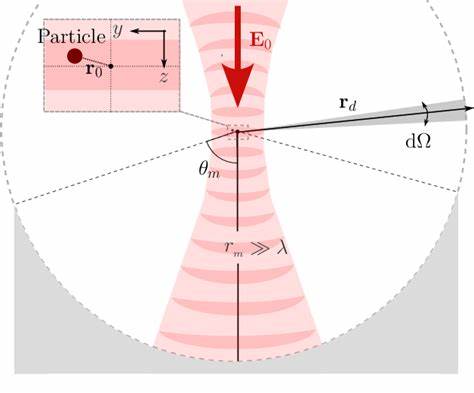

Ein wesentliches Merkmal von LTXV-13B ist seine Basis auf Diffusionsmodellen. Diese Art von Modellen arbeitet, indem sie schrittweise ein Bild oder Video durch einen mehrstufigen Prozess „entstört“. Aus anfänglichem Rauschen werden so nach mehreren Verarbeitungsschritten immer detailreichere und realistischere Bilder erzeugt. Das zugrundeliegende Transformer-Architektur-Design erlaubt es dem Modell zudem, komplexe Zusammenhänge über Zeitachsen hinweg zu erfassen und damit flüssige und konsistente Bewegungsabläufe in Videos zu produzieren. Die Kombination aus Diffusionsansatz und Transformer-Technologie stellt sicher, dass die resultierenden Videos eine hohe Detailtreue und natürliche Bewegungen aufweisen – eine Kombination, die bisher nur schwer und mit großer Rechenleistung erreichbar war.

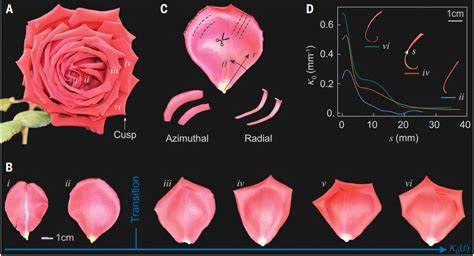

Das Training des LTXV-13B-Modells erfolgte auf sehr umfangreichen Datensätzen mit zahlreichen unterschiedlichen Szenarien. Von urbanen Landschaften bei Nacht über Winterszenen mit verschneiten Bergstraßen bis hin zu Nahaufnahmen von Personen und Interaktionen – die Trainingsdaten variierten immens. Dies befähigt das Modell dazu, flexibel auf unterschiedlichste Eingaben zu reagieren und maßgeschneiderte Videos in diversen Stilen zu produzieren. Die Fähigkeit, sowohl textbasierte als auch bildgestützte Aufforderungen in hochwertige Videos umzuwandeln, macht LTXV-13B zu einem universellen Werkzeug in der Content-Erstellung. Für Anwender stellt das Modell unterschiedliche Versionen bereit, die je nach Anwendungsfall abgewogen werden können.

So gibt es beispielsweise die ltxv-13b-0.9.7-dev-Variante, die die bestmögliche Videoqualität liefert, aber mehr Leistung und VRAM benötigt. Daneben existieren distillierte Varianten, welche eine etwas niedrigere Qualität zugunsten schnellerer Verarbeitung und geringerem VRAM-Verbrauch bieten – optimal für schnelle Prototypen oder Anwendungen mit begrenzten Ressourcen. Weiterhin sind Quantisierungsmethoden in Vorbereitung, die den Speicherbedarf noch weiter reduzieren.

Diese Auswahlmöglichkeiten erlauben es sowohl Profis als auch Hobbyisten, das Modell flexibel und effizient einzusetzen. Die Anwendungsmöglichkeiten von LTXV-13B sind vielseitig und reichen von der Erstellung von Marketingvideos über die Entwicklung von Effekten im Film- und Gamingbereich bis hin zu innovativen Bildungslösungen. Die Fähigkeit, Inhalte auf Basis ausführlicher Textbeschreibungen in hochauflösende und flüssige Videos umzuwandeln, sorgt dafür, dass Ideen schnell visualisiert und angepasst werden können, ohne aufwendige Filmaufnahmen oder Grafikerstellung. So können etwa Werbeteams ihre Kampagnenentwürfe in kurzer Zeit als dynamische Videos darstellen, und Entwickler können virtuelle Welten oder Storyboards automatisiert generieren. Die Integration des Modells mit der beliebte Diffusers-Bibliothek im Python-Umfeld erleichtert den Einstieg immens.

Mit wenigen Zeilen Code können Benutzer Szenen realisieren, Umskalierungen vornehmen und Qualitätsverbesserungen automatisch durchführen. Die Möglichkeit, Upsampling-Verfahren für die räumliche Auflösung und temporale Upscaler für die Bildrate zu verwenden, erweitert die Qualität und den Realismus der generierten Videos zusätzlich. Dabei werden gängige KI-Frameworks und CUDA-Unterstützung genutzt, was eine breite Kompatibilität mit aktuellen GPU-Architekturen sicherstellt. Doch nicht nur die reine Technik steht im Fokus von LTXV-13B, auch das Nutzererlebnis wurde optimiert. So sind ausführliche Prompt-Empfehlungen verfügbar, um präzise und komplexe Eingaben zu ermöglichen, mit dem Ziel die Generierung bestmöglich an die Vorstellungen anzupassen.

Statt einfacher Stichworte sollten elaborierte Szenenbeschreibungen verwendet werden, um den Detailgrad und die Konsistenz der Videoausgabe zu erhöhen. Auch für die Kombination von Bildvorlagen mit ergänzenden Textbeschreibungen existieren spezialisierte Methoden, die eine nahtlose Integration von vorgegebenen visuellen Elementen mit kreativen Texten erlauben. Bei aller Innovation bleibt jedoch zu beachten, dass LTXV-13B wie alle KI-Modelle gewissen Einschränkungen unterliegt. Die Modellgenauigkeit bei komplexen oder stark spezifischen Eingaben kann variieren, und es besteht die Gefahr, dass nicht immer exakt das gewünschte Ergebnis entsteht. Darüber hinaus bringt der Einsatz statistischer Lernverfahren die übliche Problematik möglicher gesellschaftlicher Verzerrungen mit sich, die auch bei diesem Modell berücksichtigt werden müssen.

Für besonders kritische Anwendungen sollten die Videos daher stets qualitativ geprüft und, falls erforderlich, nachbearbeitet werden. Insgesamt fasst LTXV-13B den aktuellen Stand der Technik in der KI-basierten Videoerstellung zusammen und erweitert ihn entscheidend um die Fähigkeit zur Echtzeitverarbeitung hochwertiger Videos. Dieses Modell verbindet innovative Algorithmen mit praktischer Nutzbarkeit und bietet einen wahrhaften Quantensprung für die Medienproduktion. Die vielseitigen Varianten und komfortablen Integration in bekannte Frameworks machen es für viele Anwendergruppen interessant und eröffnen zahlreichen Branchen neue kreative Perspektiven. Dabei bleibt die Entwicklung nicht stehen: Mit geplanten Erweiterungen wie der Quantisierung und verbesserter Ressourcenoptimierung wird LTXV-13B bald noch zugänglicher und leistungsfähiger.

Wer sich mit moderner Videoerstellung beschäftigt oder einfach die Möglichkeiten von KI im kreativen Bereich ausloten möchte, sollte LTXV-13B definitiv im Blick behalten. Von der schnellen Prototypenentwicklung über Marketingmassnahmen bis zur komplexen Produktion – hochqualitative Videos in Echtzeit von einem KI-Modell zu erhalten, war bisher Wunschdenken. Nun sind wir einen großen Schritt näher dran, diesen Traum Realität werden zu lassen.