Kubernetes hat sich als Standardplattform für die Orchestrierung von Containern etabliert und bietet ein robustes Framework zur Verwaltung von Anwendungen in großen, verteilten Systemen. Eine der wichtigsten Eigenschaften, die Kubernetes so flexibel und erweiterbar macht, ist die Möglichkeit, die Kubernetes-API durch Custom Resource Definitions, kurz CRDs, zu erweitern. Diese Erweiterungen erlauben es Entwicklern und Cloud-Architekten, eigene Ressourcen und API-Endpunkte zu definieren, die nahtlos in das Kubernetes-Ökosystem integriert werden können. Doch was steckt eigentlich hinter CRDs, wie funktionieren sie im Detail und wie ist der Registrierungsprozess aufgebaut? Diese Fragen werden im Folgenden ausführlich beantwortet und erlauben ein tiefes Verständnis dieser Technologie. Zunächst ist es wichtig zu verstehen, was CRDs eigentlich sind.

Auf der grundlegendsten Ebene handelt es sich bei einer CRD um ein Kubernetes-Objekt vom Typ CustomResourceDefinition, mit dessen Hilfe man eigene Ressourcentypen in Kubernetes definieren kann. Diese Ressourcentypen erweitern die Kubernetes-API, sodass kubectl, Controller oder andere Komponenten diese neuen Objekte verstehen, validieren und verwalten können. Allerdings sind CRDs an sich ohne zusätzliche Logik lediglich von Kubernetes gespeicherte Datenstrukturen – sie erweitern nur das Datenmodell, ohne das Verhalten zu verändern. Erst in Kombination mit einem Custom Controller oder Operator wird aus einer CRD ein mächtiges Werkzeug, das gewünschte Applikationszustände überwacht und sicherstellt. Eine typische CRD definiert unter anderem die API-Version, den Namen der Ressource, deren Scope (ob namespaced oder clusterweit), sowie die verschiedenen API-Versionen, die unterstützt werden, inklusive eines Schemas.

Dieses Schema wird mittels OpenAPI v3 definiert und legt fest, wie die einzelnen Felder der Ressource strukturiert sind, welche Datentypen sie besitzen und welche optional oder erforderlich sind. Durch diese Definition erhalten Kubernetes und seine API-Server die Fähigkeit, eingehende Daten anhand der CRD-Spezifikation zu validieren – dies schützt vor fehlerhaften Ressourcenbeschreibungen und ermöglicht eine Typensicherheit bei der Verarbeitung. Die Bedeutung der OpenAPI-Schema-Validierung kann dabei gar nicht überschätzt werden: Wenn beispielsweise ein Benutzer ein Objekt erstellt oder aktualisiert, wird geprüft, ob alle vorgeschriebenen Felder vorhanden sind und ob die Werte dem erwarteten Datentyp entsprechen. Nur wenn die Daten dieser Validierung standhalten, wird die Ressource in der Kubernetes-Datenbank etcd abgespeichert. Das sorgt für Konsistenz und verhindert Fehler, die sonst erst zur Laufzeit auftreten würden.

Wenn es um die tatsächliche Nutzung solcher CRDs geht, kommen Controller ins Spiel. Diese sind Programme, die kontinuierlich den Ist-Zustand der Kubernetes-Ressourcen beobachten und diesen mit einem gewünschten Zustand vergleichen. Ist eine Ressource nicht im erwarteten Zustand, ergreifen Controller Maßnahmen, um sie zu korrigieren. Der Controller nutzt dabei den Kubernetes-Client, auf dessen Basis ein Get-Call auf die Ressource erfolgt, um den aktuellen Status zu ermitteln. Dabei ist wichtig zu verstehen, dass die Kubernetes-Clientbibliotheken die Objekte typisiert behandeln, sofern die entsprechenden Go-Strukturen registriert sind.

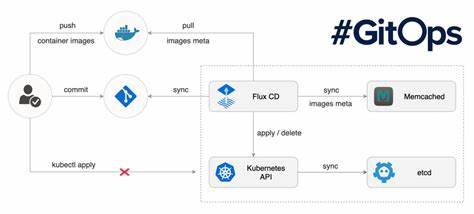

Alternativ können unstrukturierte Clients verwendet werden, um Objekte als generische Maps zu handhaben. Die Herausforderung bei der Arbeit mit CRDs liegt dabei neben der Definition und Nutzung der Schemas vor allem in der Registrierung der Ressourcen beim Kubernetes-API-Server. Denn nur so kann die Kubernetes-API Anfragen an die benutzerdefinierten Endpunkte weiterleiten. Hier kommt der Aggregationslayer zum Tragen, der Teil des kube-apiserver ist. Er ermöglicht es, mehrere API-Server logisch unter einer einzigen API-Oberfläche zu vereinen und Anfragen an verschiedene Backend-Server zu routen.

Die Registrierung geschieht über sogenannte APIService-Ressourcen, die den custom-apiserver in den Aggregationslayer einbinden. Dies sorgt dafür, dass die Kubernetes-API-Aufrufe für neue API-Gruppen und Versionen über die eingebundene Infrastruktur verfügbar sind. Die Registrierung einer CRD führt somit zu mehreren wichtigen Schritten im Hintergrund: Zunächst wird die CRD selbst als Ressource im etcd-Cluster gespeichert. Im Anschluss verarbeitet der CRD-Registrierungs-Controller diese Änderung, liest die Spezifikationen aus und erzeugt oder aktualisiert entsprechende APIService-Objekte, die dem kube-aggregator übergeben werden. Der Aggregationslayer sorgt danach dafür, dass alle Anfragen im richtigen Kontext und an die richtige Adresse versendet werden.

Damit sind selbst komplexe Erweiterungen mit mehreren Versionen und Ressourcen problemlos in den Kubernetes-API-Stack integrierbar. Ein weiterer wichtiger Aspekt ist die Discovery-Funktionalität. Kubernetes bietet eine Schnittstelle, über die Clients dynamisch eruieren können, welche API-Gruppen, Versionen und Ressourcen aktuell verfügbar sind. Die CustomResourceDiscovery-Controller sind dabei verantwortlich, die entsprechenden Pfade und Informationen zu aktualisieren, sodass Werkzeuge wie kubectl oder auch automatisierte Systeme die CRDs erkennen und korrekt verwenden können. Ohne diese dynamische Erkennung wäre der Betrieb von CRDs deutlich unkomfortabler, da Anwender gesetzmäßige Ressourcen nur schwer herausfinden oder verwalten könnten.

Im täglichen Gebrauch profitiert man von dieser komplexen Infrastruktur vor allem durch die nahtlose Integration und die Möglichkeit, eigene Ressourcen wie etwa eigene Workload-Typen, Konfigurationsobjekte oder sogar komplette Applikations-APIs in Kubernetes abzubilden. Die Kombination aus OpenAPI-Schema-Validierung, Custom Controllern sowie dem Aggregationslayer sorgt für eine sehr mächtige und dennoch schlanke Erweiterungsschnittstelle. Die eigentliche technische Implementierung im Client-Stack ist ebenfalls interessant: Beim Zugriff auf eine Ressource erfolgt ein Get-Aufruf über client-go, welcher je nach Objekt-Typ entweder als unstrukturierter Client, als geteilter Partial-Metadaten-Client oder als typisierter Client ausgeführt wird. Dabei wird zunächst das GroupVersionKind (GVK) des Objektes bestimmt, was eine einzigartige Identifikation des Ressourcentyps gewährleistet. Dieser Schritt ist zentral, da ohne bekanntes GVK der Client nicht weiß, wie das erhaltene JSON oder YAML korrekt in das interne Objekt des Controllers überführt wird.

Die Umwandlung und das Parsen der Rohdaten übernehmen sogenannte Decoder, die anhand des registrierten Schemas den Inhalt überprüfen und typisieren. Falls das Schema fehlt oder nicht erkannt wird, schlägt die Dekodierung fehl – ein häufiger Fehler, wenn ein CRD nicht korrekt im Cluster installiert ist. Somit stellt die Schema-Validierung eine wichtige Qualitätssicherung dar. Auch wenn dies im ersten Moment als sehr komplex erscheint, ist die Architektur bewusst so modular gestaltet, dass Erweiterungen einfach zu implementieren und konsistent zu pflegen sind. Die Verantwortung für Schema-Definition, Validierung, API-Integration und Request-Routing ist sauber voneinander getrennt.

Die automatische Neubewertung und Synchronisierung über Controller garantiert, dass neue CRDs und API-Services auch bei Cluster-Restarts oder Upgrades zuverlässig bestehen bleiben. Die Nutzung von CRDs und deren Registrierung ist heute aus modernen Kubernetes-Anwendungen nicht mehr wegzudenken. Sie bilden die Grundlage für Operators, IoT-Plattformen, Service-Mesh-Lösungen und viele weitere innovative Technologien, die auf Kubernetes aufbauen. Das durchdachte Zusammenspiel aus API-Erweiterung über CRDs, API-Aggregation und Client-Logik ermöglicht eine flexible und skalierbare Anpassung an fast jede Anforderung in der Cloud und vor Ort. Abschließend lässt sich sagen, dass das Verständnis der Funktionsweise von CRDs und ihrem Registrierungsmechanismus essenziell ist, um die volle Kraft von Kubernetes auszuschöpfen.

Vom ersten Schreiben eines CRD-Manifests über das Registrieren beim API-Server bis hin zur Implementierung eines eigens dafür entwickelten Controllers ist es eine spannende Reise in die Tiefen von Kubernetes. Wer diese Konzepte beherrscht, kann maßgeschneiderte und effiziente Cloud-native Lösungen realisieren, die weit über die Standardfunktionalitäten hinausgehen. Die Kombination aus Stabilität, Flexibilität und Erweiterbarkeit macht CRDs zu einem der mächtigsten Werkzeuge für Cloud-Ingenieure und Entwickler im Kubernetes-Umfeld.