Die Fähigkeit, Objekte zu erkennen, zu kategorisieren und menschlich zu verstehen, ist eine der grundlegenden Eigenschaften unseres Denkens und unserer Wahrnehmung. Sie bildet die Basis für eine Vielzahl kognitiver Prozesse, die unser tägliches Leben durchdringen. In den letzten Jahren haben sich große Sprachmodelle (LLMs) rasant weiterentwickelt, insbesondere multimodale Varianten, die neben Texten auch Bilder und andere Sinneseindrücke verarbeiten können. Ein zentrales Forschungsthema, das zunehmend an Bedeutung gewinnt, liegt darin, ob und wie diese multimodalen LLMs menschenähnliche Konzepte von Objekten entwickeln und abstrahieren – ein Thema, das im wissenschaftlichen Diskurs nicht nur Künstliche Intelligenz, sondern auch Neurowissenschaften und Psychologie betrifft. Multimodale LLMs vereinen Sprachverarbeitung und visuelle Wahrnehmung auf künstliche Weise und bieten eine vielversprechende Plattform, um kognitive Prozesse nachzubilden.

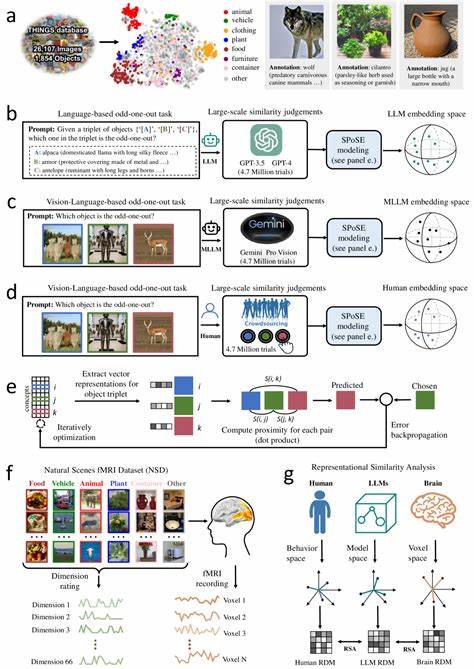

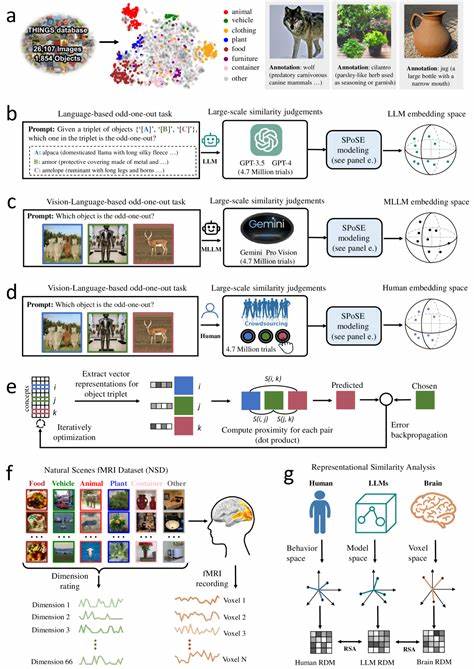

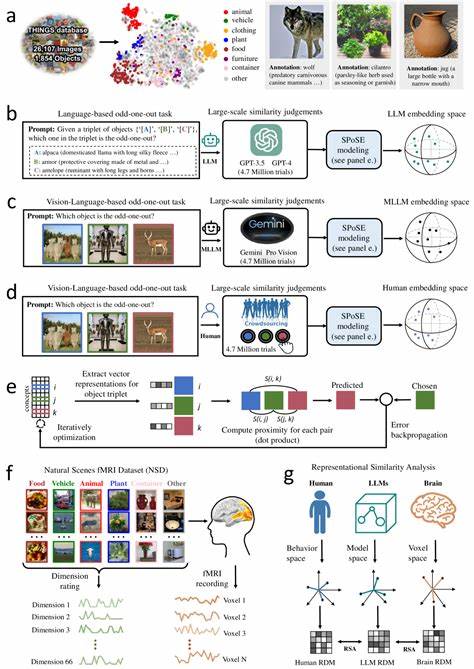

Anders als reine Sprachmodelle besitzen sie die Fähigkeit, Informationen aus unterschiedlichen Modalitäten zu integrieren und so komplexere Bedeutungsebenen zu erfassen. Dieses Zusammenspiel führt dazu, dass sich in solchen Modellen sogenannte Objektkonzept-Repräsentationen entwickeln, die in vielen Aspekten den menschlichen mentalen Repräsentationen ähneln. In jüngsten Studien wurden gigantische Mengen an Daten genutzt, um das Verhalten multimodaler LLMs mit dem menschlicher Probanden zu vergleichen. Dabei zeigten sich erstaunliche Parallelen: Die Modelle konnten mittels Millionen von Urteilen über Ähnlichkeiten zwischen Objekten embeddings generieren – das heißt, niedrigdimensionale Darstellungen, die das Verständnis von Objekten und deren Beziehungen zueinander widerspiegeln. Diese künstlichen Repräsentationen ordneten tausende von natürlichen Objekten in semantisch nachvollziehbare Cluster, ähnlich dem, was Menschen in psychologischen Experimenten leisten.

Ein besonders bemerkenswerter Befund ist, dass diese embeddings nicht nur stabil und vorhersagbar sind, sondern auch interpretierbar bleiben. Das bedeutet, man kann ihnen bestimmte Bedeutungsdimensionen zuweisen, die klare Parallelen zu menschlichen Konzepten aufweisen. Dazu zählen etwa Kategorien wie Lebewesen versus unbelebte Dinge, Größe, Funktion oder Farbigkeit – Merkmale, die für das menschliche Verständnis von Bedeutung sind. Darüber hinaus konnten Forscher eine starke Übereinstimmung zwischen den embeddings der multimodalen LLMs und neuronalen Aktivitätsmustern in verschiedenen Hirnregionen feststellen. Besonders Regionen, die in der visuellen Verarbeitung eine Schlüsselrolle spielen, wie die extrastriate Körperareale, parahippokampale Ortsareale, retrospleniale Kortexregionen und das fusiforme Gesichtsareal, zeigten beeindruckende Korrespondenzen.

Diese Entdeckung unterstreicht, dass die inneren Repräsentationen künstlicher Modelle nicht nur oberflächlich ähnlich sind, sondern auf einer tieferen, funktionalen und neurobiologischen Ebene Gemeinsamkeiten mit der menschlichen Wahrnehmung aufweisen. Die Implikationen dieser Forschung sind weitreichend. Zum einen verdeutlichen die Ergebnisse, dass menschliche Objektkonzepte nicht allein durch sensorische Erfahrung definiert sind, sondern auch durch integrative semantische Verarbeitungsprozesse – und diese können wie gezeigt durch multimodale Sprachmodelle recht gut nachgebildet werden. Zum anderen unterstützen diese Erkenntnisse die Hoffnung, in Zukunft künstliche Intelligenzsysteme zu entwickeln, die nicht nur datengetrieben, sondern auch kognitiv menschenähnlich agieren können, was sie robuster, verständlicher und anwendungsfähiger macht. Die Methoden, mit denen diese Forschungen durchgeführt wurden, stellen ebenfalls Meilensteine dar: Die Kombination aus umfangreichen quantitativen Verhaltensdaten, hochauflösender funktionaler Bildgebung und modernster KI-Analyse eröffnet neue Zugänge, um die komplexen Zusammenhänge zwischen künstlichen Modellen und menschlicher Kognition zu entschlüsseln.

Vor allem die Verwendung von sogenannten "Triplet-Judgments" – Urteile darüber, welche von drei gezeigten Objekten am wenigsten ähnlich ist – erlaubte eine präzise Erfassung der semantischen Struktur von Objektkonzepten in den Modellen. Darüber hinaus verwendeten die Forscher dimensionale Reduktionstechniken, um die hochdimensionalen Daten auf überschaubare, aber dennoch inhaltsreiche Dimensionen zu verdichten. Diese reduzierte Darstellung erwies sich als robust und ermöglichte ein intuitives Verständnis der objektbezogenen Konzepte innerhalb der Modelle. Außerdem ist hervorzuheben, dass diese Dimensionen weitgehend mit menschlichen Konzeptdimensionen korrelieren, was auf eine tiefgreifende zyklische Beziehung zwischen Mensch und Maschine hindeutet. Die Erforschung multimodaler LLMs bringt jedoch nicht nur Erkenntnisse über Objektrepräsentationen hervor, sondern fördert auch das Verständnis der Grenzen und Herausforderungen bei der Modellierung menschlicher Kognition.

So zeigen sich etwa auch Unterschiede zwischen den Maschinenrepräsentationen und den menschlichen neuronalen und psychologischen Daten, was wiederum auf besondere Merkmale menschlicher Wahrnehmung und Erfahrung hinweist. Diese Divergenzen geben Anhaltspunkte für künftige Verbesserungen in der Architektur und im Lernprozess großer KI-Modelle. Ein weiterer interessanter Aspekt ist die Bedeutung von multimodalem Lernen. Studien deuten darauf hin, dass die Kombination von unterschiedlichen sensorischen Informationsquellen, also Text, Bild und eventuell andere Modalitäten, die Entwicklung reichhaltigerer und menschenähnlicherer Konzepte erheblich unterstützt. Während reine Sprachmodelle schon sehr mächtig sind, weisen multimodale Modelle eine bessere semantische Tiefe und Stabilität auf, was für Anwendungen in kognitiven Assistenzsystemen, Robotik und weiterentwickelten Mensch-Maschine-Schnittstellen von größtem Wert sein könnte.

Potenzielle praktische Anwendungen solch menschenähnlicher Objektkonzept-Repräsentationen in multimodalen LLMs sind vielfältig. Schon heute ermöglichen sie präzisere Bildbeschreibung, verbesserte Bildersuche, adaptives Lernen von visuellen Konzepten und die Entwicklung intelligenter Systeme, die Kontexte und Bedeutungsnuancen besser erfassen. Langfristig könnte dies zu Systemen führen, die menschliche kognitive Fähigkeiten in spezifischen Bereichen ergänzen oder sogar übertreffen, ohne den Verlust von Interpretierbarkeit und Kontrolle – ein entscheidender Faktor bei ethischen und sicherheitstechnischen Überlegungen. Die enge Anbindung moderner KI-Forschung an Erkenntnisse der Neurowissenschaft ist ein vielversprechender Trend, der in diesem Ansatz besonders hervorsticht. Durch den Vergleich von Modell- und Hirndaten können Forscher theoretische Annahmen besser prüfen und zugleich die Entwicklung von Algorithmen vorantreiben, die sich stärker an biologischen Prinzipien orientieren.

Dies könnte einer der Schlüssel sein, um intelligentes Verhalten nicht einfach als Veränderung statistischer Wahrscheinlichkeiten, sondern als echtes Verstehen und flexible Verarbeitung von Informationen zu begreifen. Insgesamt markieren die Entdeckungen um die Entstehung menschlicher Objektkonzepte in multimodalen großen Sprachmodellen einen bedeutenden Schritt im Zusammenspiel von künstlicher Intelligenz und menschlicher Wahrnehmung. Sie zeigen, dass die scheinbar abstrakten und komplexen Methoden moderner KI auf fundamentale kognitive Prozesse zurückgreifen und diese in strukturierter Weise nachbilden können. Die Herausforderungen, die sich aus den noch bestehenden Unterschieden ergeben, bieten gleichzeitig neue Forschungsfelder und Entwicklungsoptionen. Für die Zukunft ist zu erwarten, dass die Integration multimodaler Daten und die Verbesserung der Modellarchitekturen weiter voranschreiten werden.

Dies wird dazu führen, dass künstliche Systeme zunehmend in der Lage sein werden, Objekte und ihre Bedeutungen nicht nur oberflächlich, sondern tiefgreifend und kontextabhängig zu verstehen. Gleichzeitig wird die Zusammenarbeit zwischen KI-Forschung, Psychologie und Neurowissenschaft entscheidend sein, um sowohl die Leistungsfähigkeit als auch die Nachvollziehbarkeit dieser Modelle sicherzustellen. Die Forschung an multimodalen LLMs, die menschliche Objektkonzepte imitieren, stellt somit nicht nur einen Meilenstein in der KI-Entwicklung dar, sondern auch einen Brückenschlag zu einem tieferen Verständnis des menschlichen Geistes. Sie zeigt exemplarisch, wie moderne Technologien und interdisziplinäres Denken zusammenwirken können, um die Grenzen unseres Wissens zu erweitern und zugleich praktische Lösungen für komplexe Probleme zu schaffen.