Die COVID-19-Pandemie hat die Welt vor enorme Herausforderungen gestellt und zahlreiche gesellschaftliche, wirtschaftliche und technologische Systeme auf die Probe gestellt. Neben der unmittelbaren gesundheitlichen Bedrohung hat die Pandemie insbesondere auch Schwachstellen unserer Systeme und Prozesse offengelegt. Ein besonders bemerkenswerter Aspekt, der in der Debatte um die Folgen der Krise immer wieder hervorgehoben wird, ist der Zielkonflikt zwischen Effizienz und Resilienz. Während Effizienz lange Zeit als Maßstab für guten Betrieb galt, offenbaren sich in Krisenzeiten die gravierenden Nachteile eines zu einseitig auf Effizienz ausgerichteten Denkens. Die Pandemie erzwingt eine Neubewertung dieser Prioritäten – gerade in der Welt der Informatik, wo die digitale Infrastruktur inzwischen das Rückgrat der modernen Gesellschaft bildet.

Effizienz wird oft als die Fähigkeit verstanden, Ressourcen möglichst optimal einzusetzen, um ein bestimmtes Ziel mit minimalem Aufwand zu erreichen. Dabei geht es darum, Prozesse zu verschlanken, Kosten zu reduzieren und die Geschwindigkeit von Abläufen zu maximieren. Gerade in der Wirtschaft und im Technologieumfeld wurde Effizienz zum zentralen Leitprinzip. Unternehmen optimieren ihre Lieferketten, Softwareentwickler streben nach möglichst schlanken Codes und Systeme werden so konzipiert, dass sie mit geringstem Energie- und Zeitaufwand maximale Leistung bringen. Dieses Streben hat zweifellos große Innovationen und Fortschritte hervorgebracht und zum Wohlstand vieler Gesellschaften beigetragen.

Doch mit der COVID-19-Pandemie wurde offensichtlich, dass maximale Effizienz auch mit erheblichen Risiken verbunden ist. Systeme, die auf maximale Auslastung und minimalen Puffer ausgelegt sind, erweisen sich in Krisen als anfällig. Beschränkte Lagerbestände in Produktionsketten, fehlender Spielraum in IT-Netzwerken oder überoptimierte Algorithmen, die auf typische Datenmuster fixiert sind, können zum Bruch führen, wenn unerwartete Störungen eintreten. Hier zeigt sich die Bedeutung von Resilienz – einem Konzept, welches die Fähigkeit beschreibt, sich an unvorhergesehene Veränderungen anzupassen und auch unter Stress handlungsfähig zu bleiben. Im Kontext der Informatik ist dieser Gegensatz von Effizienz und Resilienz besonders bedeutsam.

Traditionell stand die Leistungsfähigkeit eines Algorithmus im Mittelpunkt der Analyse. Die sogenannte Komplexitätstheorie beschäftigt sich vor allem mit der Frage, wie viel Zeit, Speicher oder andere Ressourcen benötigt werden, um ein Problem zu lösen. Gut entwickelte Algorithmen sind darauf ausgelegt, ihre Aufgabe unter idealen Bedingungen möglichst schnell zu erledigen. Allerdings zeigt sich, dass diese starke Fokussierung auf Effizienz zu Lasten der Anpassungsfähigkeit gehen kann. Algorithmen, Systeme und Netzwerke brauchen zunehmend Mechanismen, die sie gegen Ausfälle, Angriffe oder unvorhersehbare Datenmanipulationen schützen – Aspekte, die unter dem Begriff Resilienz zusammengefasst werden.

Ein anschauliches Beispiel bietet die Suche im Internet. Die ursprünglichen Suchalgorithmen wie der von Google entwickelte PageRank bewerteten Webseiten nach ihrer Vernetzung und Popularität. Diese Methode war effizient und lieferte sehr gute Ergebnisse unter normalen Bedingungen. Allerdings zeigte sich, dass diese Algorithmen anfällig für Manipulationen waren – sogenannte Suchmaschinenoptimierung oder sogar gezielte Manipulationen, um Rankings künstlich zu verbessern. Die Systeme mussten resilienter werden, um solchen Angriffen entgegenzuwirken.

Resilienz im Sinne von Robustheit gegenüber fehlerhaften oder bösartigen Eingaben ist heute ein aktives Forschungsgebiet, mit besonderer Relevanz für maschinelles Lernen und Künstliche Intelligenz. Die informatische Resilienz erfordert ein Umdenken: Neben den bereits etablierten Technologien zur Fehlertoleranz müssen neue Paradigmen etabliert werden, die Störungen nicht nur abfangen, sondern Systeme von vornherein auf Flexibilität und Anpassungsfähigkeit ausrichten. Dies bedeutet, dass Algorithmen nicht nur für den optimalen Fall, sondern auch für Abweichungen und Unsicherheiten ausgelegt sein sollten. In der Praxis können dies etwa Algorithmen sein, die aus diversen Datenquellen lernen, sich automatisch neu konfigurieren oder Angriffe erkennen und abwehren. Diese Erfordernisse spiegeln sich auch in der Arbeitsweise von Unternehmen wider, die sich während der Pandemie flexibel an neue Gegebenheiten anpassen mussten.

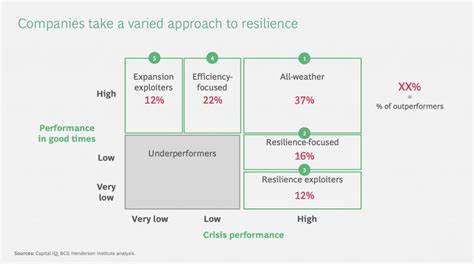

Eine übermäßige Fixierung auf Effizienz, etwa durch Just-in-Time-Produktion oder extrem schlanke Lagerhaltung, kann kurzfristig Kosten sparen, aber langfristig die Systemrobustheit stark beeinträchtigen. Resilienz bietet hier einen wertvollen Gegenpol: Sie sorgt für Redundanzen, flexible Strukturen und ein erhöhtes Fehlertoleranzvermögen. Dass diese beiden Ideale in Spannung zueinander stehen, ist kein neues Thema, aber die globale Krise hat die Dringlichkeit verdeutlicht, ihre Balance neu zu definieren. So argumentiert etwa William A. Galston, dass Effizienz eine optimale Anpassung an eine bestehende Umwelt bedeutet, während Resilienz die Fähigkeit beschreibt, auf disruptive Veränderungen zu reagieren.

Ein effizientes System erfüllt seine Aufgabe unter normalen Bedingungen optimal, kann aber bei unerwarteten Störungen versagen. Ein resilienteres System dagegen opfert manchmal optimale Leistungsfähigkeit im Geiste des Vorbeugens und Absicherns gegen mögliche Krisen. Diese Dichotomie findet sich sogar im Folgenden in der Natur wieder. Das Beispiel der sexuellen Fortpflanzung zeigt, dass Evolution nicht nur optimale Anpassung, sondern auch Erhaltung der Anpassungsfähigkeit an neue Bedingungen anstrebt. Durch genetische Vielfalt entsteht Resilienz, die das Überleben der Art auch unter drastischen Umweltveränderungen sichert.

Überträgt man dies auf die Informatik, so bedeutet dies, dass Systeme, die nicht nur für den optimalen Fall programmiert sind, sondern eine Vielfalt von Situationen antizipieren und darauf reagieren können, widerstandsfähiger und nachhaltiger sind. Der Umgang mit Daten und Algorithmen in der heutigen Zeit zeigt ebenfalls, wie Resilienz zunehmend in den Vordergrund rückt. Die Bedrohung durch Cyberangriffe, Manipulationen und fehlerhafte Datenquellen macht die Entwicklung neuer Methoden unumgänglich. Besonders im Bereich des maschinellen Lernens sind resilientere Algorithmen notwendig, um die Integrität und Zuverlässigkeit der Ergebnisse zu gewährleisten. Forschung im Bereich der adversarialen Maschinellen Lernens beschäftigt sich genau mit solchen Angriffsmethoden und der Abwehr derselben.

Neben technologischen Herausforderungen bedeutet der Ruf nach mehr Resilienz auch eine Herausforderung für die Ausbildung und Kultur in der Informatik. Noch immer wird vielfach der Schwerpunkt auf die Optimierung von Effizienz gelegt. Resilienz, Sicherheit und Nachhaltigkeit müssen jedoch stärker in den Lehrplänen, den Forschungsschwerpunkten und der täglichen Praxis verankert werden. Nur so kann die nächste Generation von IT-Fachkräften den komplexen Anforderungen einer zunehmend vernetzten und fragilen Welt gerecht werden. Die Erkenntnisse, die die Pandemie liefert, haben zudem zukunftsweisende Implikationen für die Art und Weise, wie wir Technologien entwickeln und einsetzen.

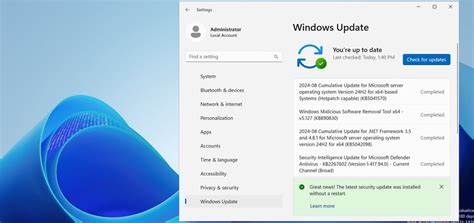

Die digitale Infrastruktur wird zunehmend als das „Betriebssystem“ unserer Zivilisation bezeichnet. Die Verantwortlichen, Entwickler und Betreiber tragen eine enorme Verantwortung, sicherzustellen, dass dieses Betriebssystem nicht nur effizient arbeitet, sondern auch robust und flexibel auf unerwartete Realitäten reagieren kann. Dies erfordert neuen Denkansätze, Investitionen in Forschung und eine bewusste Gestaltung resilienter Algorithmen und Systeme. Dabei ist Effizienz keineswegs überflüssig, sondern bleibt ein essentielles Ziel. Doch das Festhalten an maximaler Effizienz ohne Berücksichtigung von Resilienz kann zu fatalen Ausfällen führen.