Im Zeitalter der Digitalisierung spielt die Wahl der richtigen Datenbank-Engine eine entscheidende Rolle für den Erfolg moderner Unternehmen. Zahlreiche Startups und etablierte Firmen haben sich in den letzten Jahren für verteilte Datenbanklösungen wie CockroachDB entschieden, um Skalierbarkeit und Verfügbarkeit sicherzustellen. Doch mit dem Wachstum der Nutzerzahlen steigen auch die Kosten und Herausforderungen, die der Betrieb solcher Systeme mit sich bringt, was viele Unternehmen letztlich zum Nachdenken über Migrationen veranlasst. Ein System, das dabei immer häufiger als attraktive Alternative ins Blickfeld rückt, ist PostgreSQL. Der Umstieg von komplexen verteilten Datenbanken hin zu PostgreSQL verspricht nicht nur eine bessere Performance bei alltäglichen Abfragen, sondern auch wesentlich geringere Betriebskosten und eine vereinfachte Administration.

Warum genau dieser Wechsel für viele Unternehmen Sinn macht, soll hier anhand verschiedener Aspekte genauer erläutert werden. Zu Beginn muss man den Kontext verstehen, in dem viele Unternehmen sich für CockroachDB entschieden haben. CockroachDB punktet mit nahtloser horizontaler Skalierbarkeit, hoher Verfügbarkeit auch über mehrere Regionen hinweg und einer SQL-kompatiblen Schnittstelle. Gerade Unternehmen, die schon früh damit rechneten, ihre Daten aus regulatorischen Gründen in verschiedenen Regionen speichern zu müssen, sahen in einem verteilten System einen klaren Vorteil. Auch wenn sich diese Anforderung nicht sofort umsetzen ließ, bot die Architektur theoretisch eine solide Basis dafür.

Doch anders als erwartet konnte die ursprünglich mühsam vorgesehene Multi-Region-Strategie zunächst nicht umgesetzt werden und die Nutzung blieb auf eine einzelne Region mit relativ einfachen transaktionalen Abfragen beschränkt. Daraus ergibt sich die Frage, ob die hohen Kosten und Komplexitäten, die mit einer verteilten Datenbank einhergehen, in solchen Szenarien gerechtfertigt sind. Ein prägnantes Problem trat mit zunehmender Datenmenge und wachsender Datenbankkomplexität auf. Insbesondere die Durchführung von Datenbankmigrationen führte regelmäßig zu Timeout-Problemen. Das verwendete Objekt-Relationale Mapping-Tool (ORM) Prisma wurde bei der automatisierten Ausführung von Migrationen zunehmend unzuverlässig.

Entwickler waren gezwungen, Migrationen manuell und einzeln direkt auf der Datenbank auszuführen, was den Deployment-Prozess massiv verlangsamte und zu langen Ausfallzeiten führte. Solche Verzögerungen bedeuteten nicht nur einen höheren Aufwand für das Entwicklerteam, sondern auch eine eingeschränkte Flexibilität bei notwendigen Updates und Verbesserungen der Datenbanksoftware. Diese operativen Hindernisse unterstreichen, wie wichtig eine stabile und performante Migrationsstrategie für das tägliche Geschäft ist. Darüber hinaus wirkten sich diese Probleme auf die gesamte Datenverarbeitungspipeline aus. Auch ETL-Prozesse (Extract, Transform, Load) begannen durch die Instabilitäten der verteilten Datenbank zunehmend zu stocken oder gar komplett zu versagen.

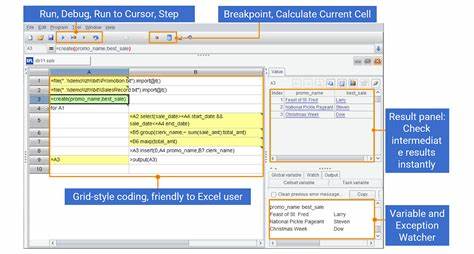

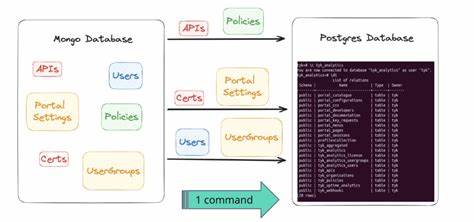

Verfügbare Werkzeuge zur Replikation und zum Datenexport, wie etwa der Airbyte-Connector, befanden sich damals noch im Alpha-Stadium und wiesen teilweise gravierende Fehler wie Speicherlecks auf. Somit musste das Unternehmen eigene Lösungen entwickeln, um die Datenmigration zu bewältigen. So entstand ein eigens gebautes ETL-System auf Basis von modernen Tools wie Bun, das Datenschemata auslas, Daten tabellenweise in CSV-Dateien exportierte und anschließend parallelisierte Einspielprozesse in PostgreSQL anstieß. Auch wenn die technische Herausforderung darin lag, Unterschiede in der Datenkodierung – beispielsweise in JSON- und Array-Spalten – zuverlässig umzusetzen, gelang am Ende eine reibungslose und schnelle Migration ohne Datenverlust. Was die reine Performance betrifft, zeigt der Vergleich zwischen CockroachDB und PostgreSQL interessante Ergebnisse.

Obwohl CockroachDB für bestimmte Abfragen dank seines Optimizers Vorteile bei der Geschwindigkeit zeigen kann, war dies in der Praxis oft die Ausnahme. Gerade bei komplexen Abfragen, die unter Verwendung von Prisma häufig sehr verschachtelte und umfangreiche SQL-Statements erzeugten, zeichnete sich PostgreSQL durch deutlich schnellere Antwortzeiten aus. In vielen Fällen konnten Abfragen auf dem produktiven System in PostgreSQL um das Mehrfache schneller durchgeführt werden. Die bessere Performance erwies sich als nicht nur technologisches, sondern auch wirtschaftliches Argument – schnellere Abfragen bedeuten bessere Nutzererfahrung im Frontend und letztlich auch geringere Betriebskosten für Rechenleistung. Neben der Performance war die Bedienbarkeit und Wartbarkeit ein weiterer kritischer Faktor des Wechsels.

Die UI von CockroachDB zeigte etwa bei der Analyse von Indizes inkonsistente Empfehlungen, was zu Verwirrung im Entwicklerteam führte und teilweise zu falschen Entscheidungen beim Umgang mit Datenbankindizes. Auch das Abbrechen laufender Abfragen stellte eine Herausforderung dar: Während es bei PostgreSQL mit gängigen SQL-Clients einfach möglich ist, laufende Prozesse zu stoppen, erfordert CockroachDB den Zugriff auf eine zentrale Konsole und ein zeitnahes manuelles Eingreifen. In einer verteilten Umgebung, wie sie CockroachDB nutzt, kann ein abgebrochenes Query teilweise weiterlaufen, bis alle beteiligten Knoten es einstellen – was zu ungeplanten Ausfällen führt. Auch der Support stellt einen wichtigen Aspekt dar. Die Trennung zwischen der CockroachDB-Hauptseite und dem Support-Portal erschwerte die schnelle Lösung von Problemen.

In kritischen Situationen, wie einem unerwarteten Bug, war das aufwändige Einloggen und erneute Eingeben relevanter Daten zeitlich hinderlich und verzögerte die Problemlösung in akuten Fällen. Im Gegensatz dazu profitiert die PostgreSQL-Community von einer großen Nutzerbasis und einer Vielzahl an Dokumentationen und Tools, die schnelle und umfassende Hilfestellungen ermöglichen. Nicht zuletzt gab es kontinuierlich technische Schwierigkeiten mit der Netzwerkanbindung. Verbindungsabbrüche aufgrund von DNS-Auflösungsproblemen mit CockroachDB-Instanzen behinderten regelmäßig den Zugriff auf die Datenbank, unabhängig vom Umfeld. Solche Fehler stärkten das Misstrauen in die Stabilität und Einfachheit des Betriebs, vor allem im Vergleich zu PostgreSQL, das solche Probleme nicht zeigte.

Die eigentliche Migration, trotz aller Herausforderungen, erwies sich als äußerst erfolgreich. In einer nächtlichen Wartungsphase, in der die Anwendung in den Wartungsmodus versetzt wurde, konnte das gesamte Datenvolumen mit Hunderten Millionen Datensätzen in etwa 15 Minuten auf das neue System übertragen werden. Die Ausfallzeit wurde bewusst großzügig auf unter eine Stunde bemessen, um Risiken zu minimieren, tatsächlich hätte sie aber noch kürzer ausfallen können. Nach dem Umstieg sah das Entwicklerteam sofort messbare Vorteile: Neben einer deutlichen Reduktion der Latenzen um rund ein Drittel konnten zahlreiche schlecht optimierte Abfragen mit Hilfe bewährter Analysewerkzeuge unter PostgreSQL schnell identifiziert und verbessert werden. Die Einsparungen im laufenden Betrieb betrugen jährlich über 100.

000 US-Dollar, ein Betrag, der bei weiter wachsendem Datenvolumen und Nutzeraufkommen noch steigen wird. Zusammenfassend zeigt die Migration weg von einer komplexen, verteilten Datenbanklösung hin zu PostgreSQL, dass in vielen Anwendungsfällen eine einfache, leistungsstarke und gut unterstützte relationale Datenbank die bessere Lösung sein kann. Gerade für Unternehmen, deren Anforderungen an Multi-Region-Szenarien noch nicht akut sind und die hauptsächlich einfache transaktionale Workloads bedienen, bringt PostgreSQL erhebliche Vorteile in Stabilität, Wartbarkeit und Kostenkontrolle. Zwar bietet CockroachDB eindrucksvolle Funktionen und technische Innovationen, doch die Komplexität und die daraus resultierenden Betriebsschwierigkeiten müssen stets gegen den tatsächlichen Nutzen abgewogen werden. Wer langfristig auf Effizienz, niedrige Ausfallzeiten und überschaubare Wartung setzt, findet in PostgreSQL eine robuste und bewährte Grundlage für seine Datenplattform.

Für Entwickler und Verantwortliche, die sich mit dem Gedanken einer Migration tragen, lohnt es sich, die zu migratierenden Workloads genau zu analysieren. Nicht jede Anwendung benötigt die Features einer verteilten Datenbank, und ein bewusster Umstieg kann nicht nur Kosten senken, sondern auch eine bessere Entwicklererfahrung gewährleisten. Die Migration sollte zudem gut vorbereitet und getestet werden, insbesondere im Bereich Datenkompatibilität und Migrationsstrategie. Moderne Tools und Skripte können dabei helfen, den Übergang so reibungslos wie möglich zu gestalten. Die Zukunft der Datenbanktechnologien wird durch zahlreiche neue Ansätze und Optimierungen geprägt sein.

![EU ruling: tracking-based advertising [...] across Europe has no legal basis](/images/1C8C02AF-85A6-4F5B-A7A2-B905DBDF8966)